HuggingFace屠榜:將兩隻羊駝去掉頭尾後拼接在一起

HuggingFace開源大模型排行榜,又被屠榜了。

前排被清一色的SOLAR 10.7B微調版本佔據,把幾週之前的各種Mixtral 8x7B微調版本擠了下去。

SOLAR大模型什麼來頭?

相關論文剛上傳到ArXiv,來自韓國公司Upstage AI,使用了新的大模型擴充方法depth up-scaling(DUS)。

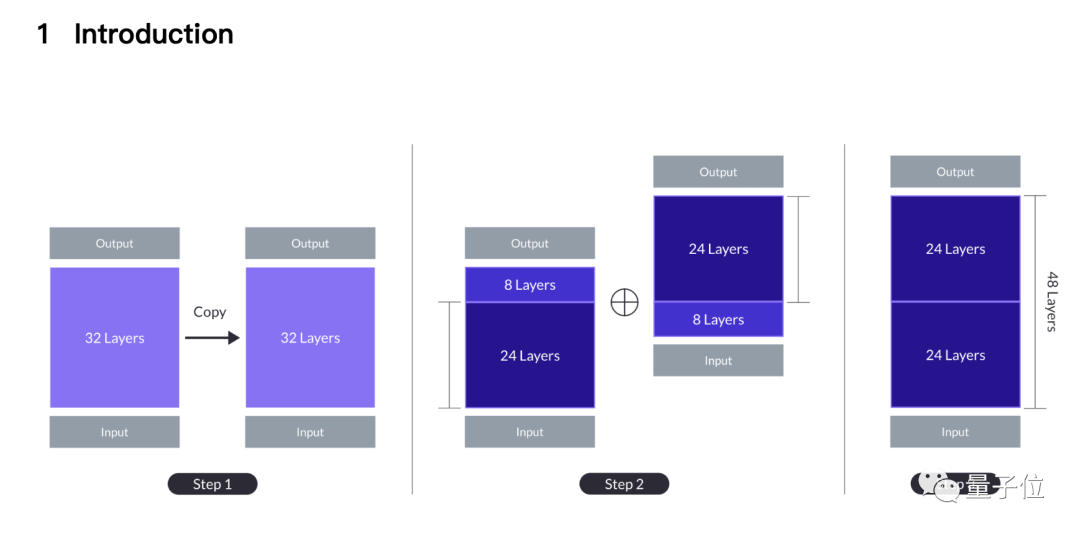

簡單來說就是兩隻7B羊駝掐頭去尾,一隻砍掉前8層,一只砍掉後8層。

剩下兩個24層縫合在一起,第一個模型的第24層與第二個模型的第9層拼接,最後變成新的48層10.7B大模型。

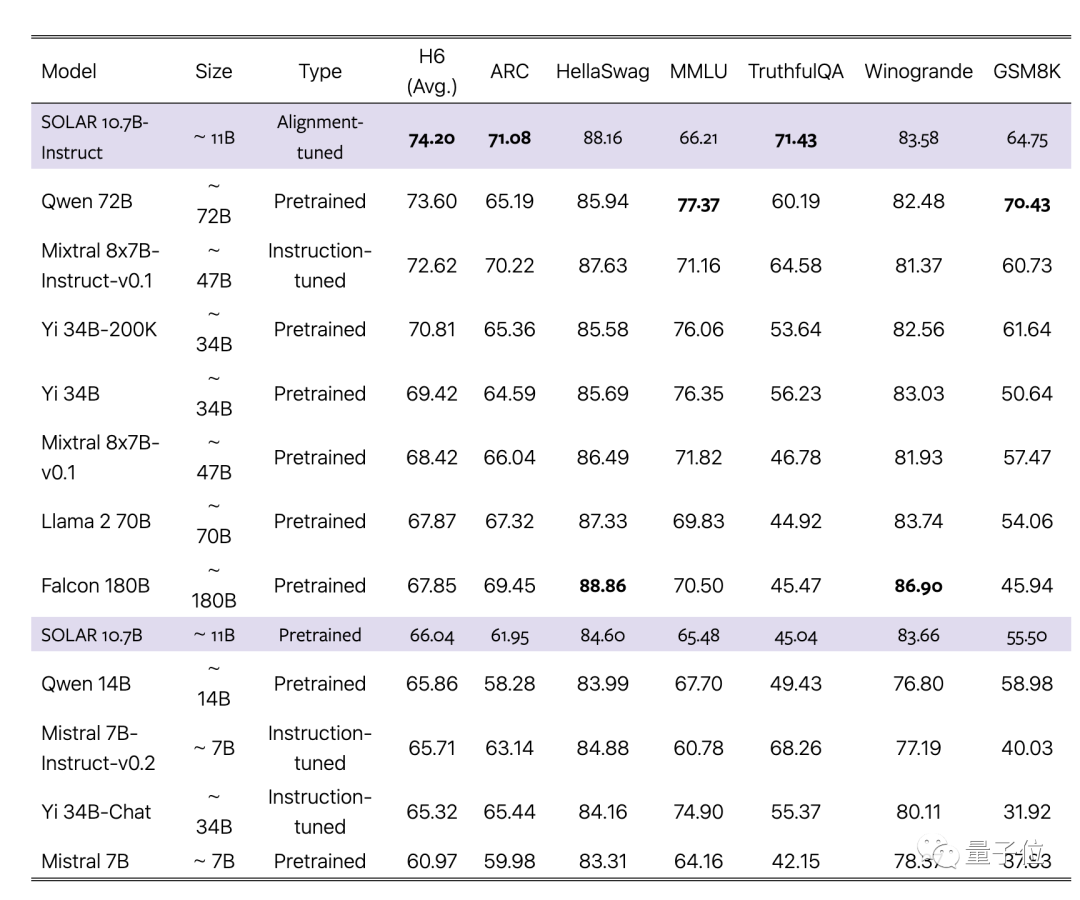

論文聲稱新方法超過傳統擴展方法如MoE,而且可以與沿用基礎大模型完全相同的基礎設施。

不需要門控網路等附加模組,針對MoE優化訓練框架了,也不需要自訂CUDA內核來快速推理,可以無縫整合到現有方法中,同時保持高效。

團隊選擇7B規模最強的單體大模型Mistral 7B作為底材,用新方法拼接起來,再超越原版以及MoE版。

同時,經過對齊的Instruct版本也超越對應的MoE Instruct版本。

將縫合進行到底

為什麼是這種拼接方式,論文中介紹來自一種直覺。

從最簡單的擴展方式開始,也就是把32層的基礎大模型重複兩次,變成64層。

這樣做的好處是不存在異質性,所有層都來自基礎大模型,但第32層和第33層(與第1層相同)的接縫處有較大的「層距離」(layer distance)。

之前有研究表明,Transformer不同層做不同的事,如越深的層擅長處理越抽象的概念。

團隊認為層距離過大可能妨礙模型有效利用預訓練權重的能力。

一個潛在的解決方案是犧牲中間層,從而減少接縫處的差異,DUS方法就從這裡誕生。

根據性能與模型尺寸的權衡,團隊選擇從每個模型中刪除8層,接縫處從32層連第1層,變成了24層連第9層。

簡單拼接後的模型,效能一開始還是會低於原版基礎模型,但經過繼續預訓練可以快速恢復。

在指令微調階段,除了使用開源資料集,還製作了數學強化資料集,對齊階段使用DPO。

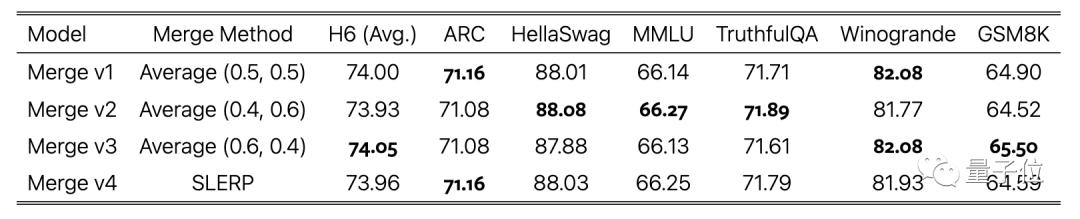

最後一步,把使用不同資料集訓練的模型版本加權平均,也是把縫合進行到底了。

有網友質疑測試資料外洩的可能性。

團隊也考慮到這一點,在論文附錄中專門報告了資料污染測試結果,顯示出低水準。

最後,SOLAR 10.7B基礎模型和微調模型都以Apache 2.0協定開源。

試用過的網友回饋,從JSON格式資料中擷取資料表現不錯。

論文網址:https://arxiv.org/abs/2312.15166

以上是HuggingFace屠榜:將兩隻羊駝去掉頭尾後拼接在一起的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

選擇大宗交易平台時應考慮以下因素:1. 流動性:優先選擇日均交易量超50億美元的平台。 2. 合規性:查看平台是否持有美國FinCEN、歐盟MiCA等牌照。 3. 安全性:冷錢包存儲比例和保險機制是關鍵指標。 4. 服務能力:是否提供專屬客戶經理和定制化交易工具。

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

提供各種複雜的交易工具和市場分析。覆蓋 100 多個國家,日均衍生品交易量超 300 億美元,支持 300 多個交易對與 200 倍槓桿,技術實力強大,擁有龐大的全球用戶基礎,提供專業的交易平台、安全存儲解決方案以及豐富的交易對。

排名前十的虛擬貨幣交易app有哪些 十大數字貨幣交易所平台推薦

Apr 22, 2025 pm 01:12 PM

排名前十的虛擬貨幣交易app有哪些 十大數字貨幣交易所平台推薦

Apr 22, 2025 pm 01:12 PM

2025年安全的數字貨幣交易所排名前十依次為:1. Binance,2. OKX,3. gate.io,4. Coinbase,5. Kraken,6. Huobi,7. Bitfinex,8. KuCoin,9. Bybit,10. Bitstamp,這些平台均採用了多層次的安全措施,包括冷熱錢包分離、多重簽名技術以及24/7的監控系統,確保用戶資金的安全。

穩定幣有哪些?穩定幣如何交易?

Apr 22, 2025 am 10:12 AM

穩定幣有哪些?穩定幣如何交易?

Apr 22, 2025 am 10:12 AM

常見的穩定幣有:1. 泰達幣(USDT),由Tether發行,與美元掛鉤,應用廣泛但透明性曾受質疑;2. 美元幣(USDC),由Circle和Coinbase發行,透明度高,受機構青睞;3. 戴幣(DAI),由MakerDAO發行,去中心化,DeFi領域受歡迎;4. 幣安美元(BUSD),由幣安和Paxos合作,交易和支付表現出色;5. 真實美元(TUSD),由TrustTo

目前有多少穩定幣交易所?穩定幣種類有多少?

Apr 22, 2025 am 10:09 AM

目前有多少穩定幣交易所?穩定幣種類有多少?

Apr 22, 2025 am 10:09 AM

截至2025年,穩定幣交易所數量約為千家。 1. 法定貨幣支持的穩定幣包括USDT、USDC等。 2. 加密貨幣支持的穩定幣如DAI、sUSD。 3. 算法穩定幣如TerraUSD。 4. 還有混合型穩定幣。

幣圈十大交易所有哪些 最新幣圈app推薦

Apr 24, 2025 am 11:57 AM

幣圈十大交易所有哪些 最新幣圈app推薦

Apr 24, 2025 am 11:57 AM

選擇可靠的交易所至關重要,Binance、OKX、Gate.io等十大交易所各具特色,CoinGecko、Crypto.com等新app也值得關注。

2025下一個千倍幣可能有哪些

Apr 24, 2025 pm 01:45 PM

2025下一個千倍幣可能有哪些

Apr 24, 2025 pm 01:45 PM

截至2025年4月,有七个加密货币项目被认为具有显著增长潜力:1. Filecoin(FIL)通过分布式存储网络实现快速发展;2. Aptos(APT)以高性能Layer 1公链吸引DApp开发者;3. Polygon(MATIC)提升以太坊网络性能;4. Chainlink(LINK)作为去中心化预言机网络满足智能合约需求;5. Avalanche(AVAX)以快速交易和