Google研究院最近針對流行的語言模型進行了一項評估研究,使用了自家的BIG-Bench基準測試和新建立的「BIG-Bench Mistake」資料集。他們主要關注了語言模型的出錯機率和糾錯能力。這項研究為了更了解市面上的語言模型的表現表現,提供了有價值的數據。

Google研究人員表示,他們創建了一項名為「BIG-Bench Mistake」的專用基準資料集,旨在評估大語言模型的「出錯機率」和「自我糾錯能力」。這是因為過去缺乏相應的數據集,無法對這些關鍵指標進行有效評估和測試。

研究人員使用PaLM 語言模型在自家BIG-Bench 基準測試任務中運行了5 項任務,並將生成的「思維鏈(Chain-of-Thought)」軌跡加入了「邏輯錯誤」部分,以此重新測試模型的準確性。

為了提高資料集的準確性,Google研究人員反覆進行了上述過程,並最終創建了一個專門用於評估的基準資料集,其中包含了255個邏輯錯誤,稱為“BIG-Bench Mistake” 。

研究人員指出,「BIG-Bench Mistake」資料集中的邏輯錯誤十分明顯,因此可以作為語言模型測試的良好標準。此資料集可協助模型從簡單錯誤開始學習,逐步提高錯誤辨識的能力。

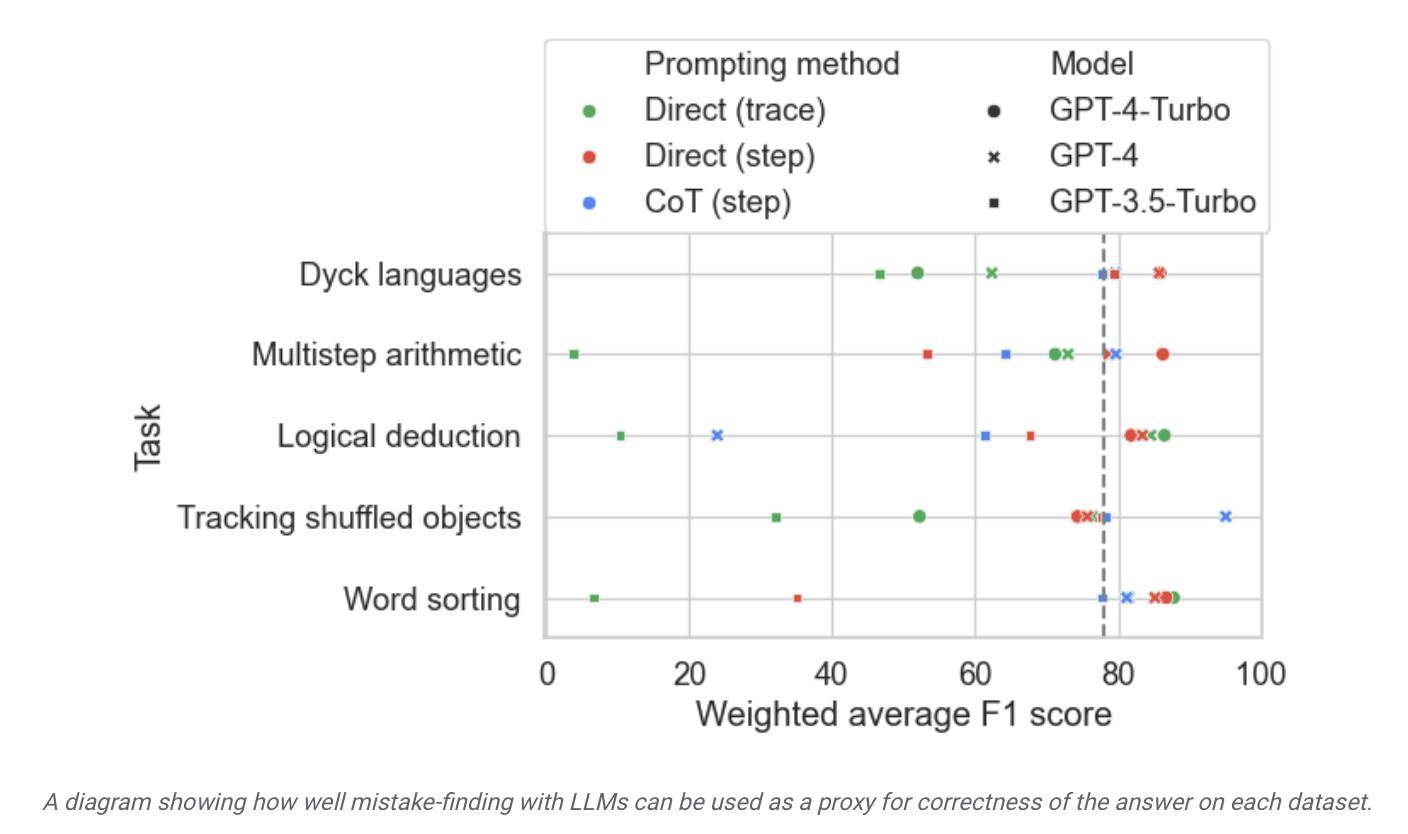

研究人員利用該資料集對市面上的模型進行測試後發現,雖然大多數語言模型能夠識別推理過程中的邏輯錯誤並進行自我修正,但這一過程並不十分理想。通常情況下,還需要人工幹預來修正模型輸出的內容。

▲ 圖源 谷歌研究院新聞稿

根據報告,Google聲稱其被認為是目前最先進的大語言模型,但其自我糾錯能力相對有限。在測驗中,成績最好的模型只能找出52.9%的邏輯錯誤。

Google研究人員同時聲稱,這一BIG-Bench Mistake 資料集有利於改善模型自我糾錯能力,經過相關測試任務微調後的模型,「即便是小型模型表現通常比零樣本提示的大模型更好」。

據此,Google認為在模型糾錯方面,可以使用專有小型模型“監督”大型模型,相對於讓大語言模型學會“糾正自我錯誤”,部署專用於監督大模型的小型專用模型有利於改善效率、降低相關AI 部署成本,並更方便微調。

以上是Google推出 BIG-Bench Mistake 資料集用於幫助 AI 提升糾錯能力的詳細內容。更多資訊請關注PHP中文網其他相關文章!