更新版 Point Transformer:更有效率、更快速、更強大!

原文標題:Point Transformer V3: Simpler, Faster, Stronger

論文連結:https://arxiv.org/pdf/2312.10035.pdf

#程式碼連結:https:// github.com/Pointcept/PointTransformerV3

作者單位:HKU SH AI Lab MPI PKU MIT

論文想法:

本文無意在註意力機制內尋求創新。相反,它側重於利用規模(scale)的力量,克服點雲處理背景下準確性和效率之間現有的權衡。從 3D 大規模表示學習的最新進展中汲取靈感,本文認識到模型性能更多地受到規模的影響,而不是複雜的設計。因此,本文提出了Point Transformer V3 (PTv3),它優先考慮簡單性和效率,而不是某些機制的準確性,這些機制對scaling 後的整體表現影響較小,例如以特定模式組織的點雲的高效序列化鄰域映射來取代KNN 的精確鄰域搜尋。這項原理實現了顯著的 scaling,將感受野從 16 點擴展到 1024 點,同時保持高效(與前身 PTv2 相比,處理速度提高了 3 倍,記憶體效率提高了 10 倍)。 PTv3 在涵蓋室內和室外場景的 20 多個下游任務中取得了最先進的結果。透過多資料集聯合訓練的進一步增強,PTv3 將這些結果推向了更高的水平。

網路設計:

3D 表示學習的最新進展[85] 透過引入跨多個3D 資料集的協同訓練方法,在克服點雲處理中的數據規模限制方面取得了進展。與此策略結合,高效率的捲積 backbone [12] 有效地彌補了通常與 point cloud transformers [38, 84] 相關的精確度差距。然而,由於與稀疏卷積相比,point cloud transformers 的效率存在差距,因此 point cloud transformers 本身尚未完全受益於這種規模優勢。這項發現塑造了本文工作的最初動機:用 scaling principle 的視角重新權衡 point transformers 的設計選擇。本文認為模型表現受規模的影響比受複雜設計的影響更顯著。

因此,本文引入了 Point Transformer V3 (PTv3),它優先考慮簡單性和效率,而不是某些機制的準確性,從而實現 scalability 。這樣的調整對 scaling 後的整體效能影響可以忽略。具體來說,PTv3 進行了以下調整以實現卓越的效率和scalability :

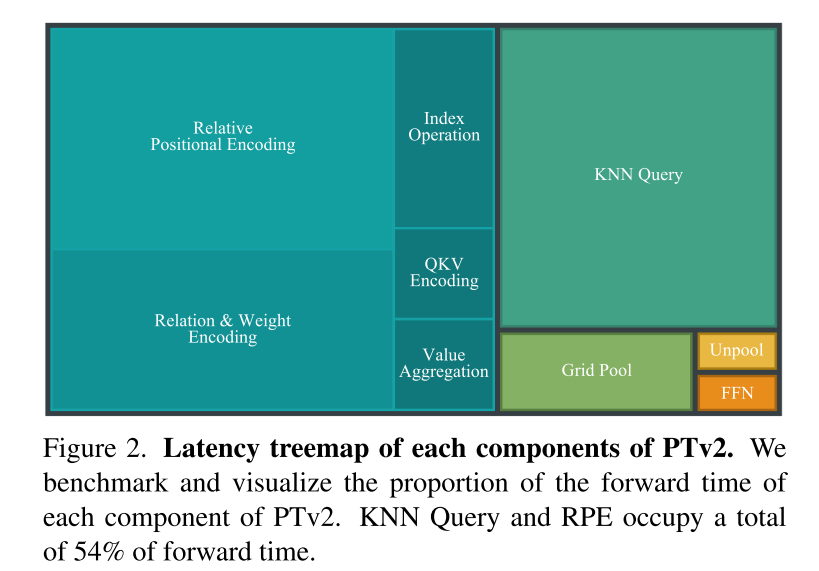

- #受到最近兩項進展[48, 77] 的啟發,並認識到結構化非結構化點雲的scalability 優勢,PTv3 改變了由K-Nearest Neighbors (KNN) query 定義的傳統空間鄰近性,佔forward time 的28%。相反,它探索了點雲中根據特定模式組織的序列化鄰域的潛力。

- PTv3 採用專為序列化點雲量身定制的簡化方法,取代了更複雜的注意力patch 交互機制,例如shift-window(阻礙注意力算子的融合)和鄰域機制(導致高記憶體消耗)。

- PTv3 消除了對佔 forward time 26% 的相對位置編碼的依賴,有利於更簡單的前置稀疏卷積層。

本文認為這些設計是由現有 point cloud transformers 的 scaling principles 和進步驅動的直覺選擇。重要的是,本文強調了認識 scalability 如何影響 backbone 設計的至關重要性,而不是詳細的模組設計。

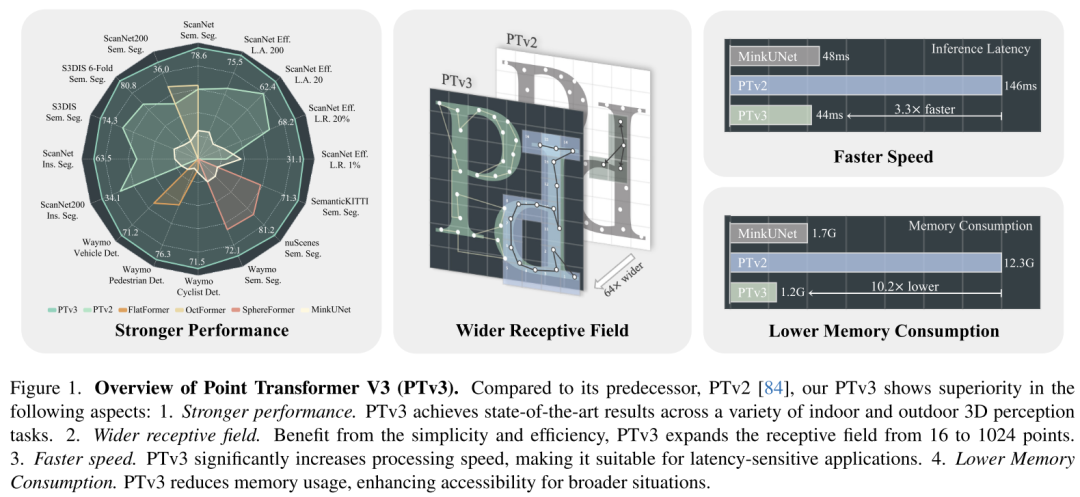

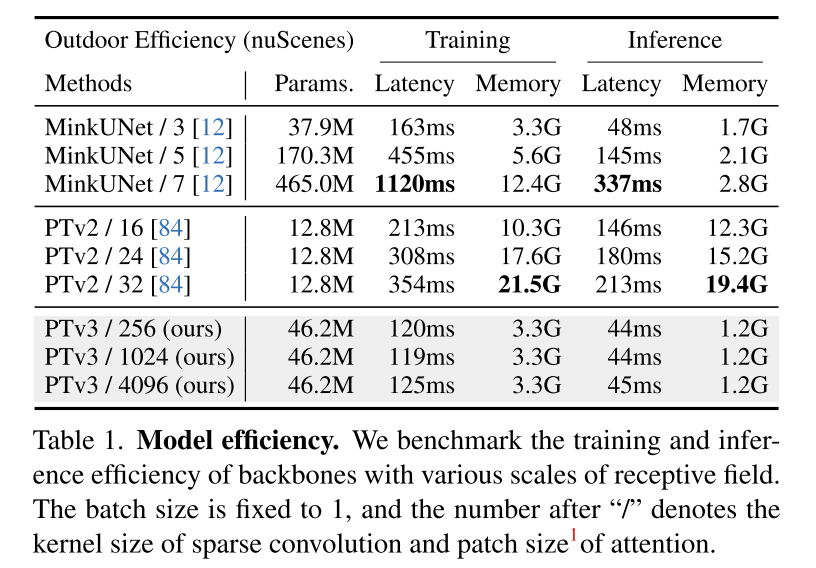

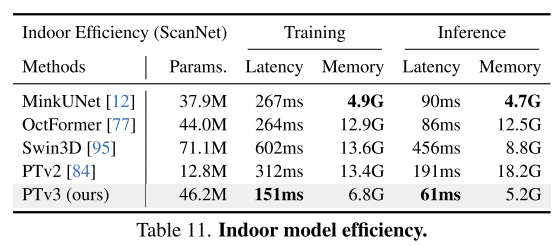

這項原則顯著增強了 scalability ,克服了準確性和效率之間的傳統權衡(見圖 1)。與前身相比,PTv3 的推理速度提高了 3.3 倍,記憶體使用量降低了 10.2 倍。更重要的是,PTv3 利用其固有的 scale 感知範圍的能力,將其感受野從 16 點擴展到 1024 點,同時保持效率。這種 scalability 支撐了其在現實世界感知任務中的卓越性能,其中 PTv3 在室內和室外場景中的 20 多個下游任務中取得了最先進的結果。 PTv3 透過多資料集訓練進一步擴大其資料規模 [85],進一步提升了這些結果。本文希望本文的見解能激發未來這一方向的研究。

圖 1.Point Transformer V3 (PTv3) 概述。與其前身PTv2[84]相比,本文的PTv3在以下方面表現出優越性:1.性能更強。 PTv3 在各種室內和室外 3D 感知任務中均取得了最先進的結果。 2.更寬的感受野。受益於簡單性和效率,PTv3 將感受野從 16 點擴展到 1024 點。 3.速度更快。 PTv3 顯著提高了處理速度,使其適合對延遲敏感的應用程式。 4. 降低記憶體消耗。 PTv3 減少了記憶體使用量,增強了更廣泛情況下的可訪問性。

圖 2. PTv2 各組件的延遲樹狀圖。本文對 PTv2 的每個元件的 forward time 比例進行基準測試和視覺化。 KNN Query 和 RPE 總共佔用了 54% 的 forward time 。

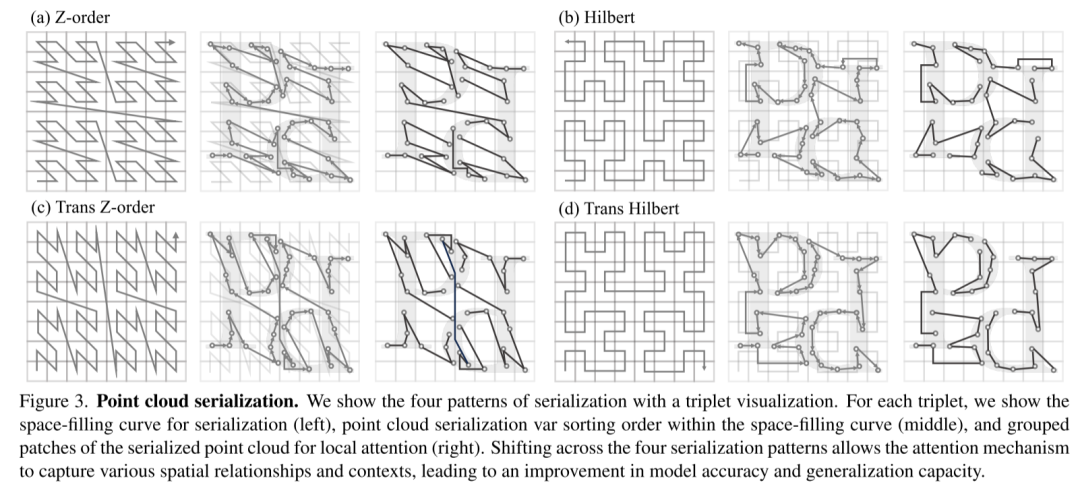

圖 3.點雲序列化。本文透過三元組視覺化展示了四種序列化模式。對於每個三元組,顯示了用於序列化的空間填充曲線(左)、空間填充曲線內的點雲序列化變數排序順序(中)以及用於局部注意力的序列化點雲的grouped patches (右)。四種序列化模式的轉換允許注意力機制捕捉各種空間關係和上下文,從而提高模型準確性和泛化能力。

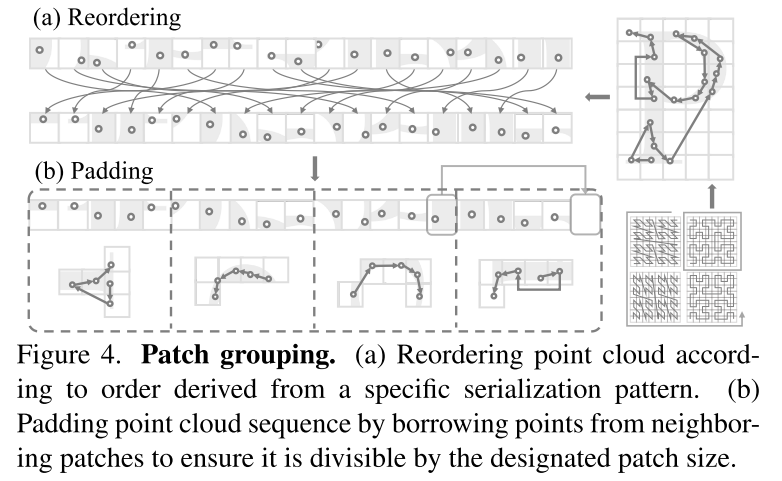

圖 4. Patch grouping。 (a) 根據從特定序列化模式導出的順序對點雲進行重新排序。 (b) 透過借用相鄰 patches 的點來填滿點雲序列,以確保它可以被指定的 patch size 整除。

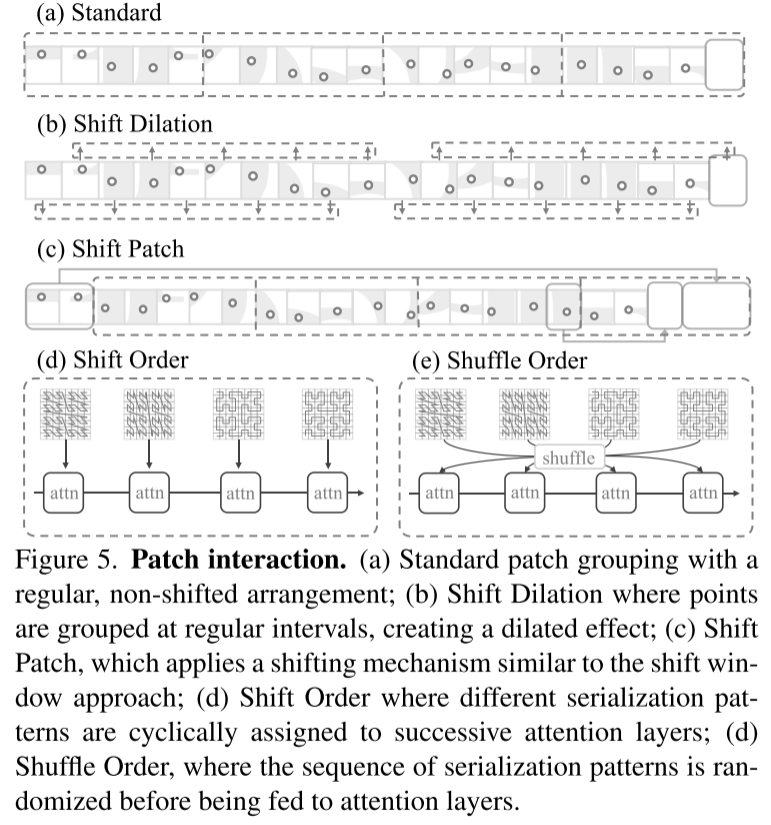

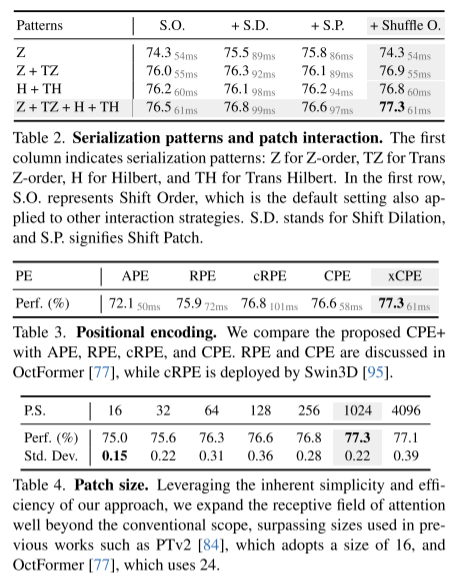

圖 5. Patch interaction。 (a) Standard patch grouping,具有規則的、非移位的排列;(b) 平移擴張,其中點按規則間隔聚合,產生擴張效果;(c) Shift Patch,採用類似於shift window 方法的移位機制;(d) Shift Order,其中不同的序列化模式被循環分配給連續的注意力層;(d) Shuffle Order,序列化模式的序列在輸入到注意層之前被隨機化。

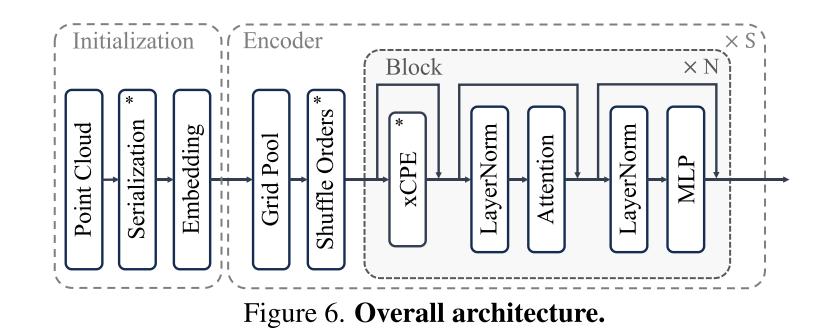

圖 6. 整體架構。

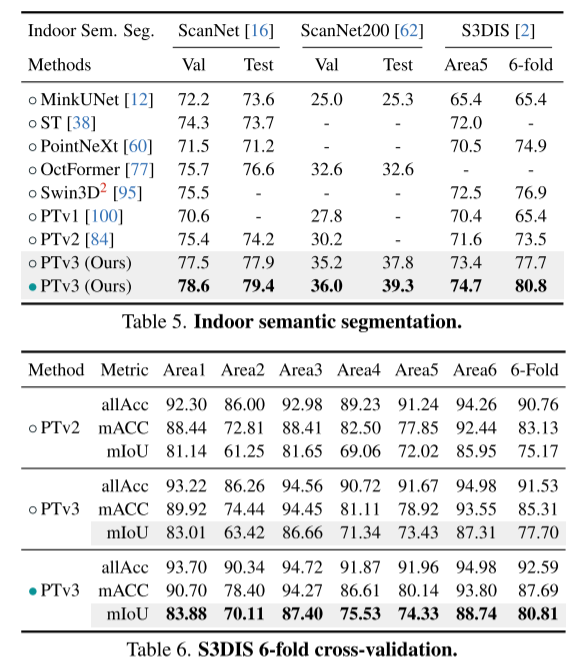

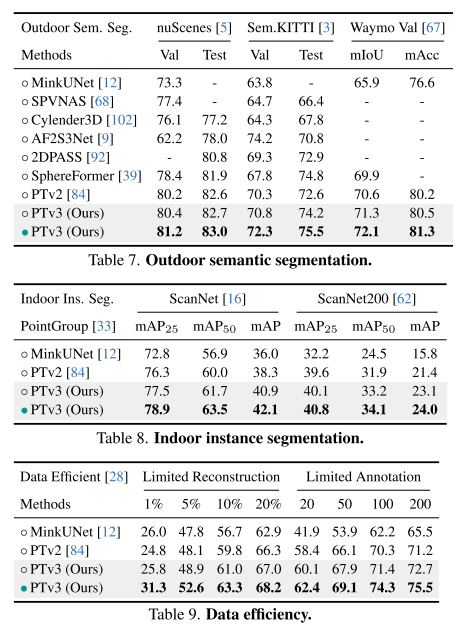

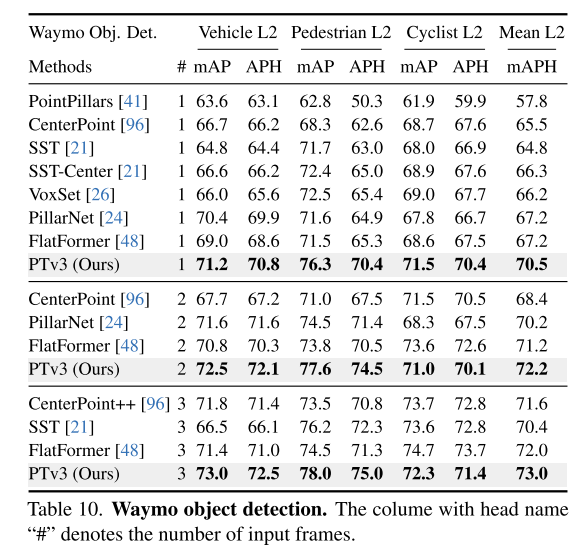

實驗結果:

總結:

本文介紹了Point Transformer V3,它朝著克服點雲處理中準確性和效率之間的傳統權衡邁出了一大步。在對 backbone 設計中 scaling principle 的新穎解釋的指導下,本文認為模型性能受規模的影響比受複雜設計的影響更深刻。透過優先考慮效率而不是影響較小的機制的準確性,本文利用規模的力量,從而提高性能。簡而言之,透過使模型更簡單、更快,本文可以使其更強大。

引用:

Wu, X., Jiang, L., Wang, P., Liu, Z., Liu, X., Qiao, Y., Ouyang, W., He, T., & Zhao, H. (2023). Point Transformer V3: Simpler, Faster, Stronger. ArXiv. /abs/2312.10035

以上是更新版 Point Transformer:更有效率、更快速、更強大!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

0.這篇文章乾了啥?提出了DepthFM:一個多功能且快速的最先進的生成式單目深度估計模型。除了傳統的深度估計任務外,DepthFM還展示了在深度修復等下游任務中的最先進能力。 DepthFM效率高,可以在少數推理步驟內合成深度圖。以下一起來閱讀這項工作~1.論文資訊標題:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

拋棄編碼器-解碼器架構,用擴散模型做邊緣偵測效果更好,國防科大提出DiffusionEdge

Feb 07, 2024 pm 10:12 PM

拋棄編碼器-解碼器架構,用擴散模型做邊緣偵測效果更好,國防科大提出DiffusionEdge

Feb 07, 2024 pm 10:12 PM

目前的深度邊緣檢測網路通常採用編碼器-解碼器架構,其中包含上下採樣模組,以更好地提取多層次的特性。然而,這種結構限制了網路輸出準確且細緻的邊緣檢測結果。針對這個問題,一篇AAAI2024的論文給了新的解決方案。論文題目:DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection作者:葉雲帆(國防科技大學),徐凱(國防科技大學),黃雨行(國防科技大學),易任嬌(國防科技大學),蔡志平(國防科技大學)論文連結:https ://ar

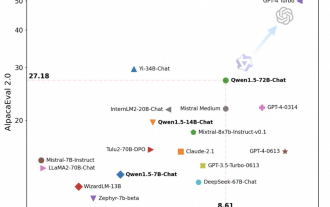

通義千問再開源,Qwen1.5帶來六種體量模型,表現超越GPT3.5

Feb 07, 2024 pm 10:15 PM

通義千問再開源,Qwen1.5帶來六種體量模型,表現超越GPT3.5

Feb 07, 2024 pm 10:15 PM

趕在春節前,通義千問大模型(Qwen)的1.5版上線了。今天上午,新版本的消息引發了AI社群關注。新版大機型包括六個型號尺寸:0.5B、1.8B、4B、7B、14B和72B。其中,最強版本的效能超越了GPT3.5和Mistral-Medium。此版本包含Base模型和Chat模型,並提供多語言支援。阿里通義千問團隊表示,相關技術也已經上線到了通義千問官網和通義千問App。除此之外,今天Qwen1.5的發布還有以下一些重點:支援32K上下文長度;開放了Base+Chat模型的checkpoint;

大模型也能切片,微軟SliceGPT讓LLAMA-2運算效率大增

Jan 31, 2024 am 11:39 AM

大模型也能切片,微軟SliceGPT讓LLAMA-2運算效率大增

Jan 31, 2024 am 11:39 AM

大型語言模型(LLM)通常擁有數十億參數,經過數萬億token的資料訓練。然而,這樣的模型訓練和部署成本都非常昂貴。為了降低運算需求,人們常常採用各種模型壓縮技術。這些模型壓縮技術一般可分為四類:蒸餾、張量分解(包括低秩因式分解)、剪枝、量化。剪枝方法已經存在一段時間,但許多方法需要在剪枝後進行恢復微調(RFT)以保持性能,這使得整個過程成本高昂且難以擴展。蘇黎世聯邦理工學院和微軟的研究者提出了一個解決這個問題的方法,名為SliceGPT。此方法的核心思想是透過刪除權重矩陣中的行和列來降低網路的嵌

更新版 Point Transformer:更有效率、更快速、更強大!

Jan 17, 2024 am 08:27 AM

更新版 Point Transformer:更有效率、更快速、更強大!

Jan 17, 2024 am 08:27 AM

原標題:PointTransformerV3:Simpler,Faster,Stronger論文連結:https://arxiv.org/pdf/2312.10035.pdf程式碼連結:https://github.com/Pointcept/PointTransformerV3作者單位:HKUSHAILabMPIPKUMIT論文想法:本文無意在注意力機制內尋求創新。相反,它側重於利用規模(scale)的力量,克服點雲處理背景下準確性和效率之間現有的權衡。從3D大規模表示學習的最新進展中汲取靈感,

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

波士頓動力Atlas,正式進入電動機器人時代!昨天,液壓Atlas剛「含淚」退出歷史舞台,今天波士頓動力就宣布:電動Atlas上崗。看來,在商用人形機器人領域,波士頓動力是下定決心要跟特斯拉硬剛一把了。新影片放出後,短短十幾小時內,就已經有一百多萬觀看。舊人離去,新角色登場,這是歷史的必然。毫無疑問,今年是人形機器人的爆發年。網友銳評:機器人的進步,讓今年看起來像人類的開幕式動作、自由度遠超人類,但這真不是恐怖片?影片一開始,Atlas平靜地躺在地上,看起來應該是仰面朝天。接下來,讓人驚掉下巴

追趕Gemini Pro,提升推理、OCR能力的LLaVA-1.6太強了

Feb 01, 2024 pm 04:51 PM

追趕Gemini Pro,提升推理、OCR能力的LLaVA-1.6太強了

Feb 01, 2024 pm 04:51 PM

在去年4月,威斯康辛大學麥迪遜分校、微軟研究院和哥倫比亞大學的研究者們共同發布了LLaVA(LargeLanguageandVisionAssistant)。儘管LLaVA只是用一個小的多模態指令資料集進行訓練,但在一些樣本上展現了與GPT-4非常相似的推理結果。然後在10月,他們推出了LLaVA-1.5,透過對原始LLaVA進行簡單修改,在11個基準測試中刷新了SOTA。這次升級的結果非常令人振奮,為多模態AI助理領域帶來了新的突破。研究團隊宣布推出LLaVA-1.6版本,針對推理、OCR和

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

哭死啊,全球狂煉大模型,一網路的資料不夠用,根本不夠用。訓練模型搞得跟《飢餓遊戲》似的,全球AI研究者,都在苦惱怎麼才能餵飽這群資料大胃王。尤其在多模態任務中,這問題尤其突出。一籌莫展之際,來自人大系的初創團隊,用自家的新模型,率先在國內把「模型生成數據自己餵自己」變成了現實。而且還是理解側和生成側雙管齊下,兩側都能產生高品質、多模態的新數據,對模型本身進行數據反哺。模型是啥?中關村論壇上剛露面的多模態大模型Awaker1.0。團隊是誰?智子引擎。由人大高瓴人工智慧學院博士生高一鑷創立,高