RoSA: 一種高效能微調大模型參數的新方法

隨著語言模型擴展到前所未有的規模,對下游任務進行全面微調變得十分昂貴。為了解決這個問題,研究人員開始注意並採用PEFT方法。 PEFT方法的主要想法是將微調的範圍限制在一小部分參數上,以降低計算成本,同時仍能實現自然語言理解任務的最先進性能。透過這種方式,研究人員能夠在保持高效能的同時,節省運算資源,為自然語言處理領域帶來新的研究熱點。

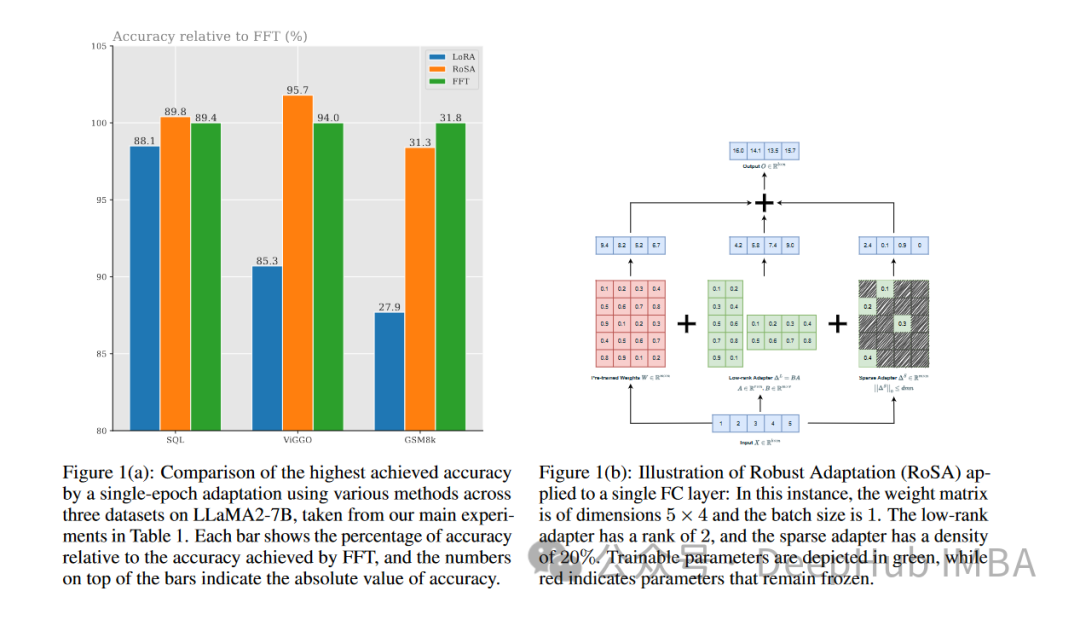

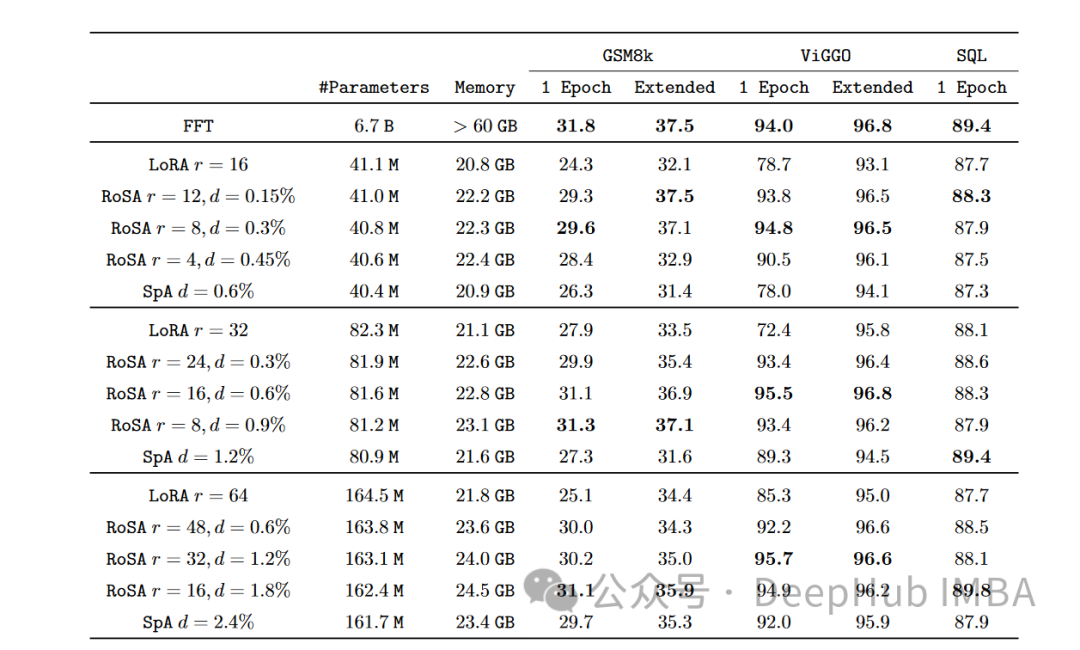

RoSA是一種新的PEFT技術,透過在一組基準測試的實驗中,發現在使用相同參數預算的情況下, RoSA表現出優於先前的低秩自適應(LoRA)和純稀疏微調方法。

本文將深入探討RoSA原理、方法和結果,並解釋其表現如何標誌著有意義的進步。對於希望有效微調大型語言模型的人,RoSA提供了一種新的優於以往方案的解決方案。

對參數高效率微調的需求

NLP已經被基於transformer的語言模型如GPT- 4徹底改變。這些模型透過對大量文本語料庫進行預先訓練,學習到強大的語言表徵。接著,它們透過一個簡單的過程將這些表徵轉移到下游的語言任務。

隨著模型規模從數十億個參數成長到兆個參數,微調帶來了巨大的運算負擔。例如,對於GPT-4這樣一個擁有1.76兆參數的模型,微調可能需要花費數百萬美元。這使得在實際應用中部署變得非常不切實際。

PEFT方法透過限制微調的參數範圍來提高效率和準確性。最近有多種PEFT技術出現,權衡了效率和準確性的關係。

LoRA

一個突出的PEFT方法是低秩適應(LoRA)。 LoRA是由Meta和麻省理工學院的研究人員於2021年推出的。該方法的動機是他們觀察到transformer在其頭部矩陣中表現出低秩結構。 LoRA的提出旨在利用這種低秩結構,以降低計算複雜度並提高模型的效率和速度。

LoRA只對前k個奇異向量進行微調,其他參數保持不變。這樣只需調優O(k)個額外參數,而不是O(n)個。

透過利用這種低秩結構,LoRA可以捕捉下游任務泛化所需的有意義的訊號,並將微調限制在這些頂級奇異向量上,使最佳化和推理更加有效。

實驗表明,LoRA在GLUE基準測試中可以匹配完全微調的性能,同時使用的參數減少了100倍以上。但隨著模型規模的不斷擴大,透過LoRA獲得強大的性能需要增加rank k,與完全微調相比減少了計算節省。

在RoSA之前,LoRA代表了PEFT方法中最先進的技術,只是使用不同的矩陣分解或添加少量額外的微調參數等技術進行了適度的改進。

Robust Adaptation (RoSA)

#Robust Adaptation(RoSA)引進了一種新的參數高效率微調方法。 RoSA的靈感來自於穩健的主成分分析(robust PCA),而不是只依賴低秩結構。

在傳統的主成分分析中,資料矩陣X被分解為X≈L S,其中L是近似主成分的低秩矩陣,S是一個捕獲殘差的稀疏矩陣。 robust PCA更進一步,將X分解為乾淨的低秩L和「污染/損壞」的稀疏S。

RoSA從中汲取靈感,將語言模型的微調分解為:

一個類似LoRA的低秩自適應(L)矩陣,經過微調以近似於主導任務相關訊號

一個高度稀疏的微調(S)矩陣,包含非常少量的大的、選擇性微調的參數,這些參數編碼L錯過的殘差訊號。

明確地建模殘差稀疏分量可以使RoSA比單獨的LoRA達到更高的精確度。

RoSA透過對模型的頭部矩陣進行低秩分解來建構L。這將編碼對下游任務有用的底層語義表示。然後RoSA選擇性地將每層最重要的前m個參數微調為S,而所有其他參數保持不變。這個步驟會捕捉不適合低秩擬合的殘差訊號。

微調參數的數量m比LoRA單獨所需的rank k小一個數量級。因此結合L中的低秩頭矩陣,RoSA維持了極高的參數效率。

RoSA也採用了一些其他簡單但有效果的最佳化:

#殘差稀疏連接:在每個transformer區塊的輸出經過層歸一化和前饋子層之前,直接向其添加S個殘差。這可以模擬L錯過的訊號。

獨立稀疏掩碼:S中選擇的用於微調的指標是為每個transformer層獨立產生的。

共享低秩結構:在L的所有層之間共享相同的低秩基底U,V矩陣,就像在LoRA中一樣。這將捕獲一致子空間中的語義概念。

這些架構選擇為RoSA建模提供了類似於完全微調的靈活性,同時保持了最佳化和推理的參數效率。利用這種結合穩健低秩自適應和高度稀疏殘差的PEFT方法,RoSA實現了精確度效率折衷的新技術。

實驗與結果

研究人員在12個NLU資料集的綜合基準上對RoSA進行了評估,這些資料集涵蓋了文本檢測、情緒分析、自然語言推理和魯棒性測驗等任務。他們使用基於人工智慧助理LLM的RoSA進行了實驗,使用了120億個參數模型。

在每個任務上,在使用相同的參數時,RoSA的表現都明顯優於LoRA。兩種方法的總參數都差不多為整個模型的0.3%左右。這意味著LoRA的k = 16, RoSA的m =5120這兩種情況下都有大約450萬個微調參數。

RoSA也符合或超過了純稀疏微調基準的效能。

在評估對抗範例的穩健性的ANLI基準上,RoSA的得分為55.6,而LoRA的得分為52.7。這表明了泛化和校準的改進。

對於情緒分析任務SST-2和IMDB, RoSA的準確率達到91.2%和96.9%,而LoRA的準確率為90.1%和95.3%。

在WIC(一項具有挑戰性的詞義消歧測驗)上,RoSA的F1得分為93.5,而LoRA的F1得分為91.7。

在所有12個資料集中,RoSA在匹配的參數預算下普遍表現出比LoRA更好的效能。

值得注意的是,RoSA能夠在不需要任何特定於任務的調優或專門化的情況下實現這些增益。這使得RoSA適合作為通用的PEFT解決方案使用。

總結

隨著語言模型規模的持續快速成長,減少對其微調的運算需求是一個迫切需要解決的問題。像LoRA這樣的參數高效能自適應訓練技術已經顯示出初步的成功,但面臨低秩近似的內在限制。

RoSA將魯棒低秩分解和殘差高度稀疏微調有機地結合在一起,提供了一個令人信服的新解決方案。透過考慮透過選擇性稀疏殘差來逃避低秩擬合的訊號,它大大提高了PEFT的效能。經驗評估表明,在不同的NLU任務集上,LoRA和不受控制的稀疏性基線有了明顯的改進。

RoSA在概念上簡單但高效能,能進一步推進參數效率、適應性表徵和持續學習的交叉研究,以擴大語言智慧。

以上是RoSA: 一種高效能微調大模型參數的新方法的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

為什麼大型語言模型都在使用 SwiGLU 作為激活函數?

Apr 08, 2024 pm 09:31 PM

為什麼大型語言模型都在使用 SwiGLU 作為激活函數?

Apr 08, 2024 pm 09:31 PM

如果你一直在關注大型語言模型的架構,你可能會在最新的模型和研究論文中看到「SwiGLU」這個詞。 SwiGLU可以說是在大語言模型中最常使用的激活函數,我們這篇文章就來對它進行詳細的介紹。 SwiGLU其實是2020年Google提出的激活函數,它結合了SWISH和GLU兩者的特徵。 SwiGLU的中文全名為“雙向門控線性單元”,它將SWISH和GLU兩種激活函數進行了優化和結合,以提高模型的非線性表達能力。 SWISH是一種非常普遍的激活函數,它在大語言模型中得到廣泛應用,而GLU則在自然語言處理任務中表現出

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

大型語言模型(LLM)是在龐大的文字資料庫上訓練的,在那裡它們獲得了大量的實際知識。這些知識嵌入到它們的參數中,然後可以在需要時使用。這些模型的知識在訓練結束時被「具體化」。在預訓練結束時,模型實際上停止學習。對模型進行對齊或進行指令調優,讓模型學習如何充分利用這些知識,以及如何更自然地回應使用者的問題。但是有時模型知識是不夠的,儘管模型可以透過RAG存取外部內容,但透過微調使用模型適應新的領域被認為是有益的。這種微調是使用人工標註者或其他llm創建的輸入進行的,模型會遇到額外的實際知識並將其整合

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

語言模型是對文字進行推理的,文字通常是字串形式,但模型的輸入只能是數字,因此需要將文字轉換成數字形式。 Tokenization是自然語言處理的基本任務,根據特定需求能夠把一段連續的文字序列(如句子、段落等)切分為一個字元序列(如單字、片語、字元、標點等多個單元),其中的單元稱為token或詞語。根據下圖所示的具體流程,首先將文字句子切分成一個個單元,然後將單元素數值化(映射為向量),再將這些向量輸入到模型進行編碼,最後輸出到下游任務進一步得到最終的結果。文本切分依照文本切分的粒度可以將Toke

可視化FAISS向量空間並調整RAG參數提高結果精度

Mar 01, 2024 pm 09:16 PM

可視化FAISS向量空間並調整RAG參數提高結果精度

Mar 01, 2024 pm 09:16 PM

隨著開源大型語言模型的效能不斷提高,編寫和分析程式碼、推薦、文字摘要和問答(QA)對的效能都有了很大的提高。但當涉及QA時,LLM通常會在未訓練資料的相關的問題上有所欠缺,許多內部文件都保存在公司內部,以確保合規性、商業機密或隱私。當查詢這些文件時,會使得LLM產生幻覺,產生不相關、捏造或不一致的內容。一種處理這項挑戰的可行技術是檢索增強生成(RAG)。它涉及透過引用訓練資料來源以外的權威知識庫來增強回應的過程,以提升生成的品質和準確性。 RAG系統包括一個檢索系統,用於從語料庫中檢索相關文檔片段

使用SPIN技術進行自我博弈微調訓練的LLM的最佳化

Jan 25, 2024 pm 12:21 PM

使用SPIN技術進行自我博弈微調訓練的LLM的最佳化

Jan 25, 2024 pm 12:21 PM

2024年是大型語言模型(LLM)快速發展的一年。在LLM的訓練中,對齊方法是一個重要的技術手段,其中包括監督微調(SFT)和依賴人類偏好的人類回饋強化學習(RLHF)。這些方法在LLM的發展中起到了至關重要的作用,但是對齊方法需要大量的人工註釋資料。面對這項挑戰,微調成為一個充滿活力的研究領域,研究人員積極致力於開發能夠有效利用人類資料的方法。因此,對齊方法的發展將推動LLM技術的進一步突破。加州大學最近進行了一項研究,介紹了一種名為SPIN(SelfPlayfInetuNing)的新技術。 S

利用知識圖譜增強RAG模型的能力和減輕大模型虛假印象

Jan 14, 2024 pm 06:30 PM

利用知識圖譜增強RAG模型的能力和減輕大模型虛假印象

Jan 14, 2024 pm 06:30 PM

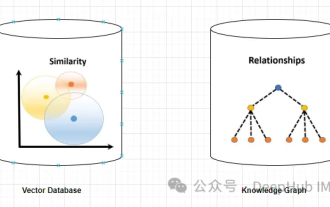

在使用大型語言模型(LLM)時,幻覺是一個常見問題。儘管LLM可以產生流暢連貫的文本,但其產生的資訊往往不準確或不一致。為了防止LLM產生幻覺,可以利用外部的知識來源,例如資料庫或知識圖譜,來提供事實資訊。這樣一來,LLM可以依賴這些可靠的資料來源,從而產生更準確和可靠的文字內容。向量資料庫和知識圖譜向量資料庫向量資料庫是一組表示實體或概念的高維度向量。它們可以用於度量不同實體或概念之間的相似性或相關性,透過它們的向量表示進行計算。一個向量資料庫可以根據向量距離告訴你,「巴黎」和「法國」比「巴黎」和

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

編輯|ScienceAI問答(QA)資料集在推動自然語言處理(NLP)研究中發揮著至關重要的作用。高品質QA資料集不僅可以用於微調模型,也可以有效評估大語言模型(LLM)的能力,尤其是針對科學知識的理解和推理能力。儘管目前已有許多科學QA數據集,涵蓋了醫學、化學、生物等領域,但這些數據集仍有一些不足之處。其一,資料形式較為單一,大多數為多項選擇題(multiple-choicequestions),它們易於進行評估,但限制了模型的答案選擇範圍,無法充分測試模型的科學問題解答能力。相比之下,開放式問答

大規模語言模型高效參數微調--BitFit/Prefix/Prompt 微調系列

Oct 07, 2023 pm 12:13 PM

大規模語言模型高效參數微調--BitFit/Prefix/Prompt 微調系列

Oct 07, 2023 pm 12:13 PM

2018年Google發布了BERT,一經面世便一舉擊敗11個NLP任務的State-of-the-art(Sota)結果,成為了NLP界新的里程碑;BERT的結構如下圖所示,左邊是BERT模型預訓練過程,右邊是對於具體任務的微調過程。其中,微調階段是後續用於一些下游任務的時候進行微調,例如:文本分類,詞性標註,問答系統等,BERT無需調整結構就可以在不同的任務上進行微調。透過」預訓練語言模型+下游任務微調」的任務設計,帶來了強大的模型效果。從此,「預訓練語言模型+下游任務微調」便成為了NLP領域主流訓