LLM大語言模型與檢索增強生成

LLM大語言模型通常使用Transformer架構進行訓練,透過大量文字資料來提高理解和產生自然語言的能力。這些模型在聊天機器人、文字摘要、機器翻譯等領域中廣泛應用。一些知名的LLM大語言模型包括OpenAI的GPT系列和谷歌的BERT等。

在自然語言處理領域,檢索增強生成是一種結合了檢索和產生的技術。它透過從大規模文字語料庫中檢索相關訊息,並利用生成模型重新組合和排列這些訊息,產生滿足要求的文字。這種技術有廣泛的應用,包括文字摘要、機器翻譯、對話生成等任務。透過利用檢索和產生的優勢,檢索增強生成能夠提高文字生成的品質和準確性,從而在自然語言處理領域中發揮重要作用。

在LLM大語言模型中,檢索增強生成被認為是提升模型效能的重要技術手段。透過融合檢索和生成,LLM可以更有效地從海量文本中獲取相關訊息,並產生高品質的自然語言文字。這種技術手段能夠顯著提升模型的生成效果與準確性,更能滿足各類自然語言處理應用的需求。透過結合檢索和生成,LLM大語言模型能夠克服傳統生成模型的一些限制,例如生成內容的一致性和相關性問題。因此,檢索增強生成在提高模型效能方面具有巨大潛力,並有望在未來的自然語言處理研究中發揮重要作用。

使用檢索增強產生技術自訂用於特定用例的LLM大語言模型步驟

要使用檢索增強產生自訂用於特定用例的LLM大語言模型,可以按照下列步驟進行:

1.準備資料

首先,準備大量的文字資料是建立LLM大語言模型的關鍵步驟。這些資料包括訓練資料和檢索資料。訓練資料用於訓練模型,而檢索資料則用於從中檢索相關資訊。 為了滿足特定用例的需求,可以根據需要選擇相關的文字資料。這些數據可以從網路上獲取,例如相關文章、新聞、論壇貼文等。選擇合適的資料來源對於訓練出高品質的模型至關重要。 為了確保訓練資料的質量,需要對資料進行預處理和清洗。這包括去除雜訊、標準化文字格式、處理缺失值等。清洗後的資料能夠更好地用於訓練模型,提高模型的準確性和性能。 另外

2.訓練LLM大語言模型

使用現有的LLM大語言模型框架,如OpenAI的GPT系列或Google的BERT,對準備好的訓練資料進行訓練。在訓練過程中,可以進行微調以提高模型在特定用例下的效能。

3.建構檢索系統

為了實現檢索增強生成,需要建立一個用於從大規模文本語料庫中檢索相關資訊的檢索系統。可以採用現有的搜尋引擎技術,例如基於關鍵字或基於內容的檢索。此外,還可以利用更先進的深度學習技術,例如基於Transformer的檢索模型,以提升檢索效果。這些技術可以透過分析語義和上下文訊息,更好地理解使用者的查詢意圖,並準確地傳回相關的結果。透過不斷優化和迭代,檢索系統可以在大規模文字語料庫中有效地檢索與使用者需求相關的資訊。

4.結合檢索系統和LLM大語言模型

將檢索系統和LLM大語言模型結合,實現檢索增強生成。首先,利用檢索系統從大規模文字語料庫檢索相關資訊。然後,利用LLM大語言模型重新排列和組合這些訊息,產生滿足要求的文字。透過這種方式,可以提高生成文字的準確性和多樣性,從而更好地滿足使用者的需求。

5.最佳化和評估

為了滿足特定用例的需求,我們可以對客製化的LLM大語言模型進行最佳化和評估。評估模型的表現可以使用準確率、召回率、F1得分等評估指標。此外,我們還可以使用實際應用場景中的資料來測試模型的實用性。

範例一:用於電影評論的LLM大語言模型

假設我們要自訂一個用於電影評論的LLM大語言模型,讓使用者輸入一個電影名稱,然後模型能夠生成對該電影的評論。

首先,我們需要準備訓練資料和檢索資料。可以從網路上取得相關的電影評論文章、新聞、論壇貼文等,作為訓練資料和檢索資料。

然後,我們可以使用OpenAI的GPT系列框架來訓練LLM大語言模型。在訓練過程中,可以讓模型針對電影評論的任務進行微調,例如調整詞彙表、語料庫等。

接下來,我們可以建立一個基於關鍵字的檢索系統,用於從大規模文字語料庫中檢索相關資訊。在這個例子中,我們可以使用電影名稱作為關鍵字,從訓練資料和檢索資料中檢索相關的評論。

最後,我們將檢索系統和LLM大語言模型結合,實現檢索增強生成。具體來說,可以先使用檢索系統從大規模文本語料庫中檢索與電影名稱相關的評論,然後使用LLM大語言模型對這些評論進行重新排列和組合,以產生符合要求的文本。

以下是使用Python和GPT庫實現上述過程的範例程式碼:

<code>import torch from transformers import GPT2Tokenizer, GPT2LMHeadModel # 准备训练数据和检索数据 train_data = [... # 训练数据] retrieval_data = [... # 检索数据] # 训练LLM大语言模型 tokenizer = GPT2Tokenizer.from_pretrained('gpt2-large') model = GPT2LMHeadModel.from_pretrained('gpt2-large') model.train() input_ids = tokenizer.encode("电影名称", return_tensors='pt') output = model(input_ids) output_ids = torch.argmax(output.logits, dim=-1) generated_text = tokenizer.decode(output_ids, skip_special_tokens=True) # 使用检索系统获取相关评论 retrieved_comments = [... # 从大规模文本语料库中检索与电影名称相关的评论] # 结合检索系统和LLM大语言模型生成评论 generated_comment = "".join(retrieved_comments) + " " + generated_text</code>範例二:幫助用戶回答關於程式設計的問題

首先,我們需要一個簡單的檢索系統,例如使用Elasticsearch。然後,我們可以使用Python編寫程式碼來連接LLM模型和Elasticsearch,並進行微調。以下是一個簡單的範例程式碼:

<code># 导入所需的库import torchfrom transformers import GPT2LMHeadModel, GPT2Tokenizerfrom elasticsearch import Elasticsearch# 初始化Elasticsearch客户端es = Elasticsearch()# 加载GPT-2模型和tokenizertokenizer = GPT2Tokenizer.from_pretrained("gpt2")model = GPT2LMHeadModel.from_pretrained("gpt2")# 定义一个函数,用于通过Elasticsearch检索相关信息def retrieve_information(query): # 在Elasticsearch上执行查询 # 这里假设我们有一个名为"knowledge_base"的索引 res = es.search(index="knowledge_base", body={"query": {"match": {"text": query}}}) # 返回查询结果 return [hit['_source']['text'] for hit in res['hits']['hits']]# 定义一个函数,用于生成文本,并利用检索到的信息def generate_text_with_retrieval(prompt): # 从Elasticsearch检索相关信息 retrieved_info = retrieve_information(prompt) # 将检索到的信息整合到输入中 prompt += " ".join(retrieved_info) # 将输入编码成tokens input_ids = tokenizer.encode(prompt, return_tensors="pt") # 生成文本 output = model.generate(input_ids, max_length=100, num_return_sequences=1, no_repeat_ngram_size=2) # 解码生成的文本 generated_text = tokenizer.decode(output[0], skip_special_tokens=True) return generated_text# 用例:生成回答编程问题的文本user_query = "What is a function in Python?"generated_response = generate_text_with_retrietrieved_response = generate_text_with_retrieval(user_query)# 打印生成的回答print(generated_response)</code>這個Python程式碼範例示範如何使用GPT-2模型與Elasticsearch結合,以實現檢索增強生成。在這個範例中,我們假設有一個名為"knowledge_base"的索引用於儲存與程式設計相關的資訊。在函數retrieve_information中,我們執行了一個簡單的Elasticsearch查詢,然後在generate_text_with_retrieval函數中,我們整合檢索到的信息,並使用GPT-2模型產生答案。

當使用者查詢有關Python函數的問題時,程式碼會從Elasticsearch檢索相關信息,並將其整合到使用者查詢中,然後使用GPT-2模型產生答案。

以上是LLM大語言模型與檢索增強生成的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

探究RNN、LSTM和GRU的概念、區別和優劣

Jan 22, 2024 pm 07:51 PM

探究RNN、LSTM和GRU的概念、區別和優劣

Jan 22, 2024 pm 07:51 PM

在時間序列資料中,觀察值之間存在依賴關係,因此它們不是相互獨立的。然而,傳統的神經網路將每個觀察視為獨立的,這限制了模型對時間序列資料的建模能力。為了解決這個問題,循環神經網路(RNN)被引入,它引入了記憶的概念,透過在網路中建立資料點之間的依賴關係來捕捉時間序列資料的動態特性。透過循環連接,RNN可以將先前的資訊傳遞到當前觀察中,從而更好地預測未來的值。這使得RNN成為處理時間序列資料任務的強大工具。但是RNN是如何實現這種記憶的呢? RNN透過神經網路中的回饋迴路實現記憶,這是RNN與傳統神經

計算神經網路的浮點操作數(FLOPS)

Jan 22, 2024 pm 07:21 PM

計算神經網路的浮點操作數(FLOPS)

Jan 22, 2024 pm 07:21 PM

FLOPS是電腦效能評估的標準之一,用來衡量每秒鐘的浮點運算次數。在神經網路中,FLOPS常用於評估模型的計算複雜度和計算資源的使用率。它是一個重要的指標,用來衡量電腦的運算能力和效率。神經網路是一種複雜的模型,由多層神經元組成,用於進行資料分類、迴歸和聚類等任務。訓練和推斷神經網路需要進行大量的矩陣乘法、卷積等計算操作,因此計算複雜度非常高。 FLOPS(FloatingPointOperationsperSecond)可以用來衡量神經網路的運算複雜度,進而評估模型的運算資源使用效率。 FLOP

利用雙向LSTM模型進行文本分類的案例

Jan 24, 2024 am 10:36 AM

利用雙向LSTM模型進行文本分類的案例

Jan 24, 2024 am 10:36 AM

雙向LSTM模型是一種用於文字分類的神經網路。以下是一個簡單範例,示範如何使用雙向LSTM進行文字分類任務。首先,我們需要匯入所需的函式庫和模組:importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Emquencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Emquencesfromkeras.modelsimportSequentialfromkeras.layers

模糊神經網路的定義與結構解析

Jan 22, 2024 pm 09:09 PM

模糊神經網路的定義與結構解析

Jan 22, 2024 pm 09:09 PM

模糊神經網路是一種將模糊邏輯和神經網路結合的混合模型,用於解決傳統神經網路難以處理的模糊或不確定性問題。它的設計受到人類認知中模糊性和不確定性的啟發,因此被廣泛應用於控制系統、模式識別、資料探勘等領域。模糊神經網路的基本架構由模糊子系統和神經子系統所組成。模糊子系統利用模糊邏輯對輸入資料進行處理,將其轉換為模糊集合,以表達輸入資料的模糊性和不確定性。神經子系統則利用神經網路對模糊集合進行處理,用於分類、迴歸或聚類等任務。模糊子系統和神經子系統之間的相互作用使得模糊神經網路具備更強大的處理能力,能夠

使用卷積神經網路進行影像降噪

Jan 23, 2024 pm 11:48 PM

使用卷積神經網路進行影像降噪

Jan 23, 2024 pm 11:48 PM

卷積神經網路在影像去噪任務中表現出色。它利用學習到的濾波器對雜訊進行過濾,從而恢復原始影像。本文詳細介紹了基於卷積神經網路的影像去噪方法。一、卷積神經網路概述卷積神經網路是一種深度學習演算法,透過多個卷積層、池化層和全連接層的組合來進行影像特徵學習和分類。在卷積層中,透過卷積操作提取影像的局部特徵,從而捕捉影像中的空間相關性。池化層則透過降低特徵維度來減少計算量,並保留主要特徵。全連接層負責將學習到的特徵與標籤進行映射,以實現影像的分類或其他任務。這種網路結構的設計使得卷積神經網路在影像處理與識

SqueezeNet簡介及其特點

Jan 22, 2024 pm 07:15 PM

SqueezeNet簡介及其特點

Jan 22, 2024 pm 07:15 PM

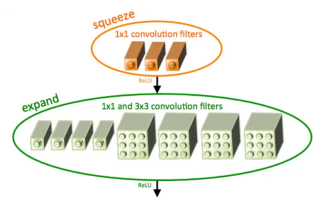

SqueezeNet是一種小巧而精確的演算法,它在高精度和低複雜度之間達到了很好的平衡,因此非常適合資源有限的移動和嵌入式系統。 2016年,DeepScale、加州大學柏克萊分校和史丹佛大學的研究人員提出了一個緊湊高效的捲積神經網路(CNN)-SqueezeNet。近年來,研究人員對SqueezeNet進行了多次改進,其中包括SqueezeNetv1.1和SqueezeNetv2.0。這兩個版本的改進不僅提高了準確性,還降低了計算成本。 SqueezeNetv1.1在ImageNet資料集上的精確度

孿生神經網路:原理與應用解析

Jan 24, 2024 pm 04:18 PM

孿生神經網路:原理與應用解析

Jan 24, 2024 pm 04:18 PM

孿生神經網路(SiameseNeuralNetwork)是一種獨特的人工神經網路結構。它由兩個相同的神經網路組成,這兩個網路共享相同的參數和權重。同時,這兩個網路也共享相同的輸入資料。這個設計靈感源自於孿生兄弟,因為這兩個神經網路在結構上完全相同。孿生神經網路的原理是透過比較兩個輸入資料之間的相似度或距離來完成特定任務,如影像匹配、文字匹配和人臉辨識。在訓練過程中,網路會試圖將相似的資料映射到相鄰的區域,將不相似的資料映射到遠離的區域。這樣,網路能夠學習如何對不同的資料進行分類或匹配,以實現相應

使用Rust編寫一個簡單的神經網路的步驟

Jan 23, 2024 am 10:45 AM

使用Rust編寫一個簡單的神經網路的步驟

Jan 23, 2024 am 10:45 AM

Rust是一種系統級程式語言,專注於安全性、效能和並發性。它旨在提供一種安全可靠的程式語言,適用於作業系統、網路應用和嵌入式系統等場景。 Rust的安全性主要源自於兩個面向:所有權系統和借用檢查器。所有權系統使得編譯器能夠在編譯時檢查程式碼中的記憶體錯誤,從而避免常見的記憶體安全問題。透過在編譯時強制檢查變數的所有權轉移,Rust確保了記憶體資源的正確管理和釋放。借用檢查器則透過對變數的生命週期進行分析,確保同一個變數不會被多個執行緒同時訪問,從而避免了常見的並發安全問題。透過這兩個機制的結合,Rust能夠提供