賈揚清公司高效率帶頭的大型推理成本排行榜出爐

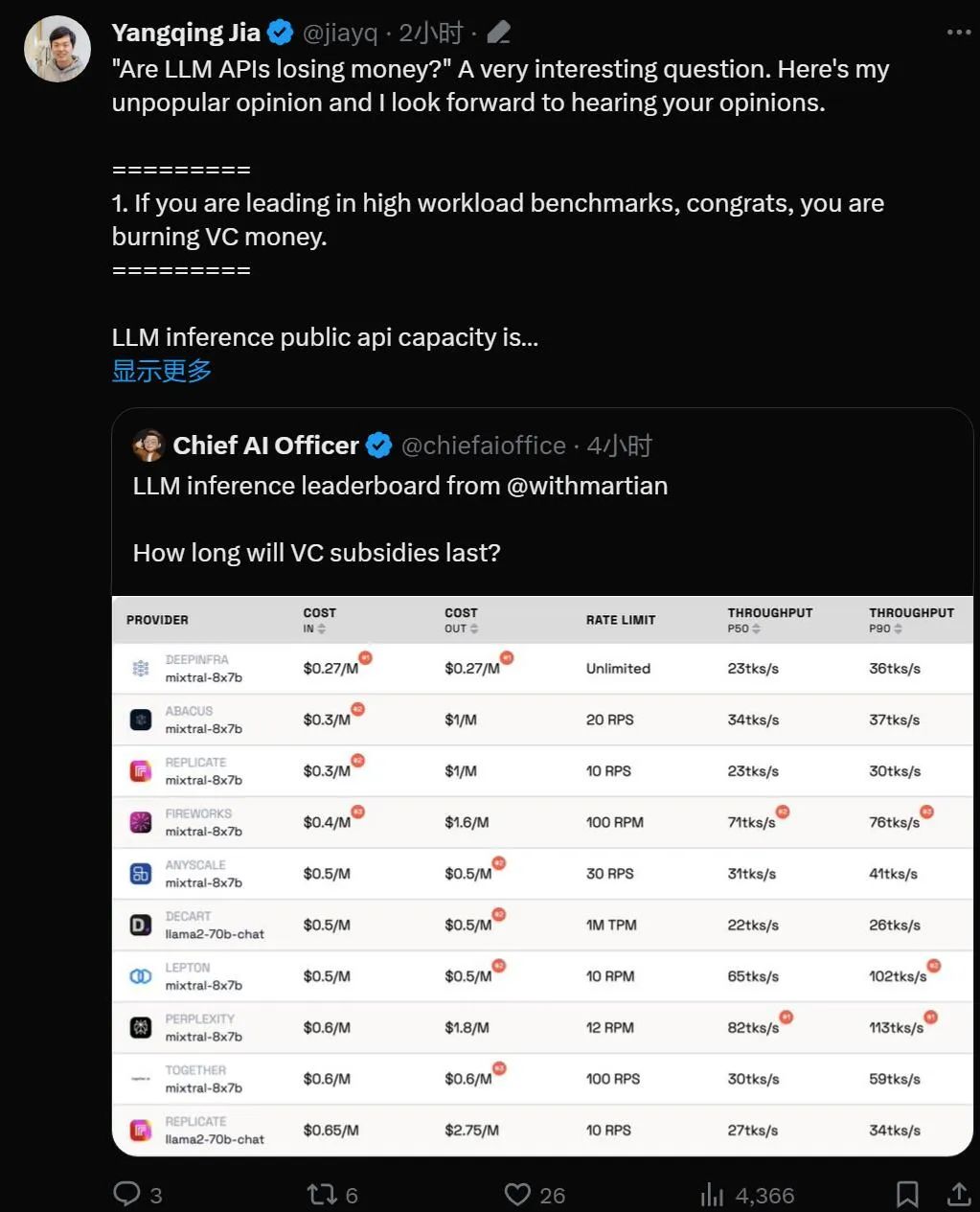

「大模型的 API 是个亏本买卖吗?」

随着大语言模型技术的实用化,许多科技公司推出了大模型 API,供开发者使用。然而,我们不禁开始怀疑基于大模型的业务能否持续下去,尤其是考虑到OpenAI每天烧掉70万美元的情况。

本周四,AI 创业公司 Martian 为我们仔细盘算了一下。

排行榜链接:https://leaderboard.withmartian.com/

The LLM Inference Provider Leaderboard is an open-source ranking of API inference products for large models. It benchmarks the cost, rate limits, throughput, and P50 and P90 TTFT for the Mixtral-8x7B and Llama-2-70B-Chat public endpoints of each vendor.

虽然互为竞争关系,但 Martian 发现各家公司的大模型服务在成本、吞吐量和速率限制方面存在显著的差异。这些差异超过了5倍的成本差异、6倍的吞吐量差异,甚至还有更大的速率限制差异。选择不同的API对于获得最佳性能至关重要,尽管只是业务开展的一部分。

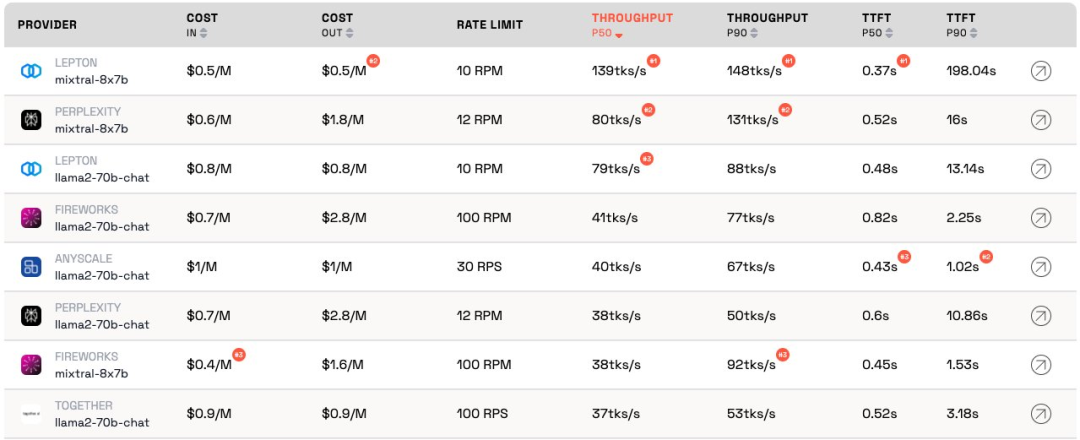

根据当前排名,Anyscale 提供的服务在Llama-2-70B的中等服务负载下具有最佳的吞吐量。对于大型服务负载,Together AI在Llama-2-70B和Mixtral-8x7B上的P50和P90吞吐量表现最佳。

此外,贾扬清的 LeptonAI 在处理短输入和长输出提示的小任务负载时,表现出最佳的吞吐量。其达到的130 tks/s的P50吞吐量,是目前市面上所有厂商提供的模型产品中最快的。

知名 AI 学者、Lepton AI 创始人贾扬清在排行榜放出后第一时间进行了点评,让我们看看他是如何说的。

贾扬清首先阐述了人工智能领域行业现状,然后肯定了基准测试的意义,最后指出 LeptonAI 将帮用户找到最好的 AI 基础策略。

1. 大模型 API 正在「烧钱」

如果模型在高工作负载基准测试中处于领先地位,那么恭喜,它正在「烧钱」。

LLM 推理公共 API 的容量就像是经营一家餐馆:有厨师,需要估算客流量。聘请厨师是要花钱的。延迟和吞吐量可以理解为「你为顾客做饭的速度有多快」。对于一个合理的生意,你需要有「合理」数量的厨师。换句话说,你希望拥有能够承载正常流量的容量,而不是在几秒钟内突然爆发的流量。流量激增意味着需要等待;反之,「厨师」则会无所事事。

在人工智能世界中,GPU 扮演着「厨师」的角色。基准负载是突发的。在低工作负载下,基准负载会混合到正常的流量中,并且测量结果可以准确表示服务在当前工作负载下的情况。

高服务负载场景则很有趣,因为会带来中断。基准测试每天 / 每周仅运行几次,因此不是人们应该期望的常规流量。想象一下,让 100 个人涌入当地的餐馆来检查厨师做菜的速度,结果会很不错。借用量子物理学的术语,这被称为「观察者效应」。干扰越强(即突发负载越大),其精度就越低。换句话说:如果您给某个服务突然提供高负载,并发现该服务响应速度非常快,那么您就知道该服务有相当多的闲置容量。作为投资者,看到这种情况,你应该质问:这种烧钱的方式负责任吗?

2. 模型最终会达到相似的表现

人工智慧領域很喜歡競爭比賽,這的確很有趣。每個人都會很快收斂到相同的解決方案,並且,由於 GPU 的原因,英偉達總是最終的贏家。這要歸功於偉大的開源項目,vLLM 就是一個很好的例子。這意味著,作為提供者,如果您的模型性能比其他模型差很多,您可以透過查看開源解決方案並應用良好的工程來輕鬆趕上。

3.「作為客戶,我不關心提供者的成本」

對於人工智慧應用程式構建者來說,我們很幸運:總是有API 提供者願意「燒錢」。 AI 產業正在燒錢來獲得流量,下一步才是擔心利潤。

基準測試是一項乏味且容易出錯的工作。無論好壞,通常都會發生成功者讚揚你而失敗者指責你的情況。上一輪卷積神經網路基準測試就是如此。這不是一件容易的事,但基準測試將幫助我們在人工智慧基礎設施方面獲得下一個 10 倍的收益。

基於人工智慧框架和雲端基礎設施,LeptonAI 將幫助用戶找到最好的 AI 基礎策略。

以上是賈揚清公司高效率帶頭的大型推理成本排行榜出爐的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

幣圈行情實時數據免費平台推薦前十名發布

Apr 22, 2025 am 08:12 AM

幣圈行情實時數據免費平台推薦前十名發布

Apr 22, 2025 am 08:12 AM

適合新手的加密貨幣數據平台有CoinMarketCap和非小號。 1. CoinMarketCap提供全球加密貨幣實時價格、市值、交易量排名,適合新手與基礎分析需求。 2. 非小號提供中文友好界面,適合中文用戶快速篩選低風險潛力項目。

okx在線 okx交易所官網在線

Apr 22, 2025 am 06:45 AM

okx在線 okx交易所官網在線

Apr 22, 2025 am 06:45 AM

OKX 交易所的詳細介紹如下:1) 發展歷程:2017 年創辦,2022 年更名為 OKX;2) 總部位於塞舌爾;3) 業務範圍涵蓋多種交易產品,支持 350 多種加密貨幣;4) 用戶遍布 200 餘個國家,千萬級用戶量;5) 採用多重安全措施保障用戶資產;6) 交易費用基於做市商模式,費率隨交易量增加而降低;7) 曾獲多項榮譽,如“年度加密貨幣交易所”等。

各大虛擬貨幣交易平台的特色服務一覽

Apr 22, 2025 am 08:09 AM

各大虛擬貨幣交易平台的特色服務一覽

Apr 22, 2025 am 08:09 AM

機構投資者應選擇Coinbase Pro和Genesis Trading等合規平台,關注冷存儲比例與審計透明度;散戶投資者應選擇幣安和火幣等大平台,注重用戶體驗與安全;合規敏感地區的用戶可通過Circle Trade和Huobi Global進行法幣交易,中國大陸用戶需通過合規場外渠道。

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

選擇大宗交易平台時應考慮以下因素:1. 流動性:優先選擇日均交易量超50億美元的平台。 2. 合規性:查看平台是否持有美國FinCEN、歐盟MiCA等牌照。 3. 安全性:冷錢包存儲比例和保險機制是關鍵指標。 4. 服務能力:是否提供專屬客戶經理和定制化交易工具。

支持多種幣種的虛擬貨幣交易平台推薦前十名一覽

Apr 22, 2025 am 08:15 AM

支持多種幣種的虛擬貨幣交易平台推薦前十名一覽

Apr 22, 2025 am 08:15 AM

優先選擇合規平台如OKX和Coinbase,啟用多重驗證,資產自託管可減少依賴:1. 選擇有監管牌照的交易所;2. 開啟2FA和提幣白名單;3. 使用硬件錢包或支持自託管的平台。

數字貨幣交易app容易上手的推薦top10(025年最新排名)

Apr 22, 2025 am 07:45 AM

數字貨幣交易app容易上手的推薦top10(025年最新排名)

Apr 22, 2025 am 07:45 AM

gate.io(全球版)核心優勢是界面極簡,支持中文,法幣交易流程直觀;幣安(簡版)核心優勢是全球交易量第一,簡版模式僅保留現貨交易;OKX(香港版)核心優勢是界面簡潔,支持粵語/普通話,衍生品交易門檻低;火幣全球站(香港版)核心優勢是老牌交易所,推出元宇宙交易終端;KuCoin(中文社區版)核心優勢是支持800 幣種,界面採用微信式交互;Kraken(香港版)核心優勢是美國老牌交易所,持有香港SVF牌照,界面簡潔;HashKey Exchange(香港持牌)核心優勢是香港知名持牌交易所,支持法

幣圈十大行情網站的使用技巧與推薦2025

Apr 22, 2025 am 08:03 AM

幣圈十大行情網站的使用技巧與推薦2025

Apr 22, 2025 am 08:03 AM

國內用戶適配方案包括合規渠道和本地化工具。 1. 合規渠道:通過OTC平台如Circle Trade進行法幣兌換,境內需通過香港或海外平台。 2. 本地化工具:使用幣圈網獲取中文資訊,火幣全球站提供元宇宙交易終端。

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

提供各種複雜的交易工具和市場分析。覆蓋 100 多個國家,日均衍生品交易量超 300 億美元,支持 300 多個交易對與 200 倍槓桿,技術實力強大,擁有龐大的全球用戶基礎,提供專業的交易平台、安全存儲解決方案以及豐富的交易對。