ICLR為什麼不接受Mamba論文? AI社群掀起了大討論

2023年,AI大模型領域的統治者Transformer的地位開始受到挑戰。一種新的架構名為「Mamba」嶄露頭角,它是一種選擇性狀態空間模型,在語言建模方面與Transformer不相上下,甚至有可能超越它。同時,Mamba能夠根據上下文長度的增加實現線性擴展,這使得它在處理實際資料時能夠處理百萬詞彙長度的序列,並提升了5倍的推理吞吐量。這項突破性的性能提升令人矚目,為AI領域的發展帶來了新的可能性。

發布後的一個多月裡,Mamba開始逐漸展現其影響力,並衍生出了MoE-Mamba、Vision Mamba、VMamba、U-Mamba、MambaByte等多個項目。在不斷克服Transformer的短板方面,Mamba顯示出了極大的潛力。這些發展顯示出Mamba不斷發展和進步,為人工智慧領域帶來了新的可能性。

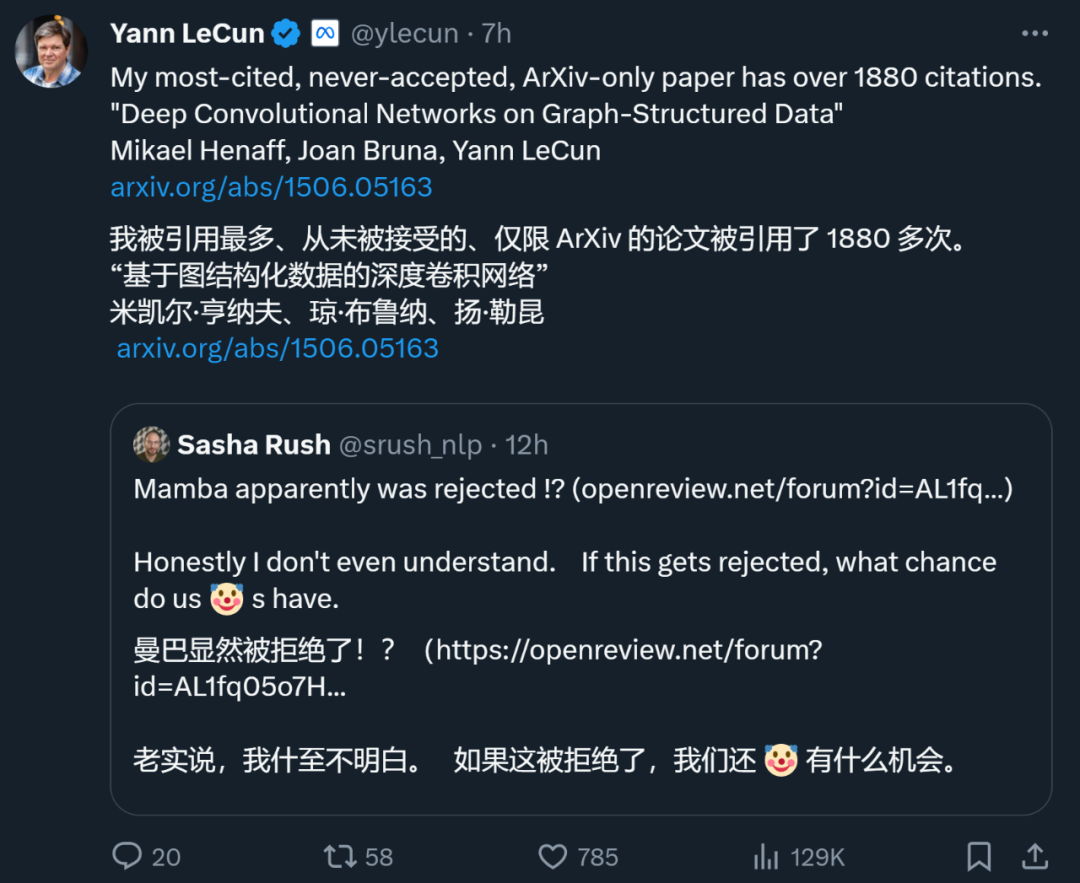

然而,這顆冉冉升起的"新星"在2024年的ICLR會議上遇到了挫折。最新的公開結果顯示,Mamba的論文目前仍處於待定狀態,我們只能在待定決定一欄中看到它的名字,無法確定是被延遲決定還是被拒絕。

整體來看,Mamba收到了四位審查者的評分,分別為8/8/6/3。有人表示,如果遭到這樣的評分仍然被拒絕,確實令人感到不解。

要弄清楚其中的緣由,我們還得看一下打出低分的審查者是怎麼說的。

論文審查頁面:https://openreview.net/forum?id=AL1fq05o7H

為什麼「not good enough」?

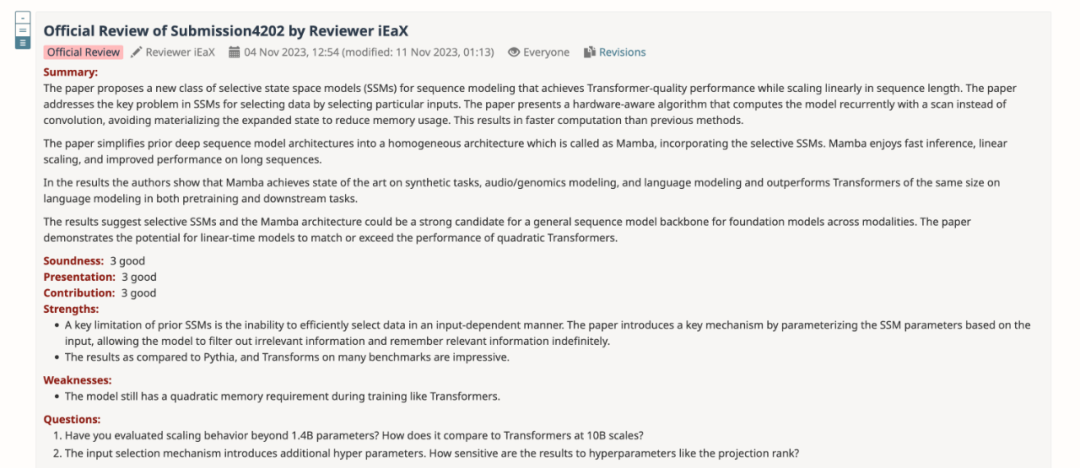

在評審回饋中,給予「3: reject, not good enough」評分的審稿人解釋了自己對於Mamba 的幾點意見:

#對模型設計的想法:

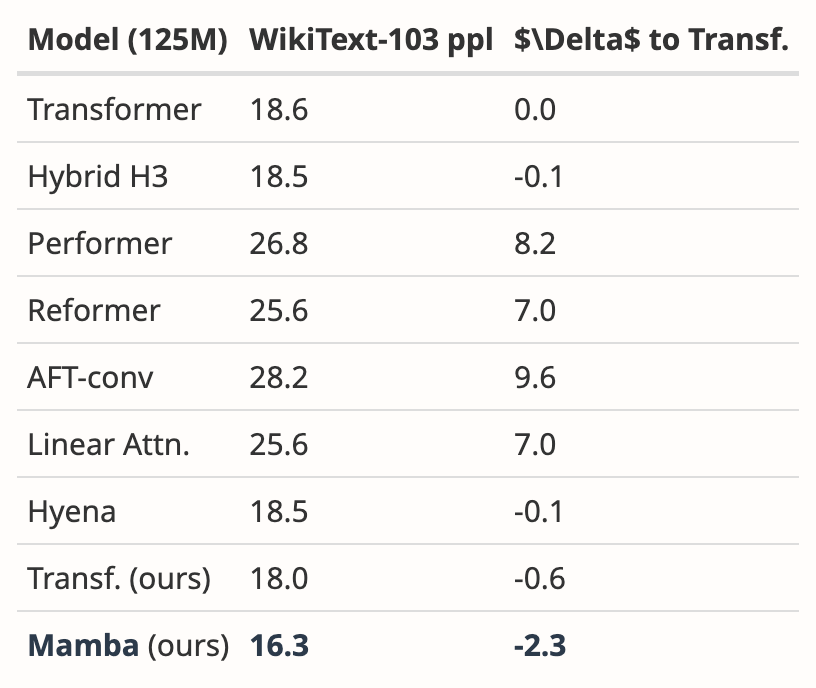

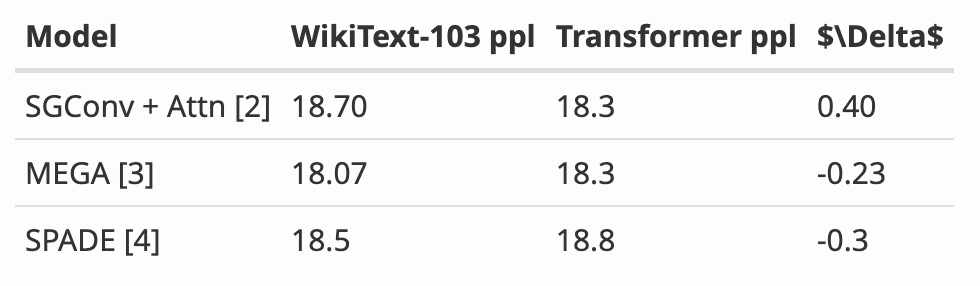

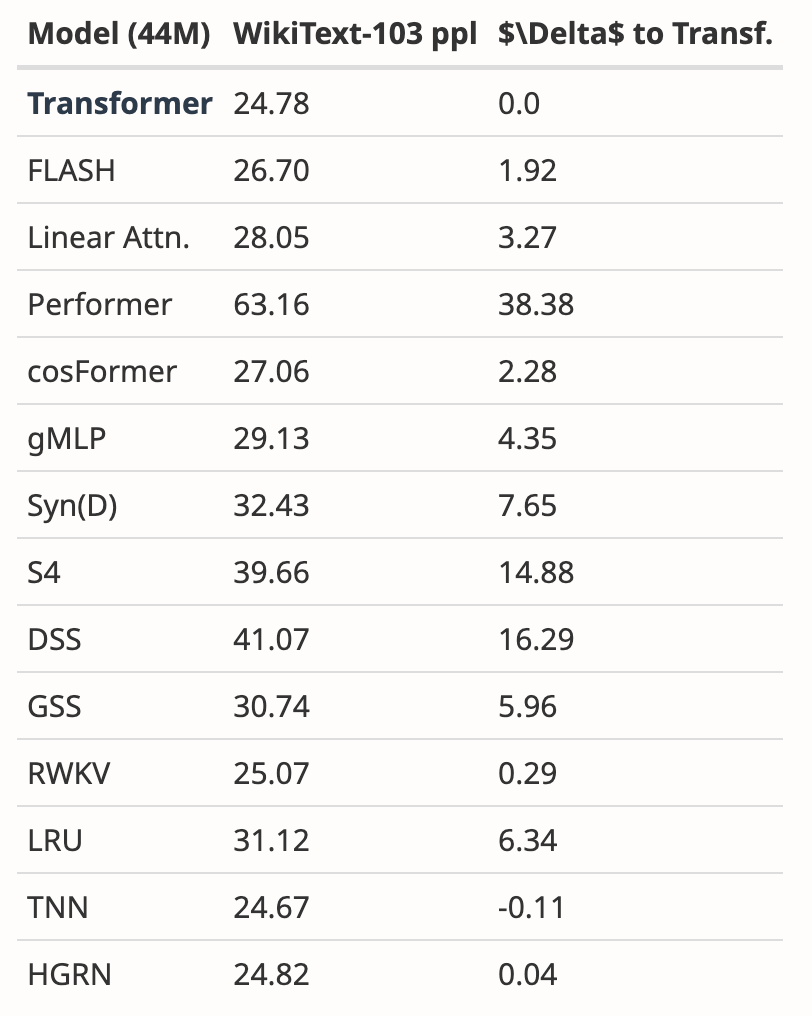

- Mamba 的動機是解決遞歸模型的缺點,同時提高基於注意力模型的效率。有許多研究都是沿著這個方向進行的:S4-diagonal [1]、SGConv [2]、MEGA [3]、SPADE [4],以及許多高效的 Transformer 模型(如 [5])。所有這些模型都達到了接近線性的複雜度,作者需要在模型性能和效率方面將 Mamba 與這些作品進行比較。關於模型效能,一些簡單的實驗(如 Wikitext-103 的語言建模)就足夠了。

- 許多基於注意力的 Transformer 模型顯示出長度泛化能力,即模型可以在較短的序列長度上進行訓練,並在較長的序列長度上進行測試。這方面的例子包括相對位置編碼(T5)和 Alibi [6]。由於 SSM 一般都是連續的,那麼 Mamba 是否具有這種長度泛化能力呢?

對實驗的想法:

- #作者需要與更強的基準進行比較。作者表示 H3 被用作模型架構的動機,然而他們並沒有在實驗中與 H3 進行比較。根據 [7] 中的表 4,在 Pile 資料集上,H3 的 ppl 分別為 8.8(1.25 M)、7.1(3.55 M)和 6.0(1.3B),大大優於 Mamba。作者需要展示與 H3 的比較。

- 對於預訓練模型,作者只展示了零樣本推理的結果。這種設定相當有限,結果無法很好地支持 Mamba 的有效性。我建議作者進行更多的長序列實驗,例如文件摘要,輸入序列自然會很長(例如,arXiv 資料集的平均序列長度大於 8k)。

- 作者聲稱其主要貢獻之一是長序列建模。作者應該在 LRA(Long Range Arena)上與更多基準進行比較,這基本上是長序列理解的標準基準。

- 缺少記憶體基準。儘管第 4.5 節的標題是“速度和內存基準”,但只介紹了速度比較。此外,作者應提供圖 8 左側更詳細的設置,如模型層、模型大小、卷積細節等。作者能否提供一些直覺訊息,說明為什麼當序列長度非常大時,FlashAttention 的速度最慢(圖 8 左)?

此外,另一位審查者也指出 Mamba 存在的不足:該模型在訓練過程中仍然像 Transformers 一樣具有二次記憶體需求。

作者:已修改,求審閱

匯總所有審稿人的意見之後,作者團隊也對論文內容進行了修改和完善,補充了新的實驗結果與分析:

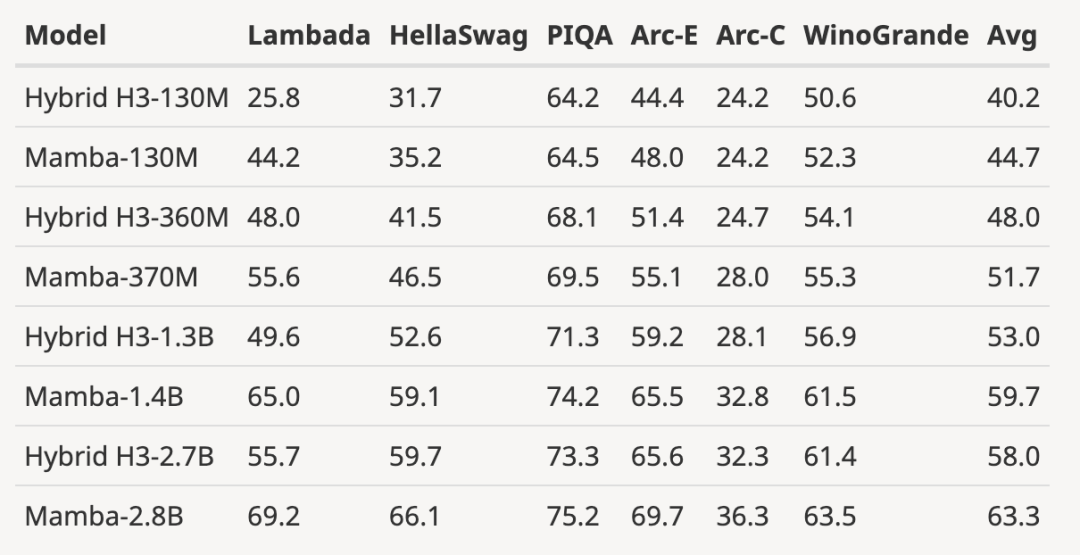

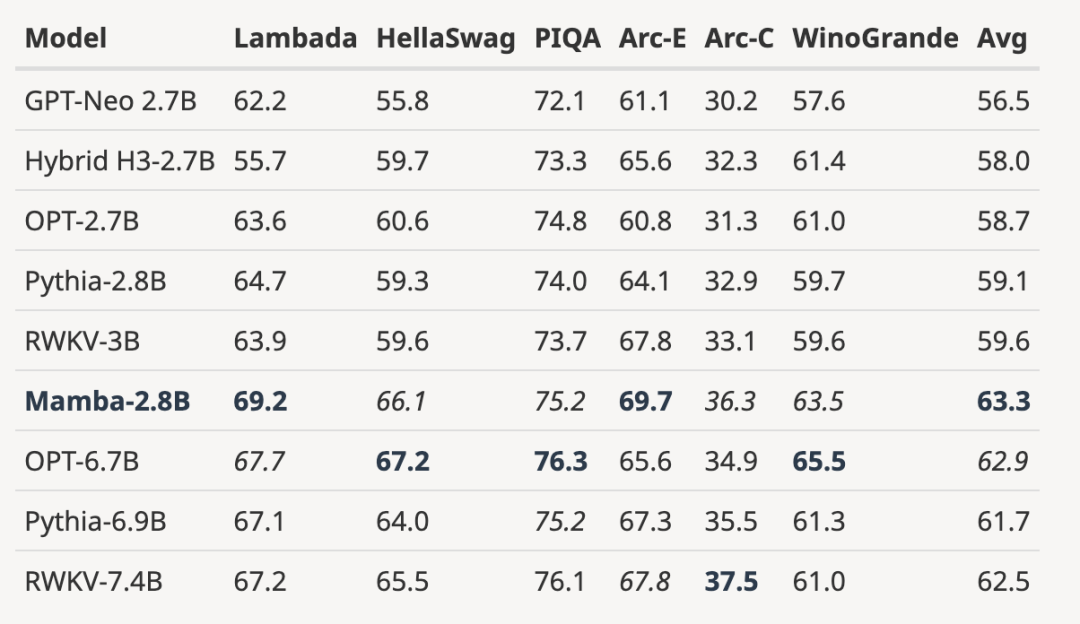

- 增加了H3 模型的評估結果

##作者下載了大小為125M-2.7 B 參數的預訓練H3 模型,並進行了一系列評估。 Mamba 在所有語言評估中都明顯更勝一籌,值得注意的是,這些H3 模型是使用二次注意力的混合模型,而作者僅使用線性時間Mamba 層的純模型在各項指標上都明顯更優。

與預訓練H3 模型的評估比較如下:

- ##將完全訓練過的模型擴展到更大的模型規模

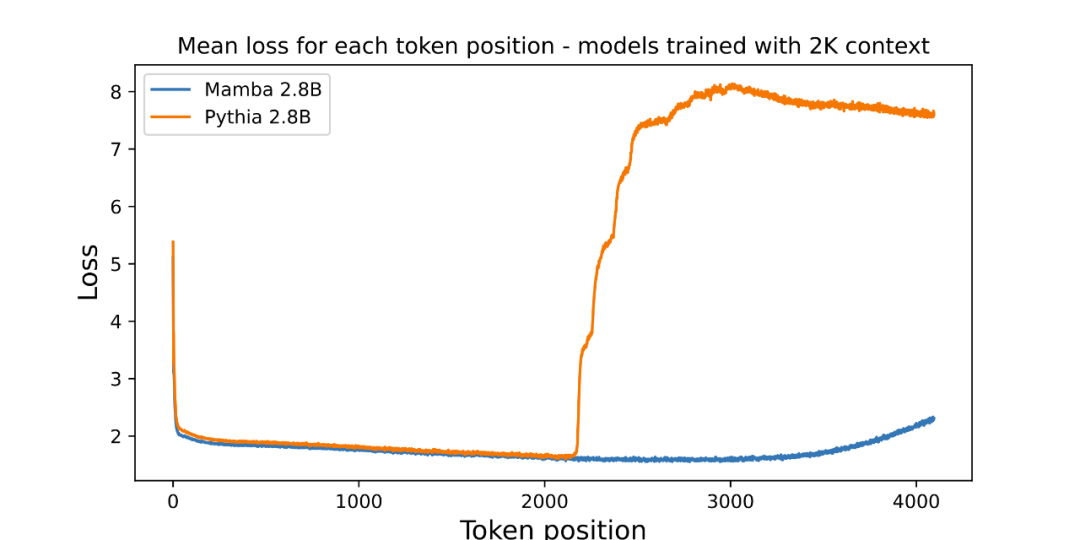

- #展示了超出訓練長度的長度外推結果

作者強調,長度外推並不是本文模型的直接動機,而是將其視為額外功能:

##這裡的基線模型(Pythia)在訓練時並沒有考慮長度外推法,或許還有其他Transformer 變體更具通用性(例如T5 或Alibi 相對位置編碼)。

- 沒有發現任何使用相對位置編碼在 Pile 上訓練的開源 3B 模型,因此無法進行這種比較。

- Mamba 和 Pythia 一樣,在訓練時沒有考慮長度外推法,因此不具有可比性。正如 Transformer 有許多技術(如不同的位置嵌入)來提高它們在長度概括等軸上的能力一樣,在未來的工作中,為類似的能力推導出 SSM 特有的技術可能會很有趣。

- 作者分析了多篇論文的結果,顯示Mamba 在WikiText-103 上的表現明顯優於其他20 多個最新的次二次序列模型。

#儘管如此,兩個月過去了,這篇論文也處於「Decision Pending」流程中,沒有得到「接收」或「拒絕」的明確結果。

#儘管如此,兩個月過去了,這篇論文也處於「Decision Pending」流程中,沒有得到「接收」或「拒絕」的明確結果。

被頂會拒絕的那些論文

在各大AI 頂會中,「投稿數量爆炸」都是一個令人頭痛的問題,所以精力有限的審稿人難免有看走眼的時候。這就導致歷史上出現了許多著名論文被頂會拒絕的情況,包括YOLO、transformer XL、Dropout、支援向量機(SVM)、知識蒸餾、SIFT,還有Google 搜尋引擎的網頁排名演算法PageRank(參見: 《大名鼎鼎的YOLO、PageRank 影響力爆棚的研究,曾被CS 頂會拒稿》)。

甚至,身為深度學習三巨頭之一的 Yann LeCun 也是經常被拒的論文大戶。剛剛,他發推文說,他被引 1887 次的論文「Deep Convolutional Networks on Graph-Structured Data」也被頂會拒絕了。

在 ICML 2022 期間,他甚至「投了三篇,被拒絕三篇」。

所以,論文被某個頂會拒絕不代表沒有價值。在上述被拒絕的論文中,許多論文選擇了轉投其他會議,最後被接收。因此,網友建議 Mamba 轉投陳丹琦等青年學者組成的 COLM。 COLM 是一個專注於語言建模研究的學術場所,專注於理解、改進和評論語言模型技術的發展,或許對 Mamba 這類論文來說是更好的選擇。

不過,無論Mamba 最終能否被ICLR 接收,它都已經成為一份頗具影響力的工作,也讓社區看到了衝破Transformer 桎梏的希望,為超越傳統Transformer 模型的探索注入了新的活力。

以上是ICLR為什麼不接受Mamba論文? AI社群掀起了大討論的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono庫可以讓你更加精確地控制時間和時間間隔,讓我們來探討一下這個庫的魅力所在吧。 C 的chrono庫是標準庫的一部分,它提供了一種現代化的方式來處理時間和時間間隔。對於那些曾經飽受time.h和ctime折磨的程序員來說,chrono無疑是一個福音。它不僅提高了代碼的可讀性和可維護性,還提供了更高的精度和靈活性。讓我們從基礎開始,chrono庫主要包括以下幾個關鍵組件:std::chrono::system_clock:表示系統時鐘,用於獲取當前時間。 std::chron

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

DMA在C 中是指DirectMemoryAccess,直接內存訪問技術,允許硬件設備直接與內存進行數據傳輸,不需要CPU干預。 1)DMA操作高度依賴於硬件設備和驅動程序,實現方式因係統而異。 2)直接訪問內存可能帶來安全風險,需確保代碼的正確性和安全性。 3)DMA可提高性能,但使用不當可能導致系統性能下降。通過實踐和學習,可以掌握DMA的使用技巧,在高速數據傳輸和實時信號處理等場景中發揮其最大效能。

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

在C 中處理高DPI顯示可以通過以下步驟實現:1)理解DPI和縮放,使用操作系統API獲取DPI信息並調整圖形輸出;2)處理跨平台兼容性,使用如SDL或Qt的跨平台圖形庫;3)進行性能優化,通過緩存、硬件加速和動態調整細節級別來提升性能;4)解決常見問題,如模糊文本和界面元素過小,通過正確應用DPI縮放來解決。

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 在實時操作系統(RTOS)編程中表現出色,提供了高效的執行效率和精確的時間管理。 1)C 通過直接操作硬件資源和高效的內存管理滿足RTOS的需求。 2)利用面向對象特性,C 可以設計靈活的任務調度系統。 3)C 支持高效的中斷處理,但需避免動態內存分配和異常處理以保證實時性。 4)模板編程和內聯函數有助於性能優化。 5)實際應用中,C 可用於實現高效的日誌系統。

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

在C 中測量線程性能可以使用標準庫中的計時工具、性能分析工具和自定義計時器。 1.使用庫測量執行時間。 2.使用gprof進行性能分析,步驟包括編譯時添加-pg選項、運行程序生成gmon.out文件、生成性能報告。 3.使用Valgrind的Callgrind模塊進行更詳細的分析,步驟包括運行程序生成callgrind.out文件、使用kcachegrind查看結果。 4.自定義計時器可靈活測量特定代碼段的執行時間。這些方法幫助全面了解線程性能,並優化代碼。

給MySQL表添加和刪除字段的操作步驟

Apr 29, 2025 pm 04:15 PM

給MySQL表添加和刪除字段的操作步驟

Apr 29, 2025 pm 04:15 PM

在MySQL中,添加字段使用ALTERTABLEtable_nameADDCOLUMNnew_columnVARCHAR(255)AFTERexisting_column,刪除字段使用ALTERTABLEtable_nameDROPCOLUMNcolumn_to_drop。添加字段時,需指定位置以優化查詢性能和數據結構;刪除字段前需確認操作不可逆;使用在線DDL、備份數據、測試環境和低負載時間段修改表結構是性能優化和最佳實踐。

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

交易所內置量化工具包括:1. Binance(幣安):提供Binance Futures量化模塊,低手續費,支持AI輔助交易。 2. OKX(歐易):支持多賬戶管理和智能訂單路由,提供機構級風控。獨立量化策略平台有:3. 3Commas:拖拽式策略生成器,適用於多平台對沖套利。 4. Quadency:專業級算法策略庫,支持自定義風險閾值。 5. Pionex:內置16 預設策略,低交易手續費。垂直領域工具包括:6. Cryptohopper:雲端量化平台,支持150 技術指標。 7. Bitsgap:

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中使用字符串流的主要步驟和注意事項如下:1.創建輸出字符串流並轉換數據,如將整數轉換為字符串。 2.應用於復雜數據結構的序列化,如將vector轉換為字符串。 3.注意性能問題,避免在處理大量數據時頻繁使用字符串流,可考慮使用std::string的append方法。 4.注意內存管理,避免頻繁創建和銷毀字符串流對象,可以重用或使用std::stringstream。