從頭開始:快速建立kafka整合環境的springboot指南

Springboot整合Kafka概述

Apache Kafka是分散式串流服務,它可以讓你以極高的吞吐量進行生產、消費和儲存資料。它被廣泛用於建立各種各樣的應用程序,如日誌聚合、度量收集、監控和事務資料管道。

Springboot是一個用於簡化Spring應用程式開發的框架。它提供了開箱即用的自動組裝和約定,從而可以輕鬆地將Kafka整合到Spring應用程式中。

建置Kafka整合Springboot所需的環境

1. 安裝Apache Kafka

- 下載Apache Kafka發行版。

- 解壓縮發行版並啟動Kafka服務。

- 查看Kafka服務日誌,確保它已正常運作。

2. 安裝Springboot

- 下載Springboot發行版。

- 解壓縮發行版並將其新增至系統的路徑。

- 創建一個Springboot應用程式。

程式碼範例

1. 建立Springboot應用程式

public class SpringbootKafkaApplication {

public static void main(String[] args) {

SpringApplication.run(SpringbootKafkaApplication.class, args);

}

}2. 新增Kafka依賴

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-kafka</artifactId>

</dependency>3. 設定Kafka生產者

@Bean

public ProducerFactory<String, String> senderFactory() {

Map<String, Object> config = new LinkedHashMap<>();

config.put(ProducerConfig.BOOTSTRAP_ certification_URL_setConfig, "kafka://127.0.0.1:9092");

config.put(ProducerConfig.KEY_SERIALIZER_setClass_Config, StringDeserializer.class);

config.put(ProducerConfig.KEY_SERIALIZER_setClass_Config, StringDeserializer.class);

return new SimpleKafkaProducerFactory<>(config);

}4. 設定Kafka消費者

@Bean

public ConcurrentKafkaListenerContainerFactory<String, String> kafkaListenerContainerFactory() {

ConcurrentKafkaListenerContainerFactory<String, String> factory = new ConcurrentKafkaListenerContainerFactory<>();

factory.setBrokerAddresses("127.0.0.1:9092");

factory.setKeyDeserializer(new StringDeserializer());

factory.setKeyDeserializer(new StringDeserializer());

return factory;

}5. 建立Kafka生產者服務

@Service

public class ProducerService {

@Autowired

private KafkaTemplate<String, String> kafkaTemplate;

public void sendMessage(String message) {

kafkaTemplate.send("test-kafka", message);

}

}6. 建立Kafka消費者服務

@Service

public class ReceiverService {

@KafkaListener(topics = "test-kafka", id = "kafka-consumer-1")

public void receiveMessage(String message) {

System.out.println("Message received: " + message);

}

}測試

- #啟動Kafka服務。

- 啟動Springboot應用程式。

- 使用ProducerService傳送一則訊息。

- 查看Kafka服務日誌,確保它已正確接收到訊息。

- 查看Springboot應用程式日誌,確保它已正確消費到資訊。

總結

本文示範如何使用Springboot將Kafka整合到Spring應用程式中。我們首先概述了Kafka和Springboot,並解釋瞭如何建立Kafka整合Springboot所需的環境。接下來,我們提供了詳細的Springboot應用程式範例,示範如何使用Springboot來生產和消費Kafka資訊。

以上是從頭開始:快速建立kafka整合環境的springboot指南的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

如何使用PHP和Kafka實現即時股票分析

Jun 28, 2023 am 10:04 AM

如何使用PHP和Kafka實現即時股票分析

Jun 28, 2023 am 10:04 AM

隨著網路和科技的發展,數位化投資已成為人們越來越關注的話題。許多投資人不斷探索研究投資策略,希望能獲得更高的投資報酬率。在股票交易中,即時的股票分析對決策非常重要,其中使用Kafka即時訊息隊列和PHP技術實現更是一種高效且實用的手段。一、Kafka介紹Kafka是由LinkedIn公司開發的一個高吞吐量的分散式發布、訂閱訊息系統。 Kafka的主要特點是

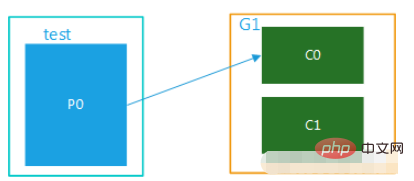

springboot+kafka中@KafkaListener動態指定多個topic怎麼實現

May 20, 2023 pm 08:58 PM

springboot+kafka中@KafkaListener動態指定多個topic怎麼實現

May 20, 2023 pm 08:58 PM

說明本項目為springboot+kafak的整合項目,故其用了springboot中對kafak的消費註解@KafkaListener首先,application.properties中配置用逗號隔開的多個topic。方法:利用Spring的SpEl表達式,將topics配置為:@KafkaListener(topics=“#{’${topics}’.split(’,’)}”)運行程序,console列印的效果如下

如何利用React與Apache Kafka建構即時資料處理應用

Sep 27, 2023 pm 02:25 PM

如何利用React與Apache Kafka建構即時資料處理應用

Sep 27, 2023 pm 02:25 PM

如何利用React和ApacheKafka來建立即時資料處理應用介紹:隨著大數據與即時資料處理的興起,建構即時資料處理應用成為了許多開發者的追求。 React作為一個流行的前端框架,與ApacheKafka作為一個高效能的分散式訊息系統的結合,可以幫助我們建立即時資料處理應用。本文將介紹如何利用React和ApacheKafka建構即時資料處理應用,並

SpringBoot怎麼整合Kafka配置工具類

May 12, 2023 pm 09:58 PM

SpringBoot怎麼整合Kafka配置工具類

May 12, 2023 pm 09:58 PM

spring-kafka是基於java版的kafkaclient與spring的集成,提供了KafkaTemplate,封裝了各種方法,方便操作,它封裝了apache的kafka-client,不需要再導入client依賴org.springframework.kafkaspring-kafkaYML配置kafka:#bootstrap-servers:server1:9092,server2:9093#kafka開發位址,#生產者設定producer:#Kafka提供的序列化和反序列化類別key

五種選擇的可視化工具,用於探索Kafka

Feb 01, 2024 am 08:03 AM

五種選擇的可視化工具,用於探索Kafka

Feb 01, 2024 am 08:03 AM

Kafka視覺化工具的五種選擇ApacheKafka是一個分散式串流處理平台,能夠處理大量即時資料。它廣泛用於建立即時資料管道、訊息佇列和事件驅動的應用程式。 Kafka的視覺化工具可以幫助使用者監控和管理Kafka集群,並且更好地理解Kafka資料流。以下是對五種流行的Kafka視覺化工具的介紹:ConfluentControlCenterConfluent

kafka視覺化工具比較分析:如何選擇最適合的工具?

Jan 05, 2024 pm 12:15 PM

kafka視覺化工具比較分析:如何選擇最適合的工具?

Jan 05, 2024 pm 12:15 PM

如何選擇合適的Kafka視覺化工具?五款工具比較分析引言:Kafka是一種高效能、高吞吐量的分散式訊息佇列系統,被廣泛應用於大數據領域。隨著Kafka的流行,越來越多的企業和開發者需要一個視覺化工具來方便地監控和管理Kafka叢集。本文將介紹五款常用的Kafka視覺化工具,並比較它們的特色和功能,幫助讀者選擇適合自己需求的工具。一、KafkaManager

springboot專案配置多個kafka的範例程式碼

May 14, 2023 pm 12:28 PM

springboot專案配置多個kafka的範例程式碼

May 14, 2023 pm 12:28 PM

1.spring-kafkaorg.springframework.kafkaspring-kafka1.3.5.RELEASE2.設定檔相關資訊kafka.bootstrap-servers=localhost:9092kafka.consumer.group.id=20230321可以並發消費的執行緒數(通常與partitionition# )kafka.consumer.concurrency=10kafka.consumer.enable.auto.commit=falsekafka.boo

如何在 Rocky Linux 上安裝 Apache Kafka?

Mar 01, 2024 pm 10:37 PM

如何在 Rocky Linux 上安裝 Apache Kafka?

Mar 01, 2024 pm 10:37 PM

在RockyLinux上安裝ApacheKafka可以按照以下步驟進行操作:更新系統:首先,確保你的RockyLinux系統是最新的,執行以下命令更新系統軟體包:sudoyumupdate安裝Java:ApacheKafka依賴Java,因此需要先安裝JavaDevelopmentKit(JDKK )。可以透過以下指令安裝OpenJDK:sudoyuminstalljava-1.8.0-openjdk-devel下載和解壓縮:造訪ApacheKafka官方網站()下載最新的二進位套件。選擇一個穩定版本