準確率不足20%,GPT-4V/Gemini竟看不懂漫畫!首個影像序列基準測試開源

OpenAI的GPT-4V和Google的Gemini多模態大語言模型引起了業界和學界的廣泛關注。這些模型在多個領域展示了對影片的深入理解能力,從不同角度呈現了其潛力。人們普遍認為這些進展是通往通用人工智慧(AGI)的重要一步。

可如果告訴你,GPT-4V連漫畫中的人物行為都會看錯, 試問:元芳,你怎麼看?

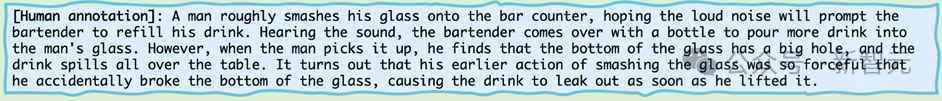

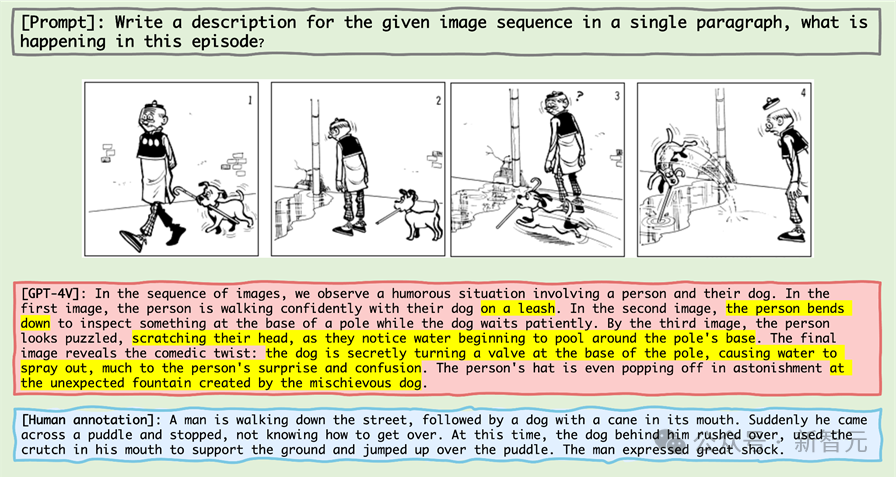

我們來看看這幅迷你漫畫系列:

#圖片

#圖片

##如果讓生物界最高智能體-人類,也就是讀者朋友來描述, 你大概率會說:

那我們來看看當機器界最高智能體-也就是GPT-4V來看這幅迷你漫畫系列的時候,它會這麼描述呢?

#GPT-4V作為公認的站在鄙視鏈頂端的機器智能體,居然公然睜眼說瞎話。

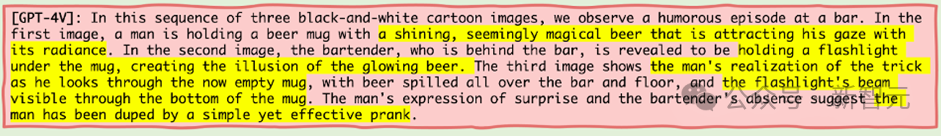

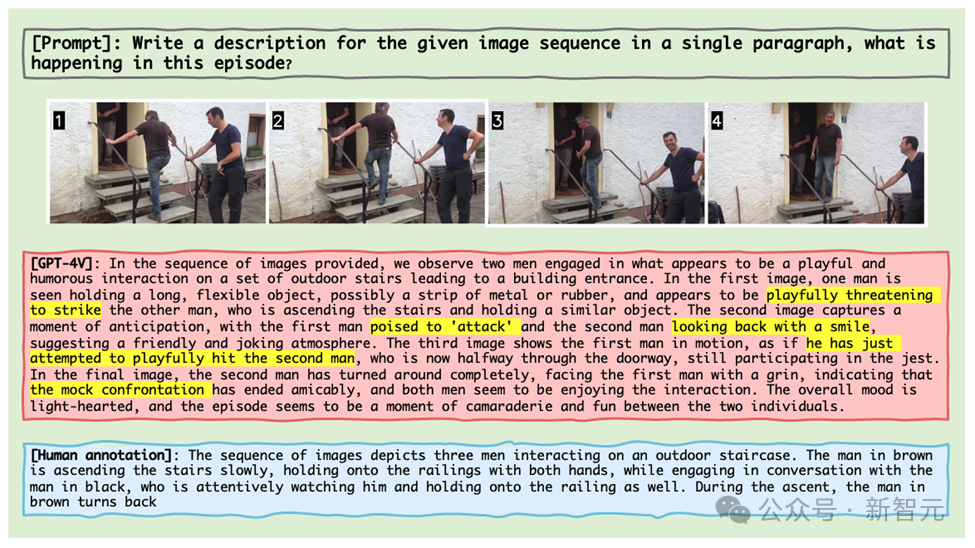

還有更離譜的是,就算給GPT-4V實際的生活圖像片段,它也會把一個人上樓梯過程中與另一個人交談的行為也離譜的識別成兩個人手持“武器」互相打架嬉鬧(如下圖)。

Gemini也不遑多讓,同樣的圖像片段,把這個過程看成了男子艱難上樓並與妻子爭吵被鎖在屋裡。

這些例子都來自於馬裡蘭大學聯合北卡教堂山的研究團隊的最新成果,他們推出了一個專門為MLLM設計的圖像序列的推理基準測試—Mementos。

就像諾蘭的電影《Memento記憶片段》重新定義了敘事方式,Mementos正在重塑測試人工智慧的上限。

作為一個全新的基準測試,它挑戰的是人工智慧對如記憶碎片般的圖像序列的理解。

論文連結:https://arxiv.org/abs/2401.10529

專案首頁:https://mementos -bench.github.io

Mementos是第一個專為MLLM設計的圖像序列推理的基準測試,主要關注大模型在連續圖像上的對象幻覺和行為幻覺。

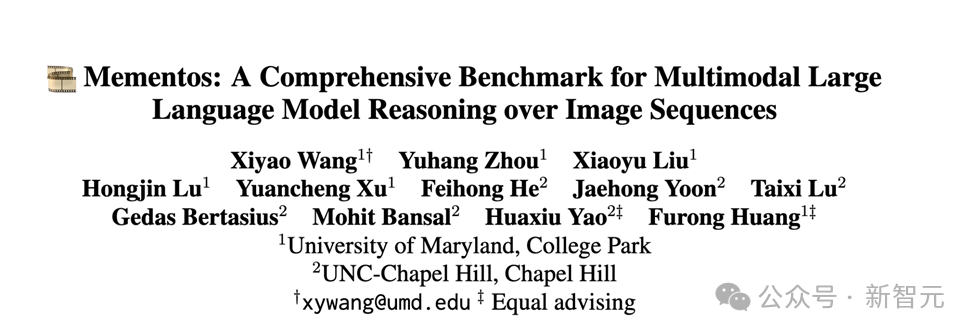

其涉及的圖片類型多樣,涵蓋三大類別:真實世界圖像,機器人圖像,以及動漫圖像。

並且包含了4,761個不同長度的多樣化影像序列,每個序列都配有人類註釋的主要物件及其在序列中的行為描述。

目前資料已經開源,而且還在更新中。

幻覺類型

作者在論文中闡述了MLLM在Mementos中會產生的兩種幻覺:物件幻覺(object hallucination)和行為幻覺(behavior hallucination) 。

顧名思義, 對象幻覺是幻想出不存在的對象(object), 而行為幻覺則是幻想出對象並沒有做出的動作與行為。

評估方式

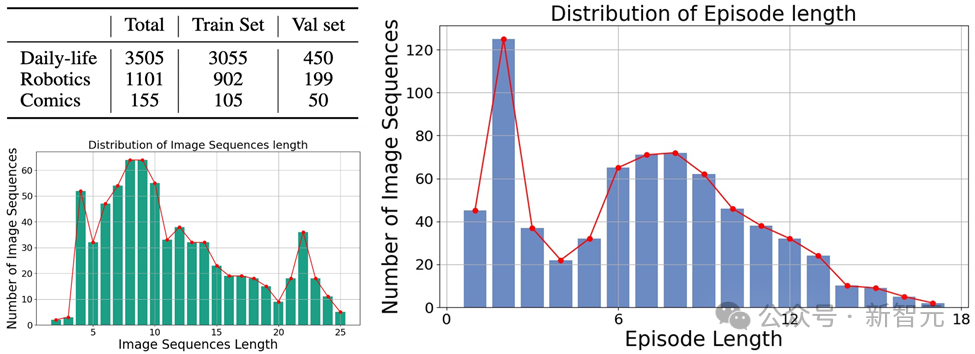

###對於如何準確的評估MLLM在Mementos上的行為幻覺和物件幻覺,研究團隊選擇了將MLLM產生的圖像描述和人標註的描述進行關鍵字配對。 ###為了自動化評測每一個MLLM的表現,作者採用了GPT-4輔助測試的方法來進行評估:

圖片

圖片

1.作者將圖像序列和提示詞作為輸入給MLLM,並產生與對應圖像序列對應的描述;

2. 請求GPT-4提取AI生成描述中的物件和行為關鍵字;

3. 取得兩個關鍵字清單:AI產生的物件關鍵字清單和AI產生的行為關鍵字清單;

4. 計算AI產生的物件關鍵字清單和行為關鍵字清單和人的標註的關鍵字表的召回率、準確率和F1指標。

評估結果

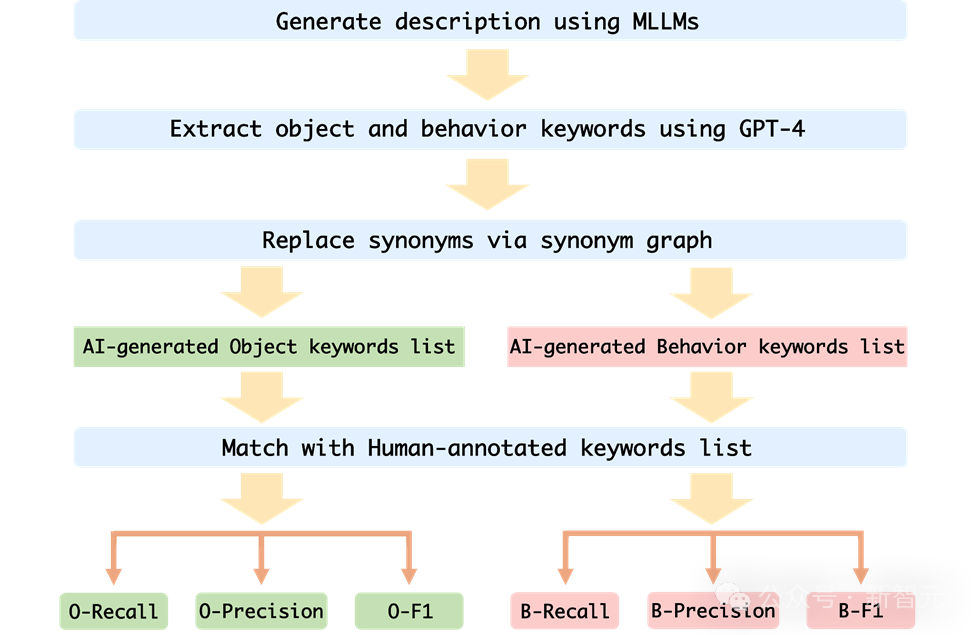

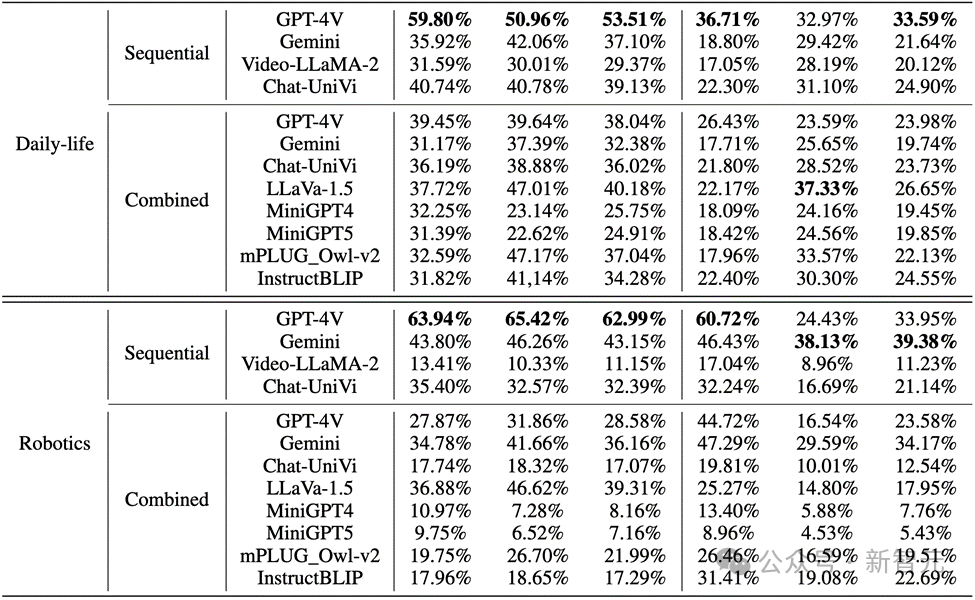

作者在Mementos上評估了MLLMs在序列影像推理方面的表現,並對包括GPT4V和Gemini在內的九種最新的MLLMs進行了細緻的評估。

MLLM被要求來描述影像序列中正在發生的事件,從而來測評MLLM對於連續影像的推理能力。

結果發現,如下圖所示,GPT-4V和Gemini對於人物行為在漫畫資料集的正確率竟然不到20%。

圖片

圖片

而在真實世界影像和機器人影像中,GPT-4V和Gemini的表現也不盡如人意:

圖片

圖片

關鍵點

#1. 在評估多模態大型語言模型時,GPT-4V和LLaVA-1.5分別是在黑盒和開源MLLMs中表現最好的模型。 GPT-4V在理解影像序列方面的推理能力優於其他所有MLLMs,而LLaVA-1.5在物件理解方面幾乎與黑盒模型Gemini相當或甚至超越。

2. 雖然Video-LLaMA-2和Chat-UniVi是為視訊理解設計的,但它們並沒有顯示出比LLaVA-1.5更好的優勢。

3. 所有MLLMs在影像序列中物件推理的三個指標上表現顯著優於行為推理,表明當前MLLMs在從連續影像中自主推斷行為的能力不強。

4. 黑盒模型在機器人領域的表現最佳,而開源模型在日常生活領域表現相對較好。這可能與訓練資料的分佈偏移有關。

5. 訓練資料的限制導致開源MLLMs的推理能力較弱。這顯示了訓練資料的重要性以及它對模型表現的直接影響。

錯誤原因

作者對目前多模態大型語言模型在處理影像序列推理時失敗的原因的分析,主要識別了三個錯誤原因:

1. 物件與行為幻覺之間的交互作用

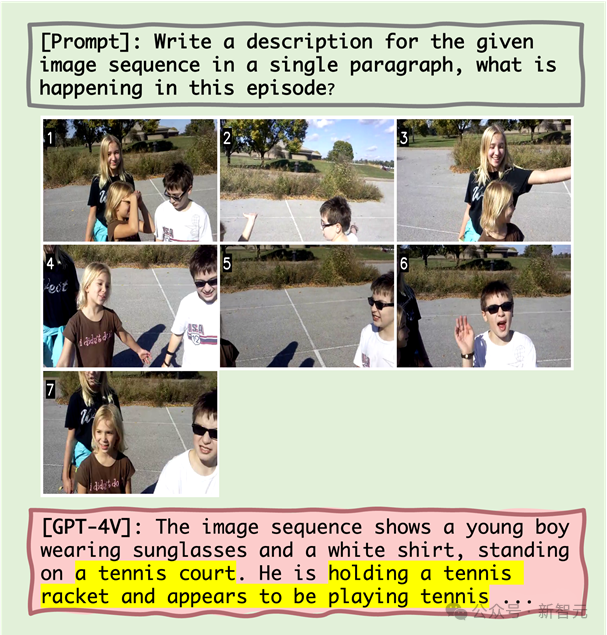

#研究假設,錯誤的物件辨識會導致隨後的行為辨識不準確。量化分析和案例研究表明,對象幻覺會在一定程度上導致行為幻覺。例如,當MLLM錯誤地將場景識別為網球場後,可能會描述人物正在打網球,即使這種行為在影像序列中並不存在。

2. 共現對行為幻覺的影響

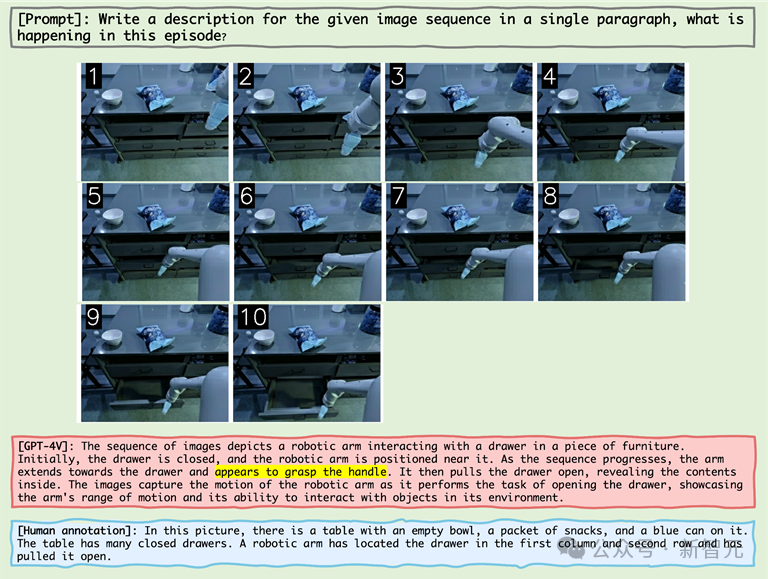

MLLM傾向於產生在影像序列推理中常見的行為組合,這加劇了行為幻覺的問題。例如,在處理機器人領域的圖像時,MLLM可能錯誤地描述一個機器人手臂在「抓取把手」之後拉開抽屜,即使實際行為是「抓取抽屜的側面」。

3. 行為幻覺的雪球效應

#隨著影像序列的進行,錯誤可能會逐漸累積或加劇,稱為雪球效應。在影像序列推理中,如果早期出現錯誤,這些錯誤可能會在序列中累積和放大,導致物件和行為識別的準確性下降。

舉例

#圖片

#圖片

從上圖可知,MLLM失敗原因包括對象幻覺以及對象幻覺與行為幻覺之間的相關性,以及共現行為。

#例如,在出現「網球場」的對象幻覺後,MLLM隨後展現出「拿著網球拍」的行為幻覺(對象幻覺與行為幻覺之間的相關性)以及「似乎在打網球」的共現行為。

圖片

圖片

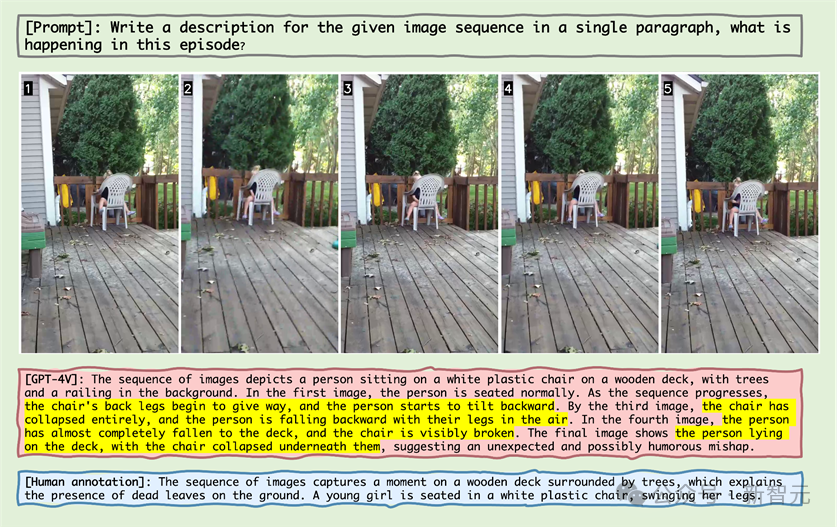

#觀察上圖中的樣本,可以發現MLLM錯誤地認為椅子再往後仰並且認為椅子碎掉了。

這現象揭示了MLLM對於影像序列中的靜止的對象,它也會產生這個物件發生了某些動作的幻覺。

圖片

圖片

#在上圖關於機械手臂的圖像序列展示中,機械手臂伸到了把手旁邊,MLLM就錯誤地認為機械手臂抓住了把手,證明了MLLM會產生在影像序列推理中常見的行為組合,從而產生幻覺。

圖片

圖片

#在上圖的案例中,老夫子並沒有牽著狗,MLLM錯誤地認為遛狗就要牽著狗,並且「狗的撐竿跳」被辨識成了「創造了噴泉」。

大量的錯誤反映了MLLM對於漫畫領域的不熟悉,在二次元動漫領域,MLLM可能需要大幅度的最佳化和預訓練.

在附錄中,作者透過詳細展示了各主要類別中的失敗案例,並進行了深入的分析。

總結

近年來,多模態大型語言模型在處理各種視覺-語言任務上展現出了卓越的能力。

這些模型,如GPT-4V和Gemini,能夠理解和產生與圖像相關的文本,極大地推動了人工智慧技術的發展。

然而,現有的MLLM基準測試主要集中在基於單張靜態圖像的推理,而對於從圖像序列中推斷,這對於理解我們不斷變化的世界至關重要,的能力研究相對較少。

為了解決這個挑戰,研究人員提出了一種新的基準測試「Mementos」,目的是評估MLLMs在序列影像推理方面的能力。

Mementos包含了4761個不同長度的多樣化影像序列。此外,研究團隊也採用了GPT-4輔助方法來評估MLLM的推理表現。

透過對九個最新的MLLMs(包括GPT-4V和Gemini)在Mementos上的仔細評估,研究發現這些模型在準確描述給定圖像序列的動態資訊方面存在挑戰,常常導致物體及其行為的幻覺/誤表達。

量化分析和案例研究識別出三個關鍵因素影響MLLMs的序列圖像推理:

1. 物件和行為幻覺之間的相關性;

2. 共現行為的影響;

3. 行為幻覺的累積影響。

這項發現對於理解和提升MLLMs在處理動態視覺訊息方面的能力具有重要意義。 Mementos基準不僅揭示了當前MLLMs的局限性,也為未來的研究和改進提供了方向。

隨著人工智慧技術的快速發展,MLLMs在多模態理解領域的應用將變得更加廣泛和深入。 Mementos基準測試的引入,不僅推動了這一領域的研究,也為我們提供了新的視角,去理解和改進這些先進的AI系統如何處理和理解我們複雜多變的世界。

參考資料:

https://github.com/umd-huanglab/Mementos

#以上是準確率不足20%,GPT-4V/Gemini竟看不懂漫畫!首個影像序列基準測試開源的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

2 個月不見,人形機器人 Walker S 會摺衣服了

Apr 03, 2024 am 08:01 AM

2 個月不見,人形機器人 Walker S 會摺衣服了

Apr 03, 2024 am 08:01 AM

機器之能報道編輯:吳昕國內版的人形機器人+大模型組隊,首次完成疊衣服這類複雜柔性材料的操作任務。隨著融合了OpenAI多模態大模型的Figure01揭開神秘面紗,國內同行的相關進展一直備受關注。就在昨天,國內"人形機器人第一股"優必選發布了人形機器人WalkerS深入融合百度文心大模型後的首個Demo,展示了一些有趣的新功能。現在,得到百度文心大模型能力加持的WalkerS是這個樣子的。和Figure01一樣,WalkerS沒有走動,而是站在桌子後面完成一系列任務。它可以聽從人類的命令,折疊衣物

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

語言模型是對文字進行推理的,文字通常是字串形式,但模型的輸入只能是數字,因此需要將文字轉換成數字形式。 Tokenization是自然語言處理的基本任務,根據特定需求能夠把一段連續的文字序列(如句子、段落等)切分為一個字元序列(如單字、片語、字元、標點等多個單元),其中的單元稱為token或詞語。根據下圖所示的具體流程,首先將文字句子切分成一個個單元,然後將單元素數值化(映射為向量),再將這些向量輸入到模型進行編碼,最後輸出到下游任務進一步得到最終的結果。文本切分依照文本切分的粒度可以將Toke

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

人形機器人Ameca升級第二代了!最近,在世界行動通訊大會MWC2024上,世界上最先進機器人Ameca又現身了。會場周圍,Ameca引來一大波觀眾。得到GPT-4加持後,Ameca能夠對各種問題做出即時反應。 「來一段舞蹈」。當被問及是否有情感時,Ameca用一系列的面部表情做出回應,看起來非常逼真。就在前幾天,Ameca背後的英國機器人公司EngineeredArts剛剛示範了團隊最新的開發成果。影片中,機器人Ameca具備了視覺能力,能看見並描述房間整個狀況、描述具體物體。最厲害的是,她還能

AI如何使機器人更具自主性和適應性?

Jun 03, 2024 pm 07:18 PM

AI如何使機器人更具自主性和適應性?

Jun 03, 2024 pm 07:18 PM

在工業自動化技術領域,最近有兩個熱點很難被忽視:人工智慧(AI)和英偉達(Nvidia)。不要改變原內容的意思,微調內容,重寫內容,不要續寫:「不僅如此,這兩者密切相關,因為英偉達在不僅僅局限於其最開始的圖形處理單元(GPU),正在將其GPU科技擴展到數位孿生領域,同時緊密連接著新興的AI技術。泰瑞達機器人及其MiR和優傲機器人公司。 Recently,Nvidiahascoll

首個自主完成人類任務機器人出現,五指靈活速度超人,大模型加持虛擬空間訓練

Mar 11, 2024 pm 12:10 PM

首個自主完成人類任務機器人出現,五指靈活速度超人,大模型加持虛擬空間訓練

Mar 11, 2024 pm 12:10 PM

這週,由OpenAI、微軟、貝佐斯和英偉達投資的機器人公司FigureAI宣布獲得接近7億美元的融資,計劃在未來一年內研發出可獨立行走的人形機器人。而特斯拉的擎天柱也屢屢傳出好消息。沒人懷疑,今年會是人形機器人爆發的一年。一家位於加拿大的機器人公司SanctuaryAI最近發布了一款全新的人形機器人Phoenix。官方號稱它能以和人類一樣的速率自主完成許多工作。世界上第一台能以人類速度自主完成任務的機器人Pheonix可以輕輕地抓取、移動並優雅地將每個物件放置在它的左右兩側。它能夠自主辨識物體的

雲端部署大模型的三個秘密

Apr 24, 2024 pm 03:00 PM

雲端部署大模型的三個秘密

Apr 24, 2024 pm 03:00 PM

編譯|星璇出品|51CTO技術堆疊(微訊號:blog51cto)在過去的兩年裡,我更參與了使用大型語言模型(LLMs)的生成AI項目,而非傳統的系統。我開始懷念無伺服器雲端運算。它們的應用範圍廣泛,從增強對話AI到為各行各業提供複雜的分析解決方案,以及其他許多功能。許多企業將這些模型部署在雲端平台上,因為公有雲供應商已經提供了現成的生態系統,而且這是阻力最小的路徑。然而,這並不便宜。雲端還提供了其他好處,如可擴展性、效率和高階運算能力(按需提供GPU)。在公有雲平台上部署LLM的過程有一些鮮為人知的

人形機器人會變魔術了,春晚節目組了解一下

Feb 04, 2024 am 09:03 AM

人形機器人會變魔術了,春晚節目組了解一下

Feb 04, 2024 am 09:03 AM

一眨眼的功夫,機器人都已經學會變魔術了?只見它先是拿起桌上的水勺,向觀眾證明了裡面什麼也沒有……然後,它又把手中雞蛋似的物體放了進去,然後把水勺放回桌子上,開始「施法」… …就在它把水勺再次拿起的時候,奇蹟發生了。原先放進去的雞蛋不翼而飛,跳出的東西變成了一個籃球……再來看一遍連貫動作:△此動圖為二倍速一套動作下來如行雲流水,只有把視頻用0.5倍速反复觀看,才終於發現其中的端倪了:如果手速再快一些,大概真的就可以瞞天過海了。有網友感嘆,機器人變魔術的程度比自己還要高:為我們表演這段魔術的,是Mag

雲鯨逍遙001掃拖機器人,長「腦子」了! | 體驗

Apr 26, 2024 pm 04:22 PM

雲鯨逍遙001掃拖機器人,長「腦子」了! | 體驗

Apr 26, 2024 pm 04:22 PM

近幾年最受消費者歡迎的智慧家電,掃拖機器人可謂是其中之一。它所帶來的操作便利性,甚至是無需操作,讓懶人們釋放了雙手,讓消費者能夠從日常的家務中「解放」出來,也能拿更多的時間花在自己喜歡的事情上,變相提高了生活品質。藉著這股熱潮,市面上幾乎所有的家電產品品牌都在做自己的掃拖機器人,一時間使得整個掃拖機器人市場熱鬧非凡。但市場的快速拓張必然會帶來一個隱患:很多廠商會採用機海戰術的方式快速佔領更多的市場份額,從而導致很多新品並沒有什麼升級點,說它是“套娃”機型也不為過。不過,並不是所有的掃拖機器人都是