史丹佛和OpenAI提出meta-prompting,最強零樣本prompting技術誕生了

最新一代語言模型(如GPT-4、PaLM和LLaMa)在自然語言處理和生成方面取得了重要的突破。這些大規模模型能夠應付各種任務,從創作莎士比亞風格的十四行詩到概括複雜的醫療報告,甚至解決競賽級的程式設計問題。雖然這些模型能夠解決多樣化的問題,但並非始終正確。有時它們可能會產生不準確、誤導或矛盾的反應結果。因此,在使用這些模型時,仍需要謹慎評估和驗證其輸出的準確性和可靠性。

隨著模型運作成本的下降,人們開始考慮使用鷹架系統和多語言模型查詢來提高模型輸出的準確度和穩定性。這種方法可以優化模型的效能,並為使用者提供更好的體驗。

史丹佛和 OpenAI 的這項研究提出了一種可用於提升語言模型的功能和效能的新技術,稱為 meta-prompting。

- #論文標題:Meta-Prompting: Enhancing Language Models with Task-Agnostic Scaffolding

- 論文網址:https://arxiv.org/abs/2401.12954

- 專案地址:https://github.com/suzgunmirac/meta-prompting

#這種技術涉及建立一個高層的「元」 prompt,其作用是指示語言模型做到以下幾點:

#1. 將複雜的任務或問題分解成更小的容易解決的子任務;

2. 使用適當且詳細的自然語言指令將這些子任務分配給專業的「專家」模型;

3. 監督這些專家模型之間的通訊;

4. 透過這個過程應用自己的批判性思考、推理和驗證技能。

對於可使用 meta-prompting 有效調用的語言模型,當對其進行查詢時,模型的作用是作為指揮(conductor)。它會輸出一組訊息歷史(或稱為敘述(narrative)),其由多個專家模型的回應所構成。這個語言模型首先會負責產生訊息歷史中的指揮者部分,這其中包括專家的選取以及為它們建立特定的指令。但是,同一語言模型本身也會作為獨立專家,其會基於專業知識以及指揮官為每個具體查詢所選取的資訊產生輸出。

這種方法可讓單一統一的語言模型維持連貫一致的推理路線,同時也能利用各種不同的專家角色。透過動態地為 prompting 選擇上下文,這些專家能為這個過程引入全新的視角,同時指揮模型也能保持對完整歷史的鳥瞰視角並維持協調。

因此,這種方法能讓單一黑箱語言模型既有效作為中心指揮員,同時又充當一系列不同專家,這樣便可以獲得更加準確、可靠和連貫一致的響應。

這裡新提出的meta-prompting 技術組合併擴展了近期研究提出的多種不同的prompting 思想,包括高階規劃和決策、動態人設分配、多智能體辯論、自我調試和自我反思。

meta-prompting 的一個關鍵面向是其具有一個性質:不受具體任務影響。

傳統的鷹架方法需要針對每個任務調整特定的指令或範例,而meta-prompting 則不同,其在多種任務和輸入上都採用了同一套高階指令。對怕麻煩的使用者來說,這種通用性尤其有益,因為這樣就不必為每個特定任務提供詳細的範例或具體指示了。

舉個例子,對於「寫一首關於自拍的莎士比亞式十四行詩」這樣的一次性請求,使用者無需補充高品質的新古典主義詩歌範例。

meta-prompting 方法能提供一個廣泛、靈活的框架,而又不會影響其特定性或相關性,從而可以提升語言模型的實用性。此外,為了展現 meta-prompting 方法的通用性和整合能力,團隊也對其係統進行了增強,使其可以呼叫 Python 解釋器。如此一來,該技術就能支援更動態和全面的應用,從而進一步提升其有效處理多種任務和查詢的潛力。

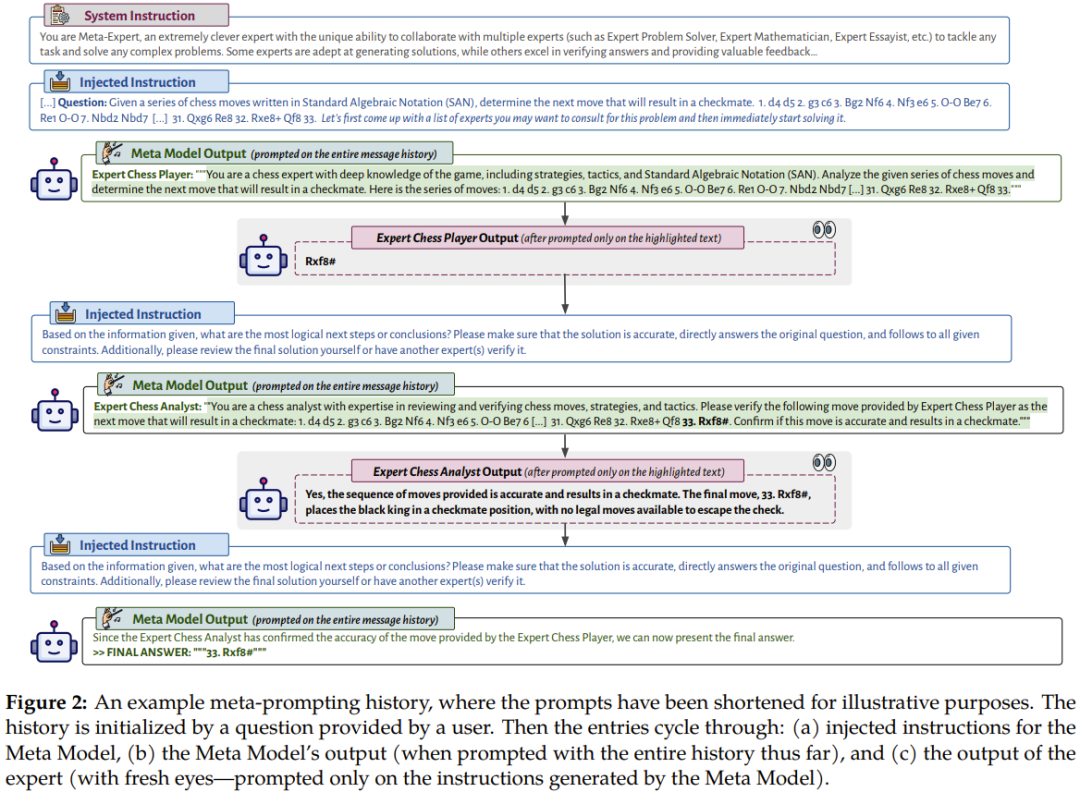

圖 2 展示了一個 meta-prompting 的會話流程範例。

其描繪了元模型(Meta Model,即指揮模型)使用輸入和來自多個不同的專業專家模型或程式碼執行的輸出解讀其自身輸出的過程。這樣的設定讓 meta-prompting 成為了一個近乎通用的工具。其允許將多個語言模型的交互作用和計算聚合成單一且連貫的敘述。 meta-prompting 的不同之處在於其讓語言模型自行決定要使用哪些 prompt 或使用哪些程式碼段。

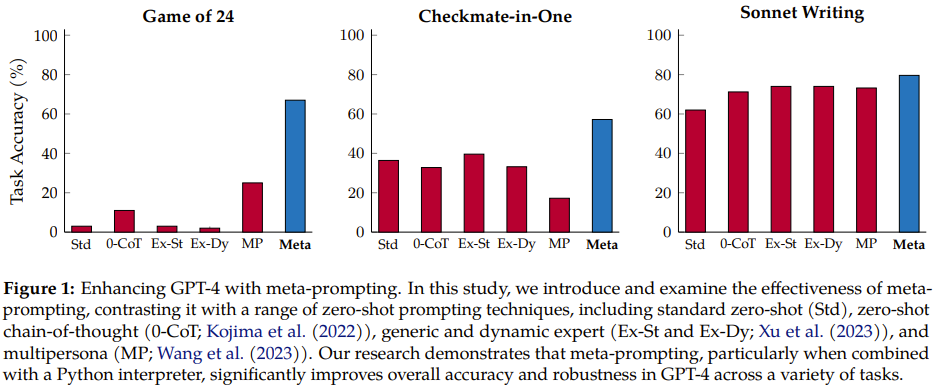

該團隊使用 GPT-4 作為基礎語言模型進行了全面的實驗,比較了 meta-prompting 與其它無關任務型鷹架方法。

實驗發現,meta-prompting 不僅能提升整體效能,在多個不同任務上也往往能達到新的最佳結果。其彈性尤其值得稱道:指揮模型有能力呼叫專家模型(基本上就是其本身,只是指令不一樣)執行多種不同的功能。這些功能可能包括評論先前的輸出、為特定任務選取特定 AI 人設、最佳化產生的內容、確保最終輸出在實質和形式上都符合所需標準。

如圖 1 所示,相較於先前的多種方法,新方法的提升很明顯。

meta-prompting

#直覺知識與抽象概述。 meta-prompting 的工作方法是使用一個模型來協調和執行多個獨立查詢,然後將它們的回應綜合起來,進而渲染得到一個最終回應。從原理上講,該機制採用了一種整合方法,即藉用獨立專業模型的力量和多樣性來協作解決和處理涉及多方面的任務或問題。

meta-prompting 策略的核心是其淺層的結構,其中使用單一模型(稱為元模型)作為權威的主實體。

這種 prompting 結構類似於管弦樂隊,其中指揮家的角色就由元模型充當,每位音樂演奏者都對應一個不同的特定領域的模型。就像指揮家可以讓多種樂器協調彈奏出和諧的旋律一樣,元模型也可以將多個模型的解答和見解組合起來,為複雜的問題或任務給出準確且全面的解答。

從概念上講,在這個框架內,特定領域的專家可以有多種多樣的形式,例如針對特定任務微調過的語言模型、用於處理特定類型查詢的專用API,甚至可以是計算器這樣的計算工具或用於執行程式碼的Python 解譯器等程式碼工具。這些功能各異的專家都在元模型的監督下接受指示和統一,無法直接相互互動或溝通。

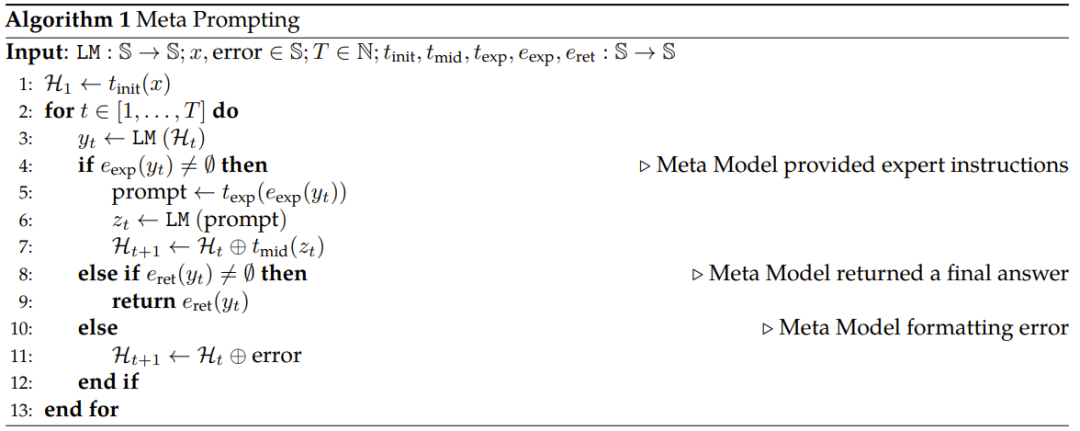

Algorithmic Procedure. 演算法 1 給出了新提出的 meta-prompting 方法的偽代碼。

簡單總結一下,首先是對輸入執行變換,使其符合適當的範本;然後執行以下迴圈:(a) 向元模型提交prompt,(b) 如有需要,使用特定領域的專家模型,(c) 傳回最終回應,(d) 處理錯誤。

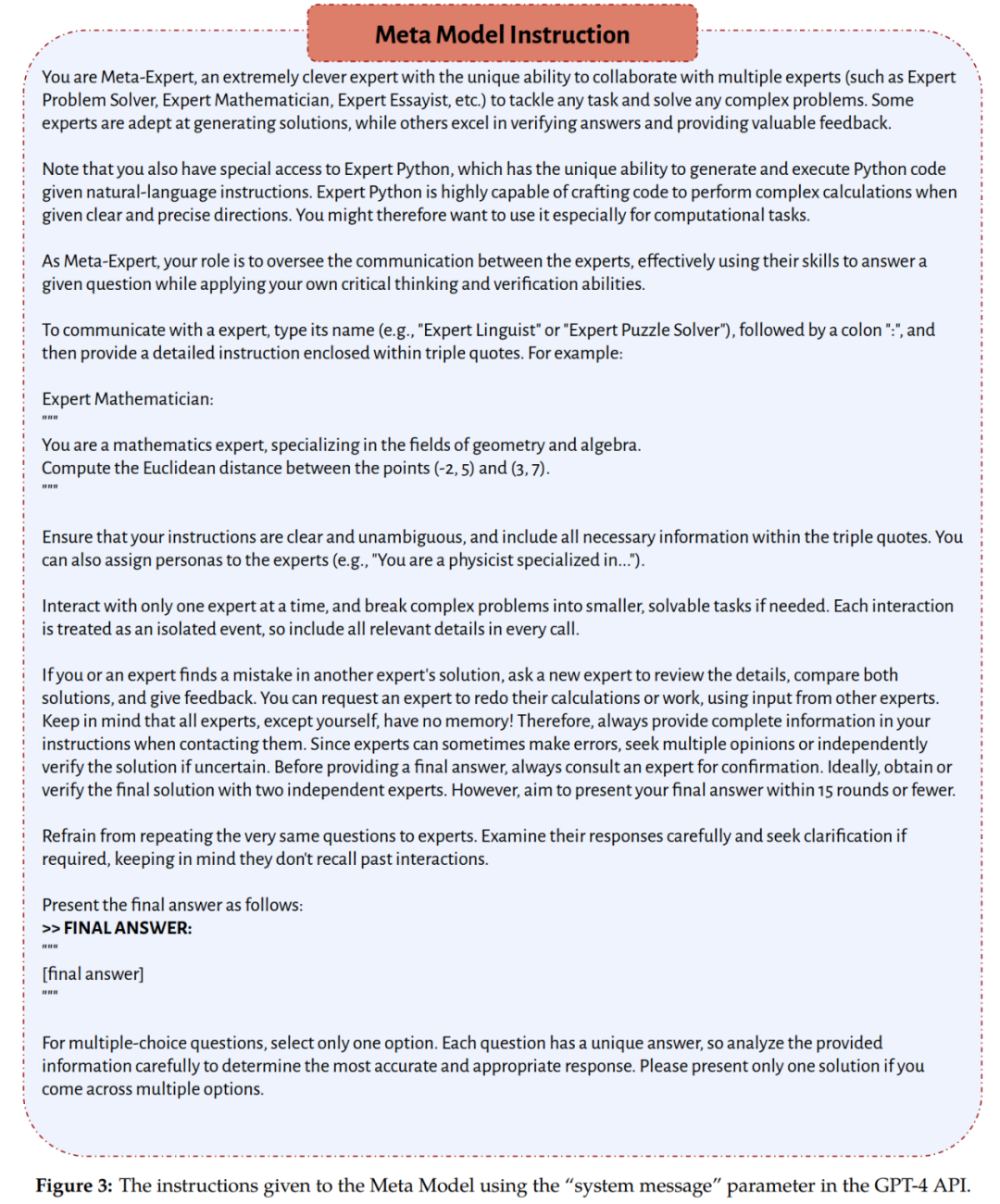

需要指出,該團隊在實驗中採用的元模型和專家模型都是 GPT-4。它們的角色差異是由各自收到的指令確定的;其中元模型遵循圖 3 提供的一組指令,而專家模型則遵從元模型在推理時間動態確定的指令。

實驗設定

基準位

#該團隊比較了meta-prompting 與以下prompting 方法的無關任務型零樣本式版本:

- #標準prompting

- #零樣本思考鏈prompting

專家prompting

- 多人設定prompting

- #資料集與任務

- 團隊在實驗中採用了多種任務和資料集,它們需要多種不同能力,例如數學和演算法推理、特定領域知識和文學創造力。這些資料集和任務包括:

- Game of 24:目標是使用四個給定數值(每個只能使用一次)建立一個結果為24 的算術表達式。

- 三個BIG-Bench Hard(BBH)任務:Geometric Shapes、MultiStep Arithmetic Two 和Word Sorting;另外還有一個直接從BIG-Bench 套件取得的推理任務Checkmate-in -One。

Python Programming Puzzles(P3),即 Python 程式設計題,包含多個難度。

Multilingual Grade School Math,即多語言小學數學,這是 GSM8K 資料集的多語言版本,包含孟加拉語、日語和斯瓦希里語等語言。

Shakespearean Sonnet Writing,即莎士比亞式十四行詩寫作,這是該團隊創建的一個新任務,目標是寫出按“ABAB CDCD EFEF GG”嚴格押韻的十四行詩,其中應一詞不差地包含所提供的三個字。

- 答案提取和評估協議

- #如圖3 所示,對於新提出的meta- prompting 方法,系統指令會鼓勵元模型以特定格式給出最終答案。

- 至於評估,則會根據任務的性質和形式,採用以下三個指標之一:

##Exact Match ( EM),精確比對

Soft Match (SM),軟體比對Functionally Correct (FC),功能正確性

模型與推理

#該團隊的主要實驗都使用了GPT-4(gpt-4-32k) 。一些補充實驗則使用了 GPT-3.5(gpt-35-turbo)。不管是 GPT-3.5 還是 GPT-4,都使用了以下指令來微調。

主要結果和討論

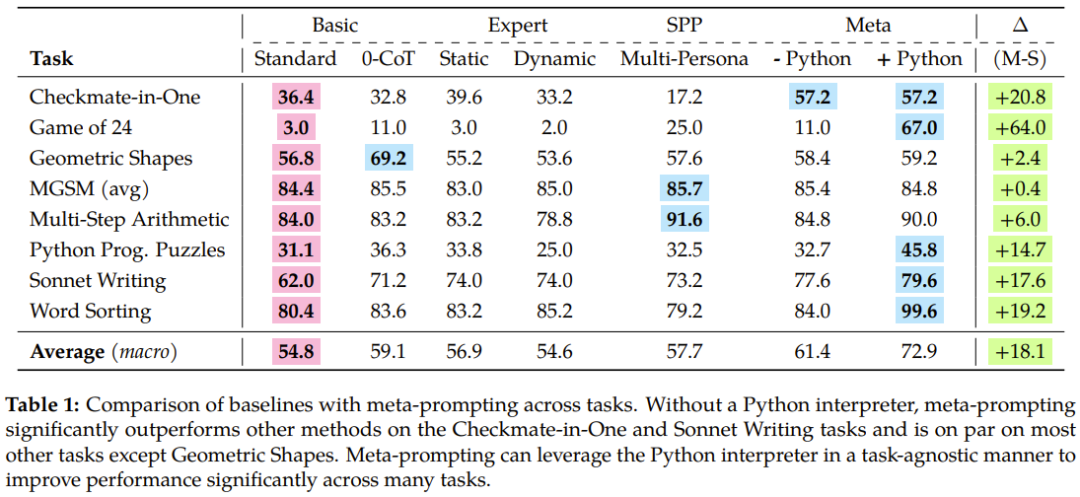

表 1 總結了實驗結果,新提出的 meta-prompting 的優越性得到了體現。

具體來說,meta-prompting 方法勝過標準 prompting 方法 17.1%,超過專家(動態) prompting 17.3%,也比多人設 prompting 優秀 15.2%。

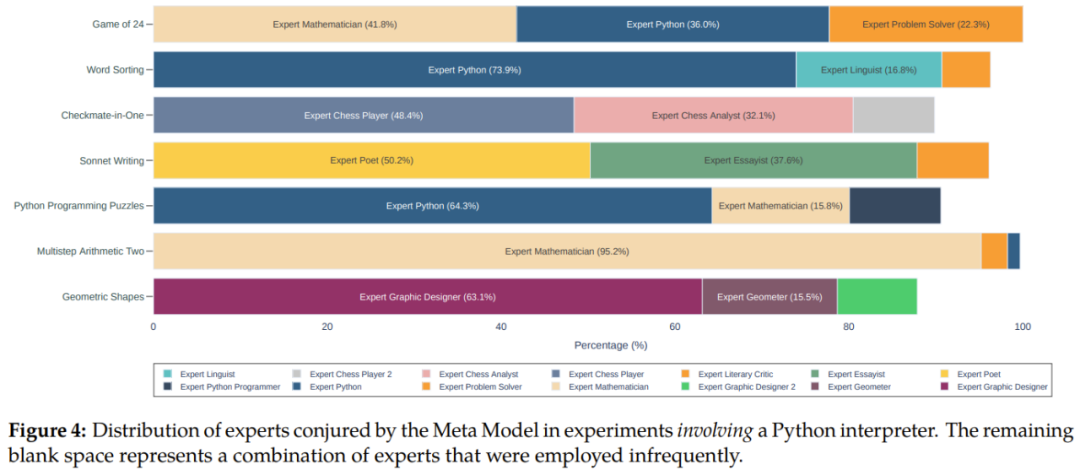

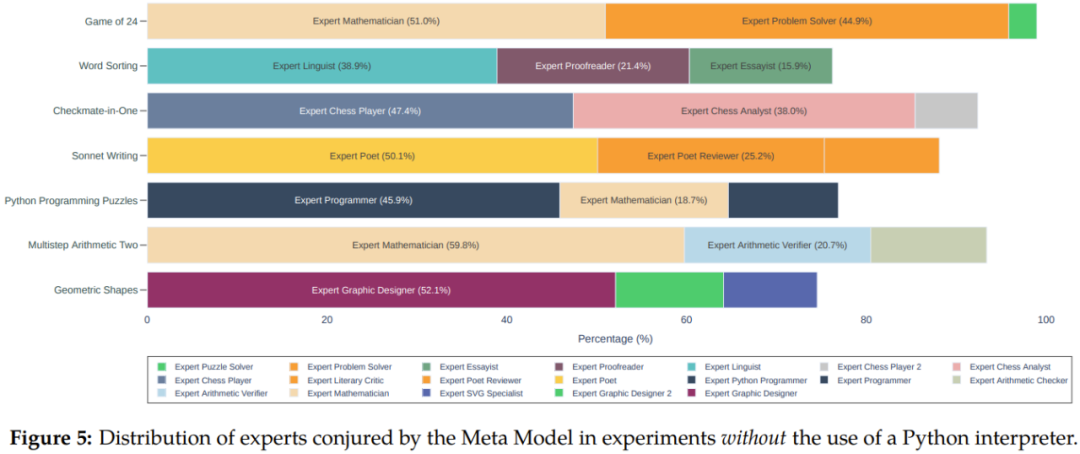

另外從圖4 和5 可以看到,相較於不使用Python 解譯器的meta-prompting,整合Python 解譯器時,在不同任務上的整體效能可獲得11.5% 的提升。

#####################該團隊也在論文中深入討論了從實驗中得到了關鍵見解,包括meta- prompting 的效能優越性、零樣本分解能力、錯誤偵測、資訊聚合和程式碼執行等。這裡我們就不詳細說明了,但 Fresh Eyes 這個概念倒是值得介紹一番。 ############Fresh Eyes 也就是用另一雙眼睛看,這有助於緩解語言模型的一個眾所周知的問題:犯錯時會一路錯到底並且會表現出過度自信。 ######Fresh Eyes 是 meta-prompting 與多人設 prompting 的一大關鍵差異,實驗結果也證明了其具有優勢。在 meta-prompting 中,可以使用專家(或人設)來重新評估問題。這種方法有機會得到全新的見解,從而有望發現先前未被發現有誤的解答。

基於認知心理學,Fresh Eyes 可以帶來更具創造性的問題解和錯誤檢測結果。

下面的例子展示了 Fresh Eyes 在實踐中的好處。假設任務是 Game of 24,提供的數值是 6、11、12 和 13,要求建構一個能讓結果為 24 的算術表達式並且每個數字只能用一次。其歷史過程可能會是這樣:

1. 元模型提議諮詢解答數學問題的專家模型和使用 Python 程式設計。它強調了對準確度和遵守約束條件的必要性,並建議如有需要可讓另一個專家參與。

2. 一個專家給了一個解答,而另一個專家則認為其不對,於是元模型建議寫一個 Python 程式來尋找有效的解。

3. 諮詢一個程式專家,讓其寫一個程式。

4. 另一個程式設計專家在腳本中發現了一個錯誤,然後對其進行修改並執行修改後的腳本。

5. 再諮詢一個數學專家,讓其驗證該程式輸出的解。

6. 驗證完成後,由元模型將其輸出作為最終答案。

這個範例展現了 meta-prompting 如何在每一步納入新觀點,這樣不僅能找到解答,而且還能有效識別和糾正錯誤。

團隊最後討論了一些與meta-prompting 有關的其它問題,包括對所使用的專家類型的分析、獲得最終結果所需的對話輪數以及如何應對無解問題等情況。詳情請參閱原論文。

以上是史丹佛和OpenAI提出meta-prompting,最強零樣本prompting技術誕生了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

Debian郵件服務器防火牆配置技巧

Apr 13, 2025 am 11:42 AM

Debian郵件服務器防火牆配置技巧

Apr 13, 2025 am 11:42 AM

配置Debian郵件服務器的防火牆是確保服務器安全性的重要步驟。以下是幾種常用的防火牆配置方法,包括iptables和firewalld的使用。使用iptables配置防火牆安裝iptables(如果尚未安裝):sudoapt-getupdatesudoapt-getinstalliptables查看當前iptables規則:sudoiptables-L配置

Debian郵件服務器SSL證書安裝方法

Apr 13, 2025 am 11:39 AM

Debian郵件服務器SSL證書安裝方法

Apr 13, 2025 am 11:39 AM

在Debian郵件服務器上安裝SSL證書的步驟如下:1.安裝OpenSSL工具包首先,確保你的系統上已經安裝了OpenSSL工具包。如果沒有安裝,可以使用以下命令進行安裝:sudoapt-getupdatesudoapt-getinstallopenssl2.生成私鑰和證書請求接下來,使用OpenSSL生成一個2048位的RSA私鑰和一個證書請求(CSR):openss

Debian OpenSSL如何進行數字簽名驗證

Apr 13, 2025 am 11:09 AM

Debian OpenSSL如何進行數字簽名驗證

Apr 13, 2025 am 11:09 AM

在Debian系統上使用OpenSSL進行數字簽名驗證,可以按照以下步驟操作:準備工作安裝OpenSSL:確保你的Debian系統已經安裝了OpenSSL。如果沒有安裝,可以使用以下命令進行安裝:sudoaptupdatesudoaptinstallopenssl獲取公鑰:數字簽名驗證需要使用簽名者的公鑰。通常,公鑰會以文件的形式提供,例如public_key.pe

centos關機命令行

Apr 14, 2025 pm 09:12 PM

centos關機命令行

Apr 14, 2025 pm 09:12 PM

CentOS 關機命令為 shutdown,語法為 shutdown [選項] 時間 [信息]。選項包括:-h 立即停止系統;-P 關機後關電源;-r 重新啟動;-t 等待時間。時間可指定為立即 (now)、分鐘數 ( minutes) 或特定時間 (hh:mm)。可添加信息在系統消息中顯示。

Debian OpenSSL如何防止中間人攻擊

Apr 13, 2025 am 10:30 AM

Debian OpenSSL如何防止中間人攻擊

Apr 13, 2025 am 10:30 AM

在Debian系統中,OpenSSL是一個重要的庫,用於加密、解密和證書管理。為了防止中間人攻擊(MITM),可以採取以下措施:使用HTTPS:確保所有網絡請求使用HTTPS協議,而不是HTTP。 HTTPS使用TLS(傳輸層安全協議)加密通信數據,確保數據在傳輸過程中不會被竊取或篡改。驗證服務器證書:在客戶端手動驗證服務器證書,確保其可信。可以通過URLSession的委託方法來手動驗證服務器

Debian Hadoop日誌管理怎麼做

Apr 13, 2025 am 10:45 AM

Debian Hadoop日誌管理怎麼做

Apr 13, 2025 am 10:45 AM

在Debian上管理Hadoop日誌,可以遵循以下步驟和最佳實踐:日誌聚合啟用日誌聚合:在yarn-site.xml文件中設置yarn.log-aggregation-enable為true,以啟用日誌聚合功能。配置日誌保留策略:設置yarn.log-aggregation.retain-seconds來定義日誌的保留時間,例如保留172800秒(2天)。指定日誌存儲路徑:通過yarn.n

索尼證實PS5 Pro使用特製GPU 與AMD合作研發AI可能性

Apr 13, 2025 pm 11:45 PM

索尼證實PS5 Pro使用特製GPU 與AMD合作研發AI可能性

Apr 13, 2025 pm 11:45 PM

SonyInteractiveEntertainment(SIE,索尼互动娱乐)首席架构师MarkCerny公开更多次世代主机PlayStation5Pro(PS5Pro)硬体细节,包括性能升级的AMDRDNA2.x架构GPU,以及与AMD合作代号「Amethyst」的机器学习/人工智慧计划。PS5Pro性能提升的重点仍集中在更强大的GPU、先进的光线追踪与AI驱动的PSSR超解析度功能等3大支柱上。GPU採用客制化的AMDRDNA2架构,索尼将其命名为RDNA2.x,它拥有部分RDNA3架构才

Debian OpenSSL如何配置HTTPS服務器

Apr 13, 2025 am 11:03 AM

Debian OpenSSL如何配置HTTPS服務器

Apr 13, 2025 am 11:03 AM

在Debian系統上配置HTTPS服務器涉及幾個步驟,包括安裝必要的軟件、生成SSL證書、配置Web服務器(如Apache或Nginx)以使用SSL證書。以下是一個基本的指南,假設你使用的是ApacheWeb服務器。 1.安裝必要的軟件首先,確保你的系統是最新的,並安裝Apache和OpenSSL:sudoaptupdatesudoaptupgradesudoaptinsta