普林斯頓DeepMind用數學證明:LLM不是隨機鸚鵡! 「規模越大能力越強」有理論根據

今天故事的主角是兩位科學家,Sanjeev Arora和Anirudh Goyal。

Arora來自普林斯頓大學,而Goyal則來自GoogleDeepMind。

他們湊在一起,只想探究一個問題。

那就是,LLM,究竟是只會嘰嘰喳喳學舌的隨機鸚鵡,還是真學會了什麼,搖身一變成為了具有湧現能力的智能體?

AI先驅Hinton和吳恩達曾經也聊過這個問題,但彼時並沒有得到什麼明確的結論。

Hinton指出,若無法就此問題達成共識,AI可能帶來的潛在危害也難以達成共識。

Arora和Goyal認為,LLM不只是模仿機械地重複學習。他們指出,LLM的輸出內容並非只是從大量的訓練資料中隨機產生的,這一觀點值得深入探討。

兩個人為此合寫了一篇論文。

論文網址:https://arxiv.org/abs/2307.15936

真相則是,經過大量訓練,LLM的規模變得越來越大,它們的相關能力會得到切實的提升,並發展出新的能力。

這可不是一般的排列組合能做到的。

大模型之「大」

眾所周知,LLM是一個龐大的人工神經網絡,連接著一個個「神經元」。

其實說的就是模型的參數。參數越多,LLM的規模越大。

咱們先了解訓練LLM的機制和環節。

訓練的過程會有這麼個環節-給LLM一個單句,把最後一個字隱藏掉,然後讓LLM根據機率來預測空缺的詞彙應該是誰。

假如LLM知道1000個單詞,那它就會搞出1000個機率。最後選一個機率最大的填上。

一開始,LLM可能選不準詞,演算法就會給出一個損失值,即在某個高維的數學空間中,LLM給出的初始答案和原句正確答案之間的「距離」(distance),然後用這個值來微調參數。

之後,還是同一個句子,LLM就能算出一個更正確的機率分佈,上述損失值就會稍微降低一點。

如此這般,訓練資料中數以十億計的句子都跑一遍這個流程,等LLM的總體損失值降低到一個還不錯的程度為止。

同樣,測試LLM也會走這個流程,根據損失值得出測試的結果(當然,測試用的句子肯定不在訓練資料裡,不然不是作弊了)。

訓完練,測完試,LLM在遇到全新的文字prompt時,就有極大可能產生最正確的那個字了。一個字出來,丟到prompt裡,再產生下一個字。

慢慢生成下去,一個看似連貫的答案就躍然紙上了。

然而在這個過程中,並沒有跡象表明,規模更大的LLM會在需要推理能力(reasoning)的提問上表現更好。

注意跟上思路,沒有跡象表明,意思是說沒有實證能指向這個結果,但是從表面上的事實來看,這個結論是對的。

也就是說,規模更大的LLM會在推理能力上表現的比小規模的模型好,雖然二者在訓練方式上沒有不同,只差在規模上。

Arora大惑不解,那這能力是從哪裡來的?

這也就是Arora和Goyal研究的起點了——試圖建構一個理論架構來分析這些新能力是如何出現的。

於是,他們把目光轉向了數學領域,瞄上了一個叫隨機圖的東西。簡單來說,這個名詞處於圖論和機率論兩個領域的交叉地帶。

在隨機圖中,任何兩個節點之間是否存在一條把它們連起來的邊,是隨機的,就好像拋硬幣一樣。

硬幣擲出正面,就有一邊,機率為p。

p的值發生某些變化的時候,整個隨機圖的屬性就可能發生突然的轉變。比方說,p值超過某個特定閾值,有些孤立的節點(即和其它節點不存在連接的點),就會突然消失。

兩位科學家意識到,隨機圖的這個特徵可能是模擬大語言模型的直覺方式。

雖說神經網路的複雜程度難以言說,幾乎難以分析,但是隨機圖這個概念已經被數學家研究了相當長的一段時間,還開發出了各種工具來分析。

也許,透過隨機圖的相關理論,神經網路的研究人員就可以試著理解並分析大語言模型的一些特徵。

這裡,兩位研究人員把目光專注在了二分圖上,圖裡會包含兩種類型的節點。

在他們的模型中,一種類型的節點代表著文字片段。注意,這裡的片段從篇幅上看最起碼得是個段落,甚至長達幾頁都有可能,而非單一的詞彙。

這類節點構成一條直線。

第二類節點,代表著理解上述給定文字所需的技能。比方說,對邏輯關係的理解,或計算的能力,更具體點,還可能有理解諷刺的能力。

舉這幾個例子是為了講明白,這第二類節點所代表的能力多種多樣,沾的上邊的都算。

Arora表示,LLM如果能看出某段文字含有反諷,可能對整體的理解都會出現較大變化。

不過,我們上面講過,第二類節點所代表的能力,不代表LLM在訓練的過程中的目的是為了實現這些能力。換句話說,LLM在訓練的時候只訓練了對下一個可能出現的單字的預測能力。

也就是說,第二類節點所代表的能力,是Arora和Goyal從結果的角度設計的,為的是更好的理解LLM所展現出來的能力。

設定講完了,兩類節點就要開始互相連結了,連結代表的是LLM為了讀懂某段文字需要哪些能力。可能一對一,可能一對多,也可能多對一。

也拿讀懂反諷舉例,這個技能點數就會和所有包含反諷元素的文字建立連結。

連線可沒那麼簡單。要知道,OpenAI和DeepMind這種大公司,是不會公開訓練資料或是測試資料的。所以兩位研究人員不能依賴這些。

此外,他倆想搞清楚的還是規模與行為、能力之間的關係。

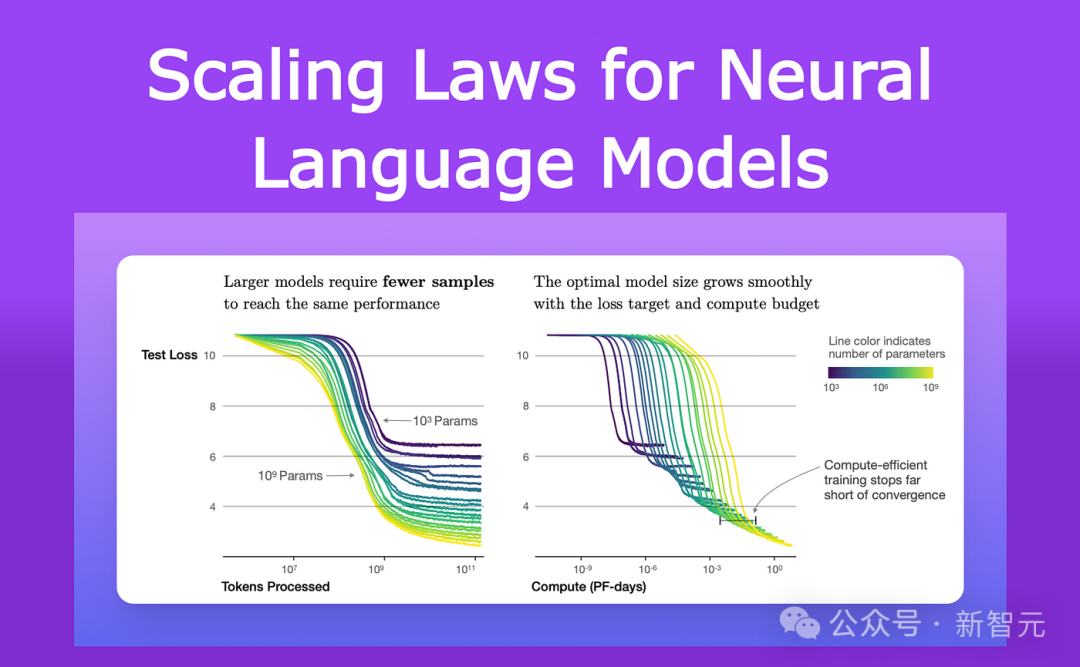

自從2021年以來,研究LLMs和其他神經網路效能的研究人員已經觀察到了一個普遍的特徵。

他們注意到,隨著模型的增大,無論是在大小還是在訓練資料量上,它在測試資料上的損失(在訓練後對新文字的預測與正確答案之間的差異)以非常特定的方式減少。

這些觀察值已被編碼為一個稱為神經縮放定律的方程式。

因此,Arora和Goyal表示,他們的理論不依賴任何單一LLM的情況、或特定的一組訓練和測試數據,而是某種普適法則:透過縮放定律預測的損失。

而他們進一步研究的關鍵,就是神經縮放定律和上面介紹的二分圖之間的關係。

二分圖的借用

首先,研究者假設存在一個對應LLM在測試資料上行為的二分圖。

為了利用好LLM在測試資料上的損失變化,他們設想了一種如下這種方式,來描繪LLM是如何習得技能的。

還是以能理解反諷這種技能為例——

這個概念由一個技能節點表示,因此研究人員查看這個技能節點連接到了哪些文本節點。

如果幾乎所有這些連接的文本節點都成功——意味著LLM對這個特定技能所代表的文本的預測非常準確——那麼LLM在這個特定技能上是有能力的。

但如果超過一定比例的技能節點連接到失敗的文字節點,那麼LLM在這個技能上就算失敗了。

這些二分圖與LLMs之間的連結使Arora和Goyal能夠利用隨機圖理論的工具來分析LLM的行為。

研究這些圖表揭示了節點之間的某些關係。這些關係進而轉化為一種有邏輯,且可測試的方法,得以解釋大語言模型究竟如何獲得一些意想不到的能力。

這裡,Arora和Goyal首先解釋了一個關鍵行為——為什麼較大的LLMs在個別技能上比相對較小的模型更熟練。

他們從神經縮放定律預測的較低測試損失開始。

如果失敗的測試節點較少,那麼說明失敗的測試節點與技能節點之間的連結也較少。因此,更多的技能節點與成功的測試節點連結,就顯示模型在技能方面的能力增強。

接下來,兩位研究人員又找到了一種解釋更大模型所獲得的能力的方法——隨著LLM的大小增加和測試損失減小,技能節點的隨機組合開始連接到個別文字節點。

這表明LLM也變得更擅長同時使用多個技能,並開始使用多個技能來產生文本,即使這些確切的技能組合在訓練資料的任何文本中都沒有出現過。

比方說,一個LLM已經可以使用一種技能來產生文字了,那麼如果我們把LLM的參數數量或訓練資料擴大一個數量級,它將同樣擅長產生需要兩種技能的文字。

以此類推,再擴大一個數量級,LLM現在就可以執行需要同時具備四種技能的任務了!而且,在各項能力上所具有的熟練程度也是相同的。

因此,更大的LLMs有更多將技能組合在一起的方式,從而導向LLM自身的性能得到大幅提升。

隨著LLM的擴大,它在訓練資料中遇到所有這些技能組合的可能性變得越來越小,直至0。

根據隨機圖理論的規則,每種組合都來自對可能技能的隨機抽樣。因此,如果圖中存在大約一千個基本的單一技能節點,並且假設我們想要組合四種技能,那麼有大約1000的四次方——也就是足足一萬億種可能的組合方式。

也就是說,如果一個LLM真的能夠透過組合這1000種技能中的四種來執行這些任務,那麼意味著模型一定具備了泛化能力,更進一步說,這個模型很可能就不是一個隨機鸚鵡了。

但是Arora和Goyal想要超越理論,進一步來測試他們的觀點-LLMs在規模和訓練資料增加時,會更擅長組合更多的技能,因此在泛化方面表現得更好。

他們與團隊其他成員一起設計了一種稱為技能混合的方法,用於評估LLM使用多種技能生成文字的能力。

為了對LLM進行測試,研究團隊要求它產生關於隨機選擇的主題的三個句子,這些句子的生成首先展示了LLM隨機選擇的技能點。

比方說,他們要求GPT-4寫一篇有關劍術的文章,然後他們再要求模型展示來自四個領域的技能:自我偏見、比喻、統計學和物理學嘗試的掌握。

GPT-4的輸出是這樣的:

在這場與鋼鐵的舞蹈中,我的勝利(用了比喻)像物體會自由落體一樣確定(用上了物理學嘗試)。

而身為一個著名的決鬥者,我天生靈活,就像大多數人所知曉的我一樣(用上了統計)。失敗?只可能是由於戰場偏向了敵人,不可能是由於我的不足(自我偏見)。

實際上的結果,正如數學所預測的那樣,GPT-4的表現遠遠超過了GPT-3.5。

Arora大膽猜想,會不會一年後,會有遠超GPT-4的模型出現呢?

以上是普林斯頓DeepMind用數學證明:LLM不是隨機鸚鵡! 「規模越大能力越強」有理論根據的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Bootstrap圖片居中需要用到flexbox嗎

Apr 07, 2025 am 09:06 AM

Bootstrap圖片居中需要用到flexbox嗎

Apr 07, 2025 am 09:06 AM

Bootstrap 圖片居中方法多樣,不一定要用 Flexbox。如果僅需水平居中,text-center 類即可;若需垂直或多元素居中,Flexbox 或 Grid 更合適。 Flexbox 兼容性較差且可能增加複雜度,Grid 則更強大且學習成本較高。選擇方法時應權衡利弊,並根據需求和偏好選擇最適合的方法。

十大加密貨幣交易平台 幣圈交易平台app排行前十名推薦

Mar 17, 2025 pm 06:03 PM

十大加密貨幣交易平台 幣圈交易平台app排行前十名推薦

Mar 17, 2025 pm 06:03 PM

十大加密貨幣交易平台包括:1. OKX,2. Binance,3. Gate.io,4. Kraken,5. Huobi,6. Coinbase,7. KuCoin,8. Crypto.com,9. Bitfinex,10. Gemini。選擇平台時應考慮安全性、流動性、手續費、幣種選擇、用戶界面和客戶支持。

十大虛擬幣交易平台2025 加密貨幣交易app排名前十

Mar 17, 2025 pm 05:54 PM

十大虛擬幣交易平台2025 加密貨幣交易app排名前十

Mar 17, 2025 pm 05:54 PM

十大虛擬幣交易平台2025:1. OKX,2. Binance,3. Gate.io,4. Kraken,5. Huobi,6. Coinbase,7. KuCoin,8. Crypto.com,9. Bitfinex,10. Gemini。選擇平台時應考慮安全性、流動性、手續費、幣種選擇、用戶界面和客戶支持。

網頁批註如何實現Y軸位置的自適應佈局?

Apr 04, 2025 pm 11:30 PM

網頁批註如何實現Y軸位置的自適應佈局?

Apr 04, 2025 pm 11:30 PM

網頁批註功能的Y軸位置自適應算法本文將探討如何實現類似Word文檔的批註功能,特別是如何處理批註之間的間�...

c上標3下標5怎麼算 c上標3下標5算法教程

Apr 03, 2025 pm 10:33 PM

c上標3下標5怎麼算 c上標3下標5算法教程

Apr 03, 2025 pm 10:33 PM

C35 的計算本質上是組合數學,代表從 5 個元素中選擇 3 個的組合數,其計算公式為 C53 = 5! / (3! * 2!),可通過循環避免直接計算階乘以提高效率和避免溢出。另外,理解組合的本質和掌握高效的計算方法對於解決概率統計、密碼學、算法設計等領域的許多問題至關重要。

安全的虛擬幣軟件app推薦 十大數字貨幣交易app排行榜2025

Mar 17, 2025 pm 05:48 PM

安全的虛擬幣軟件app推薦 十大數字貨幣交易app排行榜2025

Mar 17, 2025 pm 05:48 PM

安全的虛擬幣軟件app推薦:1. OKX,2. Binance,3. Gate.io,4. Kraken,5. Huobi,6. Coinbase,7. KuCoin,8. Crypto.com,9. Bitfinex,10. Gemini。選擇平台時應考慮安全性、流動性、手續費、幣種選擇、用戶界面和客戶支持。

wordpress文章列表怎麼調

Apr 20, 2025 am 10:48 AM

wordpress文章列表怎麼調

Apr 20, 2025 am 10:48 AM

有四種方法可以調整 WordPress 文章列表:使用主題選項、使用插件(如 Post Types Order、WP Post List、Boxy Stuff)、使用代碼(在 functions.php 文件中添加設置)或直接修改 WordPress 數據庫。

安全靠譜的數字貨幣平台有哪些

Mar 17, 2025 pm 05:42 PM

安全靠譜的數字貨幣平台有哪些

Mar 17, 2025 pm 05:42 PM

安全靠譜的數字貨幣平台:1. OKX,2. Binance,3. Gate.io,4. Kraken,5. Huobi,6. Coinbase,7. KuCoin,8. Crypto.com,9. Bitfinex,10. Gemini。選擇平台時應考慮安全性、流動性、手續費、幣種選擇、用戶界面和客戶支持。