Linux中的兩個神祕工具:靜態函式庫vs動態函式庫

Linux的世界裡,程式設計師常常使用的兩個神祕工具-靜態函式庫和動態函式庫。這兩者究竟有何優勢,差異在哪,如何根據專案需求明智選擇?

一、靜態函式庫與動態函式庫的概念

首先,讓我們先簡單了解這兩者的基本概念。

- 靜態函式庫:靜態函式庫是在編譯時將函式庫的程式碼和程式碼連結在一起,形成一個獨立的可執行檔。所有程式碼都被打包到最終的可執行檔中,使程式在運行時不依賴外部庫。

- 動態函式庫:動態函式庫則是程式執行時載入的函式庫,它在程式啟動時並不包含函式庫的程式碼,而是在需要的時候載入。多個程式可以共享同一個動態庫的實例,節省記憶體空間。

二、靜態函式庫 vs 動態函式庫:優勢比較

#靜態函式庫的優勢:

- 獨立性強:靜態函式庫將所有程式碼打包到可執行檔中,程式在運行時不需要外部支持,具有很強的獨立性。

- 鏈接速度快:由於所有程式碼在編譯時已經鏈接,因此靜態庫的鏈接速度相對較快。

- 移植性好:因為所有依賴都被打包,所以程式更容易在不同系統上移植。

動態函式庫的優點:

- 共享性強:多個程式可以共享同一個動態庫的實例,節省內存,提高系統效能。

- 靈活性高:可以在程式執行時載入和卸載,不需要重新編譯程序,更容易更新和維護。

- 執行階段載入:動態庫的載入是在程式執行時進行的,提供更大的靈活性。

三、區別比較:靜態函式庫 vs 動態函式庫

#編譯方式:

- 靜態函式庫:在編譯時與程式碼鏈接,產生獨立的可執行檔。

- 動態庫:在運行時由動態連結器加載,程式在啟動時並不包含庫的程式碼。

檔案副檔名:

- 靜態函式庫:通常以.a為副檔名,例如libexample.a。

- 動態函式庫:通常以.so為副檔名,例如libexample.so。

記憶體佔用:

- 靜態函式庫:整個函式庫的程式碼都被嵌入到執行檔中,可能佔用較多的記憶體。

- 動態庫:多個程式可以共享一個庫的實例,節省記憶體。

更新與維護:

- 靜態函式庫:需要重新編譯程式才能更新函式庫,不夠靈活。

- 動態函式庫:可以在不重新編譯程式的情況下更新函式庫,維護更加方便。

四、使用場景比較:靜態函式庫 vs 動態函式庫

#靜態庫的適用場景:

- 獨立性要求高:當程式對獨立性要求較高,不依賴外部函式庫時,選擇靜態函式庫是個不錯的選擇。

- 版本要求嚴格:當程式需要特定版本的函式庫時,將庫的程式碼嵌入程式中,可以確保版本一致性。

動態庫的適用場景:

- 共享性要求高:當多個程式需要共享同一個函式庫的實例時,使用動態函式庫可以減少系統記憶體佔用。

- 靈活性需求高:當程式需要在不重新編譯的情況下更新函式庫時,選擇動態函式庫會比較合適。

五、個案分析

場景:假設我們有一個圖形處理程序,需要載入不同濾鏡的功能。

1. 使用靜態函式庫的方式

每個濾鏡可以被編譯成靜態函式庫,然後連結到主程式。

gcc -c filter1.c -o filter1.o ar rcs libfilter1.a filter1.o gcc -o image_editor main.c -L. -lfilter1

這樣,每個濾鏡的程式碼都被打包到主程式中,形成一個獨立的執行檔。

2. 使用動態函式庫的方式

如果我們選擇使用動態函式庫,每個濾鏡可以被編譯成動態函式庫,並在程式執行時載入。

gcc -shared -fPIC filter2.c -o libfilter2.so gcc -o image_editor main.c -ldl

在程式運作時,透過動態連結器可以載入不同濾鏡的動態函式庫,實現更靈活的濾鏡管理。

六、結語

#在Linux的探索之路上,靜態函式庫和動態函式庫是你的得力助手。了解它們的優劣,理智選擇,將助你的程式更加強大和靈活。

以上是Linux中的兩個神祕工具:靜態函式庫vs動態函式庫的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

華為手機記憶體不足怎麼辦(解決記憶體不足問題的實用方法)

Apr 29, 2024 pm 06:34 PM

華為手機記憶體不足怎麼辦(解決記憶體不足問題的實用方法)

Apr 29, 2024 pm 06:34 PM

華為手機內存不足已經成為許多用戶面臨的常見問題、隨著行動應用程式和媒體檔案的增加。幫助用戶充分利用手機的儲存空間、本文將介紹一些實用方法來解決華為手機記憶體不足的問題。 1.清理快取:歷史記錄以及無效數據,以釋放記憶體空間,清除應用程式產生的臨時檔案。在華為手機設定中找到「儲存」點擊,選項「清除快取」按鈕即可刪除應用程式的快取檔案。 2.卸載不常用的應用程式:以釋放記憶體空間,刪除一些不常用的應用程式。拖曳到手機螢幕上方的、長按要刪除的應用程式圖示「卸載」然後點擊確認按鈕即可完成卸載,標誌處。 3.移動應用到

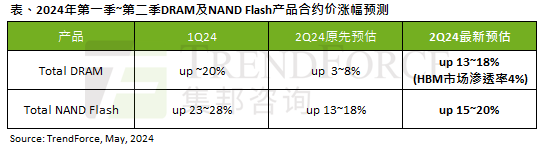

AI 潮影響明顯,TrendForce 上修本季 DRAM 記憶體、NAND 快閃記憶體合約價漲幅預測

May 07, 2024 pm 09:58 PM

AI 潮影響明顯,TrendForce 上修本季 DRAM 記憶體、NAND 快閃記憶體合約價漲幅預測

May 07, 2024 pm 09:58 PM

根據TrendForce的調查報告顯示,AI浪潮對DRAM記憶體和NAND快閃記憶體市場帶來明顯影響。在本站5月7日消息中,TrendForce集邦諮詢在今日的最新研報中稱該機構調升本季兩類儲存產品的合約價格漲幅。具體而言,TrendForce原先預估2024年第二季DRAM記憶體合約上漲3~8%,現估計為13~18%;而在NAND快閃記憶體方面,原預估上漲13~18%,新預估為15 ~20%,僅eMMC/UFS漲幅較低,為10%。 ▲圖源TrendForce集邦諮詢TrendForce表示,該機構原預計在連續

Edge瀏覽器記憶體佔用太多怎麼辦 記憶體佔用太多的解決方法

May 09, 2024 am 11:10 AM

Edge瀏覽器記憶體佔用太多怎麼辦 記憶體佔用太多的解決方法

May 09, 2024 am 11:10 AM

1.首先,進入Edge瀏覽器點選右上角三個點。 2、然後,在工作列中選擇【擴充】。 3、接著,將不需要使用的插件關閉或卸載即可。

deepseek怎麼本地微調

Feb 19, 2025 pm 05:21 PM

deepseek怎麼本地微調

Feb 19, 2025 pm 05:21 PM

本地微調 DeepSeek 類模型面臨著計算資源和專業知識不足的挑戰。為了應對這些挑戰,可以採用以下策略:模型量化:將模型參數轉換為低精度整數,減少內存佔用。使用更小的模型:選擇參數量較小的預訓練模型,便於本地微調。數據選擇和預處理:選擇高質量的數據並進行適當的預處理,避免數據質量不佳影響模型效果。分批訓練:對於大數據集,分批加載數據進行訓練,避免內存溢出。利用 GPU 加速:利用獨立顯卡加速訓練過程,縮短訓練時間。

只要250美元,Hugging Face技術主管手把手教你微調Llama 3

May 06, 2024 pm 03:52 PM

只要250美元,Hugging Face技術主管手把手教你微調Llama 3

May 06, 2024 pm 03:52 PM

我們熟悉的Meta推出的Llama3、MistralAI推出的Mistral和Mixtral模型以及AI21實驗室推出的Jamba等開源大語言模型已經成為OpenAI的競爭對手。在大多數情況下,使用者需要根據自己的資料對這些開源模型進行微調,才能充分釋放模型的潛力。在單一GPU上使用Q-Learning對比小的大語言模型(如Mistral)進行微調不是難事,但對像Llama370b或Mixtral這樣的大模型的高效微調直到現在仍然是一個挑戰。因此,HuggingFace技術主管PhilippSch

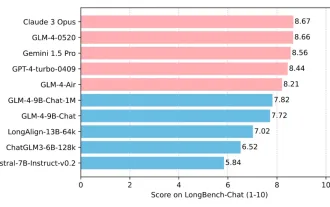

清華大學與智譜AI重磅開源 GLM-4:掀起自然語言處理新革命

Jun 12, 2024 pm 08:38 PM

清華大學與智譜AI重磅開源 GLM-4:掀起自然語言處理新革命

Jun 12, 2024 pm 08:38 PM

自2023年3月14日開始,ChatGLM-6B以來,GLM系列模型受到了廣泛的關注與認可。特別是在ChatGLM3-6B開源之後,開發者對智譜AI推出的第四代模型充滿了期待。而這項期待,隨著GLM-4-9B的發布,終於得到了充分的滿足。 GLM-4-9B的誕生為了賦予小模型(10B及以下)更加強大的能力,GLM技術團隊經過近半年的探索,推出了這款全新的第四代GLM系列開源模型:GLM-4-9B。這一模型在確保精度的同時,大幅度壓縮了模型大小,具有更快的推理速度和更高的效率。 GLM技術團隊的探索沒

golang與java做web哪個效能比較好

Apr 21, 2024 am 12:49 AM

golang與java做web哪個效能比較好

Apr 21, 2024 am 12:49 AM

Golang 在 Web 效能上更優於 Java,原因如下:編譯型語言,直接編譯成機器碼,執行效率更高。高效率的垃圾收集機制,降低記憶體洩漏風險。較快的啟動時間,無需載入運行時解釋器。請求處理效能相近,支援並發和非同步程式設計。更低的記憶體佔用,直接編譯為機器碼無需額外解釋器和虛擬機器。