AI影片又炸了!照片+聲音變視頻,阿里讓Sora女主角唱歌小李子說RAP

Sora之後,居然還有新的AI影片模型,能驚艷得大家狂轉狂贊!

圖片

圖片

有了它,《狂飆》大反派高啟強化身羅翔,都能給大夥兒普法啦(狗頭)。

這就是阿里最新推出的基於音訊驅動的肖像視訊生成框架,EMO(Emote Portrait Alive)。

有了它,輸入單張參考影像,以及一段音訊(說話、唱歌、RAP皆可),就能產生表情生動的AI影片。視訊最終長度,取決於輸入音訊的長度。

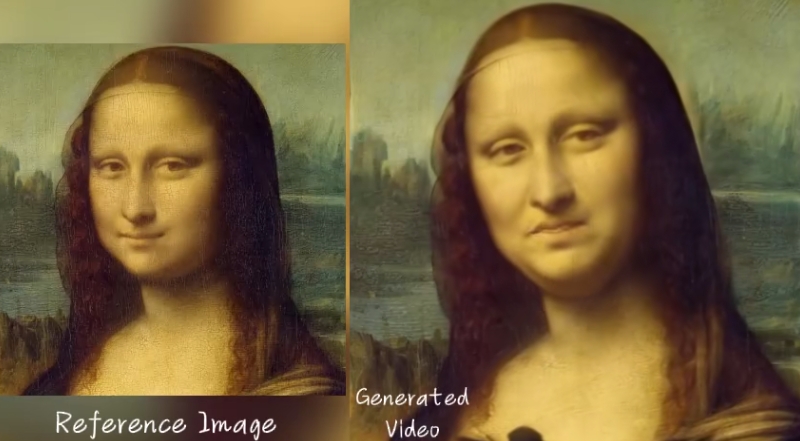

你可以讓蒙娜麗莎-這位AI屆效果體驗的老選手,朗誦一段獨白:

年輕俊美的小李子來段快節奏的RAP才藝秀,嘴形跟上完全沒問題:

#甚至粵語口型也能hold住,這就讓哥哥張國榮來首陳奕迅的《無條件》:

總之,不管是讓肖像唱歌(不同風格的肖像和歌曲)、讓肖像開口說話(不同語種)、還是各種「張冠李戴」的跨演員表演,EMO的效果,都讓咱看得一愣的。

網友大感嘆:「我們正走進一個新的現實!」

2019版《小丑》說2008版《蝙蝠俠黑暗騎士》的台詞

2019版《小丑》說2008版《蝙蝠俠黑暗騎士》的台詞

甚至已經有網友開始對EMO產生影片開始了拉片,逐幀分析效果究竟怎麼樣。

如下面這段視頻,主角是Sora生成的AI女士,本次為大家演唱的曲目是《Don’t Start Now》。

推友分析:

這段影片的一致性,比以往更上一層樓了!

一分多鐘的影片裡,Sora女士臉上的墨鏡幾乎沒有亂動,耳朵、眉毛都有獨立的運動。

最精彩的是Sora女士的喉嚨好像真的有呼吸哎!她唱歌的過程中身體還有微顫和移動,我直接震驚!

圖片

圖片

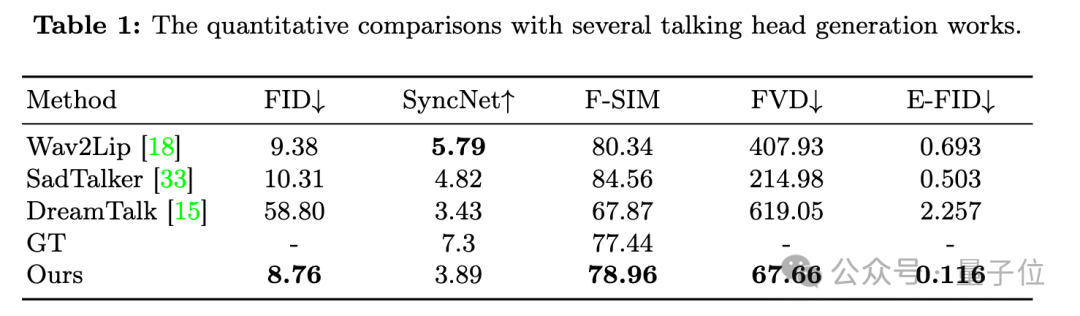

話說回來,EMO是熱門新技術嘛,免不了拿來與同類對比——

就在昨天,AI視頻生成公司Pika也推出了為視頻人物配音,同時“對口型”的唇形同步功能,撞車了。

具體效果怎麼樣呢,我們直接擺在這裡

評論區網友對比過後得出的結論是,被阿里吊打了。

圖片

圖片

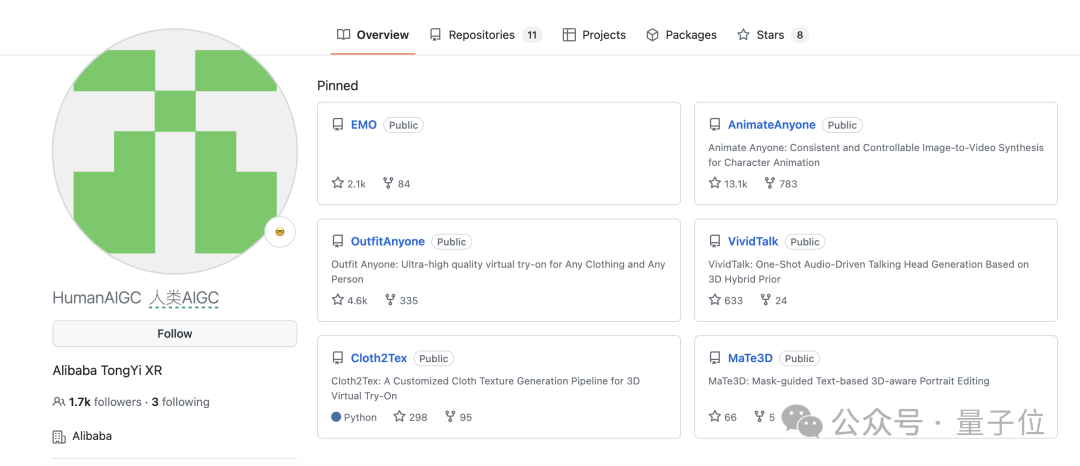

EMO公佈論文,同時宣告開源。

但是!雖說開源,GitHub上仍然是空倉。

再但是!雖然是空倉,標星數已經超過2.1k了。

圖片

圖片

惹得網友們真的好著急,有吉吉王那麼急。

與Sora不同架構

EMO論文一出,圈內不少人鬆了一口氣。

它與Sora技術路線不同,說明復刻Sora不是唯一的路。

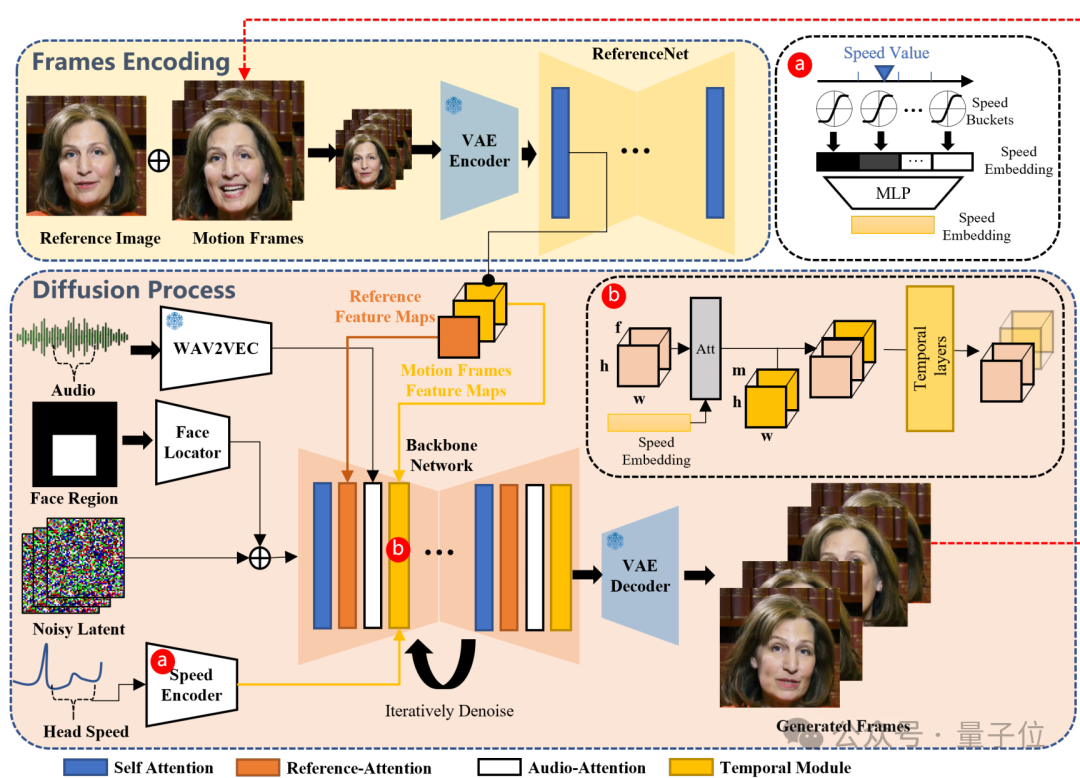

EMO並不是建立在類似DiT架構的基礎上,也就是沒有用Transformer去取代傳統UNet,其骨幹網路魔改自Stable Diffusion 1.5。

具體來說,EMO是一種富有表現力的音訊驅動的肖像視訊生成框架,可以根據輸入視訊的長度生成任何持續時間的視訊。

圖片

圖片

此框架主要由兩個階段構成:

- ##影格編碼階段

- 擴散階段

- 可以根據輸入音頻生成任意持續時間的視頻,同時保證角色身份一致性(演示中給出的最長單個視頻為1分49秒)。

- 支援各種語言的交談與唱歌(演示中包括普通話、廣東話、英語、日語、韓語)

- 支援不同畫風(照片、傳統繪畫、漫畫、3D渲染、 AI數字人)

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

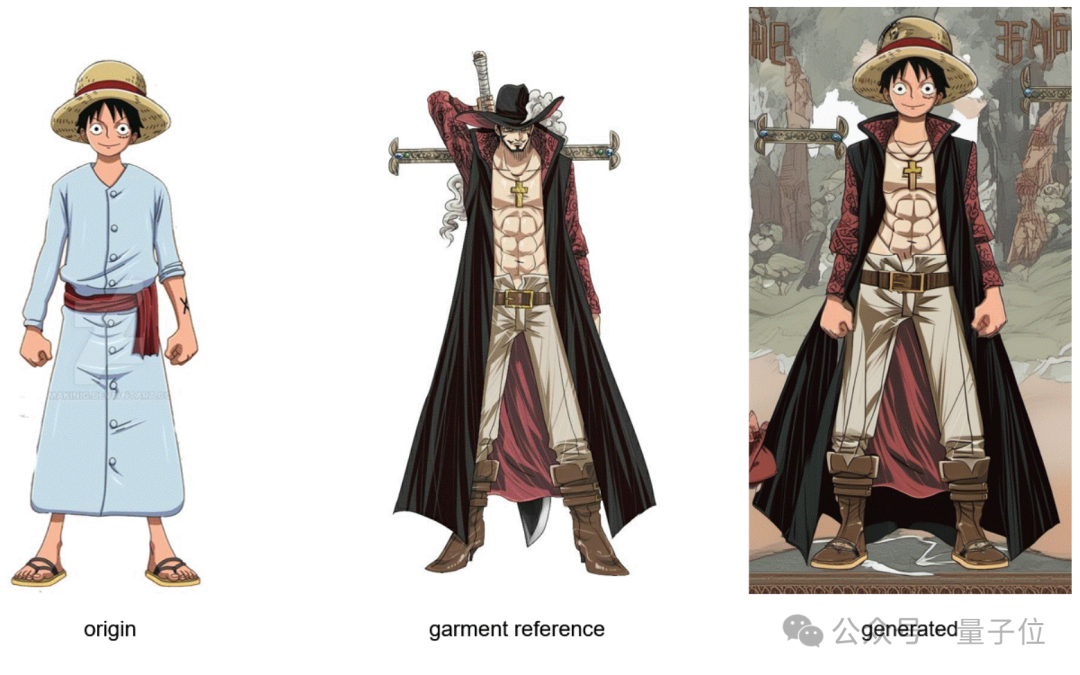

如果現在把所有這些技術結合起來,那效果…

不敢想,但好期待。

圖片

圖片

總之,我們離「發給AI一個劇本,輸出整部電影」越來越近了。

圖片

圖片

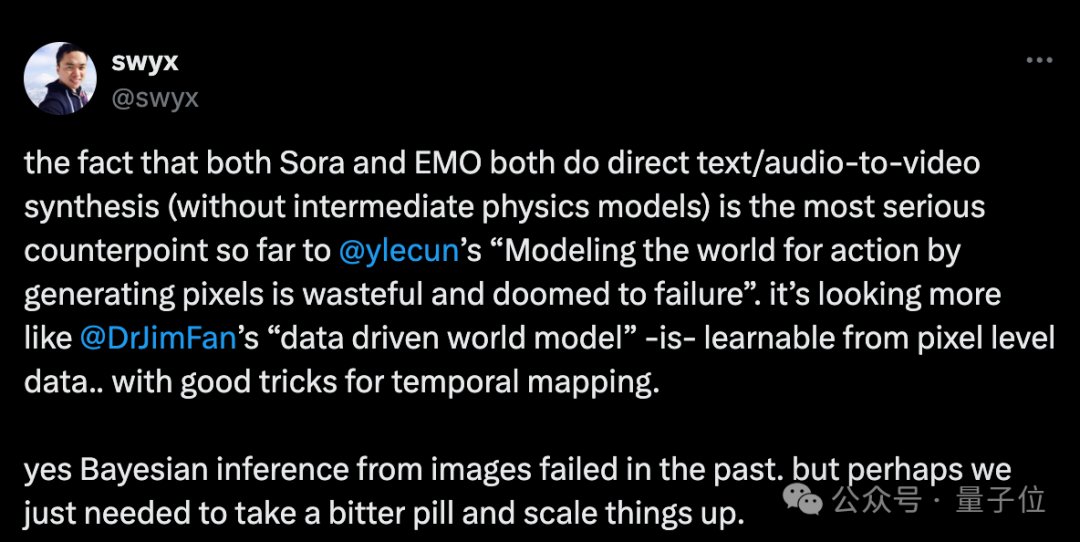

One More Thing

#Sora,代表文字驅動的影片合成的斷崖式突破。

EMO,也代表音訊驅動的視訊合成一個新高度。

兩者儘管任務不同、具體架構不同,但還有一個重要的共通性:

中間都沒有加入顯式的物理模型,卻都在一定程度上模擬了物理規律。

因此有人認為,這與Lecun堅持的「透過生成像素來為動作建模世界是浪費且注定要失敗的」觀點相悖,更支持了Jim Fan的「數據驅動的世界模型」思想。

圖片

圖片

過去種種方法失敗了,而現在的成功,可能真就來自還是強化學習之父Sutton的《苦澀的教訓》,大力出奇蹟。

讓AI能夠像人們一樣去發現,而不是包含人們發現的內容

#突破性的進展最終透過擴大計算規模來實現

#論文:https://www.php.cn/link/a717f41c203cb970f96f706e4b12617bGitHub:#https://www.php.cn/link/e43a09ffc30b44cb1f026fcn/link/e43a09ffc30b44cb1f026fcn/link/e46f878##連結:[1]

https://www.php.cn/link/0dd4f2526c7c874d06f19523264f6552以上是AI影片又炸了!照片+聲音變視頻,阿里讓Sora女主角唱歌小李子說RAP的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

DMA在C 中是指DirectMemoryAccess,直接內存訪問技術,允許硬件設備直接與內存進行數據傳輸,不需要CPU干預。 1)DMA操作高度依賴於硬件設備和驅動程序,實現方式因係統而異。 2)直接訪問內存可能帶來安全風險,需確保代碼的正確性和安全性。 3)DMA可提高性能,但使用不當可能導致系統性能下降。通過實踐和學習,可以掌握DMA的使用技巧,在高速數據傳輸和實時信號處理等場景中發揮其最大效能。

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono庫可以讓你更加精確地控制時間和時間間隔,讓我們來探討一下這個庫的魅力所在吧。 C 的chrono庫是標準庫的一部分,它提供了一種現代化的方式來處理時間和時間間隔。對於那些曾經飽受time.h和ctime折磨的程序員來說,chrono無疑是一個福音。它不僅提高了代碼的可讀性和可維護性,還提供了更高的精度和靈活性。讓我們從基礎開始,chrono庫主要包括以下幾個關鍵組件:std::chrono::system_clock:表示系統時鐘,用於獲取當前時間。 std::chron

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

在C 中測量線程性能可以使用標準庫中的計時工具、性能分析工具和自定義計時器。 1.使用庫測量執行時間。 2.使用gprof進行性能分析,步驟包括編譯時添加-pg選項、運行程序生成gmon.out文件、生成性能報告。 3.使用Valgrind的Callgrind模塊進行更詳細的分析,步驟包括運行程序生成callgrind.out文件、使用kcachegrind查看結果。 4.自定義計時器可靈活測量特定代碼段的執行時間。這些方法幫助全面了解線程性能,並優化代碼。

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

交易所內置量化工具包括:1. Binance(幣安):提供Binance Futures量化模塊,低手續費,支持AI輔助交易。 2. OKX(歐易):支持多賬戶管理和智能訂單路由,提供機構級風控。獨立量化策略平台有:3. 3Commas:拖拽式策略生成器,適用於多平台對沖套利。 4. Quadency:專業級算法策略庫,支持自定義風險閾值。 5. Pionex:內置16 預設策略,低交易手續費。垂直領域工具包括:6. Cryptohopper:雲端量化平台,支持150 技術指標。 7. Bitsgap:

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

在C 中處理高DPI顯示可以通過以下步驟實現:1)理解DPI和縮放,使用操作系統API獲取DPI信息並調整圖形輸出;2)處理跨平台兼容性,使用如SDL或Qt的跨平台圖形庫;3)進行性能優化,通過緩存、硬件加速和動態調整細節級別來提升性能;4)解決常見問題,如模糊文本和界面元素過小,通過正確應用DPI縮放來解決。

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 在實時操作系統(RTOS)編程中表現出色,提供了高效的執行效率和精確的時間管理。 1)C 通過直接操作硬件資源和高效的內存管理滿足RTOS的需求。 2)利用面向對象特性,C 可以設計靈活的任務調度系統。 3)C 支持高效的中斷處理,但需避免動態內存分配和異常處理以保證實時性。 4)模板編程和內聯函數有助於性能優化。 5)實際應用中,C 可用於實現高效的日誌系統。

給MySQL表添加和刪除字段的操作步驟

Apr 29, 2025 pm 04:15 PM

給MySQL表添加和刪除字段的操作步驟

Apr 29, 2025 pm 04:15 PM

在MySQL中,添加字段使用ALTERTABLEtable_nameADDCOLUMNnew_columnVARCHAR(255)AFTERexisting_column,刪除字段使用ALTERTABLEtable_nameDROPCOLUMNcolumn_to_drop。添加字段時,需指定位置以優化查詢性能和數據結構;刪除字段前需確認操作不可逆;使用在線DDL、備份數據、測試環境和低負載時間段修改表結構是性能優化和最佳實踐。

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中使用字符串流的主要步驟和注意事項如下:1.創建輸出字符串流並轉換數據,如將整數轉換為字符串。 2.應用於復雜數據結構的序列化,如將vector轉換為字符串。 3.注意性能問題,避免在處理大量數據時頻繁使用字符串流,可考慮使用std::string的append方法。 4.注意內存管理,避免頻繁創建和銷毀字符串流對象,可以重用或使用std::stringstream。