AMD Ryzen AI CPU 和 Radeon RX 7000 GPU 現支援本地運行 LLM 和 AI 聊天機器人

本站 3 月 7 日消息,AMD 公司今天發佈公告,表示用戶可以本地化運行基於 GPT 的大語言模型(LLM),從而構建專屬的 AI 聊天機器人。

AMD 表示用戶可以在包括採用 AMD 新 XDNA NPU 的 Ryzen 7000 和 Ryzen 8000 系列 APU,以及內建 AI 加速核心的 Radeon RX 7000 系列 GPU 設備上,本地運行 LLM 和 AI 聊天機器人。

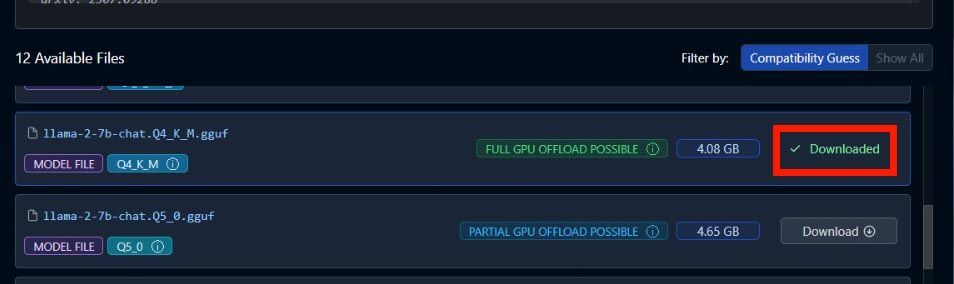

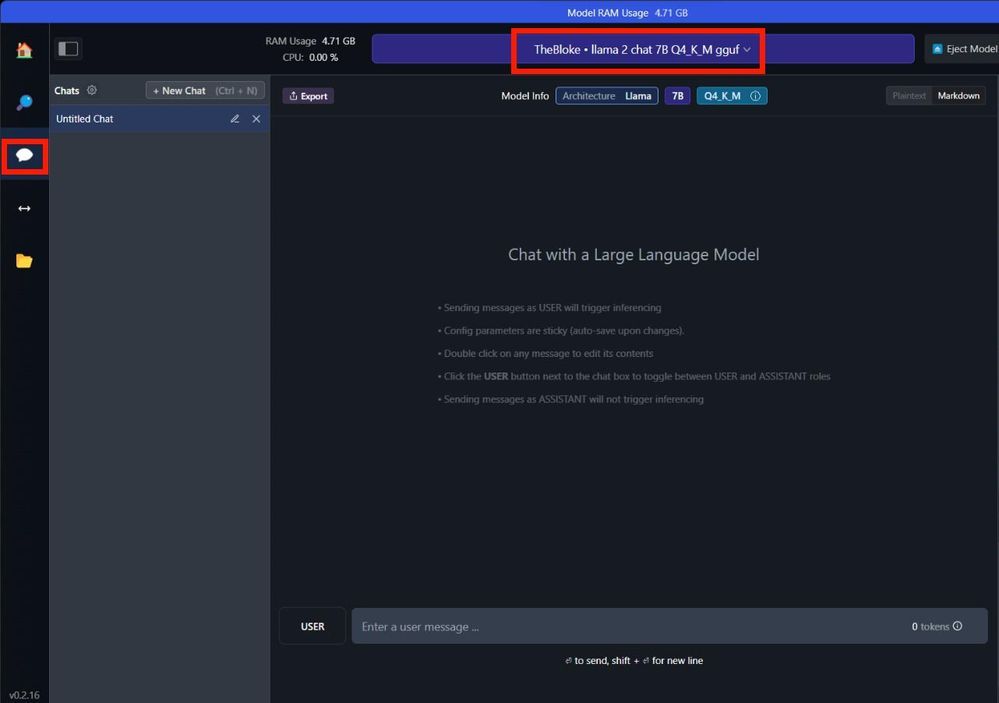

AMD 在公告中詳細介紹了運行步驟,例如運行70 億參數的Mistral,搜尋並下載「TheBloke / OpenHermes-2.5-Mistral-7B- GGUF」;如果運行70 億參數的LLAMA v2,請搜尋並下載「TheBloke / Llama-2-7B-Chat-GGUF」。

#AMD 並不是第一個這樣做的公司,Infinda(NVIDIA)最近也推出了"Chat with RTX",這是一個由GeForce RTX 40 和RTX 30 系列GPU 支援的人工智慧聊天機器人。它採用 TensorRT-LLM 功能集進行加速,基於在地化資料集提供快速產生的人工智慧結果。

本站附上公告原文位址,有興趣的使用者可以造訪閱讀。

以上是AMD Ryzen AI CPU 和 Radeon RX 7000 GPU 現支援本地運行 LLM 和 AI 聊天機器人的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

幣圈行情實時數據免費平台推薦前十名發布

Apr 22, 2025 am 08:12 AM

幣圈行情實時數據免費平台推薦前十名發布

Apr 22, 2025 am 08:12 AM

適合新手的加密貨幣數據平台有CoinMarketCap和非小號。 1. CoinMarketCap提供全球加密貨幣實時價格、市值、交易量排名,適合新手與基礎分析需求。 2. 非小號提供中文友好界面,適合中文用戶快速篩選低風險潛力項目。

okx在線 okx交易所官網在線

Apr 22, 2025 am 06:45 AM

okx在線 okx交易所官網在線

Apr 22, 2025 am 06:45 AM

OKX 交易所的詳細介紹如下:1) 發展歷程:2017 年創辦,2022 年更名為 OKX;2) 總部位於塞舌爾;3) 業務範圍涵蓋多種交易產品,支持 350 多種加密貨幣;4) 用戶遍布 200 餘個國家,千萬級用戶量;5) 採用多重安全措施保障用戶資產;6) 交易費用基於做市商模式,費率隨交易量增加而降低;7) 曾獲多項榮譽,如“年度加密貨幣交易所”等。

各大虛擬貨幣交易平台的特色服務一覽

Apr 22, 2025 am 08:09 AM

各大虛擬貨幣交易平台的特色服務一覽

Apr 22, 2025 am 08:09 AM

機構投資者應選擇Coinbase Pro和Genesis Trading等合規平台,關注冷存儲比例與審計透明度;散戶投資者應選擇幣安和火幣等大平台,注重用戶體驗與安全;合規敏感地區的用戶可通過Circle Trade和Huobi Global進行法幣交易,中國大陸用戶需通過合規場外渠道。

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

選擇大宗交易平台時應考慮以下因素:1. 流動性:優先選擇日均交易量超50億美元的平台。 2. 合規性:查看平台是否持有美國FinCEN、歐盟MiCA等牌照。 3. 安全性:冷錢包存儲比例和保險機制是關鍵指標。 4. 服務能力:是否提供專屬客戶經理和定制化交易工具。

支持多種幣種的虛擬貨幣交易平台推薦前十名一覽

Apr 22, 2025 am 08:15 AM

支持多種幣種的虛擬貨幣交易平台推薦前十名一覽

Apr 22, 2025 am 08:15 AM

優先選擇合規平台如OKX和Coinbase,啟用多重驗證,資產自託管可減少依賴:1. 選擇有監管牌照的交易所;2. 開啟2FA和提幣白名單;3. 使用硬件錢包或支持自託管的平台。

數字貨幣交易app容易上手的推薦top10(025年最新排名)

Apr 22, 2025 am 07:45 AM

數字貨幣交易app容易上手的推薦top10(025年最新排名)

Apr 22, 2025 am 07:45 AM

gate.io(全球版)核心優勢是界面極簡,支持中文,法幣交易流程直觀;幣安(簡版)核心優勢是全球交易量第一,簡版模式僅保留現貨交易;OKX(香港版)核心優勢是界面簡潔,支持粵語/普通話,衍生品交易門檻低;火幣全球站(香港版)核心優勢是老牌交易所,推出元宇宙交易終端;KuCoin(中文社區版)核心優勢是支持800 幣種,界面採用微信式交互;Kraken(香港版)核心優勢是美國老牌交易所,持有香港SVF牌照,界面簡潔;HashKey Exchange(香港持牌)核心優勢是香港知名持牌交易所,支持法

幣圈十大行情網站的使用技巧與推薦2025

Apr 22, 2025 am 08:03 AM

幣圈十大行情網站的使用技巧與推薦2025

Apr 22, 2025 am 08:03 AM

國內用戶適配方案包括合規渠道和本地化工具。 1. 合規渠道:通過OTC平台如Circle Trade進行法幣兌換,境內需通過香港或海外平台。 2. 本地化工具:使用幣圈網獲取中文資訊,火幣全球站提供元宇宙交易終端。

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

提供各種複雜的交易工具和市場分析。覆蓋 100 多個國家,日均衍生品交易量超 300 億美元,支持 300 多個交易對與 200 倍槓桿,技術實力強大,擁有龐大的全球用戶基礎,提供專業的交易平台、安全存儲解決方案以及豐富的交易對。