擴散模型如何建構新一代決策智能體?超越自回歸,同時產生長序列規劃軌跡

設想一下,當你站在房間內,準備往門口走去,你是透過自回歸的方式逐步規劃路徑嗎?實際上,你的路徑是一次性整體生成的。

最新研究指出,利用擴散模型的規劃模組可以同時產生長序列的軌跡規劃,更符合人類的決策方式。此外,擴散模型在策略表徵和資料合成方面也能為現有的決策智慧演算法提供更優化的方案。

來自上海交通大學的團隊撰寫的綜述論文《Diffusion Models for Reinforcement Learning: A Survey》梳理了擴散模型在強化學習相關領域的應用。綜述指出現有強化學習演算法面臨長序列規劃誤差累積、策略表達能力受限、互動資料不足等挑戰,而擴散模型已展現出解決強化學習問題中的優勢,並為應對上述長期以來的挑戰帶來新的思路。

論文連結:https://arxiv.org/abs/2311.01223

計畫網址: https://github.com/apexrl/Diff4RLSurvey

此綜述對擴散模型在強化學習中的作用進行了分類,總結了不同強化學習場景中擴散模型的成功案例。最後,綜述展望了未來利用擴散模型解決強化學習問題的發展方向。

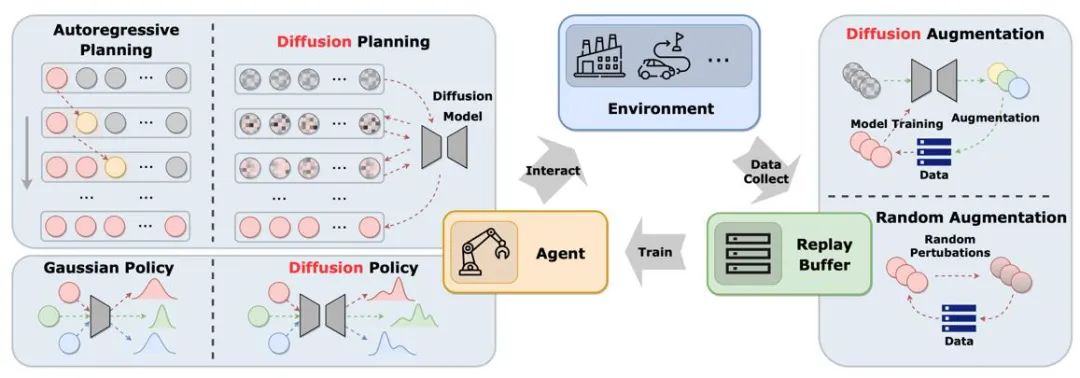

圖中展示了擴散模型在經典智能體-環境-經驗回放池循環中的作用。與傳統解決方案相比,擴散模型為系統引入了新的元素,提供了更全面的資訊互動和學習機會。透過這種方式,智能體能夠更好地適應環境變化,並且優化其決策

擴散模型在強化學習中扮演的角色

文章根據擴散模型在強化學習中扮演角色的不同,分類比較了擴散模型的應用方式和特徵。

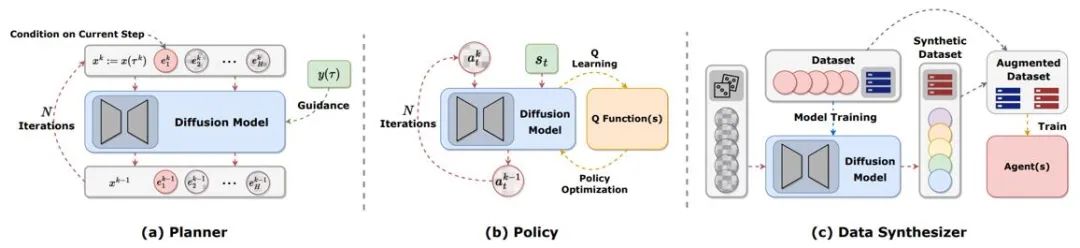

圖 2:擴散模型在強化學習中扮演的不同角色。

軌跡規劃

# 強化學習中的規劃指透過使用動態模型在想像中做決策,再選擇最大化累積獎勵的適當動作。規劃的過程通常會探索各種動作和狀態的序列,進而提升決策的長期效果。在基於模型的強化學習(MBRL)框架中,規劃序列通常以自回歸方式進行模擬,導致累積誤差。擴散模型可以同時產生多步驟規劃序列。現有文章以擴散模型產生的目標非常多樣,包括 (s,a,r)、(s,a)、僅 s、僅有 a 等等。為了在線上評估時產生高獎勵的軌跡,許多工作使用了有分類器或無分類器的引導採樣技術。

策略表徵

#擴散規劃器更近似傳統強化學習中的MBRL,與之相對,將擴散模型作為策略更類似無模型強化學習。 Diffusion-QL 首先將擴散策略與 Q 學習架構結合。由於擴散模型擬合多模態分佈的能力遠超傳統模型,擴散策略在由多個行為策略所取樣的多模態資料集中表現良好。擴散策略與普通策略相同,通常以狀態為條件產生動作,同時考慮最大化 Q (s,a) 函數。 Diffusion-QL 等方法在擴散模型訓練時加上加權的價值函數項,而 CEP 從能量的視角建構加權迴歸目標,用價值函數作為因子,調整擴散模型學到的動作分佈。

資料合成

#擴散模型可以作為資料合成器,來緩解離線或線上強化學習中資料稀少的問題。傳統強化學習資料增強方法通常只能對原有資料進行小幅擾動,而擴散模型強大的分佈擬合能力使其可以直接學習整個資料集的分佈,再取樣新的高品質資料。

其他類型

除了以上幾類,還有一些零散的工作以其他方式使用擴散模型。例如,DVF 利用擴散模型估計值函數。 LDCQ 先將軌跡編碼到隱空間上,再在隱空間上應用擴散模型。 PolyGRAD 以擴散模型學習環境動態轉移,讓策略和模型互動來提升策略學習效率。

在不同強化學習相關問題的應用

#離線強化學習

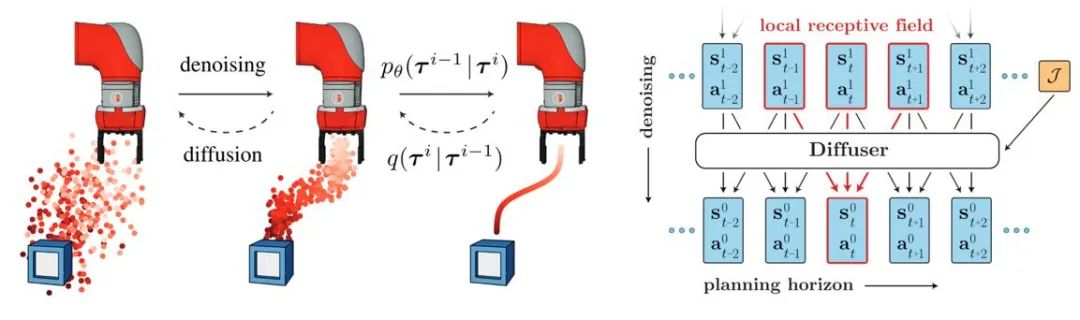

##擴散模型的引入有助於離線強化學習策略擬合多模態資料分佈並擴展了策略的表徵能力。 Diffuser 首先提出了基於分類器指導的高獎勵軌跡生成演算法並啟發了大量的後續工作。同時,擴散模型也能應用在多工與多智能體強化學習場景。

圖3:Diffuser 軌跡產生過程與模型示意圖

線上強化學習

研究者證明擴散模型對線上強化學習中的價值函數、策略也具備最佳化能力。例如,DIPO 對動作資料重標註並使用擴散模型訓練,使策略避免了基於價值引導訓練的不穩定性;CPQL 則驗證了單步採樣擴散模型作為策略能夠平衡交互時的探索和利用。

模仿學習

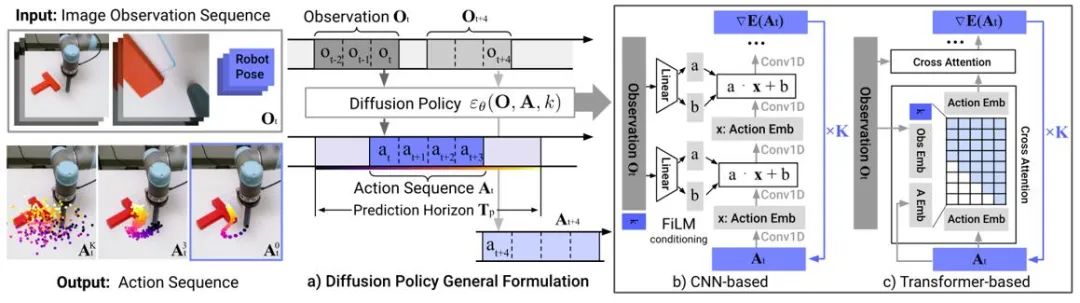

#模仿學習透過學習專家示範資料來重建專家行為。擴散模型的應用有助於提高策略表徵能力以及學習多樣的任務技能。在機器人控制領域,研究發現擴散模型能夠在保持時序穩定性的條件下預測閉環動作序列。 Diffusion Policy 採用影像輸入的擴散模型產生機器人動作序列。實驗顯示擴散模型能夠產生有效閉環動作序列,同時確保時序一致性。

圖4:Diffusion Policy 模型示意圖

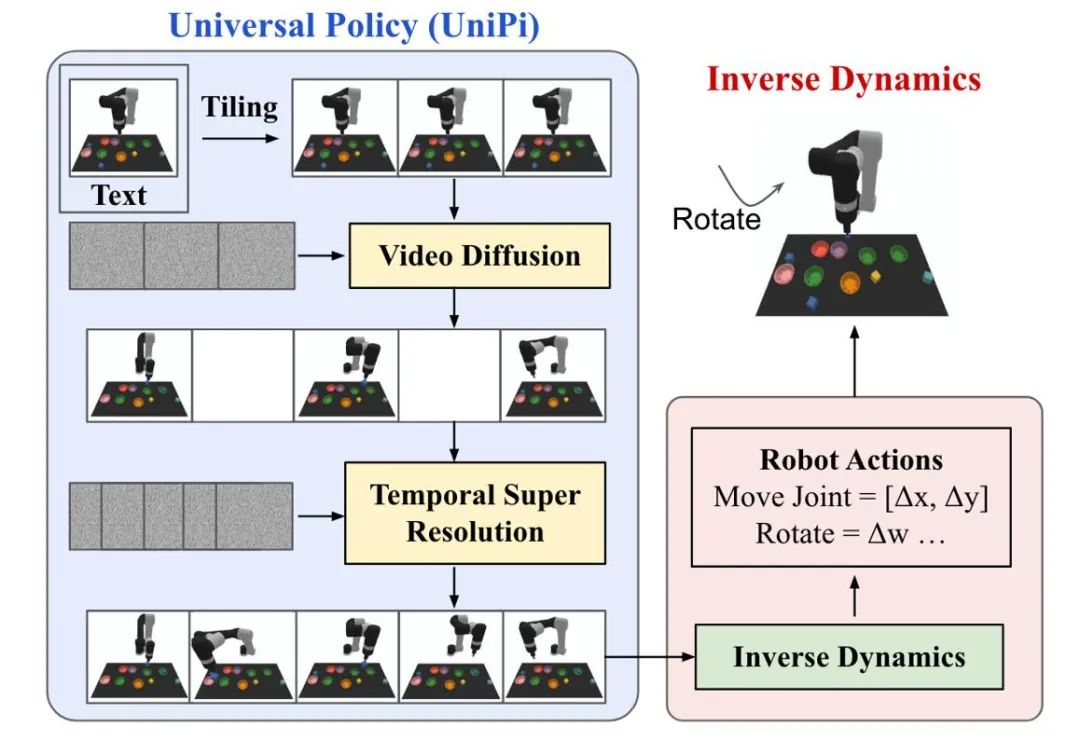

軌跡產生

擴散模型在強化學習中的軌跡生成主要聚焦於人類動作生成以及機器人控制兩類任務。擴散模型產生的動作資料或視訊資料被用來建立模擬模擬器或訓練下游決策模型。 UniPi 訓練了一個視訊生成擴散模型作為通用策略,透過連接不同的逆動力學模型來得到底層控制命令,實現跨具身的機器人控制。

圖 5:UniPi 決策流程示意圖。

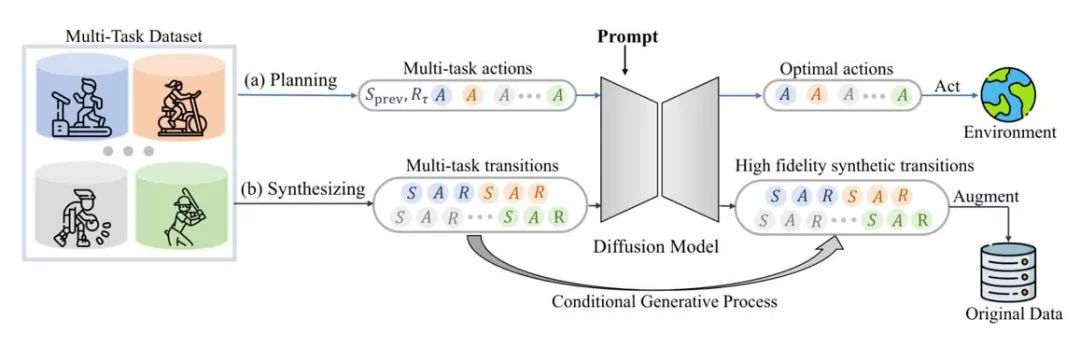

資料增強量

#擴散模型也可以直接擬合原始資料分佈,在維持真實性的前提下提供多樣的動態擴展資料。例如,SynthER 和 MTDiff-s 透過擴散模型產生了訓練任務的完整環境轉移資訊並將其應用於策略的提升,且結果顯示生成資料的多樣程度以及準確性都優於歷史方法。

圖6:MTDiff 進行多任務規劃和資料增強的示意圖

未來展望

生成式模擬環境

#如圖1 所示,現有研究主要利用擴散模型來克服智能體和經驗回放池的局限性,利用擴散模型增強模擬環境的研究比較少。 Gen2Sim 利用文生圖擴散模型在模擬環境中產生多樣化的可操作物件來提高機器人精密操作的泛化能力。擴散模型還有可能在模擬環境中產生狀態轉移函數、獎勵函數或多智能體互動中的對手行為。

加入安全性限制#

透過將安全約束作為模型的取樣條件,基於擴散模型的智能體可以做出滿足特定限制的決策。擴散模型的引導採樣允許透過學習額外的分類器來不斷加入新的安全約束,而原始模型的參數保持不變,從而節省額外的訓練開銷。

檢索增強生成

#檢索增強生成技術能夠透過存取外部資料集增強模型能力,在大語言模型上得到廣泛的應用。透過檢索與智能體當前狀態相關的軌跡並輸入到模型中,基於擴散的決策模型在這些狀態下的表現同樣可能得到提升。如果檢索資料集不斷更新,智能體有可能在不重新訓練的情況下表現出新的行為。

組合多種技能

#與分類器引導或無分類器引導結合,擴散模型可以組合多種簡單技能來完成複雜任務。離線強化學習中的早期結果也表明擴散模型可以共享不同技能之間的知識,從而有可能透過組合不同技能實現零樣本遷移或持續學習。

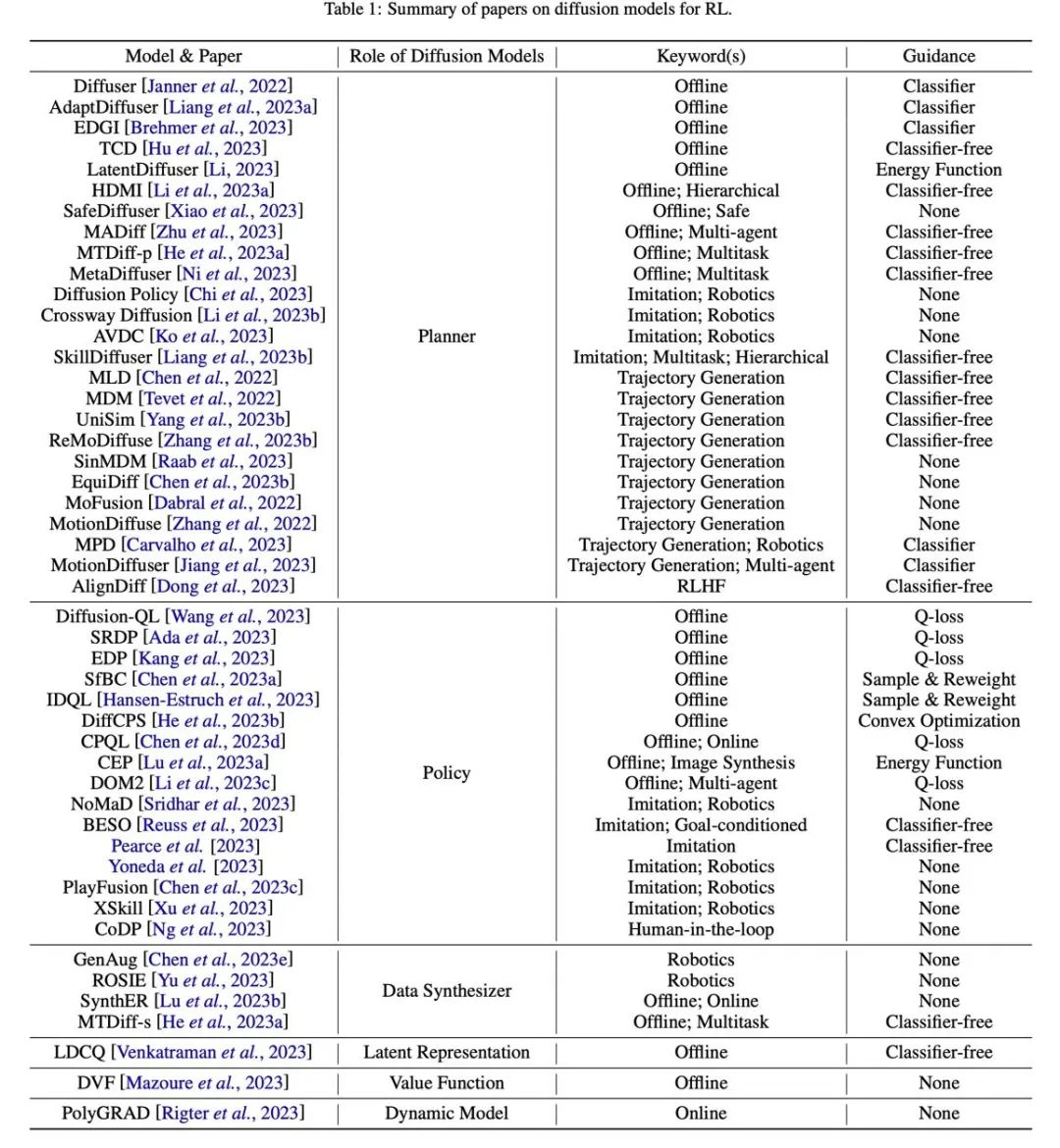

表格

#圖 7:相關論文總結分類表格。

以上是擴散模型如何建構新一代決策智能體?超越自回歸,同時產生長序列規劃軌跡的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

joiplay模擬器使用方法介紹

May 04, 2024 pm 06:40 PM

joiplay模擬器使用方法介紹

May 04, 2024 pm 06:40 PM

jojplay模擬器是一款非常好用的手機模擬器,它支援電腦遊戲可以在手機上運行,而且相容性非常好,有些玩家不知道怎麼使用,下面小編就為大家帶來了使用方法介紹。 joiplay模擬器怎麼使用1、首先需要下載Joiplay本體及RPGM插件,最好按本體-插件的順序進行安裝,apk包可在Joiplay吧取得(點擊取得>>>)。 2.安卓完成後,就可以在左下角加入遊戲了。 3.name隨便填,executablefile按CHOOSE選擇遊戲的game.exe檔。 4.Icon可以留空也可以選擇自己喜歡的圖片

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

本月初,來自MIT等機構的研究者提出了一種非常有潛力的MLP替代方法—KAN。 KAN在準確性和可解釋性方面表現優於MLP。而且它能以非常少的參數量勝過以更大參數量運行的MLP。例如,作者表示,他們用KAN以更小的網路和更高的自動化程度重現了DeepMind的結果。具體來說,DeepMind的MLP有大約300,000個參數,而KAN只有約200個參數。 KAN與MLP一樣具有強大的數學基礎,MLP基於通用逼近定理,而KAN基於Kolmogorov-Arnold表示定理。如下圖所示,KAN在邊上具

joiplay模擬器字體設定方法介紹

May 09, 2024 am 08:31 AM

joiplay模擬器字體設定方法介紹

May 09, 2024 am 08:31 AM

jojplay模擬器其實可以自訂遊戲字體的,而且可以解決文字出現缺字、方框字的問題,想必不少玩家還不知道怎麼操作,下面小編就為大家帶來了joiplay模擬器字體設定方法介紹。 joiplay模擬器字體怎麼設定1、先開啟joiplay模擬器,點選右上角的設定(三個點),找到。 2.在RPGMSettings一欄,第三行CustomFont自訂字體,點選選擇。 3.選擇字體文件,點擊ok就行了,注意不要按右下角「儲存」圖標,不然會原預設設定。 4.推薦方正準圓簡體(已在復興、重生遊戲資料夾內)。 joi

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺

雷電模擬器怎麼刪除應用? -雷電模擬器刪除應用的方法?

May 08, 2024 pm 02:40 PM

雷電模擬器怎麼刪除應用? -雷電模擬器刪除應用的方法?

May 08, 2024 pm 02:40 PM

雷電模擬器版本官方版是相當專業的安卓模擬器工具。那麼雷電模擬器要怎麼刪除應用?雷電模擬器刪除應用的方法?下面就讓小編給大家解答吧!雷電模擬器怎麼刪除應用? 1、點擊並長按你想要刪除的應用程式圖示。 2、等待一段時間,直到出現卸載或刪除應用程式的選項。 3、將應用程式拖曳到卸載選項處。 4.在彈出的確認視窗中,點選確定就可以完成應用的刪除。

人生重開模擬器攻略大全

May 07, 2024 pm 05:28 PM

人生重開模擬器攻略大全

May 07, 2024 pm 05:28 PM

人生重開模擬器是一款非常有趣的模擬小遊戲,這款遊戲最近非常的火,遊戲中有很多的玩法,下面小編就大家帶來了人生重開模擬器攻略大全,快來看看都有哪些攻略吧。人生重開模擬器攻略大全人生重開模擬器特色這是一款非常有創意的遊戲,遊戲裡玩家可以依照自己的想法進行遊戲。每天都會有許多的任務可以完成,在這個虛擬的世界裡享受全新的人生。遊戲裡擁有許多的歌曲,各種不同的人生等著你來感受。人生重開模擬器遊戲內容天賦抽卡:天賦:必選神秘的小盒子,才能修仙子。各種各樣的小膠囊可選,避免中途死掉。克蘇魯選了可能會

全面超越DPO:陳丹琦團隊提出簡單偏好優化SimPO,也煉出最強8B開源模型

Jun 01, 2024 pm 04:41 PM

全面超越DPO:陳丹琦團隊提出簡單偏好優化SimPO,也煉出最強8B開源模型

Jun 01, 2024 pm 04:41 PM

為了將大型語言模型(LLM)與人類的價值和意圖對齊,學習人類回饋至關重要,這能確保它們是有用的、誠實的和無害的。在對齊LLM方面,一種有效的方法是根據人類回饋的強化學習(RLHF)。儘管RLHF方法的結果很出色,但其中涉及了一些優化難題。其中涉及訓練一個獎勵模型,然後優化一個策略模型來最大化該獎勵。近段時間已有一些研究者探索了更簡單的離線演算法,其中之一就是直接偏好優化(DPO)。 DPO是透過參數化RLHF中的獎勵函數來直接根據偏好資料學習策略模型,這樣就無需顯示式的獎勵模型了。此方法簡單穩定