深度估計SOTA!自動駕駛單眼與環視深度的自適應融合

寫在前面&個人理解

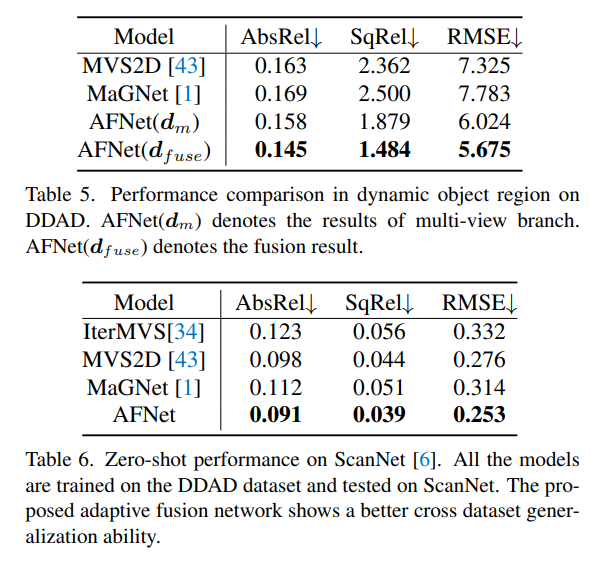

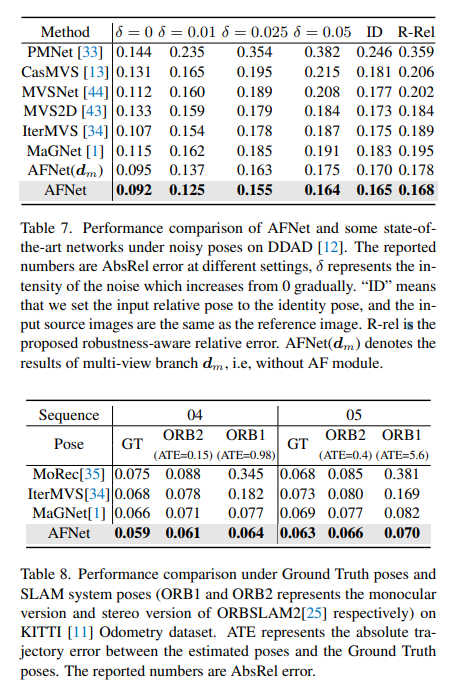

多視圖深度估計在各種基準測試中都取得了較高性能。然而,目前幾乎所有的多視圖系統都依賴給定的理想相機姿態,而這在許多現實世界的場景中是不可用的,例如自動駕駛。本工作提出了一種新的穩健性基準來評估各種噪音姿態設定下的深度估計系統。令人驚訝的是,發現當前的多視圖深度估計方法或單視圖和多視圖融合方法在給定有雜訊的姿態設定時會失敗。為了應對這一挑戰,這裡提出了一種單視圖和多視圖融合的深度估計系統AFNet,該系統自適應地整合了高置信度的多視圖和單視圖結果,以實現穩健和準確的深度估計。自適應融合模組透過基於包裹置信度圖在兩個分支之間動態選擇高置信度區域來執行融合。因此,當面對無紋理場景、不準確的校準、動態物件和其他退化或具有挑戰性的條件時,系統傾向於選擇更可靠的分支。在穩健性測試下,方法優於最先進的多視圖和融合方法。此外,在具有挑戰性的基準測試中實現了最先進的性能 (KITTI和DDAD)。

論文連結:https://arxiv.org/pdf/2403.07535.pdf

論文名稱:Adaptive Fusion of Single-View and Multi-View Depth for Autonomous Driving

領域背景

影像深度估計一直是電腦視覺領域的挑戰,具有廣泛的應用。對於基於視覺的自動駕駛系統,深度感知是關鍵,它有助於理解道路上的物體並建立3D環境地圖。隨著深度神經網路在各種視覺問題中的應用,基於卷積神經網路(CNN)的方法已成為深度估計任務的主流。

根據輸入格式,主要分為多視角深度估計和單視角深度估計。多視圖方法估計深度的假設是,給定正確的深度、相機標定和相機姿態,各個視圖的像素應該相似。他們依靠極線幾何來三角測量高品質的深度。然而,多視圖方法的準確性和穩健性在很大程度上取決於相機的幾何配置和視圖之間的對應匹配。首先,攝影機需要進行足夠的平移以進行三角測量。在自動駕駛場景中,自車可能會在紅綠燈處停車或在不向前移動的情況下轉彎,這會導致三角測量失敗。此外,多視圖方法存在動態目標和無紋理區域的問題,這些問題在自動駕駛場景中普遍存在。另一個問題是運動車輛上的SLAM姿態優化。在現有的SLAM方法中,噪音是不可避免的,更不用說具有挑戰性和不可避免的情況了。例如,一個機器人或自動駕駛汽車可以在不重新校準的情況下部署數年,從而導致姿勢嘈雜。相較之下,由於單一視圖方法依賴對場景的語義理解和透視投影線索,因此它們對無紋理區域、動態物件更具穩健性,而不依賴相機姿勢。然而,由於尺度的模糊性,其效能與多視圖方法相比仍有很大差距。在這裡,我們傾向於考慮是否可以很好地結合這兩種方法的優勢,在自動駕駛場景中進行穩健和準確的單目視訊深度估計。

AFNet網路結構

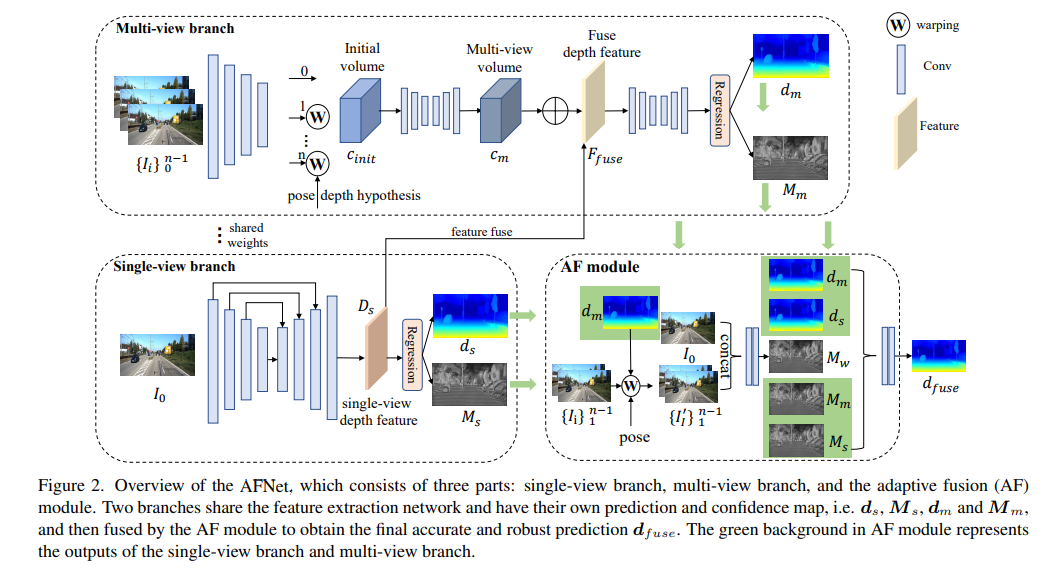

AFNet結構如下所示,它由三個部分組成:單一視圖分支、多視圖分支和自適應融合(AF)模組。兩個分支共享特徵提取網絡,並具有自己的預測和置信度圖,即、,和,然後由AF模組進行融合,以獲得最終準確和穩健的預測,AF模組中的綠色背景表示單視圖分支和多重視圖分支的輸出。

損失函數:

#單一視圖與多視圖深度模組

#為了合併主幹特徵並獲得深度特徵Ds,AFNet建構了一個多尺度解碼器。在這個過程中,對Ds的前256個通道進行softmax操作,得到深度機率體積Ps。而深度特徵中的最後一個通道則被用作單視圖深度的置信圖Ms。最後,透過軟加權的方式來計算單視圖深度。

多重視圖分支

多重視圖分支與單一視圖分支共用主幹,以擷取參考影像和來源影像的特徵。我們採用去卷積將低分辨率特徵去卷積為四分之一分辨率,並將它們與用於構建cost volume的初始四分之一特徵相結合。透過將來源特徵wrap到參考相機跟隨的假設平面中,形成特徵volume。用於不需要太多的魯棒匹配信息,在計算中保留了特徵的通道維度並構建了4D cost volume,然後通過兩個3D卷積層將通道數量減少到1。

深度假設的取樣方法與單視圖分支一致,但取樣數量僅為128,然後使用堆疊的2D沙漏網路進行正規化,以獲得最終的多視圖cost volume。為了補充單視圖特徵的豐富語義資訊和由於成本正則化而丟失的細節,使用殘差結構來組合單視圖深度特徵Ds和cost volume,以獲得融合深度特徵,如下所示:

自適應融合模組

為了獲得最終準確和穩健的預測,設計了AF模組,以自適應地選擇兩個分支之間最準確的深度作為最終輸出,如圖2所示。透過三個confidence進行融合映射,其中兩個是由兩個分支分別產生的置信圖Ms和Mm,最關鍵的一個是透過前向wrapping產生的置信度圖Mw,以判斷多視圖分支的預測是否可靠。

實驗結果

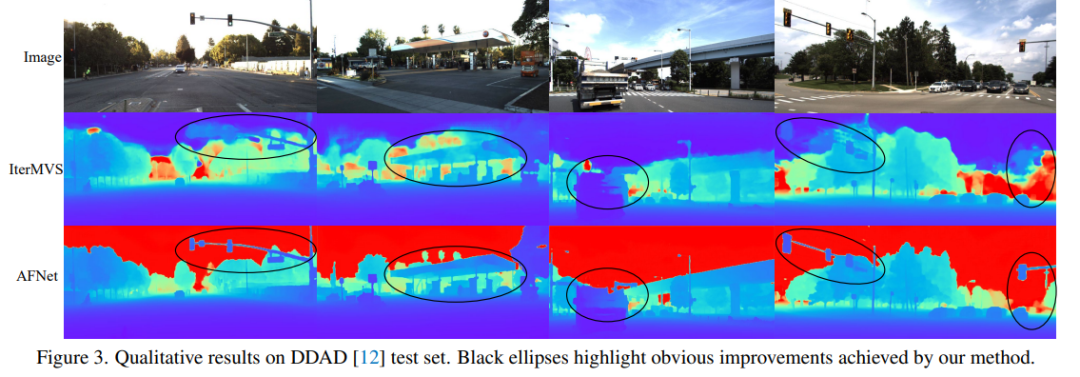

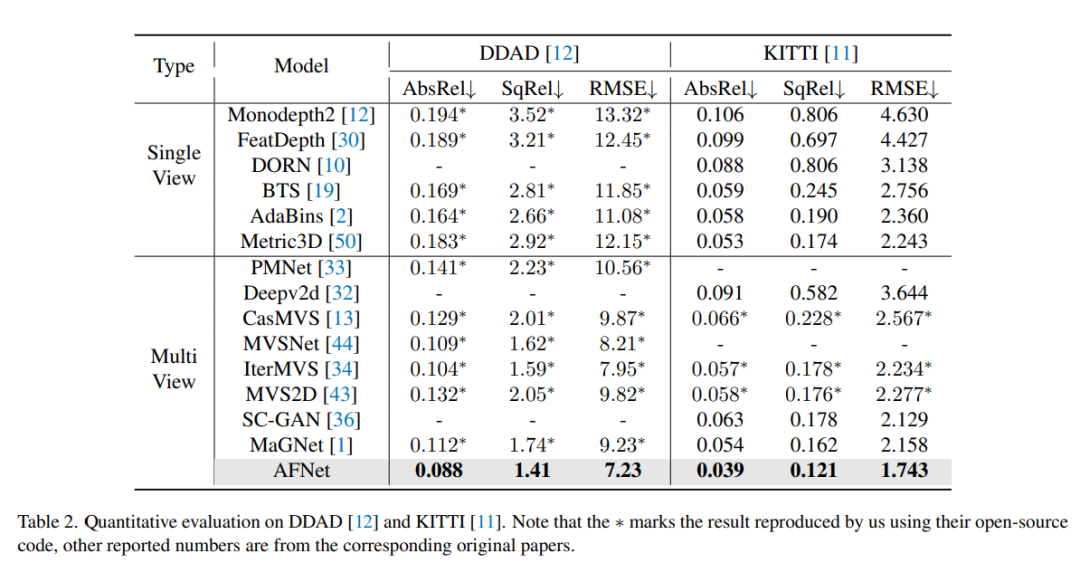

DDAD(自動駕駛的密集深度)是一種新的自動駕駛基準,用於在具有挑戰性和多樣化的城市條件下進行密集深度估計。它由6台同步相機拍攝,並包含高密度雷射雷達產生的準確的地GT深度(整個360度視場)。它在單一相機視圖中有12650個訓練樣本和3950個驗證樣本,其中解析度為1936×1216。來自6台攝影機的全部資料用於訓練和測試。 KITTI資料集,提供運動車輛上拍攝的戶外場景的立體影像和相應的3D雷射scan,解析度約為1241×376。

DDAD和KITTI上的評測結果比較。請注意,* 標記了使用其開源程式碼複製的結果,其他報告的數字來自相應的原始論文。

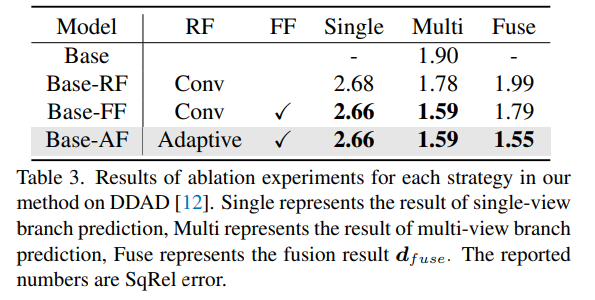

DDAD上方法中每種策略的消融實驗結果。 Single表示單一視圖分支預測的結果,Multi-表示多視圖分支預測結果,Fuse表示融合結果dfuse。

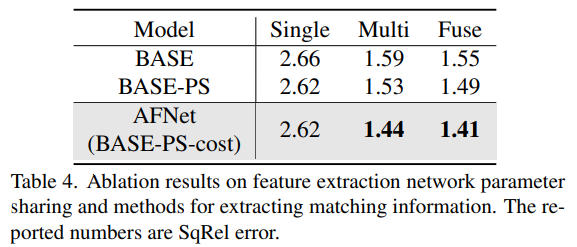

消融結果的特徵提取網路參數共享和提取匹配資訊的方法。

以上是深度估計SOTA!自動駕駛單眼與環視深度的自適應融合的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

CUDA之通用矩陣乘法:從入門到熟練!

Mar 25, 2024 pm 12:30 PM

CUDA之通用矩陣乘法:從入門到熟練!

Mar 25, 2024 pm 12:30 PM

通用矩陣乘法(GeneralMatrixMultiplication,GEMM)是許多應用程式和演算法中至關重要的一部分,也是評估電腦硬體效能的重要指標之一。透過深入研究和優化GEMM的實現,可以幫助我們更好地理解高效能運算以及軟硬體系統之間的關係。在電腦科學中,對GEMM進行有效的最佳化可以提高運算速度並節省資源,這對於提高電腦系統的整體效能至關重要。深入了解GEMM的工作原理和最佳化方法,有助於我們更好地利用現代計算硬體的潛力,並為各種複雜計算任務提供更有效率的解決方案。透過對GEMM性能的優

华为乾崑 ADS3.0 智驾系统 8 月上市 享界 S9 首发搭载

Jul 30, 2024 pm 02:17 PM

华为乾崑 ADS3.0 智驾系统 8 月上市 享界 S9 首发搭载

Jul 30, 2024 pm 02:17 PM

7月29日,在AITO问界第四十万台新车下线仪式上,华为常务董事、终端BG董事长、智能汽车解决方案BU董事长余承东出席发表演讲并宣布,问界系列车型将于今年8月迎来华为乾崑ADS3.0版本的上市,并计划在8月至9月间陆续推送升级。8月6日即将发布的享界S9将首发华为ADS3.0智能驾驶系统。华为乾崑ADS3.0版本在激光雷达的辅助下,将大幅提升智驾能力,具备融合端到端的能力,并采用GOD(通用障碍物识别)/PDP(预测决策规控)全新端到端架构,提供车位到车位智驾领航NCA功能,并升级CAS3.0全

蘋果16系統哪個版本最好

Mar 08, 2024 pm 05:16 PM

蘋果16系統哪個版本最好

Mar 08, 2024 pm 05:16 PM

蘋果16系統中版本最好的是iOS16.1.4,iOS16系統的最佳版本可能因人而異添加和日常使用體驗的提升也受到了很多用戶的好評。蘋果16系統哪個版本最好答:iOS16.1.4iOS16系統的最佳版本可能因人而異。根據公開的消息,2022年推出的iOS16被認為是一個非常穩定且性能優越的版本,用戶對其整體體驗也相當滿意。此外,iOS16中新功能的新增和日常使用體驗的提升也受到了許多用戶的好評。特別是在更新後的電池續航力、訊號表現和發熱控制方面,使用者的回饋都比較正面。然而,考慮到iPhone14

常用常新!華為Mate60系列升級HarmonyOS 4.2:AI雲端增強、小藝方言太好用了

Jun 02, 2024 pm 02:58 PM

常用常新!華為Mate60系列升級HarmonyOS 4.2:AI雲端增強、小藝方言太好用了

Jun 02, 2024 pm 02:58 PM

4月11日,華為官方首次宣布HarmonyOS4.2百機升級計劃,此次共有180餘款設備參與升級,品類覆蓋手機、平板、手錶、耳機、智慧螢幕等設備。過去一個月,隨著HarmonyOS4.2百機升級計畫的穩定推進,包括華為Pocket2、華為MateX5系列、nova12系列、華為Pura系列等多款熱門機型也已紛紛展開升級適配,這意味著會有更多華為機型用戶享受到HarmonyOS帶來的常用常新體驗。從使用者回饋來看,華為Mate60系列機種在升級HarmonyOS4.2之後,體驗全方位躍升。尤其是華為M

電腦作業系統有哪些

Jan 12, 2024 pm 03:12 PM

電腦作業系統有哪些

Jan 12, 2024 pm 03:12 PM

電腦作業系統就是用來管理電腦硬體和軟體程式的系統,同時也是根據所有軟體系統去開發的作業系統程序,而不同的作業系統,對應的使用人群也是不同的,那麼電腦系統有哪些呢?下面,小編跟大家分享電腦作業系統有哪些。所謂的作業系統就是管理電腦硬體與軟體程序,所有的軟體都是基於作業系統程式的基礎上去開發的。其實作業系統種類是很多的,用工業用的,商業用的,個人用的,涉及的範圍很廣。下面,小編跟大家講解電腦作業系統有哪些。電腦作業系統有哪些windows系統Windows系統是美國微軟公司所開發的作業系統。比最

Linux與Windows系統中cmd指令的差異與相似之處

Mar 15, 2024 am 08:12 AM

Linux與Windows系統中cmd指令的差異與相似之處

Mar 15, 2024 am 08:12 AM

Linux和Windows是兩種常見的作業系統,分別代表了開源的Linux系統和商業的Windows系統。在這兩種作業系統中,都存在著命令列介面,用於使用者與作業系統互動。在Linux系統中,使用者使用的是Shell命令列,而在Windows系統中,使用者使用的是cmd命令列。 Linux系統中的Shell命令列是一個非常強大的工具,可以完成幾乎所有的系統管理任

Oracle資料庫中修改系統日期方法詳解

Mar 09, 2024 am 10:21 AM

Oracle資料庫中修改系統日期方法詳解

Mar 09, 2024 am 10:21 AM

Oracle資料庫中修改系統日期方法詳解在Oracle資料庫中,修改系統日期的方法主要涉及修改NLS_DATE_FORMAT參數和使用SYSDATE函數。本文將詳細介紹這兩種方法及其具體的程式碼範例,幫助讀者更好地理解並掌握在Oracle資料庫中修改系統日期的操作。一、修改NLS_DATE_FORMAT參數方法NLS_DATE_FORMAT是Oracle數據

系統字體儲存路徑在哪裡

Feb 19, 2024 pm 09:11 PM

系統字體儲存路徑在哪裡

Feb 19, 2024 pm 09:11 PM

系統字體在哪個資料夾在現代的電腦系統中,字體起著至關重要的作用,它影響著我們的閱讀體驗和文字表達的美觀程度。而對於一些熱衷於個人化設定和自訂的使用者來說,了解系統字體的儲存位置就顯得尤為重要。那麼,系統字體究竟會保存在哪個資料夾呢?本文將為大家一一揭曉。在Windows作業系統中,系統字型存放在一個名為「Fonts」的資料夾裡。這個資料夾預設位於C碟的Win