不走Transformer尋常路,魔改RNN的國產新架構RWKV,有了新進展:

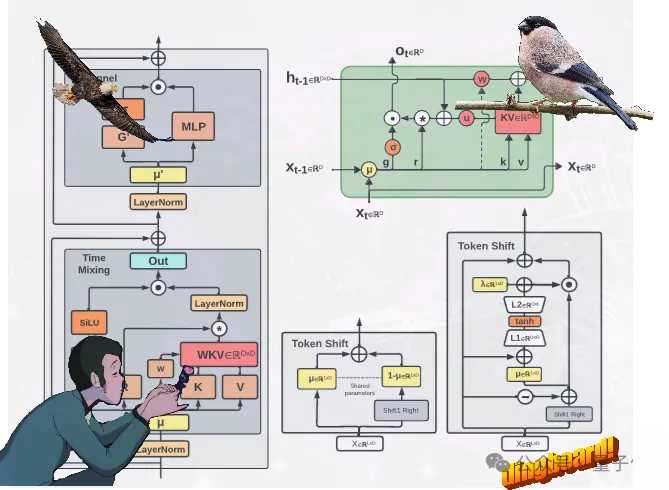

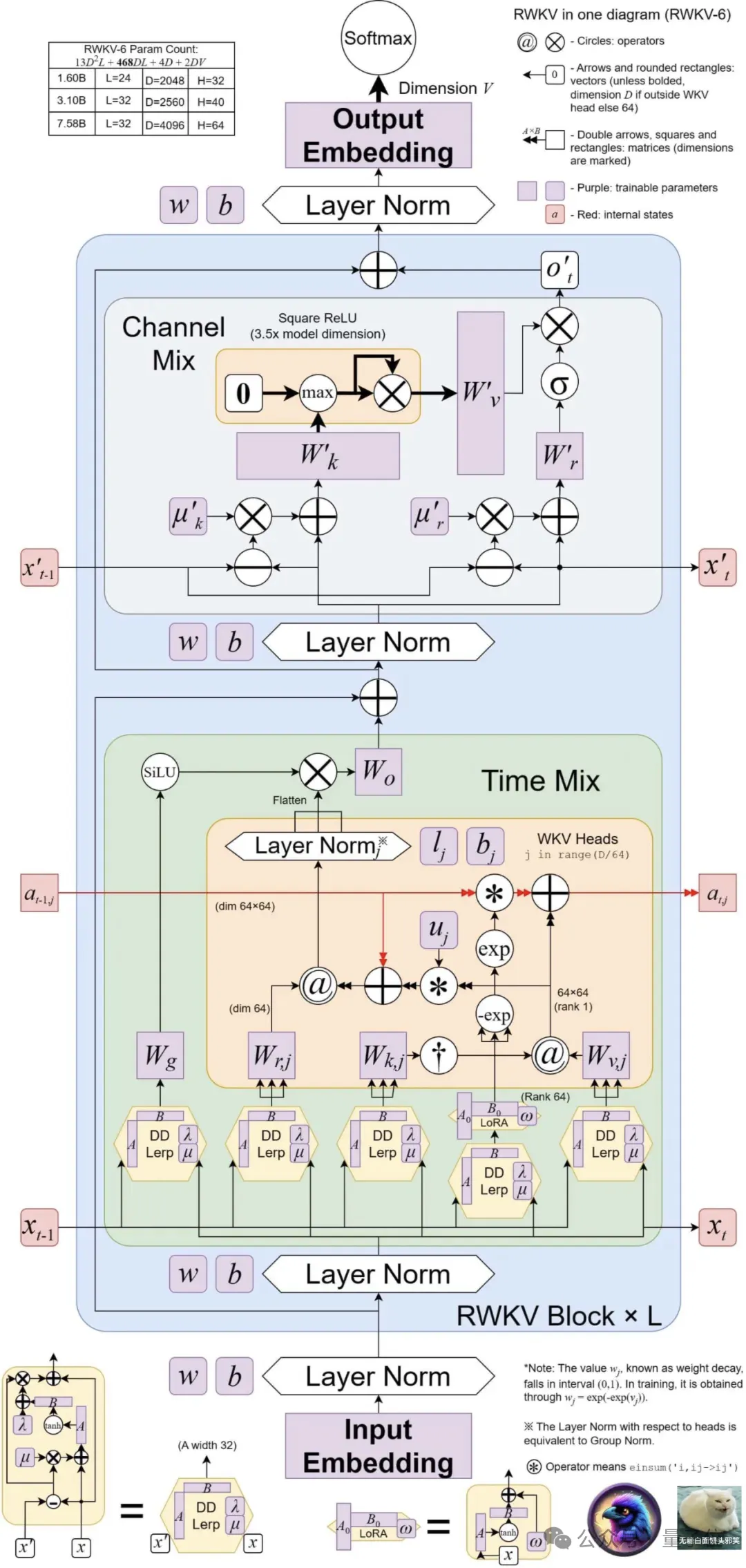

提出了兩種新的RWKV架構,即Eagle (RWKV-5) 和#Finch(RWKV-6)。

這兩種序列模型以RWKV-4架構為基礎,然後作了改進。

新架構的設計進展包括多頭矩陣值狀態(multi-headed matrix-valued states)和動態遞歸機制 (dynamic recurrence mechanism),這些改進提高了RWKV模型的表達能力,同時保持RNN的推理效率特徵。

同時,新架構引進了一個新的多語言語料庫,包含1.12兆個令牌。

團隊也基於貪婪匹配(greedy matching)開發了一個快速的分詞器,以增強RWKV的多語言性。

目前,4個Eagle模型和2個Finch模型,都已經在抱抱臉上發布了~

這次更新的RWKV,共包含6個模型,分別是:

4個Eagle(RWKV-5)模型#:分別為0.4B、1.5B、3B、7B參數大小;

2個Finch(RWKV-6)模型#:分別是1.6B、3B參數大小。

Eagle透過使用多頭矩陣值狀態(而非向量值狀態)、重新建構的接受態和額外的門控機制,改善了從RWKV-4中學習到的架構和學習衰減進度。

Finch則透過引入新的資料相關函數,進一步改進架構的表現能力和靈活性,用於時間混合和令牌移位模組,包括參數化線性插值。

此外,Finch提出了對低秩自適應函數的新用法,以使可訓練的權重矩陣能夠以一種上下文相關的方式有效地增強學習到的資料衰減向量。

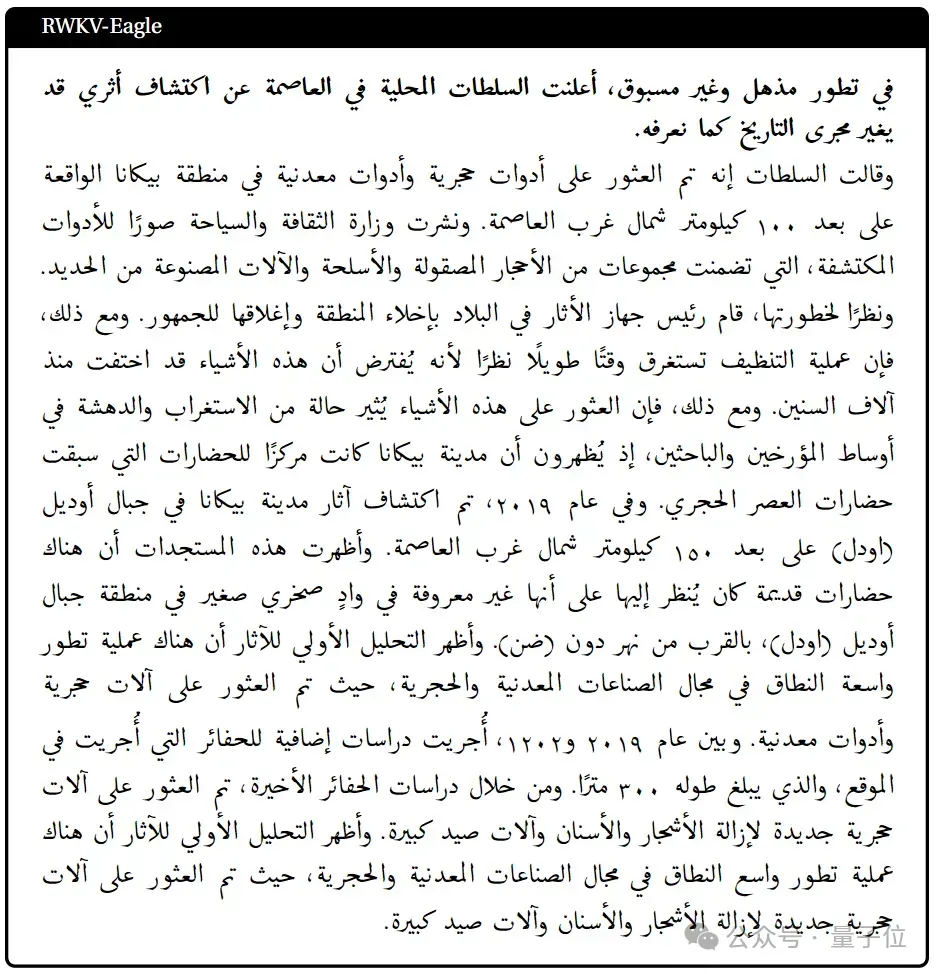

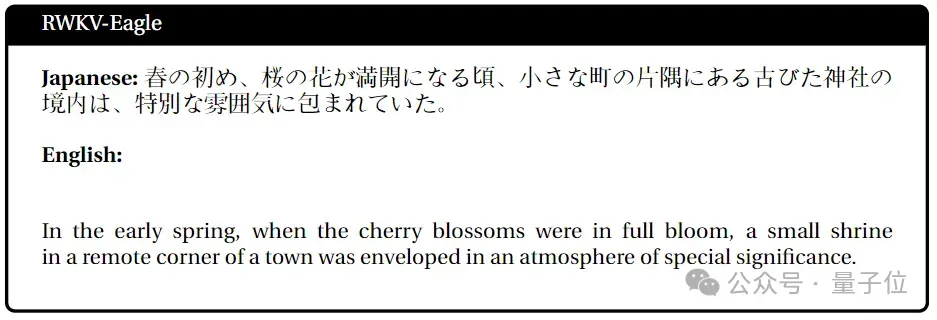

最後,RWKV新架構引入了一種新的分詞器RWKV World Tokenizer,和一個新資料集RWKV World v2,兩者皆用於提高RWKV模型在多語言和程式碼資料上的效能。

其中的新分詞器RWKV World Tokenizer包含不常見語言的詞彙,並且透過基於Trie的貪婪匹配(greedy matching)進行快速分詞。

而新資料集RWKV World v2是一個新的多語言1.12T tokens資料集,取自各種手動選擇的公開可用資料來源。

其數據組成中,約70%是英語數據,15%是多語言數據,15%是程式碼數據。

光有架構創新還不夠,關鍵要看模型的實際表現。

來看看新模型在各大權威評測榜單上的成績-

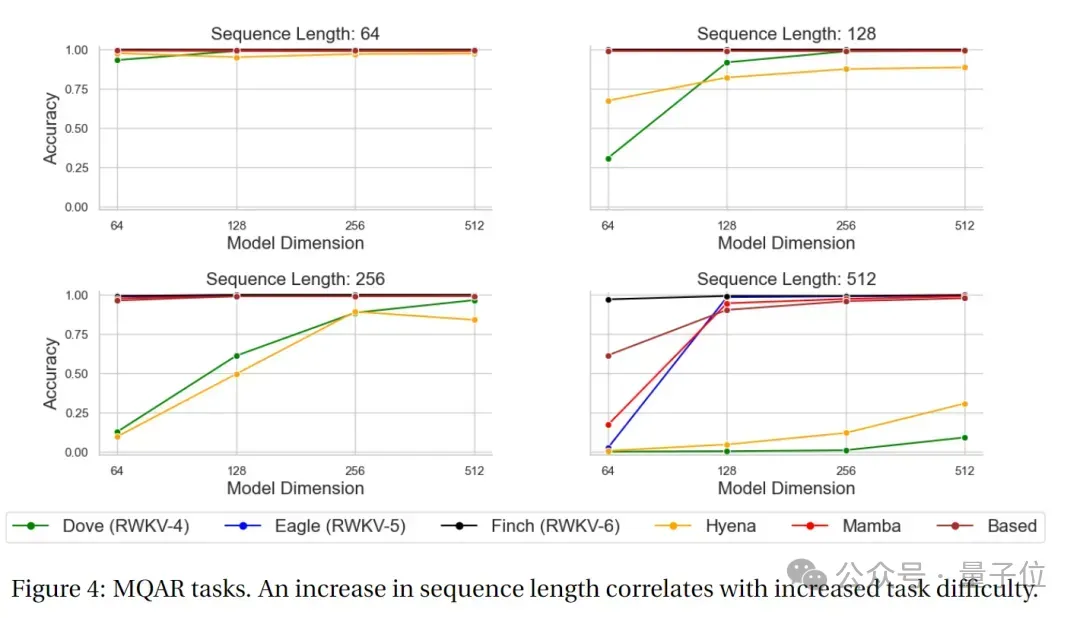

MQAR (Multiple Query Associative Recall)任務是一種用於評估語言模型的任務,旨在測試模型在多次查詢情況下的聯想記憶能力。

在這類任務中,模型需要透過給定的多個查詢來檢索相關的資訊。

MQAR任務的目標是衡量模型在多次查詢下檢索資訊的能力,以及其對不同查詢的適應性和準確性。

下圖為RWKV-4、Eagle、 Finch和其他非Transformer架構的MQAR任務測試結果。

可以看出,在MQAR任務的準確度測試中, Finch在多種序列長度測試中的準確度表現都非常穩定,對比RWKV-4、RWKV -5和其他非Transformer架構的模型有顯著的效能優勢。

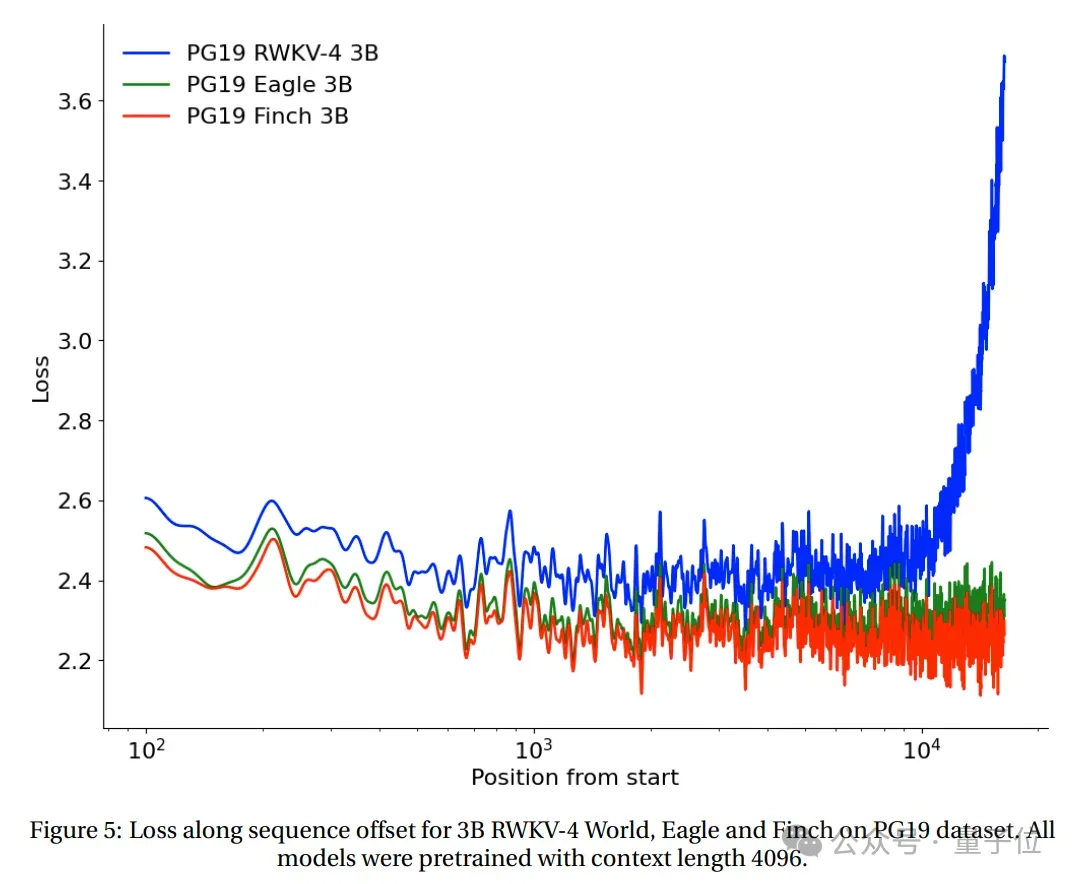

在PG19測試集上測試了從2048 tokens開始的RWKV-4、Eagle和Finch的loss與序列位置。

(所有模型均基於上下文長度4096進行預訓練)。

測試結果顯示, Eagle在長序列任務上比RWKV-4有了顯著的改進,而在上下文長度4096訓練的Finch的表現比Eagle更好,可以良好地自動適應到20000以上的上下文長度。

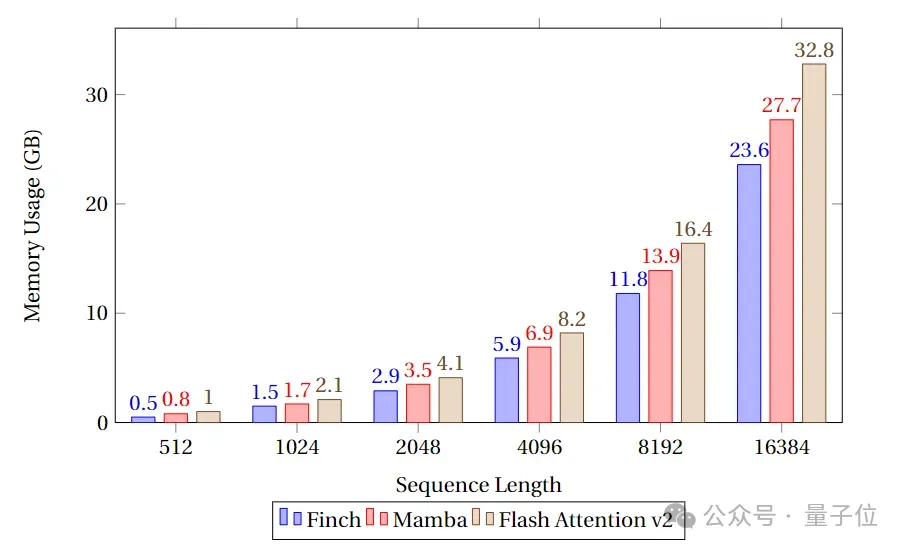

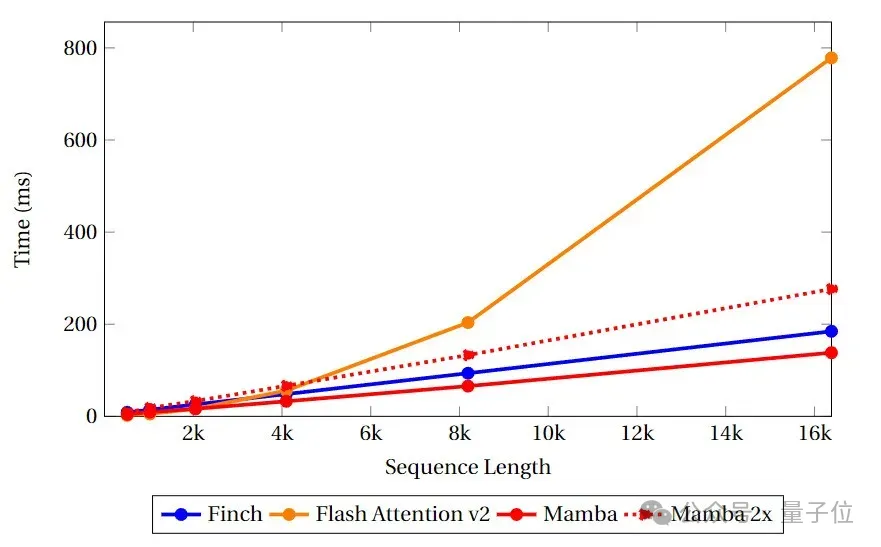

速度和記憶體基準測試中,團隊比較了Finch、Mamba和Flash Attention的類Attention核心的速度和顯存利用率。

可以看到,Finch在記憶體使用方面總是優於Mamba和Flash Attention,而記憶體使用量分別比Flash Attention和Mamba少40%和17 %。

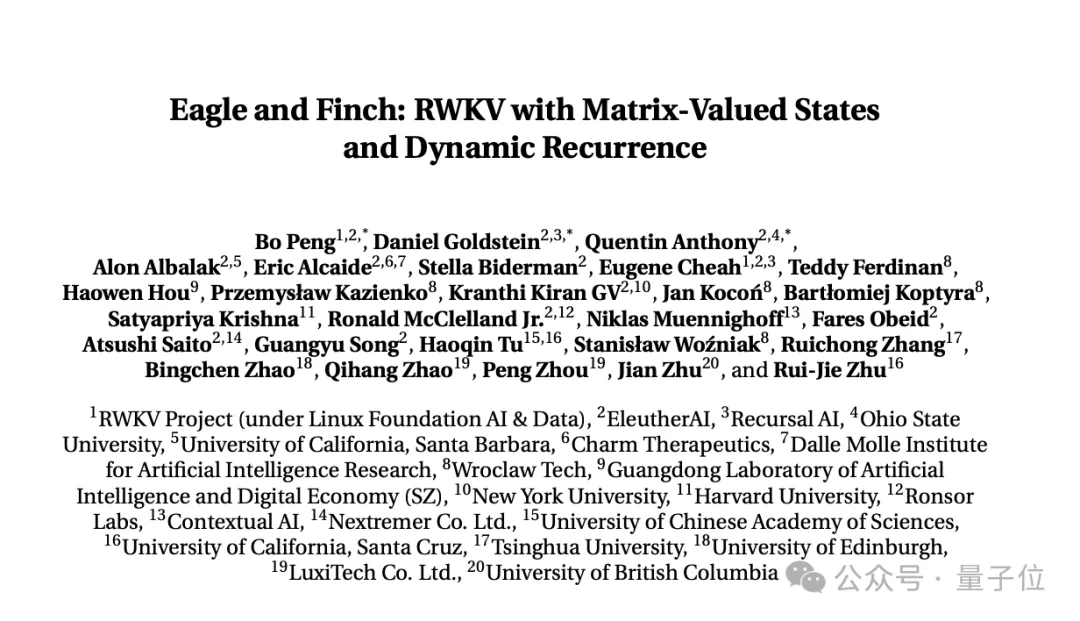

以上研究內容,來自RWKV Foundation發布的最新論文《Eagle and Finch:RWKV with Matrix-Valued States and Dynamic Recurrence》。

論文由RWKV創辦人Bo PENG(彭博)和RWKV開源社群成員共同完成。

共同一作彭博,畢業於香港大學物理系,程式設計經驗20 年,曾在世界最大外匯對沖基金之一Ortus Capital就職,負責高頻量化交易。

也曾出版一本關於深度卷積網絡的書《深度卷積網絡·原理與實踐》。

他的主要關注和興趣方向在軟硬體開發方面,在先前的公開訪談中,他曾明確表示AIGC是自己的興趣所在,尤其是小說生成。

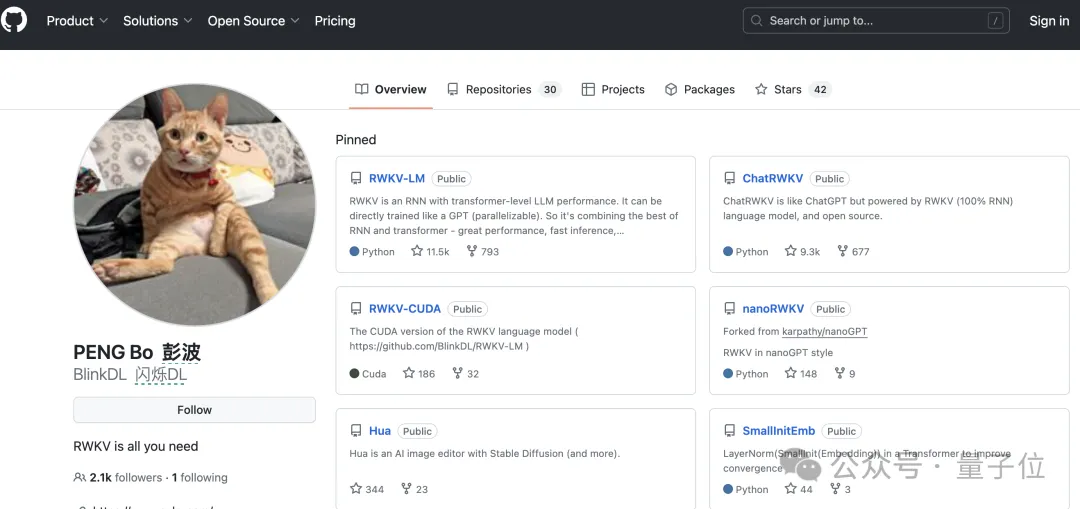

目前,彭博在Github有2.1k的followers。

但他最主要的公開身分是燈具公司禀臨科技的共同創辦人,主要是做陽光燈、吸頂燈、便攜檯燈什麼的。

並且其人應該是個喵星人資深愛好者,Github、知乎、微信頭像,以及燈具公司的官網首頁、微博上,都有一隻橘貓的身影。

量子位元獲悉,RWKV目前的多模態工作包含RWKV Music(音樂方向)和VisualRWKV(影像方向)。

接下來,RWKV的重點工作將放在以下幾個方向:

論文連結:

https://arxiv.org/pdf/2404.05892.pdf

以上是魔改RNN挑戰Transformer,RWKV上新:推出兩款新架構模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!