Meta無限長文本大模型來了:參數僅7B,已開源

Google之後,Meta 也來卷無限長上下文。

Transformers的二次複雜度和弱長度外推限制了它們擴展到長序列的能力,雖然存在線性注意力力和狀態空間模型等次二次解決方案,但從以往經驗來看,它們在預訓練效率和下游任務準確性方面表現不佳。

近日,Google提出的Infini-Transformer引入了有效方法,可以將基於Transformer的大型語言模型(LLM)擴展到無限長輸入,而不增加儲存和運算需求,吸引了人們的注意。

幾乎就在同時,Meta 也提出了一種無限長文字技術。

論文網址:https://arxiv.org/pdf/2404.08801.pdf

論文標題:MEGALODON: Efficient LLM Pretraining and Inference with Unlimited Context Length

從技術上講,MEGA 中的 EMA 子層有助於捕獲每個 token 附近的本地上下文信息,從而緩解了在超出塊邊界的上下文中丟失信息的問題。儘管 MEGA 取得了令人深刻的印象,但面臨以下問題:

i)由於 MEGA 中 EMA 子層的表達能力有限,具有塊級注意力的 MEGA 性能仍然落後於全注意力 MEGA。

ii) 對於不同的任務、資料類型,最終的 MEGA 架構可能有架構差異,例如,不同的歸一化層、歸一化模式和注意力函數 f (・) 。

iii) 沒有實證顯示 MEGA 可擴展用於大規模預訓練。

CEMA:將多維阻尼EMA 擴展到複數域

為了解決MEGA 面臨的問題,該研究提出了MEGALODON。

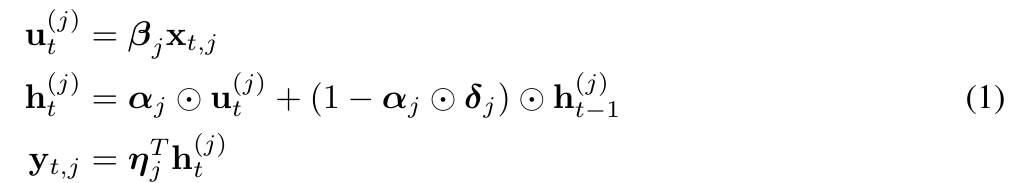

具體而言,他們創造性地提出了複指數移動平均CEMA( complex exponential moving average ),將上式(1)改寫為如下形式:

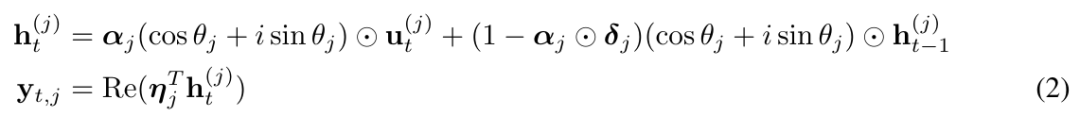

#並將(2)中的θ_j 參數化為:

#時間步(Timestep)歸一化

儘管層歸一化與Transformer 結合的性能令人印象深刻,但很明顯,層歸一化不能直接減少沿空間維度(也稱為時間步長或序列維度)的內部協變量偏移。

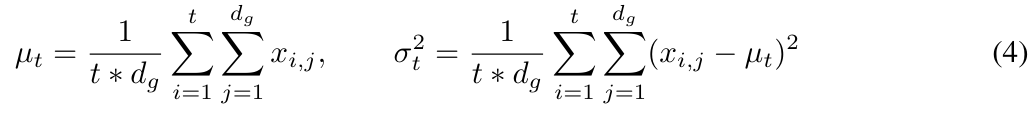

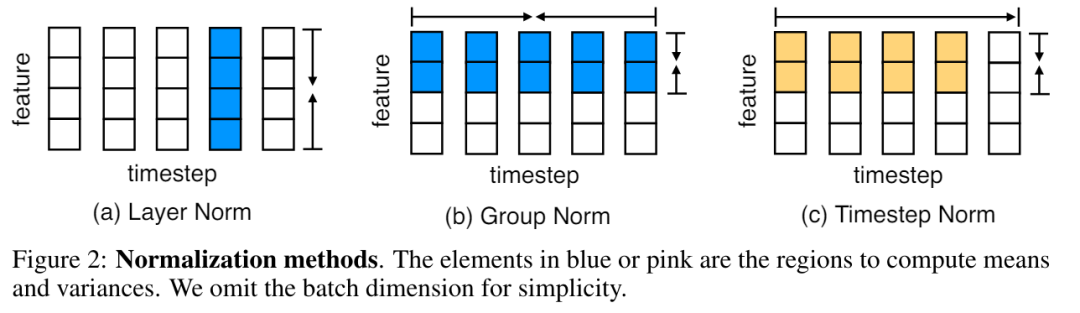

在 MEGALODON 中,該研究透過計算累積平均值和變異數將組別歸一化擴展到自迴歸情況。

圖 2 說明了層歸一化和時間步標準化。

MEGALODON 中的歸一化注意力

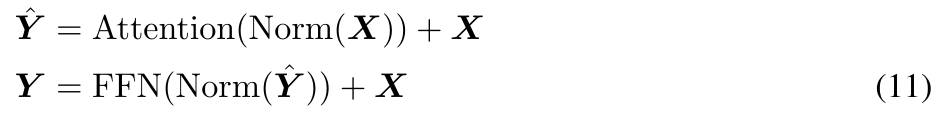

此外,研究還提出了專門為MEGA 定制的歸一化注意力機制,以提高其穩定性。形式如下:

則上式(17) 中的注意力運算改為:

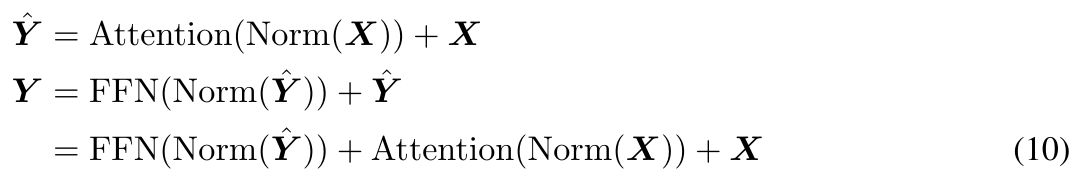

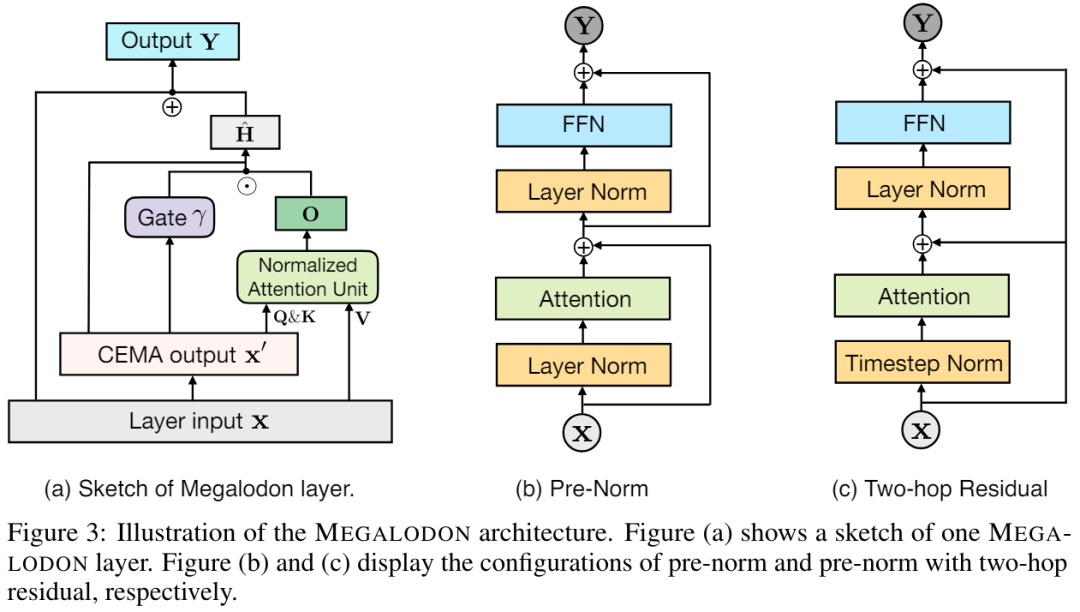

##具有Two-hop 殘差的預範數(Pre-Norm)

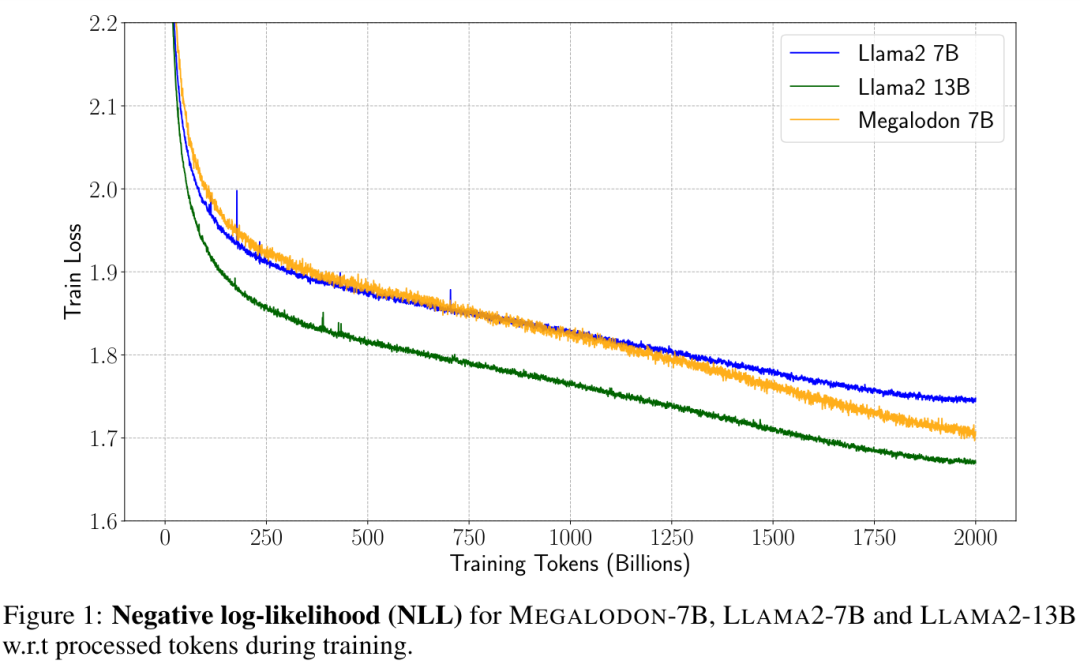

透過調查發現,擴大模型大小會造成預歸一化不穩定問題。基於Transformer 區塊的預歸一化可以表示為(如圖3 (b) 所示):

實驗

#為了評估MEGALODON 在長上下文序列建模上的可擴展性和效率,本文將MEGALODON 擴展到70 億規模大小。LLM 預訓練

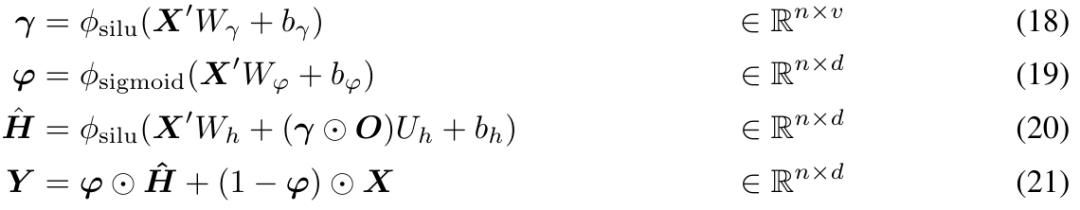

為了提高資料效率,研究者在訓練過程中顯示了MEGALODON-7B、LLAMA2-7B 和LLAMA2-13B 的負對數似然(NLL),如圖1 所示。 在相同數量的訓練 token 下,MEGALODON-7B 獲得了比 LLAMA2-7B 明顯更好(更低)的 NLL,表現出更好的數據效率。

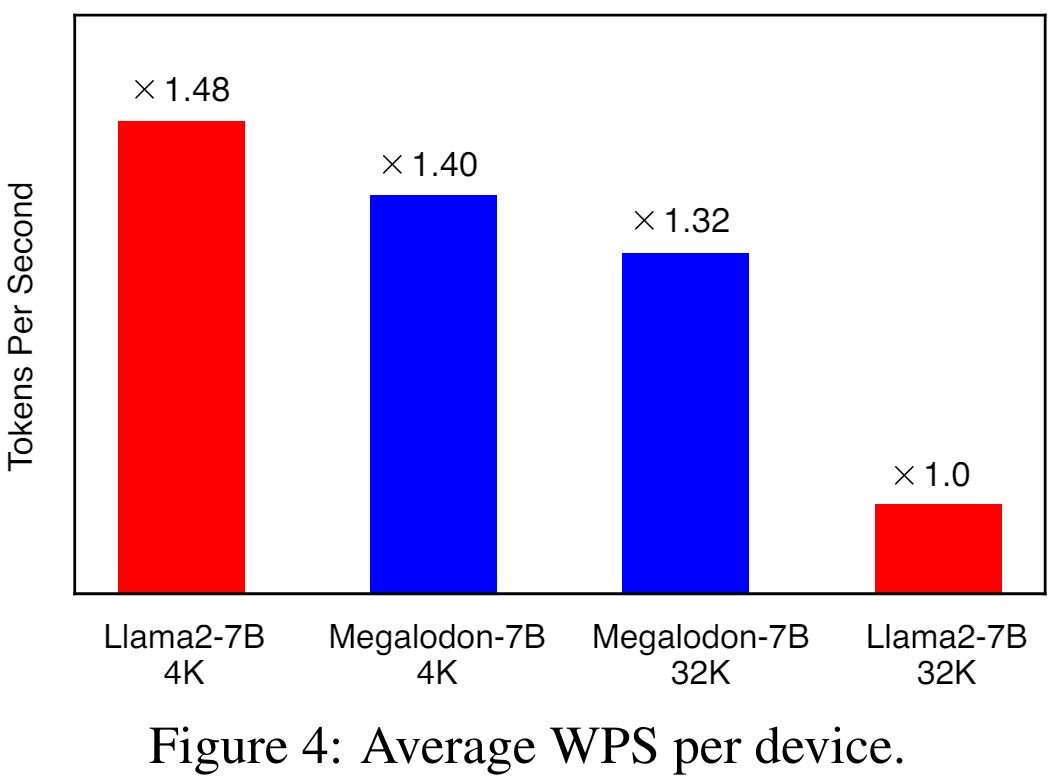

圖 4 說明了分別使用 4K 和 32K 上下文長度的 LLAMA2-7B 和 MEGALODON-7B 在每個裝置上的平均 WPS( word/token per second )。對於 LLAMA2 模型,研究使用 Flash-Attention V2 加速全注意力的計算。在 4K 上下文長度下,由於引入了 CEMA 和時間步歸一化,MEGALODON-7B 比 LLAMA2-7B 稍慢(約 6%)。當將上下文長度擴展到 32K 時,MEGALODON-7B 明顯比 LLAMA2-7B 快(約 32%),這證明了 MEGALODON 對於長上下文預訓練的計算效率。

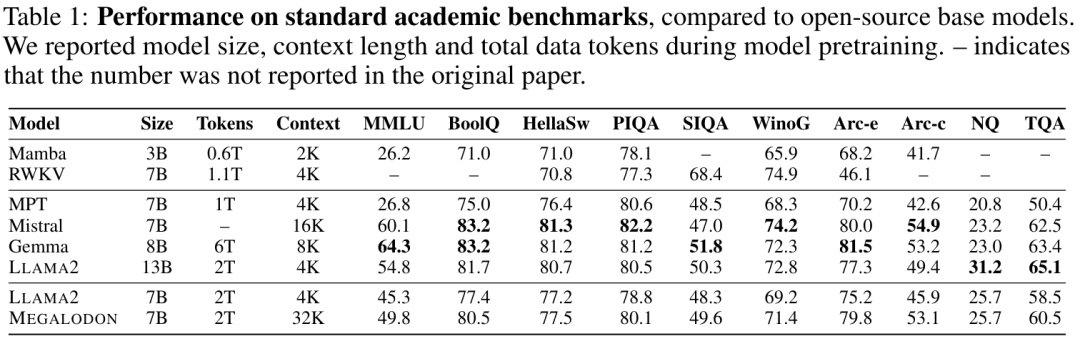

短上下文評估

表1 總結了MEGALODON 和LLAMA2 在學術基準上的結果,以及其他開源基礎模型,包括MPT、RWKV 、Mamba 、 Mistral 和Gemma 的比較結果。在相同的 2T token 上進行預訓練後,MEGALODON-7B 在所有基準測試中均優於 LLAMA2-7B。在某些任務上,MEGALODON-7B 的表現與 LLAMA2-13B 相當甚至更好。

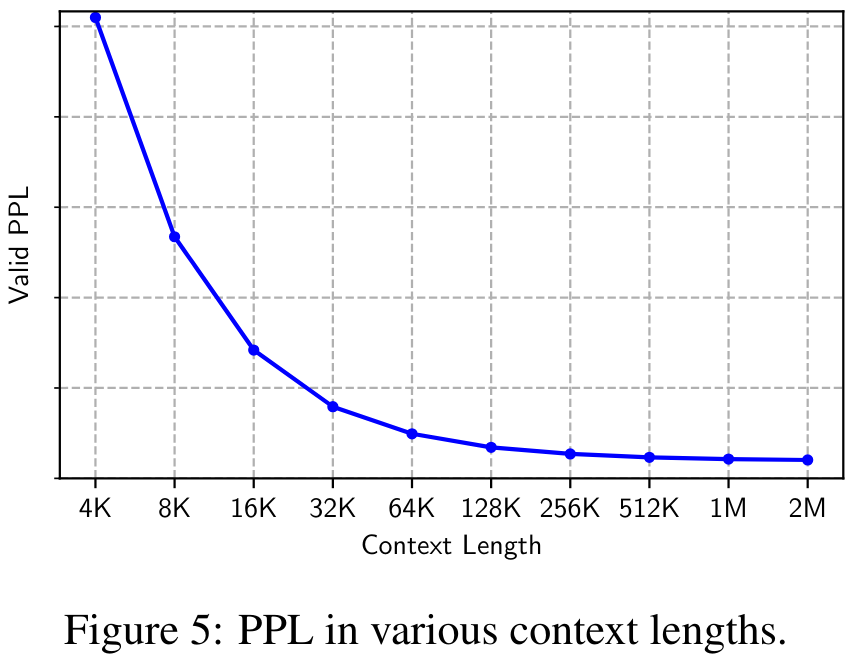

長上下文評估

#圖5 顯示了驗證資料集在4K 到2M 各種上下文長度下的困惑度( PPL)。可以觀察到 PPL 隨著上下文長度單調下降,驗證了 MEGALODON 在建模極長序列方面的有效性和穩健性。

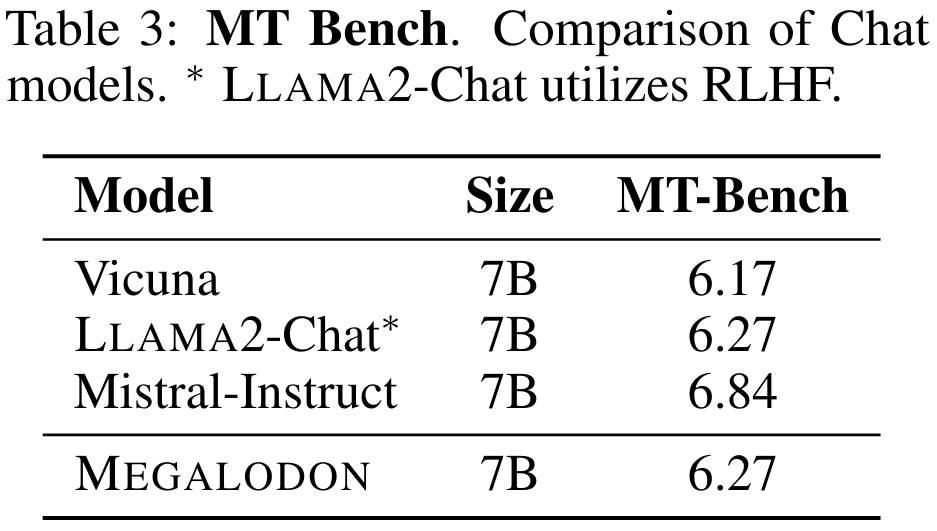

指令微調

表 3 總結了 7B 模型在 MT-Bench 上的表現。與 Vicuna 相比,MEGALODON 在 MT-Bench 上表現出優越的性能,並且與 LLAMA2-Chat 相當,而後者利用 RLHF 進行了進一步的對齊微調。

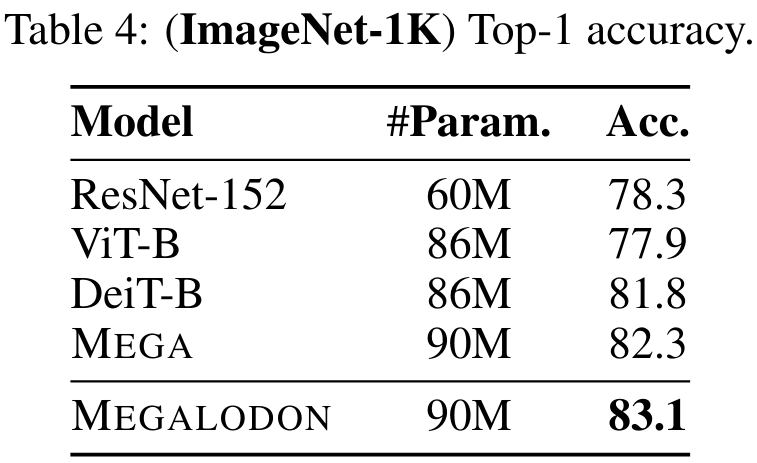

中型基準評估

為了評估MEGALODON 在影像分類任務上的效能,該研究在Imagenet-1K 資料集上進行了實驗。表 4 報告了驗證集上的 Top-1 準確率。 MEGALODON 的準確率比 DeiT-B 提高了 1.3%,比 MEGA 提高了 0.8%。

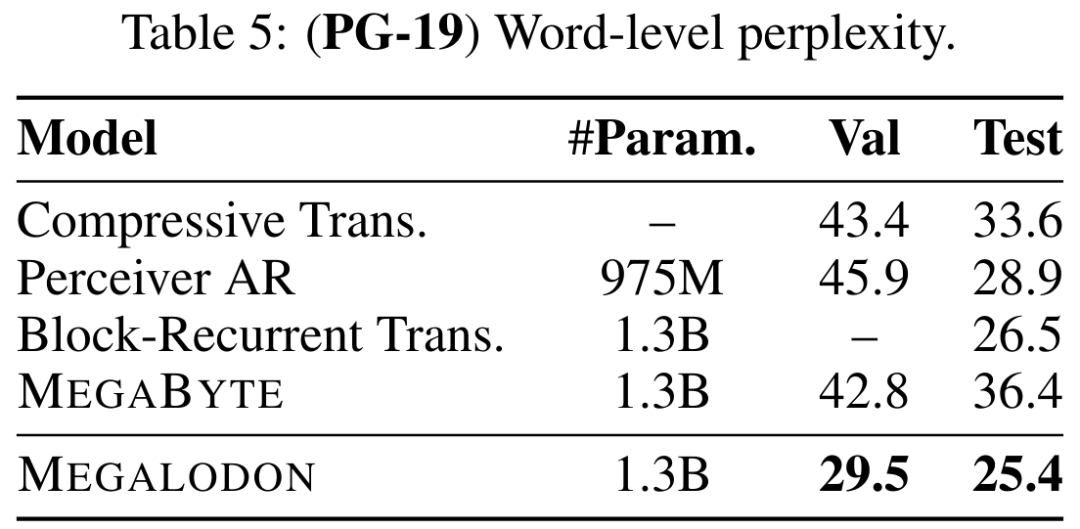

表5 說明了MEGALODON 在PG-19 上的字級困惑度(PPL),以及與先前最先進的模型,包括Compressive Transformer 、Perceiver AR、Perceiver AR、區塊循環Transformer 和MEGABYTE 等的比較。 MEGALODON 性能明顯領先。

更詳細內容請參考論文原文。

以上是Meta無限長文本大模型來了:參數僅7B,已開源的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

wordpress文章列表怎麼調

Apr 20, 2025 am 10:48 AM

wordpress文章列表怎麼調

Apr 20, 2025 am 10:48 AM

有四種方法可以調整 WordPress 文章列表:使用主題選項、使用插件(如 Post Types Order、WP Post List、Boxy Stuff)、使用代碼(在 functions.php 文件中添加設置)或直接修改 WordPress 數據庫。

git怎麼下載項目到本地

Apr 17, 2025 pm 04:36 PM

git怎麼下載項目到本地

Apr 17, 2025 pm 04:36 PM

要通過 Git 下載項目到本地,請按以下步驟操作:安裝 Git。導航到項目目錄。使用以下命令克隆遠程存儲庫:git clone https://github.com/username/repository-name.git

git怎麼更新代碼

Apr 17, 2025 pm 04:45 PM

git怎麼更新代碼

Apr 17, 2025 pm 04:45 PM

更新 git 代碼的步驟:檢出代碼:git clone https://github.com/username/repo.git獲取最新更改:git fetch合併更改:git merge origin/master推送更改(可選):git push origin master

git怎麼刪除倉庫

Apr 17, 2025 pm 04:03 PM

git怎麼刪除倉庫

Apr 17, 2025 pm 04:03 PM

要刪除 Git 倉庫,請執行以下步驟:確認要刪除的倉庫。本地刪除倉庫:使用 rm -rf 命令刪除其文件夾。遠程刪除倉庫:導航到倉庫設置,找到“刪除倉庫”選項,確認操作。

git下載不動怎麼辦

Apr 17, 2025 pm 04:54 PM

git下載不動怎麼辦

Apr 17, 2025 pm 04:54 PM

解決 Git 下載速度慢時可採取以下步驟:檢查網絡連接,嘗試切換連接方式。優化 Git 配置:增加 POST 緩衝區大小(git config --global http.postBuffer 524288000)、降低低速限制(git config --global http.lowSpeedLimit 1000)。使用 Git 代理(如 git-proxy 或 git-lfs-proxy)。嘗試使用不同的 Git 客戶端(如 Sourcetree 或 Github Desktop)。檢查防火

git怎麼合併代碼

Apr 17, 2025 pm 04:39 PM

git怎麼合併代碼

Apr 17, 2025 pm 04:39 PM

Git 代碼合併過程:拉取最新更改以避免衝突。切換到要合併的分支。發起合併,指定要合併的分支。解決合併衝突(如有)。暫存和提交合併,提供提交消息。

如何解決PHP項目中的高效搜索問題? Typesense助你實現!

Apr 17, 2025 pm 08:15 PM

如何解決PHP項目中的高效搜索問題? Typesense助你實現!

Apr 17, 2025 pm 08:15 PM

在開發一個電商網站時,我遇到了一個棘手的問題:如何在大量商品數據中實現高效的搜索功能?傳統的數據庫搜索效率低下,用戶體驗不佳。經過一番研究,我發現了Typesense這個搜索引擎,並通過其官方PHP客戶端typesense/typesense-php解決了這個問題,大大提升了搜索性能。

git commit怎麼用

Apr 17, 2025 pm 03:57 PM

git commit怎麼用

Apr 17, 2025 pm 03:57 PM

Git Commit 是一種命令,將文件變更記錄到 Git 存儲庫中,以保存項目當前狀態的快照。使用方法如下:添加變更到暫存區域編寫簡潔且信息豐富的提交消息保存並退出提交消息以完成提交可選:為提交添加簽名使用 git log 查看提交內容