六年種方式快速體驗最新發布的 Llama 3!

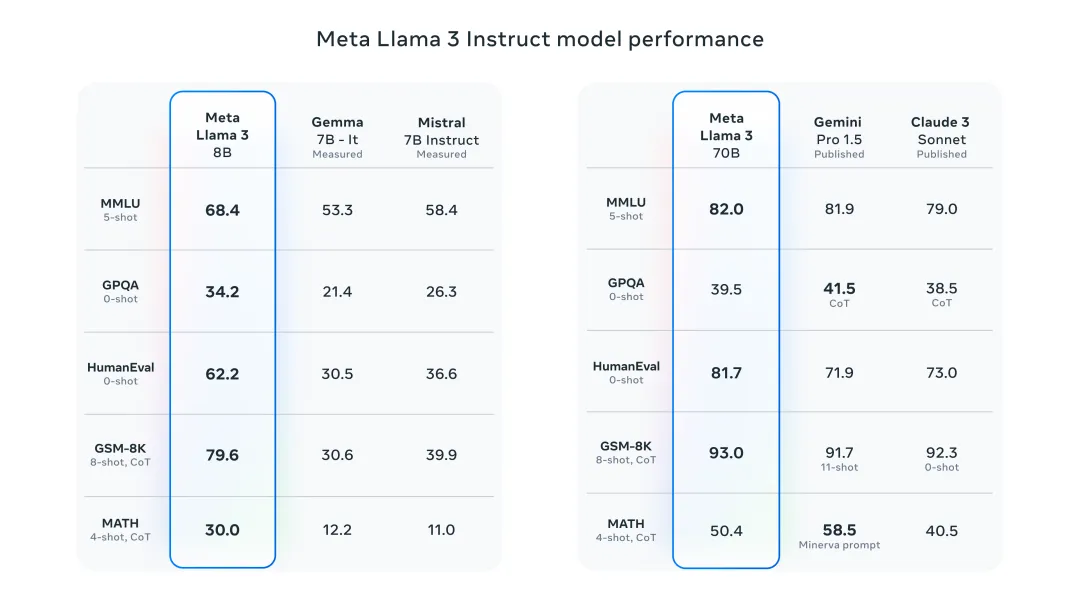

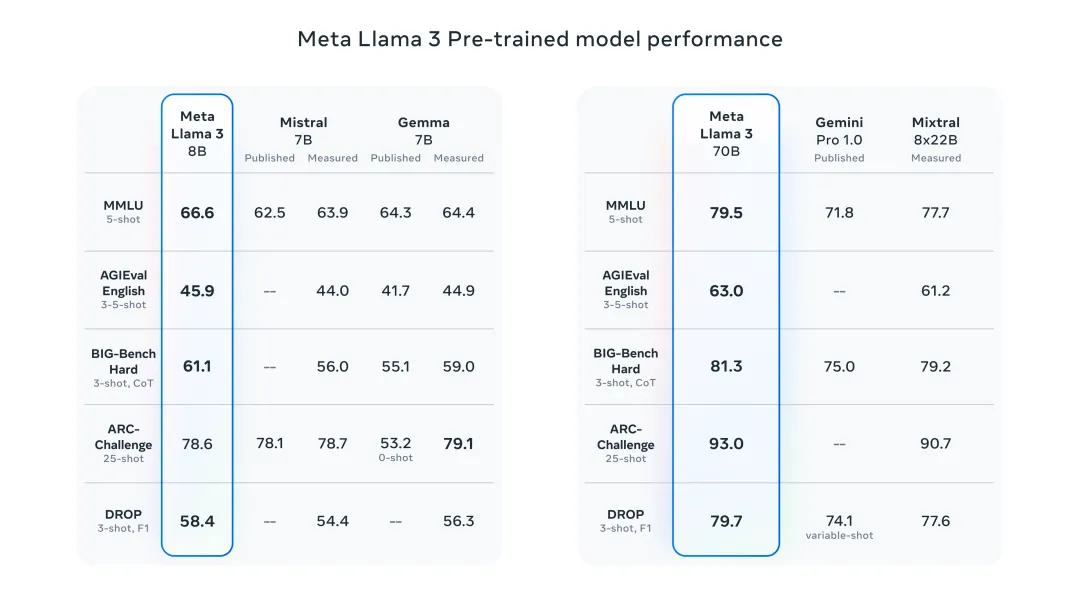

昨晚Meta發布了Llama 3 8B 和70B 模型,Llama 3 指令調整模型針對對話/聊天用例進行了微調和優化,在常見基準測試中優於許多現有的開源聊天模型。例如,Gemma 7B 和 Mistral 7B。

Llama 3模型對資料和規模進行了提升,達到了新的高度。它是在Meta最近發布的兩個客製化的24K GPU叢集上,對超過15T token的資料進行訓練的。這個訓練資料集比Llama 2大7倍,包含多4倍的程式碼。這使得Llama模型的能力達到了目前的最高水平,它支援8K以上的文字長度,是Llama 2的兩倍。

下面我將介紹 6 種方式,讓你快速體驗最新發布的 Llama 3!

線上體驗Llama 3

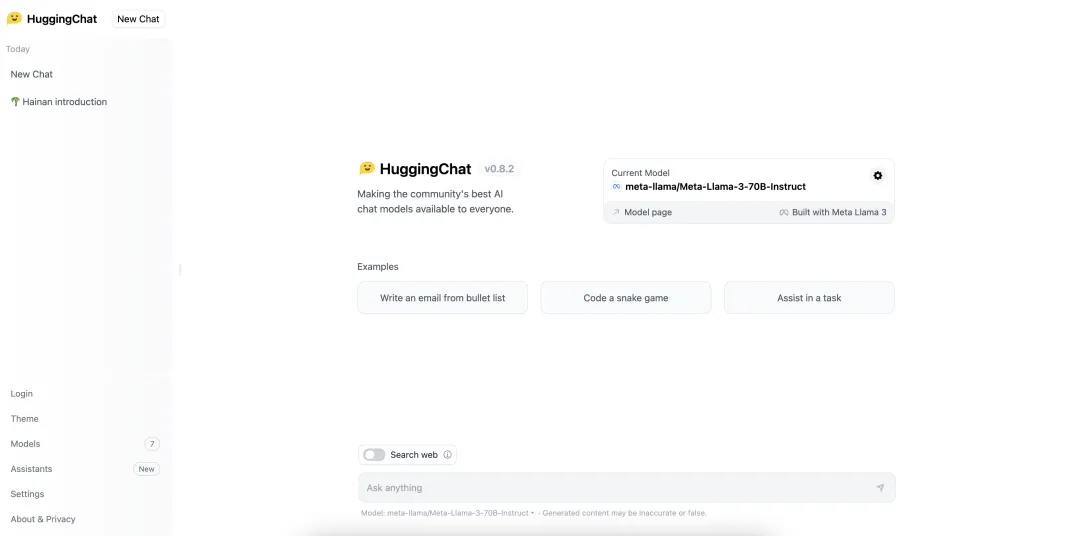

HuggingChat

llama2.ai

https://www.llama2.ai/

本地體驗Llama 3

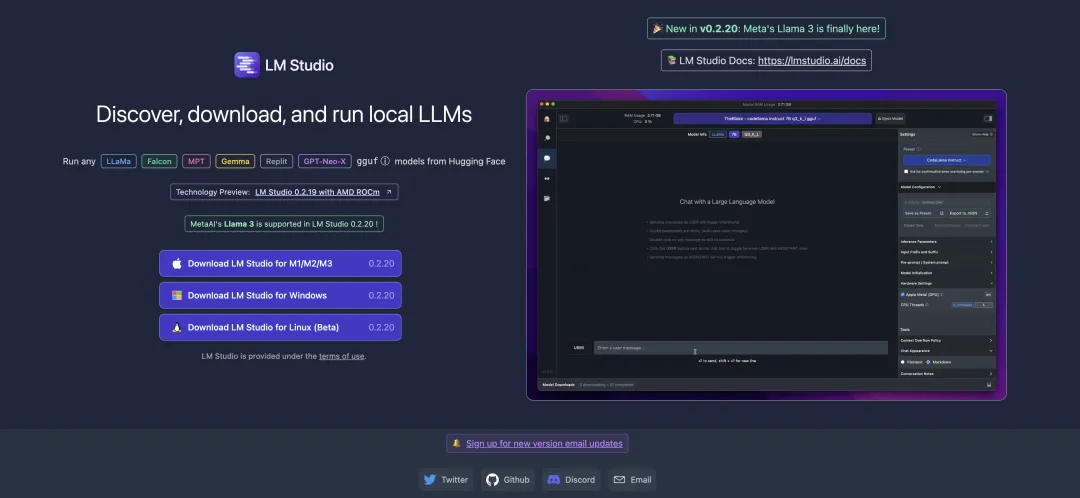

LM Studio

https://lmstudio.ai/

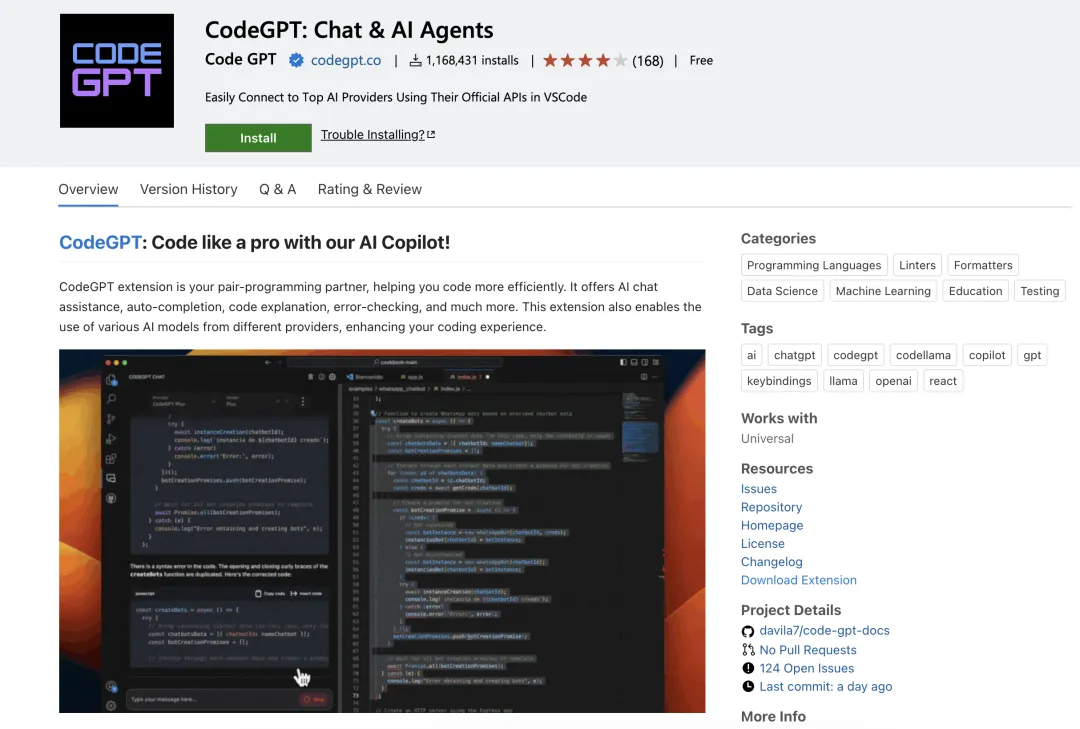

#CodeGPT

##https://marketplace.visualstudio.com/items?itemName=DanielSanMedium.dscodegpt&ssr=false

使用CodeGPT 前,記得先使用Ollama 拉取對應的模型。例如,拉取 llama3:8b 模型:ollama pull llama3:8b。如果你本地尚未安裝 ollama,可以閱讀 「部署本地的大語言模型,只需幾分鐘!」 這篇文章。

Ollama

運行Llama 3 8B 模型:

ollama run llama3

運行Llama 3 70B 模型:

ollama run llama3:70b

Open WebUI & Ollama

#https://pinokio.computer/item?uri=https:/ /github.com/cocktailpeanutlabs/open-webui。

以上是六年種方式快速體驗最新發布的 Llama 3!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

git怎麼下載項目到本地

Apr 17, 2025 pm 04:36 PM

git怎麼下載項目到本地

Apr 17, 2025 pm 04:36 PM

要通過 Git 下載項目到本地,請按以下步驟操作:安裝 Git。導航到項目目錄。使用以下命令克隆遠程存儲庫:git clone https://github.com/username/repository-name.git

git怎麼更新代碼

Apr 17, 2025 pm 04:45 PM

git怎麼更新代碼

Apr 17, 2025 pm 04:45 PM

更新 git 代碼的步驟:檢出代碼:git clone https://github.com/username/repo.git獲取最新更改:git fetch合併更改:git merge origin/master推送更改(可選):git push origin master

git怎麼更新本地代碼

Apr 17, 2025 pm 04:48 PM

git怎麼更新本地代碼

Apr 17, 2025 pm 04:48 PM

如何更新本地 Git 代碼?用 git fetch 從遠程倉庫拉取最新更改。用 git merge origin/<遠程分支名稱> 將遠程變更合併到本地分支。解決因合併產生的衝突。用 git commit -m "Merge branch <遠程分支名稱>" 提交合併更改,應用更新。

git怎麼合併代碼

Apr 17, 2025 pm 04:39 PM

git怎麼合併代碼

Apr 17, 2025 pm 04:39 PM

Git 代碼合併過程:拉取最新更改以避免衝突。切換到要合併的分支。發起合併,指定要合併的分支。解決合併衝突(如有)。暫存和提交合併,提供提交消息。

git下載不動怎麼辦

Apr 17, 2025 pm 04:54 PM

git下載不動怎麼辦

Apr 17, 2025 pm 04:54 PM

解決 Git 下載速度慢時可採取以下步驟:檢查網絡連接,嘗試切換連接方式。優化 Git 配置:增加 POST 緩衝區大小(git config --global http.postBuffer 524288000)、降低低速限制(git config --global http.lowSpeedLimit 1000)。使用 Git 代理(如 git-proxy 或 git-lfs-proxy)。嘗試使用不同的 Git 客戶端(如 Sourcetree 或 Github Desktop)。檢查防火

如何解決PHP項目中的高效搜索問題? Typesense助你實現!

Apr 17, 2025 pm 08:15 PM

如何解決PHP項目中的高效搜索問題? Typesense助你實現!

Apr 17, 2025 pm 08:15 PM

在開發一個電商網站時,我遇到了一個棘手的問題:如何在大量商品數據中實現高效的搜索功能?傳統的數據庫搜索效率低下,用戶體驗不佳。經過一番研究,我發現了Typesense這個搜索引擎,並通過其官方PHP客戶端typesense/typesense-php解決了這個問題,大大提升了搜索性能。

幣圈行情實時數據免費平台推薦前十名發布

Apr 22, 2025 am 08:12 AM

幣圈行情實時數據免費平台推薦前十名發布

Apr 22, 2025 am 08:12 AM

適合新手的加密貨幣數據平台有CoinMarketCap和非小號。 1. CoinMarketCap提供全球加密貨幣實時價格、市值、交易量排名,適合新手與基礎分析需求。 2. 非小號提供中文友好界面,適合中文用戶快速篩選低風險潛力項目。

git怎麼刪除分支

Apr 17, 2025 pm 04:42 PM

git怎麼刪除分支

Apr 17, 2025 pm 04:42 PM

可以通過以下步驟刪除 Git 分支:1. 刪除本地分支:使用 git branch -d <branch-name> 命令;2. 刪除遠程分支:使用 git push <remote-name> --delete <branch-name> 命令;3. 保護分支:使用 git config branch. <branch-name>.protected true 添加保護分支設置。