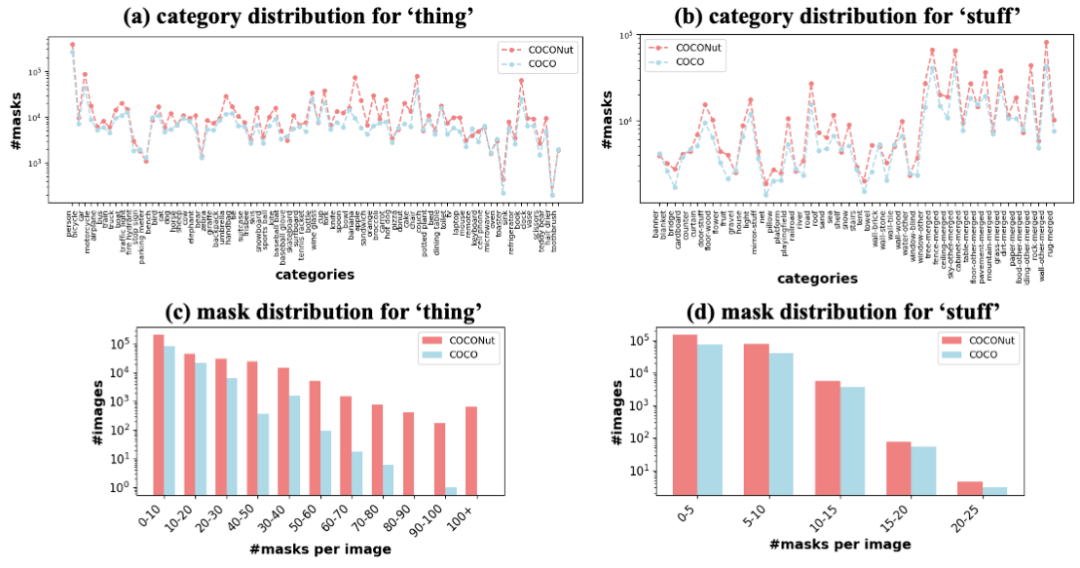

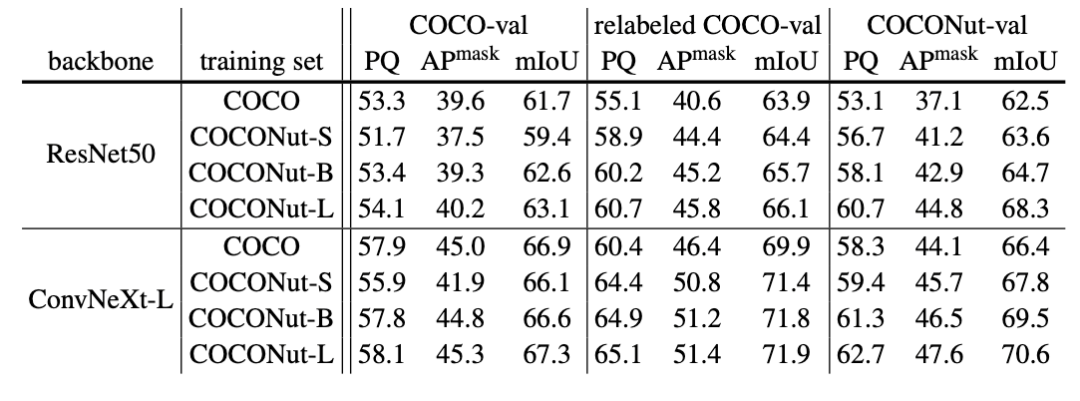

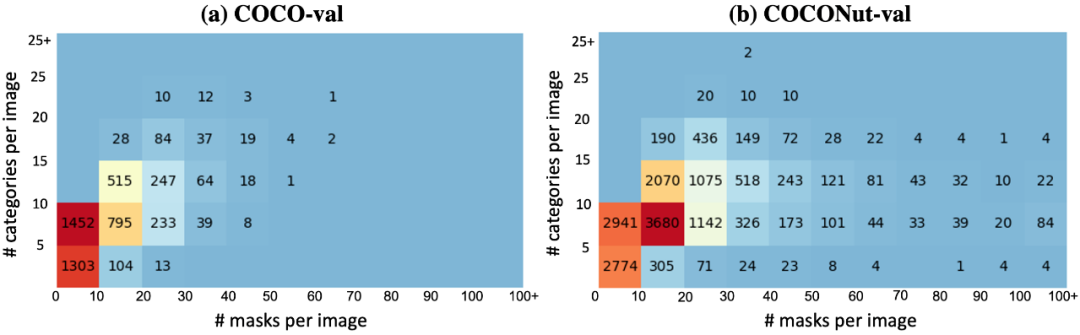

CVPR 2024 | 位元組提出新一代資料集COCONut,比COCO粒度分割更密集

AIxiv專欄是本站發布學術、技術內容的欄位。過去數年,本站AIxiv專欄接收通報了2,000多篇內容,涵蓋全球各大專院校與企業的頂尖實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或聯絡報道。投稿信箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com。

論文連結:https://arxiv.org/abs/2404.08639 程式碼與數據集連結: https://xdeng7.github.io/coconut.github.io/

以上是CVPR 2024 | 位元組提出新一代資料集COCONut,比COCO粒度分割更密集的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

h5項目怎麼運行

Apr 06, 2025 pm 12:21 PM

h5項目怎麼運行

Apr 06, 2025 pm 12:21 PM

運行 H5 項目需要以下步驟:安裝 Web 服務器、Node.js、開發工具等必要工具。搭建開發環境,創建項目文件夾、初始化項目、編寫代碼。啟動開發服務器,使用命令行運行命令。在瀏覽器中預覽項目,輸入開發服務器 URL。發布項目,優化代碼、部署項目、設置 Web 服務器配置。

Beego ORM中如何指定模型關聯的數據庫?

Apr 02, 2025 pm 03:54 PM

Beego ORM中如何指定模型關聯的數據庫?

Apr 02, 2025 pm 03:54 PM

在BeegoORM框架下,如何指定模型關聯的數據庫?許多Beego項目需要同時操作多個數據庫。當使用Beego...

Gitee Pages靜態網站部署失敗:單個文件404錯誤如何排查和解決?

Apr 04, 2025 pm 11:54 PM

Gitee Pages靜態網站部署失敗:單個文件404錯誤如何排查和解決?

Apr 04, 2025 pm 11:54 PM

GiteePages靜態網站部署失敗:404錯誤排查與解決在使用Gitee...

Go語言中哪些庫是由大公司開發或知名的開源項目提供的?

Apr 02, 2025 pm 04:12 PM

Go語言中哪些庫是由大公司開發或知名的開源項目提供的?

Apr 02, 2025 pm 04:12 PM

Go語言中哪些庫是大公司開發或知名開源項目?在使用Go語言進行編程時,開發者常常會遇到一些常見的需求,�...

在Go語言中使用Redis Stream實現消息隊列時,如何解決user_id類型轉換問題?

Apr 02, 2025 pm 04:54 PM

在Go語言中使用Redis Stream實現消息隊列時,如何解決user_id類型轉換問題?

Apr 02, 2025 pm 04:54 PM

Go語言中使用RedisStream實現消息隊列時類型轉換問題在使用Go語言與Redis...

H5頁面製作是否需要持續維護

Apr 05, 2025 pm 11:27 PM

H5頁面製作是否需要持續維護

Apr 05, 2025 pm 11:27 PM

H5頁面需要持續維護,這是因為代碼漏洞、瀏覽器兼容性、性能優化、安全更新和用戶體驗提升等因素。有效維護的方法包括建立完善的測試體系、使用版本控制工具、定期監控頁面性能、收集用戶反饋和製定維護計劃。

xml怎麼轉換成excel

Apr 03, 2025 am 08:54 AM

xml怎麼轉換成excel

Apr 03, 2025 am 08:54 AM

有兩種方法將 XML 轉換為 Excel:使用 Excel 內置功能或第三方工具。第三方工具包括 XML to Excel 轉換器、XML2Excel 和 XML Candy。

在Go編程中,如何正確管理Mysql和Redis的連接與釋放資源?

Apr 02, 2025 pm 05:03 PM

在Go編程中,如何正確管理Mysql和Redis的連接與釋放資源?

Apr 02, 2025 pm 05:03 PM

Go編程中的資源管理:Mysql和Redis的連接與釋放在學習Go編程過程中,如何正確管理資源,特別是與數據庫和緩存�...