4個月用戶成長20倍,這家遊戲開黑平台怎麼做到的?

騰訊雲端技術支援的遊戲語音平台Oopz正在快速成長。 4月24日,Oopz宣布上線4個月用戶規模成長了20倍,日活用戶突破10萬,成為遊戲開黑賽道的一匹黑馬。 Oopz於2023年12月開放公測。憑藉騰訊雲端即時音訊視訊TRTC的技術支持,快速獲得了遊戲玩家的青睞,為超過10萬日活用戶打造了流暢沉浸的遊戲體驗。

Oopz是一款集語音開黑、社群交友、AI聊天於一體的遊戲語音軟體。在開黑過程中,玩家自主設立的遊戲域(房間)支援100人同時開麥,介面內24小時在線的AI聊天機器人Chatbot,能高效回答各類問題。為了持續提升使用者體驗,Oopz 設立了多通路平台,使用者可在各平台與Oopz官方直接1v1對話,在產品與功能層面打造使用者共創模式。

對於遊戲玩家來說,開黑過程中如果遇到噪音幹擾、延遲、音質不佳、掉幀、卡頓等狀況,遊戲體驗會大打折扣。為了從根源解決遊戲玩家痛點,Oopz聯合騰訊雲一起,結合遊戲玩家對於語音的實際需求,共同推動遊戲語音體驗邁向新高度。

首先,不掉幀、穩定在線,是遊戲玩家開黑的前提。騰訊雲端TRTC透過雲端處理、高效編解碼技術和自適應碼率調整等技術手段,對CPU和記憶體資源的精細化管理,將語音處理任務高效分散至系統空閒時段,避免佔用遊戲關鍵時刻的運算資源,使得Oopz語音通訊能夠在不影響遊戲效能的前提下穩定運作。同時,在初期研發階段,Oopz敏銳地感知到玩家們對於語音開黑平台高內存佔用不滿的這一用戶痛點。不同於市面上普遍選擇Electron作為前端技術的軟體,Oopz透過Flutter規避了Electron需要二次編譯的弊端,在記憶體佔用和運行效率上實現了顯著優化,做到了行業領先,解決了因記憶體佔用導致遊戲掉幀這一現象,藉此快速實現了跨平台的應用開發,讓玩家們可以多端交流,打造了更優質的遊戲社交體驗。

為了消除遊戲開黑遭遇的噪音幹擾,Oopz引進了騰訊天籟實驗室領先的AI降噪方案,可支援最高48kHz取樣率的全帶訊號降噪,透過深度學習和智慧偵測技術,能夠精準辨識300多種背景噪音,無論是風扇嗡鳴、鍵盤敲擊,或是網咖喧囂,均能在不影響語音品質的前提下被智慧過濾。

在跨國、跨區等大規模遊戲作戰場景中,即使是幾毫秒延遲,都會極大影響開黑體驗。為了保障低延遲、高可靠性的語音通訊質量,騰訊雲實時音視頻TRTC為Oopz提供了自研的cPLC與cFEC技術,可實現端到端通話延時小於300ms的超低延時、抗丟包率超過80%和抗網路抖動超過1000ms的抗弱網能力,顯著降低了語音資料在網路中的傳輸延遲,確保玩家間的交流如同面對面般即時、高效。

值得一提的是,騰訊雲實時音視頻TRTC還基於騰訊會議同款音頻編解碼技術,極大提升了Oopz在同等碼率下語音的音質表現,助力Oopz細膩還原人聲細節,消除音訊壓縮帶來的失真,讓玩家彷彿置身於同一間隔音室中對話,無論是戰術討論還是情緒表達,都能得到真實、飽滿的呈現。

前不久,為了助力企業低門檻、快速搭建出業界頂尖的遊戲開黑工具,騰訊雲實時音視頻TRTC推出了一站式遊戲開黑解決方案,整合低延時、無噪音、低資源佔用的高品質語音、開放完善的興趣社群、全球化的遊戲加速等服務,一次覆蓋遊戲開黑核心場景。目前,騰訊雲端即時音訊視訊TRTC一站式遊戲開黑方案已服務多家頭部遊戲語音平台,提供使用者更清晰、更流暢、專注的語音溝通體驗。

自QQ時代以來,騰訊在網路與音訊視訊通訊領域已經有21年的技術積累,持續支援了國內90%的影音客戶實現雲端創新。 IDC最新發布的中國視訊雲市場報告顯示,騰訊雲音視訊的解決方案份額連續七次蟬聯榜首,在視訊直播和媒體處理賽道均排名第一。未來,騰訊雲也將與Oopz一起在影音使用者體驗上建立深度合作,為遊戲語音提供最優的技術支援服務;繼續以技術創新為引擎,持續為Oopz提供推動數位化創新與業務升級的服務支持。

以上是4個月用戶成長20倍,這家遊戲開黑平台怎麼做到的?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

華為手機記憶體不足怎麼辦(解決記憶體不足問題的實用方法)

Apr 29, 2024 pm 06:34 PM

華為手機記憶體不足怎麼辦(解決記憶體不足問題的實用方法)

Apr 29, 2024 pm 06:34 PM

華為手機內存不足已經成為許多用戶面臨的常見問題、隨著行動應用程式和媒體檔案的增加。幫助用戶充分利用手機的儲存空間、本文將介紹一些實用方法來解決華為手機記憶體不足的問題。 1.清理快取:歷史記錄以及無效數據,以釋放記憶體空間,清除應用程式產生的臨時檔案。在華為手機設定中找到「儲存」點擊,選項「清除快取」按鈕即可刪除應用程式的快取檔案。 2.卸載不常用的應用程式:以釋放記憶體空間,刪除一些不常用的應用程式。拖曳到手機螢幕上方的、長按要刪除的應用程式圖示「卸載」然後點擊確認按鈕即可完成卸載,標誌處。 3.移動應用到

騰訊混元大模型全面降價!混元-lite即日起免費

Jun 02, 2024 pm 08:07 PM

騰訊混元大模型全面降價!混元-lite即日起免費

Jun 02, 2024 pm 08:07 PM

5月22日,騰訊雲公佈全新大模型升級方案。主力模型之一混元-lite模型,API輸入輸出總長度計畫從目前的4k升級到256k,價格從0.008元/千tokens調整為全面免費。混元-standardAPI輸入價格從0.01元/千tokens降至0.0045元/千tokens,下降55%,API輸出價格從0.01元/千tokens降至0.005元/千tokens,下降50%。新上線的混元-standard-256k,具備處理超過38萬字符的超長文字能力,API輸入價格下調至0.015元/千toke

deepseek怎麼本地微調

Feb 19, 2025 pm 05:21 PM

deepseek怎麼本地微調

Feb 19, 2025 pm 05:21 PM

本地微調 DeepSeek 類模型面臨著計算資源和專業知識不足的挑戰。為了應對這些挑戰,可以採用以下策略:模型量化:將模型參數轉換為低精度整數,減少內存佔用。使用更小的模型:選擇參數量較小的預訓練模型,便於本地微調。數據選擇和預處理:選擇高質量的數據並進行適當的預處理,避免數據質量不佳影響模型效果。分批訓練:對於大數據集,分批加載數據進行訓練,避免內存溢出。利用 GPU 加速:利用獨立顯卡加速訓練過程,縮短訓練時間。

Edge瀏覽器記憶體佔用太多怎麼辦 記憶體佔用太多的解決方法

May 09, 2024 am 11:10 AM

Edge瀏覽器記憶體佔用太多怎麼辦 記憶體佔用太多的解決方法

May 09, 2024 am 11:10 AM

1.首先,進入Edge瀏覽器點選右上角三個點。 2、然後,在工作列中選擇【擴充】。 3、接著,將不需要使用的插件關閉或卸載即可。

只要250美元,Hugging Face技術主管手把手教你微調Llama 3

May 06, 2024 pm 03:52 PM

只要250美元,Hugging Face技術主管手把手教你微調Llama 3

May 06, 2024 pm 03:52 PM

我們熟悉的Meta推出的Llama3、MistralAI推出的Mistral和Mixtral模型以及AI21實驗室推出的Jamba等開源大語言模型已經成為OpenAI的競爭對手。在大多數情況下,使用者需要根據自己的資料對這些開源模型進行微調,才能充分釋放模型的潛力。在單一GPU上使用Q-Learning對比小的大語言模型(如Mistral)進行微調不是難事,但對像Llama370b或Mixtral這樣的大模型的高效微調直到現在仍然是一個挑戰。因此,HuggingFace技術主管PhilippSch

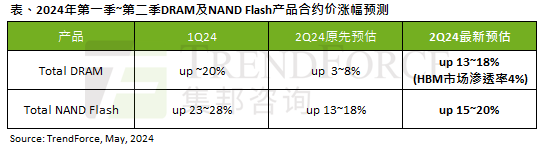

AI 潮影響明顯,TrendForce 上修本季 DRAM 記憶體、NAND 快閃記憶體合約價漲幅預測

May 07, 2024 pm 09:58 PM

AI 潮影響明顯,TrendForce 上修本季 DRAM 記憶體、NAND 快閃記憶體合約價漲幅預測

May 07, 2024 pm 09:58 PM

根據TrendForce的調查報告顯示,AI浪潮對DRAM記憶體和NAND快閃記憶體市場帶來明顯影響。在本站5月7日消息中,TrendForce集邦諮詢在今日的最新研報中稱該機構調升本季兩類儲存產品的合約價格漲幅。具體而言,TrendForce原先預估2024年第二季DRAM記憶體合約上漲3~8%,現估計為13~18%;而在NAND快閃記憶體方面,原預估上漲13~18%,新預估為15 ~20%,僅eMMC/UFS漲幅較低,為10%。 ▲圖源TrendForce集邦諮詢TrendForce表示,該機構原預計在連續

騰訊混元升級模型矩陣,雲端推出256k長文模型

Jun 01, 2024 pm 01:46 PM

騰訊混元升級模型矩陣,雲端推出256k長文模型

Jun 01, 2024 pm 01:46 PM

大模型落地加速,「產業實用」成為發展共識。 2024年5月17日,騰訊雲生成式AI產業應用高峰會在北京召開,公佈大模型研發、應用產品的系列進度。騰訊混元大模型能力持續升級,多個版本模型hunyuan-pro、hunyuan-standard、hunyuan-lite透過騰訊雲對外開放,滿足企業客戶、開發者在不同場景下的模型需求,落地最優性價比模型方案。騰訊雲大模型知識引擎、影像創作引擎、影片創作引擎三大工具發布,打造大模型時代原生工具鏈,透過PaaS服務簡化資料存取、模式精調、應用開發流程,協助企業