你說箱子裡要裝滿鑽石,於是箱子被鑽石填滿,比實拍還要耀眼。這樣的技能,哪個劇組不喜歡?

這是前段時間Adobe旗下的影片剪輯軟體Premiere Pro所呈現的「魔法」。該軟體透過引入Sora、Runway、Pika等AI視訊工具,實現在影片中添加物件、消除物件以及生成視訊片段等能力,這被視為視訊領域的再一次技術革新。

從 2 月 Sora 席捲全球到如今 Adobe 再施魔法,海外熱火朝天。相較之下,國內在影片領域,尤其是長影片產生方向仍處於「等待」狀態。在過去的兩個月裡,我們已經聽到了一些宣稱追趕 Sora 的聲音,但是目前還沒有看到國內取得明顯進展。但今天生數科技剛發布的這支短片,讓我們看到了不少驚喜。

這是生數科技聯合清華大學最新發布的影片大模型「Vidu」所官方的影片。可以看出,它生成的影片不再是持續幾秒鐘的“GIF”,而是達到了十幾秒鐘(最長可以達到 16 秒左右)。當然更令人驚訝的是,「Vidu」畫面效果非常接近Sora,在多鏡頭語言、時間和空間一致性、遵循物理規律等方面表現都非常出色,而且還能虛構出真實世界不存在的超現實主義畫面,這是目前的影片產生模型難以實現的。在短短兩個月的時間,生數科技能實現到這般效果,實在令人驚訝。

國內首個全面對標 Sora 的視頻模型

自 Sora 發布之後,「國產 Sora」的爭奪戰就打響了。但當產業都聚焦在「長」這個特性時,卻都忽略了 Sora 的背後其實是綜合效果的提升,例如長時間序下的一致性、真實度、美觀性等等。

從綜合效果看,“Vidu”是首個也是唯一在效果層面全面對標Sora 的視頻模型,不僅僅在國內,在全球範圍,也是繼Sora 之後首個完成突破的視訊模型。從具體效果,可以顯著看到幾個明顯的優勢:

給影片注入「鏡頭語言」

在影片製作中有一個非常重要的概念— —鏡頭語言。它是透過畫面來表達故事情節、揭示角色心理、營造氛圍以及引導觀眾情感的主要方式。不同的鏡頭選擇、角度、運動和組合將極大地影響敘事的效果和觀眾的感受。

現有 AI 生成的視頻,能夠明顯地感覺到鏡頭語言的單調,鏡頭的運動局限於輕微幅度的推、拉、移等簡單鏡頭。背後的主因是,現有的影片內容產生大多是先透過產生單幀畫面,再做連續的前後幀預測,但主流的技術路徑,很難做到長時序的連貫預測,只能做到小幅的動態預測。

Runway 於去年 7 月產生中的科幻電影預告片《Trailer: Genesis》中(《創世紀》)。

「Vidu」則是突破了這些限制。在一個「海邊小屋」為主題的片段中,我們可以看到,「Vidu」一次生成的一段片段中涉及多個鏡頭,畫面既有小屋的近景特寫,也有望向海面的遠眺,整體看下來有種從屋內到走廊再到欄桿邊賞景的敘事感。可以看出,「Vidu」能夠圍繞著統一主體在一段畫面中實現遠景、近景、中景、特寫等不同鏡頭的切換。

提示:在古色古香的海邊小屋裡,陽光沐浴著房間,鏡頭緩慢過渡到一個陽台,俯瞰著寧靜的大海,最後鏡頭定格在漂浮著大海、帆船和倒影般的雲彩。 (生數旗下 PixWeaver 產品官網所放出的完整影片片段)

此外,從短片中的多個片段能看到,「Vidu」能直接產生轉場、追焦、長鏡頭等效果,包括能夠產生影視級的鏡頭畫面,給影片注入鏡頭語言,提升畫面的整體敘事感。

#保持時間和空間的一致性

#影片畫面的連貫性和流暢性至關重要,這背後其實是人物和場景的時空一致性,例如人物在空間中的運動始終保持一致,場景也不能在沒有任何轉場的情況下突變。而這一點 AI 很難實現,尤其時長一長,AI 生成的影片將出現敘事斷裂、視覺不連貫、邏輯錯誤等問題, 這些問題會嚴重影響影片的真實感和觀賞性。

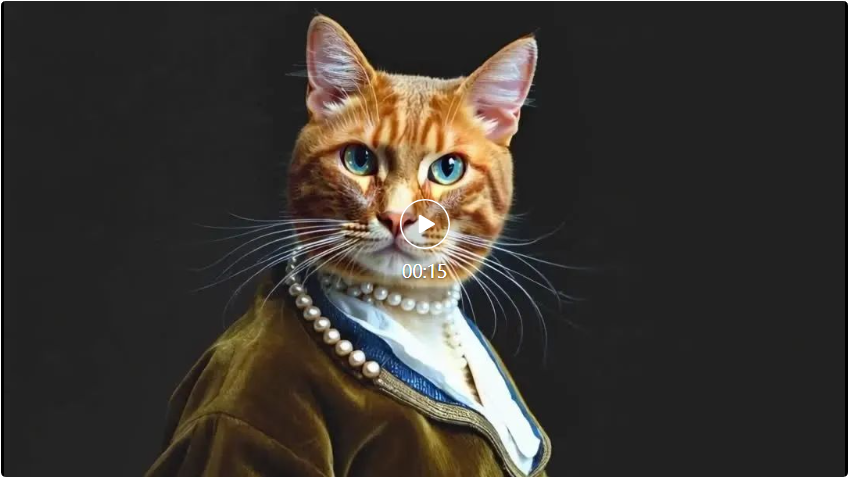

“Vidu”在某種程度上克服了這些問題。從它生成的一段「帶珍珠耳環的貓」的影片中可以看到,隨著鏡頭的移動,作為畫面主體的貓在3D 空間下一直保持著表情、服飾的一致,影片整體上非常連貫、流暢,保持了很好的時間、空間一致性。

提示:這是一隻藍眼睛的橘色貓的肖像,慢慢地旋轉,靈感來自維梅爾的《戴珍珠耳環的少女》,畫面戴著珍珠耳環,棕色頭髮像荷蘭帽一樣,黑色背景,工作室燈光。 (生數旗下PixWeaver 產品官網放出的完整影片片段)

#模擬真實物理世界

Sora 令人驚豔的一大特點,就是能夠模擬真實物理世界的運動,例如物體的移動和相互作用。其中 Sora 發布過的一個經典案例 ——「一輛老式 SUV 行駛在山坡上」的畫面,非常好地模擬了輪胎揚起的灰塵、樹林中的光影以及車行駛過程中的陰影變化。在同樣的提示詞下,「Vidu」與 Sora 生成效果高度接近,灰塵、光影等細節與人類在真實物理世界中的體驗非常接近。  提示:鏡頭跟隨一輛帶有黑色車頂行李架的白色老式SUV,它在陡峭的山坡上一條被松樹環繞的陡峭土路上加速行駛,輪胎揚起灰塵,陽光照射在SUV 上,為整個場景投射出溫暖的光芒。土路緩緩地蜿蜒延伸至遠方,看不到其他汽車或車輛。道路兩旁都是紅杉樹,零星散落一片片綠意。從後面看,這輛車輕鬆地沿著曲線行駛,看起來就像是在崎嶇的地形上行駛。土路周圍是陡峭的丘陵和山脈,上面是清澈的藍天和縷縷雲彩。 (生數旗下 PixWeaver 產品官網放出的完整影片片段)

提示:鏡頭跟隨一輛帶有黑色車頂行李架的白色老式SUV,它在陡峭的山坡上一條被松樹環繞的陡峭土路上加速行駛,輪胎揚起灰塵,陽光照射在SUV 上,為整個場景投射出溫暖的光芒。土路緩緩地蜿蜒延伸至遠方,看不到其他汽車或車輛。道路兩旁都是紅杉樹,零星散落一片片綠意。從後面看,這輛車輕鬆地沿著曲線行駛,看起來就像是在崎嶇的地形上行駛。土路周圍是陡峭的丘陵和山脈,上面是清澈的藍天和縷縷雲彩。 (生數旗下 PixWeaver 產品官網放出的完整影片片段)  ##

##

豐富的想像力

與實景拍攝相比,用AI 生成影片有一個很大的優勢—— 它可以產生現實世界中不存在的畫面。以往,這些畫面往往要花費很大的人力、物力去搭建或做成特效,但是 AI 短時間就可以自動產生了。例如在下面這個場景中,「帆船」、「海浪」罕見地出現在了工作室裡,而且海浪與帆船的交互動態非常自然。

提示:母室內的一艘船駛向鏡頭。 (生數旗下PixWeaver 產品官網放出的完整影片片段)

#短片中的「魚缸女孩」的片段也是奇幻但又有一定的合理感。這種能夠虛構真實世界不存在的畫面的能力,對於創作超現實主義內容非常有幫助,不僅可以激發創作者的靈感,提供新穎的視覺體驗,還能拓寬藝術表達的邊界,帶來更加豐富和多元化的內容形式。

理解中國元素

除了以上四個方面的特徵外,我們從「Vidu」放出的短片中還看到了一些不一樣的驚喜,「Vidu」能夠產生特有中國元素的畫面,例如熊貓、龍、宮殿場景等。

提示:在寧靜的湖邊,一隻熊貓熱切地彈著吉他,讓整個環境變得活躍起來。晴朗天空下平靜的水面倒映著這一場景,以生動的全景鏡頭捕捉到,將現實主義與大熊貓活潑的精神融為一體,創造出活力與平靜的和諧融合。 (生數旗下 PixWeaver 產品官網放出的完整影片片段)

#兩個月快速突破,背後是怎麼做到的?

「Vidu」背後的研發團隊生數科技是國內多模態大模型方向的創業團隊,核心成員來自清華大學人工智慧研究院,團隊專注於圖像、3D、影片等多模態生成領域。

在今年 1 月份,生數科技在旗下視覺創意設計平台 PixWeaver 就上線了短影片生成功能,支援 4 秒高美學性的短影片內容。 2 月Sora 推出後,據悉,生數科技內部成立了正式的攻堅小組,加快了原本視頻方向的研發進度,3 月份內部就實現了8 秒的視頻生成,緊接著4 月份就突破了16 秒生成,生成品質與時長全方面取得突破。

眾所周知,Sora 並沒有公佈太多的技術細節,能在這麼短的時間內取得突破,背後核心是團隊深厚的技術積累和諸多從0 到1 的原創成果,尤其是在最核心的技術架構層面。

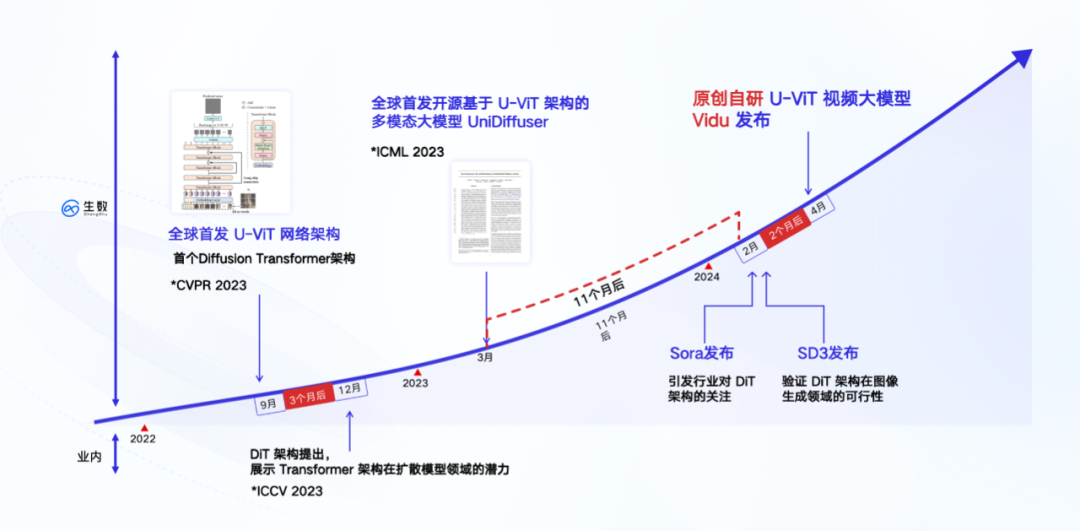

「Vidu」底層基於完全自研的U-ViT 架構,該架構由團隊在2022 年9 月提出,早於Sora 採用的DiT 架構,是全球首個Diffusion 和Transformer 融合的架構。

在DiT 論文發布兩個月前,清華大學的朱軍團隊提交了一篇論文—《All are Worth Words: A ViT Backbone for Diffusion Models》。這篇論文提出了以 Transformer 取代基於 CNN 的 U-Net 的網路架構 U-ViT。這是「Vidu」最重要的技術基礎。

在技術路線上,「Vidu」採用了和 Sora 完全一致的 Diffusion 和 Transformer 融合的架構。不同於採用插幀的多步驟處理方式來達到長視頻的生成,“Vidu”採用的是和 Sora 一致的路線,即通過單一步驟直接生成高質量的視頻。從底層來看,這是一種「一步到位」的實現方法,基於單一模型完全端到端生成,不涉及中間的插幀和其他多步驟的處理,文本到視頻的轉換是直接且連續的。

另外基於U-ViT 架構,2023 年3 月,團隊在開源的大規模圖文資料集LAION-5B 上訓練了10 億參數量的多模態模型-UniDiffuser,並將其開源(請參閱《清華朱軍團隊開源首個基於Transformer 的多模態擴散大模型,文圖互生、改寫全拿下》)。

UniDiffuser 主要擅長圖文任務,能支援圖文模態間的任意生成與轉換。 UniDiffuser 的實現有一項重要的價值- 首次驗證了融合架構在大規模訓練任務中的可擴展性(Scaling Law),相當於將U-ViT 架構在大規模訓練任務中的所有環節流程都跑通。值得一提的,UniDiffuser 比同樣 DiT 架構的圖文模型 Stable Diffusion 3 的提案領先了一年。

這些在圖文任務中累積的工程經驗為視訊模型的研發打下了基礎。因為影片本質上是影像的串流,相當於影像在時間軸上做了一個擴增。因此,在圖文任務上所取得的成果往往能夠在影片任務中重複使用。 Sora 就是這麼做的:它採用了 DALL・E 3 的重標註技術,透過為視覺訓練資料產生詳細的描述,使模型能夠更準確地遵循使用者的文字指令來產生影片。這種效應也必然會發生在「Vidu」上面。

根據先前的消息推測,「Vidu」也復用了生數科技在圖文任務的許多經驗,包括訓練加速、平行化訓練、低顯存訓練等等,從而快速跑通了訓練流程。據悉,他們透過視訊資料壓縮技術降低輸入資料的序列維度,同時採用自研的分散式訓練框架,在確保運算精度的同時,通訊效率提升1 倍,顯存開銷降低80%,訓練速度累計提升40 倍。

從圖任務的統一到融合視訊能力,「Vidu」可被視為一款通用視覺模型,能夠支援產生更多樣化、更長時長的視訊內容。官方也透露,「Vidu」目前還在加速迭代提升。面向未來,「Vidu」靈活的模型架構也將能夠相容於更廣泛的多模態能力。

來自清華系的精幹團隊

最後,再聊「Vidu」背後的團隊— 生數科技,這是一支清華背景的精幹團隊。

生數科技的核心團隊來自清華大學人工智慧研究院。首席科學家由清華人工智慧研究院副院長朱軍擔任;CEO 唐家渝本碩就讀於清華大學計算機系,是THUNLP 組成員;CTO 鮑凡則是清華大學計算機系博士生、朱軍教授的課題組成員,長期關注擴散模型領域研究,U-ViT 和UniDiffuser 兩項工作均是由他主導完成的。

團隊從事生成式人工智慧和貝葉斯機器學習的研究已有 20 餘年,在深度生成模型突破的早期就開展了深入研究。在擴散模型方面,團隊於國內率先開啟了該方向的研究,成果涉及骨幹網路、高速推理演算法、大規模訓練等全端技術方向。

團隊於ICML、NeurIPS、ICLR 等人工智慧頂會發表多模態領域相關論文近30 篇,其中提出的免訓練推理演算法Analytic-DPM、DPM -Solver 等突破性成果,獲得ICLR 傑出論文獎,並被OpenAI、蘋果、Stability.ai 等國外前沿機構採用,應用於DALL・E 2、Stable Diffusion 等明星項目中。

自 2023 年成立以來,團隊已獲得螞蟻集團、啟明創投、BV 百度創投、位元組錦秋基金等多家知名產業機構的認可,完成數億元融資。據悉,生數科技是目前國內在多模態大模型賽道估值最高的創業團隊。此次「Vidu」的推出,是生數科技在多模態原生大模型領域的再一次創新與領先。

相關閱讀:

《專訪生數科技唐家渝:拿到上億融資,Transformer 來做多模態大模型》

《 國內公司有望做出Sora 嗎?這支清華系大模型團隊給了希望》

以上是目前最強國產Sora!清華團隊突破16秒長視頻,懂多鏡頭語言,會模擬物理規律的詳細內容。更多資訊請關注PHP中文網其他相關文章!