挑戰OpenAI,微軟自研5000億參數絕密武器曝光!前GoogleDeepMind高層帶隊

不需要OpenAI,微軟或許也會成為AI領頭羊!

外媒Information爆料稱,微軟內部正在開發自家首款5000億參數的大模型MAl-1。

這剛好是,納德拉帶領團隊證明自己的時候到了。

在向OpenAI投資100多億美元之後,微軟才獲得了GPT-3.5/GPT-4先進模型的使用權,但終究不是長久之計。

甚至,先前有傳言稱,微軟已經淪落為OpenAI的一個IT部門。

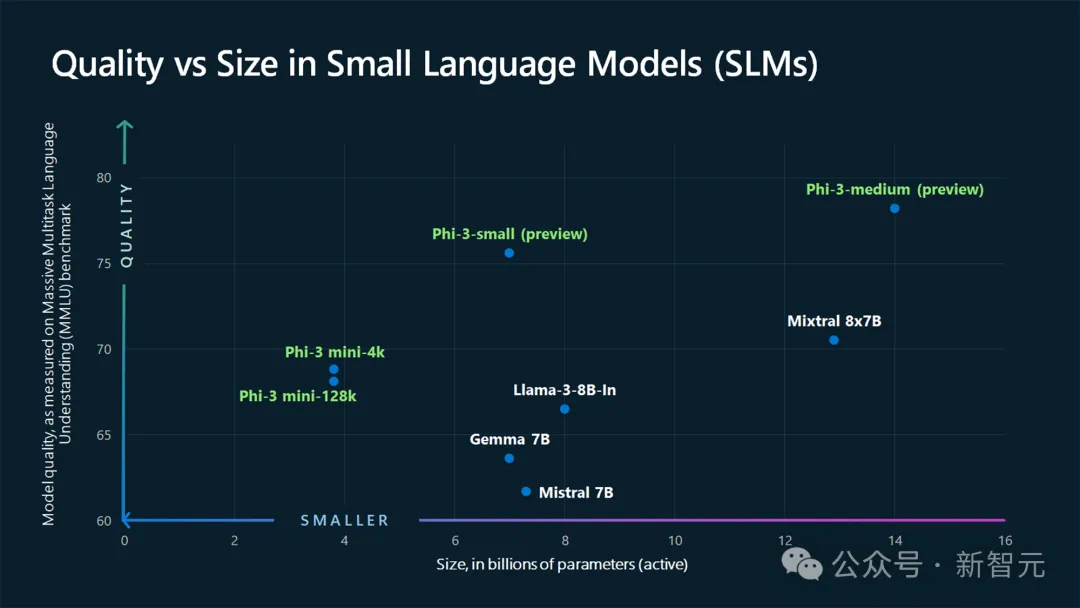

在過去的一年,每個人熟知的,微軟在LLM方面的研究,主要集中在小體積phi的更新,例如Phi-3的開源。

而在大模型的專攻上,除了圖靈系列,微軟內部還未透露半點風聲。

就在今天,微軟技術長Kevin Scott證實,MAI大模型確實正在開發中。

顯然,微軟秘密籌備大模型的計劃,是為了能夠開發出一款全新LLM,能夠與OpenAI、Google、Anthropic頂尖模型競爭。

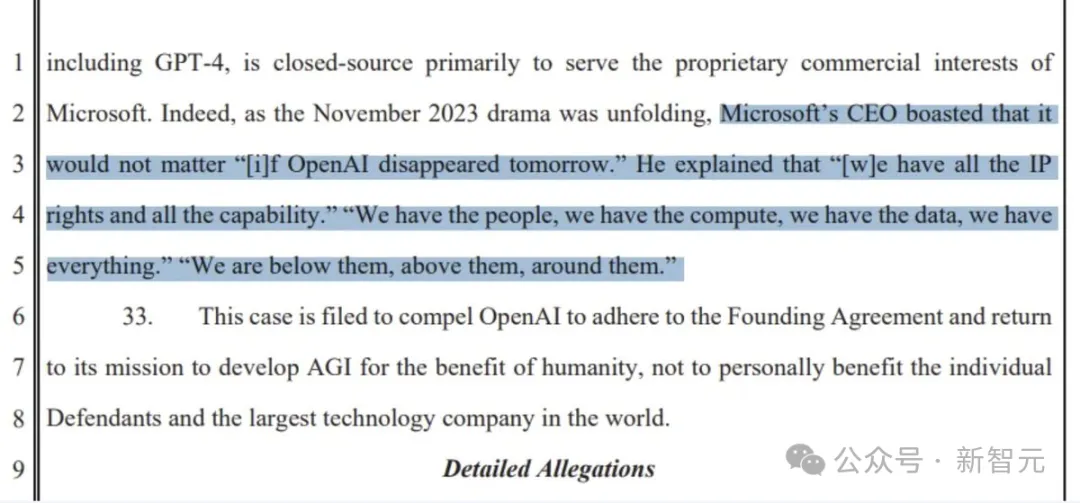

畢竟,納德拉曾說過,「如果OpenAI明天消失了,也無關緊要」。

「我們有的是人才、有的是算力、有的是數據,我們什麼都不缺。我們在他們之下,在他們之上,在他們周圍」。

看來,微軟的底氣,就是自己。

自研5000億MAI-1大模型

據介紹,MAI-1大模型由前GoogleDeepMind負責人Mustafa Suleyman,負責監督。

值得一提的是,Suleyman在加入微軟之前,還是AI新創Inflection AI創辦人兼CEO。

創辦於2022年,一年的時間,他帶領團隊推出了大模型Inflection(目前已更新到了2.5版本),以及日活破百萬的高情商AI助手Pi 。

不過因為找不到正確的商業模式,Suleyman和另一位聯創,以及大部分員工,在3月共同加入微軟。

也就是說,Suleyman和團隊負責這個新專案MAI-1,會為此帶來更多的前沿大模型的經驗。

還是要提一句,MAI-1模型是微軟自研發的,並非從Inflection模型繼承而來。

據兩位微軟員工稱,「MAI-1與Inflection先前發布的模型不同」。不過,訓練過程可能會用到其訓練資料和技術。

擁有5000億參數,MAI-1的參數規模將遠遠超出,微軟以往訓練的任何小規模開源模型。

這也意味著,它將需要更多的算力、數據,訓練成本也是高昂的。

為了訓練這款新模型,微軟已經預留了一大批配備英偉達GPU的伺服器,並一直在編制訓練資料以優化模型。

其中,包括來自GPT-4產生的文本,以及外部來源(網路公共資料)的各種資料集。

大小模型,我都要

相較之下,GPT-4曾被曝出有1.8兆參數,Meta、Mistral等AI公司發布較小開源模型,則有700億參數。

當然,微軟採取的是多管齊下的策略,也就是大小模型一起研發。

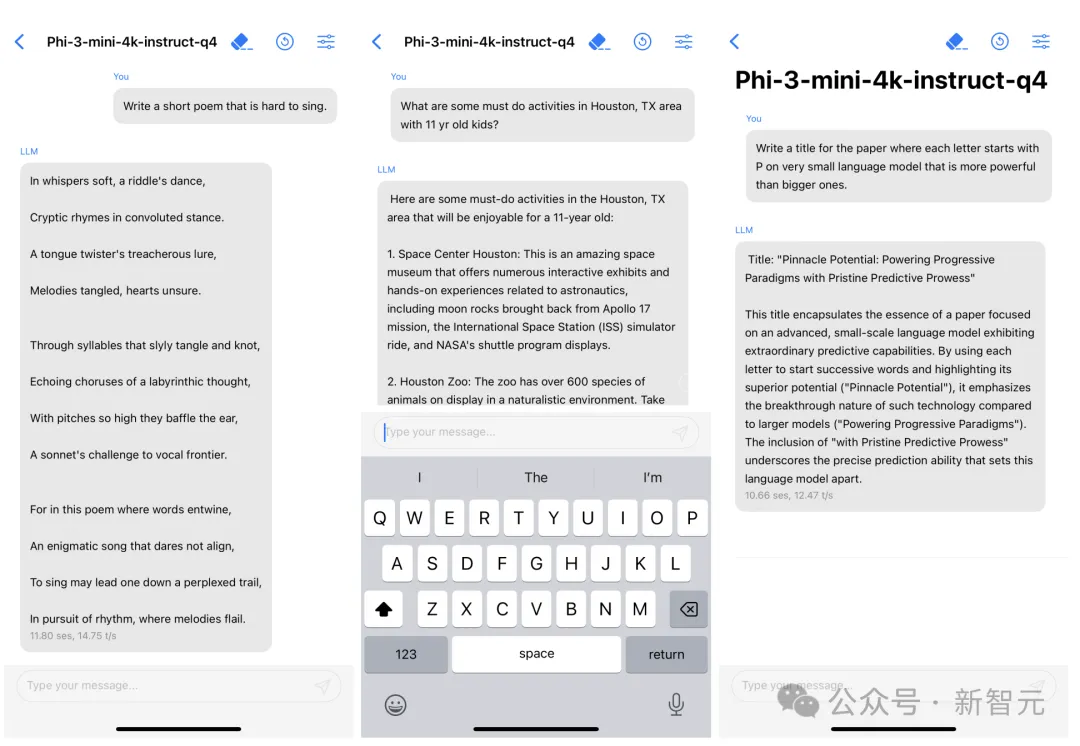

其中,最經典的便是Phi-3了——一個能夠塞進手機的小模型,而且最小尺寸3.8B性能碾壓GPT-3.5。

Phi-3 mini在量化到4bit的情況下,只佔用大約1.8GB的內存,用iPhone14每秒可產生12個token 。

在網友拋出「應該用更低成本訓練AI,不是更好嗎」的問題後,Kevin Scott回覆到:

這並不是一個非此即彼的關係。在許多AI應用中,我們結合使用大型前緣模型和更小、更有針對性的模型。我們做了大量工作,確保SLM在設備上和雲端中都能很好地運作。我們在訓練SLM方面累積了大量經驗,甚至將其中一些工作開源,供他人研究和使用。我認為,在可預見的未來,這種大與小的結合還會持續下去。

這表明,微軟既要開發成本低廉、可整合到應用程式中,並能在行動裝置上運行的SLM,也要開發更大、更先進的AI模型。

目前,微軟自稱是一家「Copilot公司」。得到AI加持的Copilot聊天機器人,可以完成撰寫電子郵件、快速總結文件等任務。

而未來,下一步的機會在哪裡?

大小模型兼顧,正體現了充滿創新活力的微軟,更願意探索AI的新路徑。

不給OpenAI當「IT」了?

話又說回來,自研MAI-1,並不代表微軟將會拋棄OpenAI。

首席技術長Kevin Scott在今早的貼文中首先,肯定了微軟與OpenAI合作五年的堅固「友誼」。

我們一直在為合作夥伴OpenAI建造大型超算,來訓練前沿的AI模型。然後,兩家都會將模型,應用到自家的產品和服務中,讓更多的人受益。

而且,每一代新的超算都將比上一代,更加強大,因此OpenAI訓出的每個前沿模型,都要比上一個更加先進。

我們將繼續沿著這條路走下去——不斷建立更強大的超算,讓OpenAI能夠訓練出引領整個產業的模型。我們的合作將會產生越來越大的影響力。

前段時間,外媒曝光了,微軟和OpenAI聯手打造AI超算「星際之門」,將斥資高達1150億美元。

據稱,最快將在2028年推出超算,並在2030年之前進一步擴展。

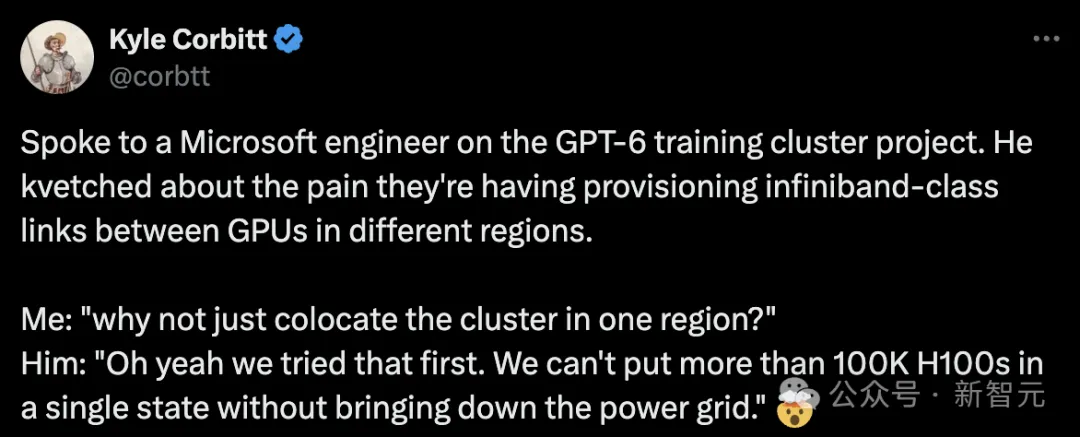

包括先前,微軟工程師向創業家Kyle Corbitt爆料稱,微軟正在緊鑼密鼓地建設10萬個H100,以供OpenAI訓練GPT- 6。

種種跡象表明,微軟與OpenAI之間合作,只會更加牢固。

此外,Scott也表示,「除了與OpenAI的合作,微軟多年來一直都在讓MSR和各產品團隊開發AI模型」。

AI模型幾乎深入了,微軟的所有產品、服務和營運過程。團隊有時也需要進行客製化工作,不論是從零開始訓模型,還是對現有模型進行微調。

未來,還會有更多類似的這樣的情況。

這些模型中,有些被命名為Turing、MAI等,還有的命名為Phi,我們並將其開源。

雖然我的表達可能沒有那麼引人注目,但這是現實。對於我們這些極客來說,鑑於這一切在實踐中的複雜性,這是一個非常令人興奮的現實。

解密「圖靈」模型

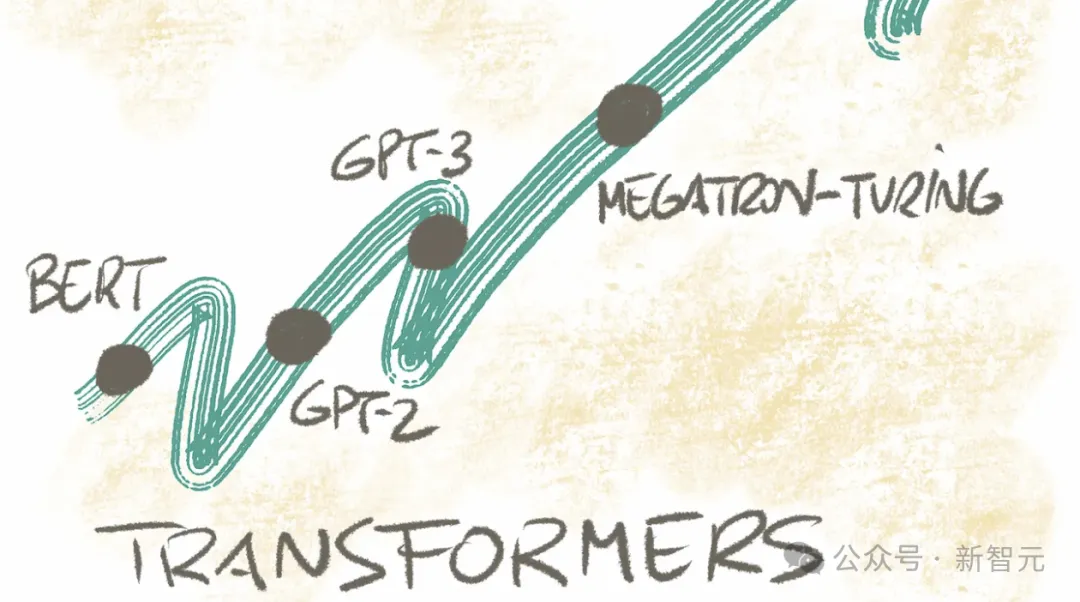

除了MAI、Phi系列模型,代號「Turing」是微軟在2017年在內部開啟的計劃,旨在打造一款大模型,並應用到所有產品線中。

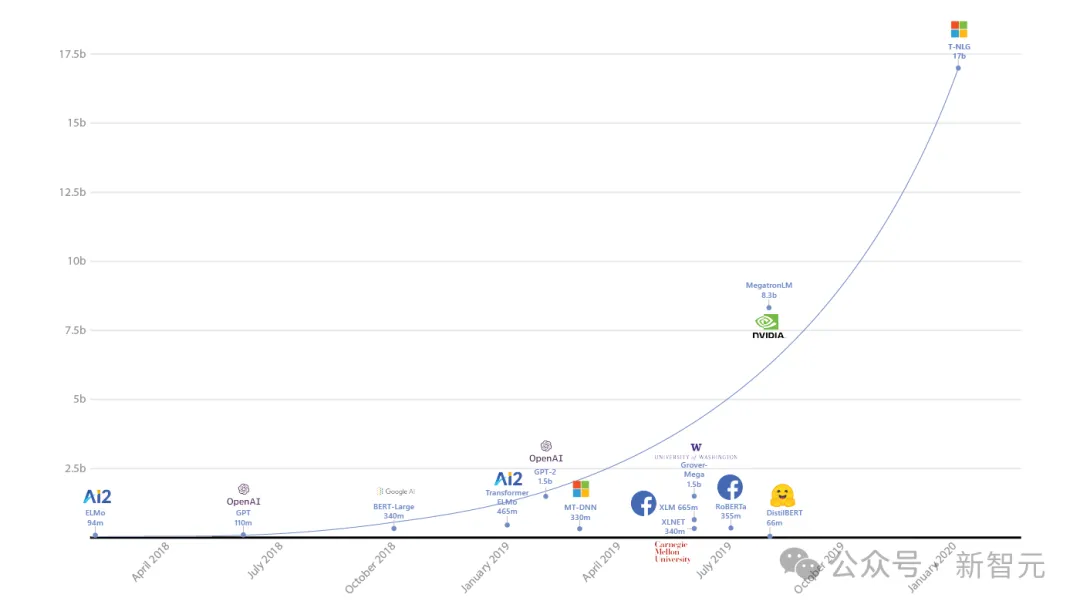

經過3年研發,他們在2020年首次發表170億參數的T-NLG模型,創下當時有史以來最大參數規模的LLM記錄。

到了2021年,微軟聯手英偉達發布了5,300億參數的Megatron-Turing(MT-NLP),在一系列廣泛的自然語言任務中表現出了「無與倫比」的準確性。

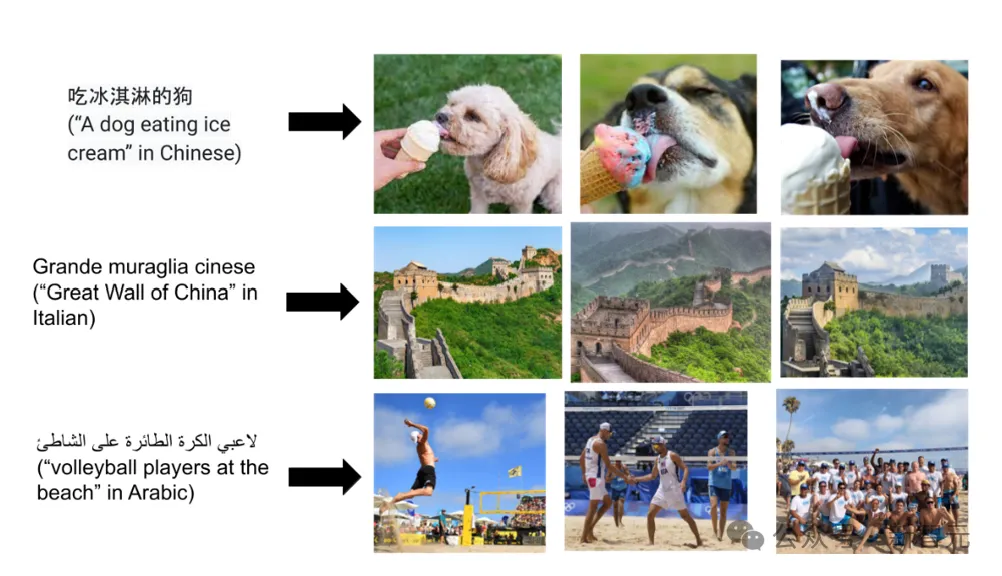

同年,視覺語言模型Turing Bletchley首次面世。

去年8月,該多模態模型已經迭代到了V3版本,並且已經整合進Bing等相關產品中,以提供更出色的圖像搜尋體驗。

此外,微軟也在2021年和2022年發布了「圖靈通用語言表示模型」-T-ULRv5和T-ULRv6兩個版本。

目前,「圖靈」模型已經用在了,Word中的智慧查詢(SmartFind),Xbox中的問題匹配(Question Matching)上。

還有團隊研發的影像超解析度模型Turing Image Super-Resolution(T-ISR),已在必應地圖中應用,可以為全球用戶提高航空影像的品質.

目前,MAI-1新模型具體會在哪裡得到應用,還未確定,將取決於其性能表現。

順便提一句,關於MAI-1更多的信息,可能會在5月21日-23日微軟Build開發者大會上首次展示。

接下來,就是坐等MAI-1發布了。

以上是挑戰OpenAI,微軟自研5000億參數絕密武器曝光!前GoogleDeepMind高層帶隊的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

iOS 18 RC 中發現 iPhone 零件啟動鎖——可能是蘋果對以用戶保護為幌子銷售維修權的最新打擊

Sep 14, 2024 am 06:29 AM

iOS 18 RC 中發現 iPhone 零件啟動鎖——可能是蘋果對以用戶保護為幌子銷售維修權的最新打擊

Sep 14, 2024 am 06:29 AM

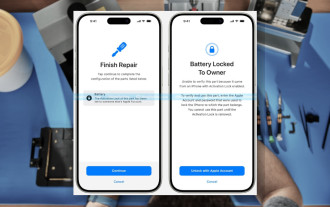

今年早些時候,蘋果宣布將把啟動鎖定功能擴展到 iPhone 組件。這有效地將各個 iPhone 組件(例如電池、顯示器、FaceID 組件和相機硬體)連結到 iCloud 帳戶,

iPhone零件啟動鎖可能是蘋果對以用戶保護為幌子銷售維修權的最新打擊

Sep 13, 2024 pm 06:17 PM

iPhone零件啟動鎖可能是蘋果對以用戶保護為幌子銷售維修權的最新打擊

Sep 13, 2024 pm 06:17 PM

今年早些時候,蘋果宣布將把啟動鎖定功能擴展到 iPhone 組件。這有效地將各個 iPhone 組件(例如電池、顯示器、FaceID 組件和相機硬體)連結到 iCloud 帳戶,

多名 iPhone 16 Pro 使用者報告觸控螢幕凍結問題,可能與防手掌誤觸敏感度有關

Sep 23, 2024 pm 06:18 PM

多名 iPhone 16 Pro 使用者報告觸控螢幕凍結問題,可能與防手掌誤觸敏感度有關

Sep 23, 2024 pm 06:18 PM

如果您已經拿到了 Apple iPhone 16 系列的裝置(更具體地說是 16 Pro/Pro Max),那麼您最近很可能遇到某種觸控螢幕問題。一線希望是你並不孤單——報告

Gate.io交易平台官方App下載安裝地址

Feb 13, 2025 pm 07:33 PM

Gate.io交易平台官方App下載安裝地址

Feb 13, 2025 pm 07:33 PM

本文詳細介紹了在 Gate.io 官網註冊並下載最新 App 的步驟。首先介紹了註冊流程,包括填寫註冊信息、驗證郵箱/手機號碼,以及完成註冊。其次講解了下載 iOS 設備和 Android 設備上 Gate.io App 的方法。最後強調了安全提示,如驗證官網真實性、啟用兩步驗證以及警惕釣魚風險,以確保用戶賬戶和資產安全。

在使用PHP調用支付寶EasySDK時,如何解決'Undefined array key 'sign'”報錯問題?

Mar 31, 2025 pm 11:51 PM

在使用PHP調用支付寶EasySDK時,如何解決'Undefined array key 'sign'”報錯問題?

Mar 31, 2025 pm 11:51 PM

問題介紹在使用PHP調用支付寶EasySDK時,按照官方提供的代碼填入參數後,運行過程中遇到報錯信息“Undefined...

Beats 為其產品陣容增添手機殼:推出適用於 iPhone 16 系列的 MagSafe 手機殼

Sep 11, 2024 pm 03:33 PM

Beats 為其產品陣容增添手機殼:推出適用於 iPhone 16 系列的 MagSafe 手機殼

Sep 11, 2024 pm 03:33 PM

Beats 以推出藍牙揚聲器和耳機等音訊產品而聞名,但令人驚訝的是,這家蘋果旗下公司從 iPhone 16 系列開始涉足手機殼製造領域。節拍 iPhone

安幣app官方下載v2.96.2最新版安裝 安幣官方安卓版

Mar 04, 2025 pm 01:06 PM

安幣app官方下載v2.96.2最新版安裝 安幣官方安卓版

Mar 04, 2025 pm 01:06 PM

幣安App官方安裝步驟:安卓需訪官網找下載鏈接,選安卓版下載安裝;iOS在App Store搜“Binance”下載。均要從官方渠道,留意協議。

iPhone 16 Pro Max實驗室測試揭示其實際充電速度

Sep 19, 2024 am 06:15 AM

iPhone 16 Pro Max實驗室測試揭示其實際充電速度

Sep 19, 2024 am 06:15 AM

有些人批評新的 iPhone 16 系列缺乏創新,而郭明池透露,蘋果收到的預訂量也低於預期。該分析師指出,預購量低於標準的主要原因是新手機尚未上市。