港大開源圖基礎大模型OpenGraph: 強泛化能力,前向傳播預測全新數據

图学习领域的数据饥荒问题,又有能缓解的新花活了!

OpenGraph,一个基于图的基础模型,专门用于在多种图数据集上进行零样本预测。

港大数据智能实验室的负责人Chao Huang团队,他们也针对模型提出了提升调整技术,以提高模型对新任务的适应性。

目前,这项工作已经挂上了GitHub。

介绍数据增强技术,此工作主要是深入探讨增强图模型泛化能力的策略(特别是在训练和测试数据存在显著差异时)。

OpenGraph是一种通用的图结构模式,通过传播预测进行前向传播,实现对全新数据的零样本预测。

为了实现目标,团队解决了以下3点挑战:

- 数据集间的token差异:不同图数据集常有不同的图token集,我们需要模型能够跨数据集进行预测。

- 节点关系建模:在构建通用图模型时,有效地建模节点关系至关重要,这关系到模型的扩展性和效率。

- 数据稀缺:面对数据获取的难题,我们通过大型语言模型进行数据增强,以模拟复杂的图结构关系,提升模型训练质量。

通过一系列创新方法,如拓扑感知的BERT Tokenizer和基于锚点的图Transformer,OpenGraph有效应对了上述挑战。在多个数据集上的测试结果证明了模型的出色泛化能力,能够对模型的彩色泛化能力进行有效评估。

OpenGraph模型

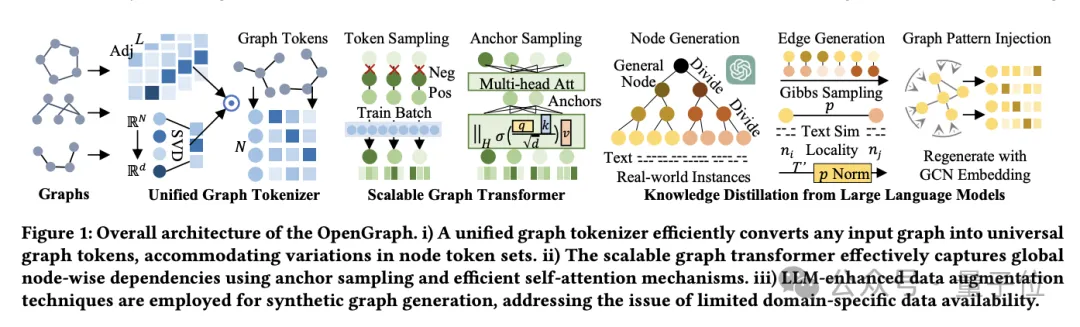

OpenGraph模型架构主要由3个核心部分组成:

- 统一图Tokenizer。

- 可扩展的图Transformer。

- 基于大语言模型的知识蒸馏技术。

首先来说说统一图Tokenizer。

为了适应不同数据集的节点和边的差异,团队开发了统一图Tokenizer,它将图数据标准化为token序列。

这一过程包括高阶邻接矩阵平滑化和拓扑感知映射。

高阶邻接矩阵平滑化即利用邻接矩阵的高阶幂来解决连接稀疏的问题,而拓扑感知映射则是将邻接矩阵转换为节点序列,并使用快速奇异值分解(SVD)最小化信息损失,保留更多的图结构信息。

其次是可扩展的图Transformer。

在token化后,OpenGraph使用Transformer架构模拟节点间的依赖,主要采用以下技术优化模型性能和效率:

一来是token序列采样,通过采样技术减少模型需要处理的关系数量,从而降低训练的时间和空间复杂度。

二来是锚点采样的自注意力机制。此方法进一步降低计算复杂度,通过分阶段学习节点间的信息传递,有效提高模型的训练效率和稳定性。

最后是大语言模型知识蒸馏。

为了应对培训通用图模型时面临的数据隐私和种类多样性问题,团队从大语言模型(LLM)的知识和理解能力中获得灵感,使用LLM生成各种图结构数据。

这一数据增强机制通过模拟真实世界图的特征,有效提升了数据的质量和实用性。

团队还首先生成适应特定应用的节点集,每个节点拥有文本描述以便生成边。

在面对如电子商务平台这种大规模节点集时,研究人员通过将节点细分为更具体的子类别来处理。

例如,从“电子产品”细化到具体的“移动电话”“笔记本电脑”等,此过程反复进行,直到节点精细到接近真实实例。

提示树算法则按树状结构将节点细分,并生成更细致的实体。

从一般的类别如“产品”开始,逐步细化到具体的子类别,最终形成节点树。

至于边的生成,利用吉布斯采样,研究人员基于已生成的节点集来形成边。

为了减少计算负担,我们不直接通过LLM遍历所有可能的边,而是先利用LLM计算节点间的文本相似度,再通过简单的算法判断节点关系。

在此基础上,团队引入了几种技术调整:

- 動態機率標準化:透過動態調整,將相似度對應到更適合取樣的機率範圍內。

- 節點局部性:引入局部性概念,只在節點的局部子集間建立連接,模擬現實世界中的網路局部性。

- 圖拓樸模式註入:使用圖卷積網路修正節點表示,以更好地適應圖結構特徵,減少分佈偏差。

以上步驟確保了產生的圖資料不僅豐富多樣,而且貼近現實世界的連結模式和結構特性。

實驗驗證與效能分析

需要注意,該實驗專注於使用僅由LLM產生的資料集訓練OpenGraph模型,並在多樣化的真實場景資料集上進行測試,涵蓋節點分類和連結預測任務。

實驗設計如下:

零樣本設定。

為了評估OpenGraph在未見過的資料上的表現,我們在產生的訓練集上訓練模型,然後在完全不同的真實測試集上進行評估。確保了訓練和測試資料在節點、邊和特徵上均無重合。

少樣本設定。

考慮到許多方法難以有效執行零樣本預測,我們引入少樣本設置,基線模型在預訓練資料上預訓練後,採用k-shot樣本進行微調。

在2個任務和8個測試集上的結果顯示,OpenGraph在零樣本預測中顯著優於現有方法。

此外,現有預訓練模型在跨資料集任務中的表現有時不如從頭訓練的模型。

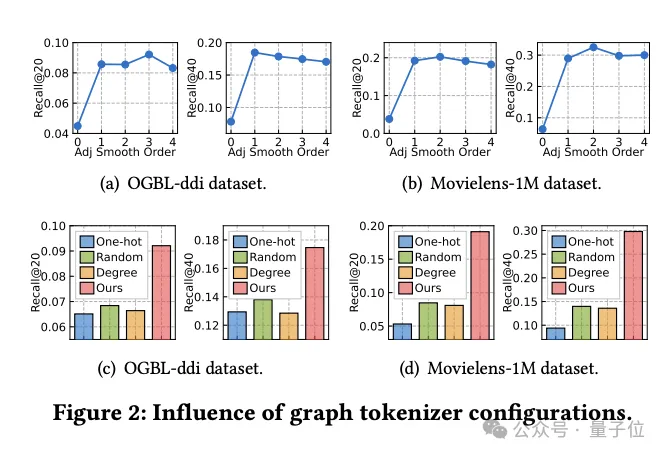

圖Tokenizer設計影響研究

同時,團隊探索了圖Tokenizer設計如何影響模型效能。

首先,透過實驗發現,不進行鄰接矩陣平滑(平滑階數為0)會顯著降低效能,說明平滑處理的必要性。

然後,研究人員嘗試了幾種簡單的拓撲感知替代方案:跨資料集的獨熱編碼ID、隨機映射和基於節點度數的表示。

實驗結果顯示,這些替代方案性能均不理想。

具體來說,跨資料集的ID表示效果最差,基於度數的表示也表現不佳,而隨機映射雖稍好,但與優化的拓撲感知映射相比,效能差距明顯。

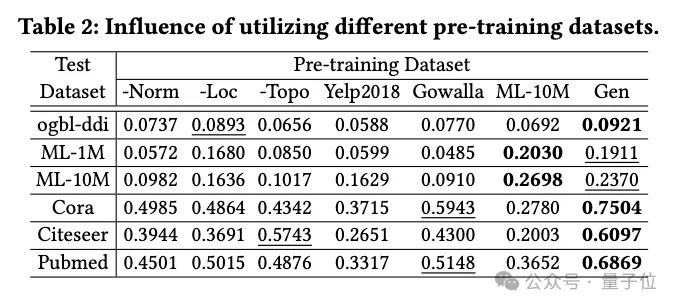

資料產生技術的影響

團隊調查了不同預訓練資料集對OpenGraph性能的影響,包括使用基於LLM的知識蒸餾方法產生的資料集,以及幾個真實資料集。

實驗中比較的預訓練資料集包括從團隊生成方法中移除某項技術後的資料集、2個與測試資料集無關的真實資料集(Yelp2018和Gowalla)、1個與測試資料集類似的真實資料集(ML-10M)。

實驗結果顯示,生成資料集在所有測試集上都展示了良好性能;三種生成技術的移除都顯著影響了性能,驗證了這些技術的有效性。

使用與測試集無關的真實資料集(如Yelp和Gowalla)訓練時,效能有時會下降,這可能是由於不同資料集之間的分佈差異。

ML-10M資料集在與之類似的測試資料集(如ML-1M和ML-10M)上取得了最佳效能,突顯了訓練和測試資料集相似性的重要性。

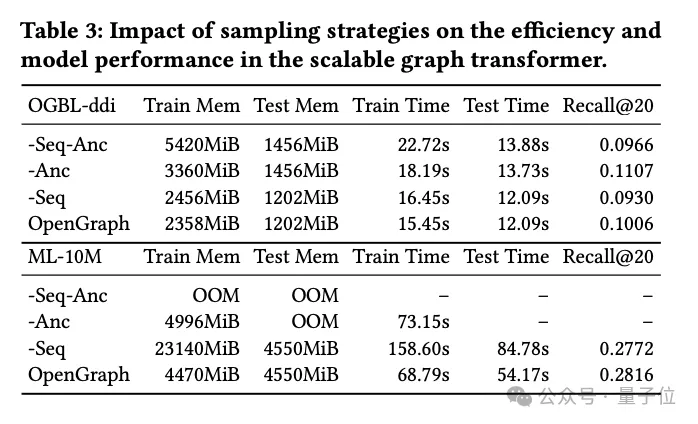

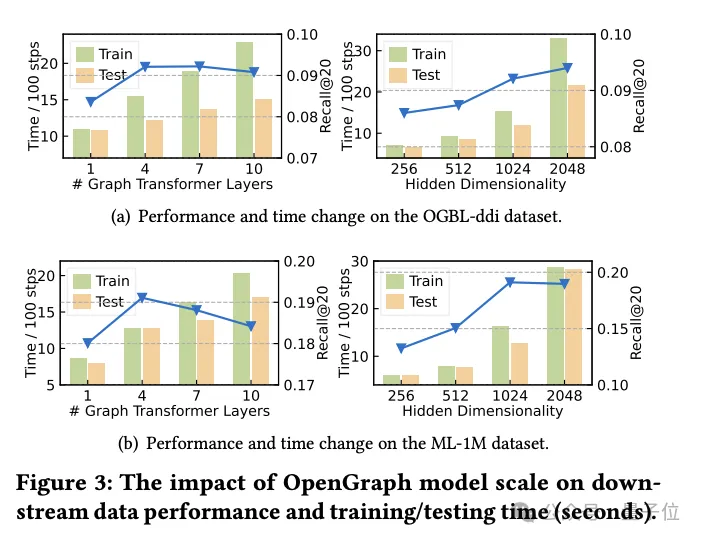

Transformer取樣技術的研究

在這部分實驗中,研究團隊探討了圖Transformer模組中所使用的兩種取樣技術:

token序列採樣(Seq)和錨點採樣(Anc)。

他們對這兩種採樣方法進行了詳細的消融實驗,以評估它們對模型性能的具體影響。

實驗結果表明,無論是token序列取樣還是錨點取樣,兩者都能在訓練和測試階段有效地減少模型的空間和時間複雜度。這對於處理大規模圖資料尤其重要,可以顯著提高效率。

從效能的角度分析,token序列取樣對模型的整體效能產生了正面影響。這種採樣策略透過選取關鍵的token來優化圖的表示,從而提高了模型處理複雜圖結構的能力。

相比之下,在ddi数据集上的实验显示,锚点采样可能对模型性能产生负面影响。锚点采样通过选择特定的节点作为锚点来简化图结构,但这种方法可能会忽略一些关键的图结构信息,从而影响模型的准确性。

综上所述,虽然这两种采样技术都有其优势,但在实际应用中需要根据具体的数据集和任务需求仔细选择合适的采样策略。

研究结论

本研究旨在开发一个高适应性框架,该框架能够精确地识别和解析各种图结构的复杂拓扑模式。

研究人员的目标是通过充分发挥所提出模型的能力,显著增强模型在零样本图学习任务中的泛化能力,包括多种下游应用。

模型是在可扩展的图Transformer架构和LLM增强的数据增强机制的支持下构建的,以提升OpenGraph的效率和健壮性。

通过在多个标准数据集上进行的广泛测试,团队证明了模型的出色泛化性能。

据了解,作为对图基础模型构建的初步尝试,未来,团队工作将着重于增加框架的自动化能力,包括自动识别噪声连接和进行反事实学习。

同时,团队计划学习和提取各种图结构的通用且可迁移的模式,进一步推动模型的应用范围和效果。

参考链接:

[1]论文: https://arxiv.org/pdf/2403.01121.pdf。

[2]源码库:https://github.com/HKUDS/OpenGraph。

以上是港大開源圖基礎大模型OpenGraph: 強泛化能力,前向傳播預測全新數據的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

git怎麼下載項目到本地

Apr 17, 2025 pm 04:36 PM

git怎麼下載項目到本地

Apr 17, 2025 pm 04:36 PM

要通過 Git 下載項目到本地,請按以下步驟操作:安裝 Git。導航到項目目錄。使用以下命令克隆遠程存儲庫:git clone https://github.com/username/repository-name.git

git怎麼更新代碼

Apr 17, 2025 pm 04:45 PM

git怎麼更新代碼

Apr 17, 2025 pm 04:45 PM

更新 git 代碼的步驟:檢出代碼:git clone https://github.com/username/repo.git獲取最新更改:git fetch合併更改:git merge origin/master推送更改(可選):git push origin master

git下載不動怎麼辦

Apr 17, 2025 pm 04:54 PM

git下載不動怎麼辦

Apr 17, 2025 pm 04:54 PM

解決 Git 下載速度慢時可採取以下步驟:檢查網絡連接,嘗試切換連接方式。優化 Git 配置:增加 POST 緩衝區大小(git config --global http.postBuffer 524288000)、降低低速限制(git config --global http.lowSpeedLimit 1000)。使用 Git 代理(如 git-proxy 或 git-lfs-proxy)。嘗試使用不同的 Git 客戶端(如 Sourcetree 或 Github Desktop)。檢查防火

git怎麼合併代碼

Apr 17, 2025 pm 04:39 PM

git怎麼合併代碼

Apr 17, 2025 pm 04:39 PM

Git 代碼合併過程:拉取最新更改以避免衝突。切換到要合併的分支。發起合併,指定要合併的分支。解決合併衝突(如有)。暫存和提交合併,提供提交消息。

git commit怎麼用

Apr 17, 2025 pm 03:57 PM

git commit怎麼用

Apr 17, 2025 pm 03:57 PM

Git Commit 是一種命令,將文件變更記錄到 Git 存儲庫中,以保存項目當前狀態的快照。使用方法如下:添加變更到暫存區域編寫簡潔且信息豐富的提交消息保存並退出提交消息以完成提交可選:為提交添加簽名使用 git log 查看提交內容

git怎麼刪除倉庫

Apr 17, 2025 pm 04:03 PM

git怎麼刪除倉庫

Apr 17, 2025 pm 04:03 PM

要刪除 Git 倉庫,請執行以下步驟:確認要刪除的倉庫。本地刪除倉庫:使用 rm -rf 命令刪除其文件夾。遠程刪除倉庫:導航到倉庫設置,找到“刪除倉庫”選項,確認操作。

如何解決PHP項目中的高效搜索問題? Typesense助你實現!

Apr 17, 2025 pm 08:15 PM

如何解決PHP項目中的高效搜索問題? Typesense助你實現!

Apr 17, 2025 pm 08:15 PM

在開發一個電商網站時,我遇到了一個棘手的問題:如何在大量商品數據中實現高效的搜索功能?傳統的數據庫搜索效率低下,用戶體驗不佳。經過一番研究,我發現了Typesense這個搜索引擎,並通過其官方PHP客戶端typesense/typesense-php解決了這個問題,大大提升了搜索性能。

git怎麼更新本地代碼

Apr 17, 2025 pm 04:48 PM

git怎麼更新本地代碼

Apr 17, 2025 pm 04:48 PM

如何更新本地 Git 代碼?用 git fetch 從遠程倉庫拉取最新更改。用 git merge origin/<遠程分支名稱> 將遠程變更合併到本地分支。解決因合併產生的衝突。用 git commit -m "Merge branch <遠程分支名稱>" 提交合併更改,應用更新。