- 原生基礎

- HTML| CSS| HTML5| CSS3| JavaScript

最新推薦

-

30分鐘學會網站佈局

152542 人學習

最新推薦

-

你的第一行UNI-APP程式碼

5487 人學習

-

Flutter 從頭到應用程式啟動

7821 人學習

最新推薦

-

AXURE 9影片教學(適用於產品經理互動產品設計UI)

3350 人學習

-

零基礎PS影片教學

180660 人學習

-

16天帶你入門UI視頻教程

48569 人學習

-

PS技巧和切片技巧影片教學

18603 人學習

最新推薦

-

阿裡雲環境搭建以及項目上線視頻教程

40936 人學習

-

電腦網路概述-程式設計師必須掌握的基礎知識

1549 人學習

-

程式設計師必備教學——HTTP協定講解

1183 人學習

-

Websocket影片教學

32909 人學習

谢邀。

6000条数据无论对于前端还是后端来说都过于巨大了,这不是中意不中意的问题,这是能做不能做的问题,答案也很简单,不能做。

如果真的有6000条数据要用js来处理,写原生js可能会提高一部分效率,假使目前js引擎的速度都提高10倍,前端OK了,后端如此大的数据量也会在个位数并发的时候直接拖垮数据库。

一次性加载6000条数据,在前端分页,不是违反最佳实践,而从根本上就是个错误的设计。

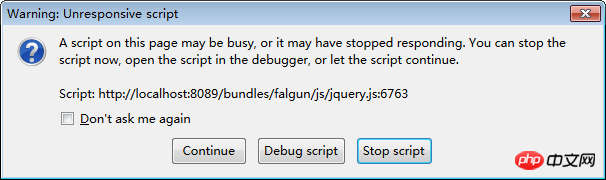

应该是有问题的,能不能查看是否代码有问题,或者这个插件有可能有内存泄露等bug。

呵呵,78MB,感觉有点...

用过前端缓存4000条数据,用的是taffy-db,无压力。

请问你6000条怎样的数据?? 是JSON吗?