hive分区(partition)简介

网上有篇关于hive的partition的使用讲解的比较好,转载了: 一、背景 1、在Hive Select查询中一般会扫描整个表内容,会消耗很多时间做没必要的工作。有时候只需要扫描表中关心的一部分数据,因此建表时引入了partition概念。 2、分区表指的是在创建表时指定

网上有篇关于hive的partition的使用讲解的比较好,转载了:

一、背景

1、在Hive Select查询中一般会扫描整个表内容,会消耗很多时间做没必要的工作。有时候只需要扫描表中关心的一部分数据,因此建表时引入了partition概念。

2、分区表指的是在创建表时指定的partition的分区空间。

3、如果需要创建有分区的表,需要在create表的时候调用可选参数partitioned by,详见表创建的语法结构。

二、技术细节

1、一个表可以拥有一个或者多个分区,每个分区以文件夹的形式单独存在表文件夹的目录下。

2、表和列名不区分大小写。

3、分区是以字段的形式在表结构中存在,通过describe table命令可以查看到字段存在,但是该字段不存放实际的数据内容,仅仅是分区的表示。

4、建表的语法(建分区可参见PARTITIONED BY参数):

CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table_name [(col_name data_type [COMMENT col_comment], ...)] [COMMENT table_comment] [PARTITIONED BY (col_name data_type [COMMENT col_comment], ...)] [CLUSTERED BY (col_name, col_name, ...) [SORTED BY (col_name [ASC|DESC], ...)] INTO num_buckets BUCKETS] [ROW FORMAT row_format] [STORED AS file_format] [LOCATION hdfs_path]

5、分区建表分为2种,一种是单分区,也就是说在表文件夹目录下只有一级文件夹目录。另外一种是多分区,表文件夹下出现多文件夹嵌套模式。

a、单分区建表语句:create table day_table (id int, content string) partitioned by (dt string);单分区表,按天分区,在表结构中存在id,content,dt三列。

b、双分区建表语句:create table day_hour_table (id int, content string) partitioned by (dt string, hour string);双分区表,按天和小时分区,在表结构中新增加了dt和hour两列。

表文件夹目录示意图(多分区表):

6、添加分区表语法(表已创建,在此基础上添加分区):

ALTER TABLE table_name ADD partition_spec [ LOCATION 'location1' ] partition_spec [ LOCATION 'location2' ] ... partition_spec: : PARTITION (partition_col = partition_col_value, partition_col = partiton_col_value, ...)

用户可以用 ALTER TABLE ADD PARTITION 来向一个表中增加分区。当分区名是字符串时加引号。例:

ALTER TABLE day_table ADD PARTITION (dt='2008-08-08', hour='08') location '/path/pv1.txt' PARTITION (dt='2008-08-08', hour='09') location '/path/pv2.txt';

7、删除分区语法:

ALTER TABLE table_name DROP partition_spec, partition_spec,...

用户可以用 ALTER TABLE DROP PARTITION 来删除分区。分区的元数据和数据将被一并删除。例:

ALTER TABLE day_hour_table DROP PARTITION (dt='2008-08-08', hour='09');

8、数据加载进分区表中语法:

LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE] INTO TABLE tablename [PARTITION (partcol1=val1, partcol2=val2 ...)]

例:

LOAD DATA INPATH '/user/pv.txt' INTO TABLE day_hour_table PARTITION(dt='2008-08- 08', hour='08'); LOAD DATA local INPATH '/user/hua/*' INTO TABLE day_hour partition(dt='2010-07- 07');

当数据被加载至表中时,不会对数据进行任何转换。Load操作只是将数据复制至Hive表对应的位置。数据加载时在表下自动创建一个目录,文件存放在该分区下。

9、基于分区的查询的语句:

SELECT day_table.* FROM day_table WHERE day_table.dt>= '2008-08-08';

10、查看分区语句:

hive> show partitions day_hour_table; OK dt=2008-08-08/hour=08 dt=2008-08-08/hour=09 dt=2008-08-09/hour=09

三、总结

1、在 Hive 中,表中的一个 Partition 对应于表下的一个目录,所有的 Partition 的数据都存储在最字集的目录中。

2、总的说来partition就是辅助查询,缩小查询范围,加快数据的检索速度和对数据按照一定的规格和条件进行管理。

——————————————————————————————————————

hive中关于partition的操作:

hive> create table mp (a string) partitioned by (b string, c string);

OK

Time taken: 0.044 seconds

hive> alter table mp add partition (b='1', c='1');

OK

Time taken: 0.079 seconds

hive> alter table mp add partition (b='1', c='2');

OK

Time taken: 0.052 seconds

hive> alter table mp add partition (b='2', c='2');

OK

Time taken: 0.056 seconds

hive> show partitions mp ;

OK

b=1/c=1

b=1/c=2

b=2/c=2

Time taken: 0.046 seconds

hive> explain extended alter table mp drop partition (b='1');

OK

ABSTRACT SYNTAX TREE:

(TOK_ALTERTABLE_DROPPARTS mp (TOK_PARTSPEC (TOK_PARTVAL b '1')))

STAGE DEPENDENCIES:

Stage-0 is a root stage

STAGE PLANS:

Stage: Stage-0

Drop Table Operator:

Drop Table

table: mp

Time taken: 0.048 seconds

hive> alter table mp drop partition (b='1');

FAILED: Error in metadata: table is partitioned but partition spec is not specified or tab: {b=1}

FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask

hive> show partitions mp ;

OK

b=1/c=1

b=1/c=2

b=2/c=2

Time taken: 0.044 seconds

hive> alter table mp add partition ( b='1', c = '3') partition ( b='1' , c='4');

OK

Time taken: 0.168 seconds

hive> show partitions mp ;

OK

b=1/c=1

b=1/c=2

b=1/c=3

b=1/c=4

b=2/c=2

b=2/c=3

Time taken: 0.066 seconds

hive>insert overwrite table mp partition (b='1', c='1') select cnt from tmp_et3 ;

hive>alter table mp add columns (newcol string);

location指定目录结构

hive> alter table alter2 add partition (insertdate='2008-01-01') location '2008/01/01';

hive> alter table alter2 add partition (insertdate='2008-01-02') location '2008/01/02';

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

【Linux系统】fdisk相关分区命令。

Feb 19, 2024 pm 06:00 PM

【Linux系统】fdisk相关分区命令。

Feb 19, 2024 pm 06:00 PM

fdisk是一个常用的Linux命令行工具,用于创建、管理和修改磁盘分区。以下是一些常用的fdisk命令:显示磁盘分区信息:fdisk-l该命令将显示系统中所有磁盘的分区信息。选择要操作的磁盘:fdisk/dev/sdX将/dev/sdX替换为要操作的实际磁盘设备名称,如/dev/sda。创建新分区:n这将引导您创建一个新的分区。按照提示输入分区类型、起始扇区、大小等信息。删除分区:d这将引导您选择要删除的分区。按照提示选择要删除的分区编号。修改分区类型:t这将引导您选择要修改类型的分区。按照提

win10安装后无法分区的解决方法

Jan 02, 2024 am 09:17 AM

win10安装后无法分区的解决方法

Jan 02, 2024 am 09:17 AM

我们再重装win10操作系统的时候,到了磁盘分区的步骤却发现出现系统提示无法创建新的分区也找不到现有分区。对于这种情况小编觉得可以尝试将整个硬盘重新进行格式化再次安装系统进行分区,或者通过软件重新进行系统安装等等。具体内容就来看看小编是怎么做的吧~希望可以帮助到你。安装win10无法创建新的分区怎么办方法一:格式化整个硬盘重新分区或尝试插拔U盘几次并刷新,如果你的硬盘上没有重要数据的话,到了分区这一步时,将硬盘上的所有分区都删除了。重新格式化整个硬盘,然后重新分区,再进行安装就正常了。方法二:P

Python ORM 性能基准测试:比较不同 ORM 框架

Mar 18, 2024 am 09:10 AM

Python ORM 性能基准测试:比较不同 ORM 框架

Mar 18, 2024 am 09:10 AM

对象关系映射(ORM)框架在python开发中扮演着至关重要的角色,它们通过在对象和关系数据库之间建立桥梁,简化了数据访问和管理。为了评估不同ORM框架的性能,本文将针对以下流行框架进行基准测试:sqlAlchemyPeeweeDjangoORMPonyORMTortoiseORM测试方法基准测试使用了一个包含100万条记录的SQLite数据库。测试对数据库执行了以下操作:插入:向表中插入10,000条新记录读取:读取表中的所有记录更新:更新表中所有记录的单个字段删除:删除表中的所有记录每个操作

如何在Windows 11中增加WinRE分区大小

Feb 19, 2024 pm 06:06 PM

如何在Windows 11中增加WinRE分区大小

Feb 19, 2024 pm 06:06 PM

在这篇文章中,我们将向您展示如何在Windows11/10中更改或增加WinRE分区大小。微软现在将在每月累积更新的同时更新Windows恢复环境(WinRE),开始于Windows11版本22H2。然而,并非所有计算机都有足够大的恢复分区以容纳新的更新,这可能导致出现错误消息。Windows恢复环境服务失败如何在Windows11中增加WinRE分区大小要在您的计算机上手动增加WinRE分区大小,请执行下面提到的步骤。检查并禁用WinRE缩小操作系统分区创建新的恢复分区确认分区并启用WinRE

详解Linux Opt分区的设置方法

Mar 20, 2024 am 11:30 AM

详解Linux Opt分区的设置方法

Mar 20, 2024 am 11:30 AM

LinuxOpt分区的设置方法及代码示例在Linux系统中,Opt分区通常用于存储可选软件包和应用程序数据。合理设置Opt分区可以有效管理系统资源,避免磁盘空间不足等问题。本文将详细介绍如何设置LinuxOpt分区,并提供具体的代码示例。1.确定分区空间大小首先,我们需要确定Opt分区所需的空间大小。一般建议将Opt分区的大小设置为系统总空间的5%-1

Win11怎么分区硬盘分区?win11磁盘怎么分区硬盘教程

Feb 19, 2024 pm 06:01 PM

Win11怎么分区硬盘分区?win11磁盘怎么分区硬盘教程

Feb 19, 2024 pm 06:01 PM

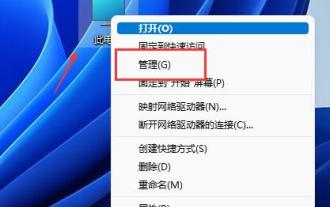

不少的用户们觉得系统默认的分区空间太小了,那么Win11如何分区硬盘分区?用户们可以直接的点击此电脑下的管理,然后点击磁盘管理来进行操作设置就可以了。下面就让本站来为用户们来仔细的介绍一下win11磁盘怎么分区硬盘教程吧。win11磁盘怎么分区硬盘教程1、首先右键此电脑,打开计算机管理。3、然后查看右侧磁盘情况,是否有可用空间。(如果有可用空间就跳到第6步)。5、然后选择需要腾出的空间量,点击压缩。7、再输入想要的简单卷大小,点击下一页。9、最后点击完成就可以创建新的分区了。

Python ORM 在大数据项目中的应用

Mar 18, 2024 am 09:19 AM

Python ORM 在大数据项目中的应用

Mar 18, 2024 am 09:19 AM

对象关系映射(ORM)是一种编程技术,允许开发人员使用对象编程语言来操作数据库,而无需直接编写sql查询。python中的ORM工具(例如SQLAlchemy、Peewee和DjangoORM)简化了大数据项目的数据库交互。优点代码简洁性:ORM消除了编写冗长的SQL查询的需要,这提高了代码简洁性和可读性。数据抽象:ORM提供了一个抽象层,将应用程序代码与数据库实现细节隔离开来,提高了灵活性。性能优化:ORM通常会使用缓存和批量操作来优化数据库查询,从而提高性能。可移植性:ORM允许开发人员在不

如何对磁盘进行分区管理

Feb 25, 2024 pm 03:33 PM

如何对磁盘进行分区管理

Feb 25, 2024 pm 03:33 PM

磁盘管理怎么分区随着电脑技术的不断发展,磁盘管理也成为了我们电脑使用过程中必不可少的一部分。而磁盘分区作为磁盘管理的重要环节,它可以将一个硬盘划分为多个部分,使得我们能够更加灵活地存储和管理数据。那么,磁盘管理怎么分区呢?下面,我将给大家详细介绍。首先,我们需要明确一点,磁盘分区并非只有一种分法,根据不同的需求和目的,我们可以灵活地选择合适的磁盘分区方式。常