NGUI研究之3D模型坐标转2D屏幕坐标

刚好今天有朋友问我,比较典型的例子就是游戏里面人物的血条。原理很简单就是把3D点换算成2D的点,但是由于NGUI自身是3D所以我们需要先把NGUI下的点转成2D点,然后在把他转成3D的点。听起来有点绕,不要紧我直接上代码。对屏幕自适应不明白的看NGUI研究之如

刚好今天有朋友问我,比较典型的例子就是游戏里面人物的血条。原理很简单就是把3D点换算成2D的点,但是由于NGUI自身是3D所以我们需要先把NGUI下的点转成2D点,然后在把他转成3D的点。听起来有点绕,不要紧我直接上代码。对屏幕自适应不明白的看NGUI研究之如何自适应屏幕

目前我一直都是用NGUI来做人物血条,但是2D血条都会有个限制,就是它不能和模型有遮挡关系。不过血条可以根据人物的位置调节,比如远一点的人物血条会小一些,近一点的人物血条会大一些。

最好让美术做FBX的时候直接内置一个GameObject 的点,因为模型有的高有的低,所以血条的位置高度是不一样的,如果美术内置的话可以让美术来调节模型头顶上的点,这样比较方便。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 |

using UnityEngine; using System.Collections;

publicclassNewBehaviourScript :MonoBehaviour{

//角色 publicTransform Cube; //角色的血条 publicTransform UI;

//默认血条缩与摄像机的距离 privatefloatFomat; //角色头顶的点, 最好让美术把这个点直接做在fbx模型里面。 privateTransform Head;

voidStart() { //找到角色身上头顶的点 Head=Cube.Find("head"); //计算以下默认血条的距离,也可以写个常量,就是标记一下 Fomat =Vector3.Distance(Head.position,Camera.main.transform.position); }

voidUpdate() { //这里可以判断一下 如果位置没有变化就不要在赋值了 floatnewFomat=Fomat/Vector3.Distance(Head.position,Camera.main.transform.position); UI.position =WorldToUI(Head.position); //计算出血条的缩放比例 UI.localScale=Vector3.one *newFomat;

//测试代码,按下W S键前后移动角色 if(Input.GetKey(KeyCode.W)) Cube.Translate(Vector3.forward); if(Input.GetKey(KeyCode.S)) Cube.Translate(Vector3.back); }

//核心代码在这里把3D点换算成NGUI屏幕上的2D点。 publicstaticVector3 WorldToUI(Vector3 point) { Vector3 pt=Camera.main.WorldToScreenPoint(point); //我发现有时候UICamera.currentCamera 有时候currentCamera会取错,取的时候注意一下啊。 Vector3 ff= UICamera.currentCamera.ScreenToWorldPoint(pt); //UI的话Z轴 等于0 ff.z=0; returnff; } } |

再说一下,一般血条可能都是由多个UISprite组成,那么最好把这些Sprite都挂在同一个GameObject下面,这样只需要修正父对象,所以子对象的缩放都会正确。控制角色移动近一点的截图。

控制角色移动远一点的截图,你会发现血条在屏幕上的比例是不会变化的。

祝大家学习愉快,欢迎讨论,嘿嘿嘿嘿

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最强开源 MoE 模型来了,中文能力比肩 GPT-4,价格仅为 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想象一下,一个人工智能模型,不仅拥有超越传统计算的能力,还能以更低的成本实现更高效的性能。这不是科幻,DeepSeek-V2[1],全球最强开源MoE模型来了。DeepSeek-V2是一个强大的专家混合(MoE)语言模型,具有训练经济、推理高效的特点。它由236B个参数组成,其中21B个参数用于激活每个标记。与DeepSeek67B相比,DeepSeek-V2性能更强,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,最大生成吞吐量提高到5.76倍。DeepSeek是一家探索通用人工智

iPhone屏幕截图不起作用:如何修复

May 03, 2024 pm 09:16 PM

iPhone屏幕截图不起作用:如何修复

May 03, 2024 pm 09:16 PM

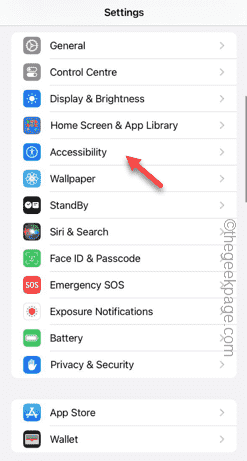

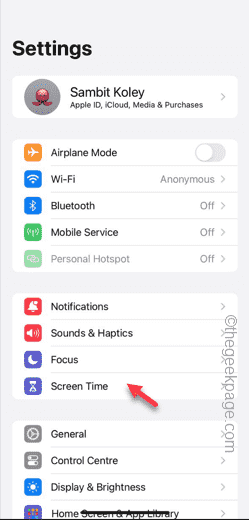

屏幕截图功能在您的iPhone上不起作用吗?截屏非常简单,因为您只需同时按住“提高音量”按钮和“电源”按钮即可抓取手机屏幕。但是,还有其他方法可以在设备上捕获帧。修复1–使用辅助触摸使用辅助触摸功能截取屏幕截图。步骤1–转到您的手机设置。步骤2–接下来,点击以打开“辅助功能”设置。步骤3–打开“触摸”设置。步骤4–接下来,打开“辅助触摸”设置。步骤5–打开手机上的“辅助触摸”。步骤6–打开“自定义顶级菜单”以访问它。步骤7–现在,您只需将这些功能中的任何一个链接到屏幕捕获即可。因此,点击那里的首

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

你好,电动Atlas!波士顿动力机器人复活,180度诡异动作吓坏马斯克

Apr 18, 2024 pm 07:58 PM

波士顿动力Atlas,正式进入电动机器人时代!昨天,液压Atlas刚刚「含泪」退出历史舞台,今天波士顿动力就宣布:电动Atlas上岗。看来,在商用人形机器人领域,波士顿动力是下定决心要和特斯拉硬刚一把了。新视频放出后,短短十几小时内,就已经有一百多万观看。旧人离去,新角色登场,这是历史的必然。毫无疑问,今年是人形机器人的爆发年。网友锐评:机器人的进步,让今年看起来像人类的开幕式动作、自由度远超人类,但这真不是恐怖片?视频一开始,Atlas平静地躺在地上,看起来应该是仰面朝天。接下来,让人惊掉下巴

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被开源项目扩展到卷积了

Jun 01, 2024 pm 10:03 PM

本月初,来自MIT等机构的研究者提出了一种非常有潜力的MLP替代方法——KAN。KAN在准确性和可解释性方面表现优于MLP。而且它能以非常少的参数量胜过以更大参数量运行的MLP。比如,作者表示,他们用KAN以更小的网络和更高的自动化程度重现了DeepMind的结果。具体来说,DeepMind的MLP有大约300,000个参数,而KAN只有约200个参数。KAN与MLP一样具有强大的数学基础,MLP基于通用逼近定理,而KAN基于Kolmogorov-Arnold表示定理。如下图所示,KAN在边上具

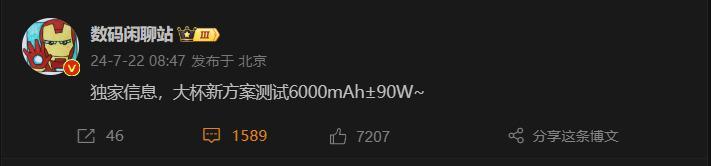

6000 毫安硅负极电池!小米 15Pro 升级再曝料

Jul 24, 2024 pm 12:45 PM

6000 毫安硅负极电池!小米 15Pro 升级再曝料

Jul 24, 2024 pm 12:45 PM

7月23日消息,博主数码闲聊站爆料称,小米15Pro电池容量增大至6000mAh,支持90W有线闪充,这将是小米数字系列电池最大的Pro机型。此前数码闲聊站透露,小米15Pro的电池拥有超高能量密度,硅含量远高于竞品。硅基电池在2023年大规模试水后,第二代硅负极电池被确定为行业未来发展方向,今年将迎来直接竞争的高峰。1.硅的理论克容量可达4200mAh/g,是石墨克容量的10倍以上(石墨的理论克容量372mAh/g)。对于负极而言,当锂离子嵌入量达到最大时的容量为理论克容量,这意味着相同重量下

屏幕录制变黑:这是修复

May 03, 2024 pm 09:13 PM

屏幕录制变黑:这是修复

May 03, 2024 pm 09:13 PM

您是否正在尝试在手机屏幕上录制某些内容,并且它正在变黑?通常,您可以从控制中心启动屏幕录制。在某些情况下,您无法在屏幕上录制项目。我们已经提到了所有方案以及可以帮助您正常录制屏幕的可能解决方案列表。屏幕录制变黑的原因–如果您在iPhone屏幕上播放时尝试录制任何受DRM(数字版权管理)保护的内容,您将无法得到任何东西。输出将是一个漆黑的屏幕。所有领先的OTT平台,如Netflix、Disney+、Hulu和Peacock,都有这个DRM,可以阻止任何屏幕录制功能。2.有几个网站禁止使用屏幕捕获

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人进厂打工,马斯克:手的自由度今年将达到22个!

May 06, 2024 pm 04:13 PM

特斯拉机器人Optimus最新视频出炉,已经可以在厂子里打工了。正常速度下,它分拣电池(特斯拉的4680电池)是这样的:官方还放出了20倍速下的样子——在小小的“工位”上,拣啊拣啊拣:这次放出的视频亮点之一在于Optimus在厂子里完成这项工作,是完全自主的,全程没有人为的干预。并且在Optimus的视角之下,它还可以把放歪了的电池重新捡起来放置,主打一个自动纠错:对于Optimus的手,英伟达科学家JimFan给出了高度的评价:Optimus的手是全球五指机器人里最灵巧的之一。它的手不仅有触觉

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首个基于鱼眼相机的目标检测算法

Apr 26, 2024 am 11:37 AM

目标检测在自动驾驶系统当中是一个比较成熟的问题,其中行人检测是最早得以部署算法之一。在多数论文当中已经进行了非常全面的研究。然而,利用鱼眼相机进行环视的距离感知相对来说研究较少。由于径向畸变大,标准的边界框表示在鱼眼相机当中很难实施。为了缓解上述描述,我们探索了扩展边界框、椭圆、通用多边形设计为极坐标/角度表示,并定义一个实例分割mIOU度量来分析这些表示。所提出的具有多边形形状的模型fisheyeDetNet优于其他模型,并同时在用于自动驾驶的Valeo鱼眼相机数据集上实现了49.5%的mAP