公式化描述EMC中国实验室的"研究2.0"

今天让我来对EMC中国实验室的"研究2.0"作一个公式化的介绍. IBM 的 James Snell 对于 Web2.0 给出了一个有名的"程序员呆子"式的(geeky)定义: "Web2.0 = chmod 777 web". 我虽然不敢自我标榜为"程序员呆子",但曾经干过几天程序员的历史背景使我非常喜欢这个"

今天让我来对EMC中国实验室的"研究2.0"作一个公式化的介绍.

IBM 的 James Snell 对于 Web2.0 给出了一个有名的"程序员呆子"式的(geeky)定义: "Web2.0 = chmod 777 web". 我虽然不敢自我标榜为"程序员呆子",但曾经干过几天程序员的历史背景使我非常喜欢这个"程序员呆子"公式. 现对其作出如下延伸: “Research2.0 = chmod 777 Research”. 虽然充满"程序员呆子"气,这个公式却是对EMC中国实验室正在实践中的"研究2.0"尝试所作出的一个精辟的公式化描述.

首先,我们的研究人员与公司其它核心实验室(如著名的RSA实验室, 与EMC中国实验室同隶属于EMC全球创新网络)的同事们保持着密切的研究合作关系.这种公司内核心实验室之间的研究合作可由上述公式中的"7--"部分来表达. 同时我们也致力于把研究成果介绍给公司内位于全球各地的工程师们,并经常向他们征求反馈意见及用户需求.这种由核心实验室向公司各产品开发部门知识的交流与共享可由公式中的"-7-"部分来表达. 最后是十分重要的一条, 我们与全球大学及研究社区合作伙伴们的公开性合作研究(当然在中国我们与中国大学的合作更为广泛,深入而且密切).这一条也是使我们研究人员获得及生成知识的最有效途径,可以用上述公式中的"--7"部分来表达.

"程序员呆子"们可以跳过以下圆括号中的内容(请注意:7的二进制表达是111三个比特). Linux 或 Unix "程序员呆子"们可以跳过以下方括号中的内容[111三个比特中第一个比特代表"读"操作特权,第二个代表"写"操作特权,而第三个代表"执行"操作特权]

如上所述在三个范围内的全方位合作都是在知识共享的方式下进行的,所以每一个7都表示合作者们都具有"读"操作特权. 合作者们积极贡献知识的交流方式当然包含研究论文写作及发表,有用程序的设计及开发.所以每一个7都又表示合作者们都具有"写"操作特权, 即人人都是发布者. 至于每一个7都还表示合作者们的"执行"操作特权嘛, 就用我们与合作者们都特别喜欢倒弄开源软件这个事实来表达吧.(所谓倒弄开源软件, 是指包含使用,开发,试验开源软件,参与开源社区活动,并将我们的结果又以开源软件贡献回馈给开源社区).

基于"研究2.0"的理念,EMC中国实验室领导开发了道里维基网站: www.daoliproject.org 这是一个Web2.0式的网站. 欢迎大家来道里维基访问. 请记住, 您可以成为一个参与者, 请给自己设制上读,写,及执行的特权!

Extending James Snell’s geeky definition of web 2.0 as “chmod 777 web” to our notion of Research 2.0, we use “chmod 777 research” to describe our research practice in EMC Research China. It involves intra-EIN collaborations among core research labs (the 1st 7), cross-EMC-organization collaborations with globally distributed Advanced Development Groups and Centers of Excellence (the 2nd 7), and world-wide collaborations with universities and external business partners (the 3rd 7). Moreover, these collaborations feature openness in knowledge sharing (set all the read bits), ease of making contributions (set all the write bits), and roll-up-the-sleeves style of execution including getting our hands dirty with open-source code (set all the execution bits). ERC has already implemented an example of Research 2.0. The Daoli twiki www.daoliproject.org, which has been in the spotlight since its recent debut in early June, can be regarded as a prototype of our executing “chmod 777 research”. The Daoli twiki has more than 70 pages, which were created in less than one month through the collaborative efforts of ERC staff members and our partners at four universities working concurrently. It is kept up-to-date through efficient maintenance by distributed teams and monitored through email notifications used to prevent malicious modifications.

原文是作者当天在道里博客上发表的 http://daoliproject.org/wordpress/

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

深入探讨模型、数据和框架:一份详尽的54页高效大语言模型综述

Jan 14, 2024 pm 07:48 PM

深入探讨模型、数据和框架:一份详尽的54页高效大语言模型综述

Jan 14, 2024 pm 07:48 PM

大规模语言模型(LLMs)在许多重要任务中展现出了引人注目的能力,包括自然语言理解、语言生成和复杂推理,并对社会产生了深远的影响。然而,这些出色的能力却需要大量的训练资源(如左图所示)和较长的推理时间(如右图所示)。因此,研究人员需要开发有效的技术手段来解决它们的效率问题。此外,从图的右侧还可以看出,一些高效的LLMs(LanguageModels)如Mistral-7B,已经成功应用于LLMs的设计和部署中。这些高效的LLMs在保持与LLaMA1-33B相近的准确性的同时,能够大大减少推理内存

多模态大模型最全综述来了!7位微软研究员大力合作,5大主题,成文119页

Sep 25, 2023 pm 04:49 PM

多模态大模型最全综述来了!7位微软研究员大力合作,5大主题,成文119页

Sep 25, 2023 pm 04:49 PM

多模态大模型最全综述来了!由微软7位华人研究员撰写,足足119页——它从目前已经完善的和还处于最前沿的两类多模态大模型研究方向出发,全面总结了五个具体研究主题:视觉理解视觉生成统一视觉模型LLM加持的多模态大模型多模态agent并重点关注到一个现象:多模态基础模型已经从专用走向通用。Ps.这也是为什么论文开头作者就直接画了一个哆啦A梦的形象。谁适合阅读这份综述(报告)?用微软的原话来说:只要你有兴趣学习多模态基础模型的基础知识和最新进展,无论你是专业研究员还是在校学生,这个内容都非常适合你一起来

碾压H100,英伟达下一代GPU曝光!首个3nm多芯片模块设计,2024年亮相

Sep 30, 2023 pm 12:49 PM

碾压H100,英伟达下一代GPU曝光!首个3nm多芯片模块设计,2024年亮相

Sep 30, 2023 pm 12:49 PM

3纳米制程,性能超越H100!最近,据外媒DigiTimes爆料,英伟达正在开发下一代GPU,代号为「Blackwell」的B100据称,作为面向人工智能(AI)和高性能计算(HPC)应用的产品,B100将采用台积电的3nm工艺制程,以及更为复杂的多芯片模块(MCM)设计,并将于2024年第四季度现身。对于垄断了人工智能GPU市场80%以上份额的英伟达来说,则可以借着B100趁热打铁,在这波AI部署的热潮中进一步狙击AMD、英特尔等挑战者。根据英伟达的估计,到2027年,该领域的产值预计将达到约

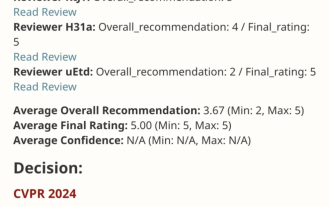

VPR 2024 满分论文!Meta提出EfficientSAM:快速分割一切!

Mar 02, 2024 am 10:10 AM

VPR 2024 满分论文!Meta提出EfficientSAM:快速分割一切!

Mar 02, 2024 am 10:10 AM

EfficientSAM这篇工作以5/5/5满分收录于CVPR2024!作者在某社交媒体上分享了该结果,如下图所示:LeCun图灵奖得主也强烈推荐了该工作!在近期的研究中,Meta研究者提出了一种新的改进方法,即使用SAM的掩码图像预训练(SAMI)。这一方法结合了MAE预训练技术和SAM模型,旨在实现高质量的预训练ViT编码器。通过SAMI,研究者试图提高模型的性能和效率,为视觉任务提供更好的解决方案。这一方法的提出为进一步探索和发展计算机视觉和深度学习领域带来了新的思路和机遇。通过结合不同的

SD社区的I2V-Adapter:无需配置,即插即用,完美兼容图生视频插件

Jan 15, 2024 pm 07:48 PM

SD社区的I2V-Adapter:无需配置,即插即用,完美兼容图生视频插件

Jan 15, 2024 pm 07:48 PM

图像到视频生成(I2V)任务是计算机视觉领域的一项挑战,旨在将静态图像转化为动态视频。这个任务的难点在于从单张图像中提取并生成时间维度的动态信息,同时保持图像内容的真实性和视觉上的连贯性。现有的I2V方法通常需要复杂的模型架构和大量的训练数据来实现这一目标。近期,快手主导的一项新研究成果《I2V-Adapter:AGeneralImage-to-VideoAdapterforVideoDiffusionModels》发布。该研究引入了一种创新的图像到视频转换方法,提出了一种轻量级适配器模块,即I

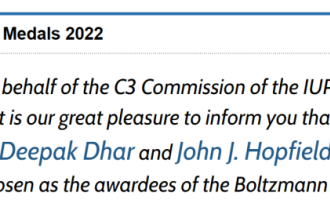

揭晓2022年玻尔兹曼奖:Hopfield网络创始人荣获奖项

Aug 13, 2023 pm 08:49 PM

揭晓2022年玻尔兹曼奖:Hopfield网络创始人荣获奖项

Aug 13, 2023 pm 08:49 PM

两位获得2022年玻尔兹曼奖的科学家已经公布,这个奖项由IUPAP统计物理委员会(C3)设立,旨在表彰在统计物理学领域取得杰出成就的研究者。获奖者必须是之前没有获得过玻尔兹曼奖或诺贝尔奖的科学家。这个奖项始于1975年,每三年颁发一次,以纪念统计物理学的奠基人路德维希·玻尔兹曼DeepakDharistheoriginalstatement.获奖理由:表彰DeepakDharistheoriginalstatement.对统计物理学领域作出的开创性贡献,包括自组织临界模型的精确解、界面生长、无序

谷歌AI新星转投Pika:视频生成Lumiere一作,担任创始科学家

Feb 26, 2024 am 09:37 AM

谷歌AI新星转投Pika:视频生成Lumiere一作,担任创始科学家

Feb 26, 2024 am 09:37 AM

视频生成进展如火如荼,Pika迎来一位大将——谷歌研究员OmerBar-Tal,担任Pika创始科学家。一个月前,还在谷歌以共同一作的身份发布视频生成模型Lumiere,效果十分惊艳。当时网友表示:谷歌加入视频生成战局,又有好戏可看了。StabilityAICEO、谷歌前同事等在内一些业内人士送上了祝福。Lumiere一作,刚硕士毕业OmerBar-Tal,2021年本科毕业于特拉维夫大学的数学与计算机系,随后前往魏茨曼科学研究所攻读计算机硕士,主要聚焦于图像和视频合成领域的研究。其论文成果多次

统一图像和文字生成的MiniGPT-5来了:Token变Voken,模型不仅能续写,还会自动配图了

Oct 11, 2023 pm 12:45 PM

统一图像和文字生成的MiniGPT-5来了:Token变Voken,模型不仅能续写,还会自动配图了

Oct 11, 2023 pm 12:45 PM

大型模型正在实现语言和视觉之间的跨越,有望无缝地理解和生成文本和图像内容。在最近的一系列研究中,多模态特征集成不仅是一个不断发展的趋势,而且已经带来了从多模态对话到内容创建工具等关键进步。大型语言模型在文本理解和生成方面已经展现出无与伦比的能力。然而,同时生成具有连贯文本叙述的图像仍然是一个有待发展的领域近日,加州大学圣克鲁兹分校的研究团队提出了MiniGPT-5,这是一种以「生成式voken」概念为基础的创新型交错视觉语言生成技术。论文地址:https://browse.arxiv.org/p