Hadoop 临时目录

今天早上的报表没有出来,报表是从用 hadoop 进行跑的 一看 hadoop 相关日志,报如下错误 Message: org.apache.hadoop.ipc.RemoteException: java.io.IOException: org.apache.hadoop.fs.FSError: java.io.IOException: No space left on device 咋一看, 以为

今天早上的报表没有出来,报表是从用 hadoop 进行跑的

一看 hadoop 相关日志,报如下错误

<code>Message: org.apache.hadoop.ipc.RemoteException: java.io.IOException: org.apache.hadoop.fs.FSError: java.io.IOException: No space left on device </code>

咋一看, 以为是 hdfs没空间了,运行如下命令

<code> hadoop dfsadmin -report

Configured Capacity: 44302785945600 (40.29 TB)

Present Capacity: 42020351946752 (38.22 TB)

DFS Remaining: 8124859072512 (7.39 TB)

DFS Used: 33895492874240 (30.83 TB)

DFS Used%: 80.66%

Under replicated blocks: 1687

Blocks with corrupt replicas: 0

Missing blocks: 0

</code>从输出的结果来看,dfs的空间还很大,所以”No space left on device”这样的错误应该不是hdfs的问题

应该是本地磁盘的问题,发现hadoop运行时,要用到一个临时目录,可以在core-site.xml文件中配置

<code>hadoop.tmp.dir </code>

默认的路径是 /tmp/hadoop-${user.name}

看了一下 /tmp/的空间,确实很小了,把hadoop.tmp.dir挂到一个大一点的盘上就可以了

hadoop.tmp.dir是其它临时目录的父目录

但是一个问题还没有解决, hadoop.tmp.dir到底需要多大空间呢?怎么样计算呢?

common-question-and-requests-from-our-users

原文地址:Hadoop Tmp Dir, 感谢原作者分享。

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

7652

7652

15

15

1393

1393

52

52

91

91

11

11

73

73

19

19

37

37

110

110

/tmp/文件夹在Linux系统中的清理原理及tmp文件的作用

Dec 21, 2023 pm 05:36 PM

/tmp/文件夹在Linux系统中的清理原理及tmp文件的作用

Dec 21, 2023 pm 05:36 PM

.tmp文件大部分都是因为不正常关机、或死机后所留下的文件,这些临时的暂存盘,在你重新开机后,已经没有任何的用途,可以放心删除。大家在使用Windows操作系统的时候,可能会经常在C盘根目录发现一些后缀名为TMP的文件,还会在Windows目录里发现一个TEMP的目录,TMP文件是各种软件或系统产生的临时文件,也就是常说的垃圾文件。Windows产生的临时文件,本质上和虚拟内存没什么两样,只不过临时文件比虚拟内存更具有针对性,单独为某个程序服务而已。而它的专一性导致了许多新手对他望而生畏,不删占

如何在CentOS 7中访问并清理/tmp目录中的垃圾文件?

Dec 27, 2023 pm 09:10 PM

如何在CentOS 7中访问并清理/tmp目录中的垃圾文件?

Dec 27, 2023 pm 09:10 PM

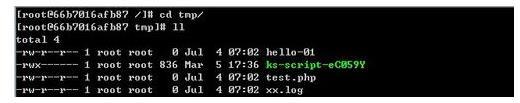

centos7系统中tmp目录下有很多垃圾,想要清除垃圾,该怎么清除呢?下面我们就来看看详细的教程。查看tmp文件目录下文件列表,执行命令cdtmp/切换到tmp当前文件目录,执行ll命令,查看当前目录下文件列表。如下图所示。使用rm删除文件命令,需要注意的是rm命令是将文件永远从系统中删除,因此建议在使用rm命令时,最好是在删除文件前给出提示。使用命令rm-i文件名,等用户确认删除(y)或跳过删除(n),系统进行相应的操作。如下图所示。

linux中tmp什么意思

Mar 10, 2023 am 09:26 AM

linux中tmp什么意思

Mar 10, 2023 am 09:26 AM

linux中tmp指的是一个存储临时文件的文件夹,该文件夹包含系统和用户创建的临时文件;tmp文件夹的默认时限是30天,30天不访问的tmp下的文件会被系统自动删除的。

Java错误:Hadoop错误,如何处理和避免

Jun 24, 2023 pm 01:06 PM

Java错误:Hadoop错误,如何处理和避免

Jun 24, 2023 pm 01:06 PM

Java错误:Hadoop错误,如何处理和避免当使用Hadoop处理大数据时,常常会遇到一些Java异常错误,这些错误可能会影响任务的执行,导致数据处理失败。本文将介绍一些常见的Hadoop错误,并提供处理和避免这些错误的方法。Java.lang.OutOfMemoryErrorOutOfMemoryError是Java虚拟机内存不足的错误。当Hadoop任

TmP是什么文件?

Dec 25, 2023 pm 03:39 PM

TmP是什么文件?

Dec 25, 2023 pm 03:39 PM

“tmp”文件是临时文件,通常由操作系统或程序在运行过程中产生,用于存储临时数据或程序运行时的中间结果。这些文件主要用于帮助程序顺利执行,但它们在程序执行完毕后通常会被自动删除。tmp文件通常可以在Windows系统的C盘根目录下找到。然而,tmp文件与特定应用程序或系统有关,因此它们的具体内容和用途可能因应用程序而异。

tmp是什么文件

Feb 22, 2023 pm 02:35 PM

tmp是什么文件

Feb 22, 2023 pm 02:35 PM

tmp是各种软件或系统产生的临时文件,也就是常说的垃圾文件。通常,创建临时文件的程序会在完成时将其删除,但有时候这些文件会被保留。临时文件被保留的原因可能有多种:程序可能在完成安装前被中断,或在重新启动时崩溃;对于这些文件,一般没有什么使用价值,我们可以直接将其删除。

在Beego中使用Hadoop和HBase进行大数据存储和查询

Jun 22, 2023 am 10:21 AM

在Beego中使用Hadoop和HBase进行大数据存储和查询

Jun 22, 2023 am 10:21 AM

随着大数据时代的到来,数据处理和存储变得越来越重要,如何高效地管理和分析大量的数据也成为企业面临的挑战。Hadoop和HBase作为Apache基金会的两个项目,为大数据存储和分析提供了一种解决方案。本文将介绍如何在Beego中使用Hadoop和HBase进行大数据存储和查询。一、Hadoop和HBase简介Hadoop是一个开源的分布式存储和计算系统,它可

如何使用PHP和Hadoop进行大数据处理

Jun 19, 2023 pm 02:24 PM

如何使用PHP和Hadoop进行大数据处理

Jun 19, 2023 pm 02:24 PM

随着数据量的不断增大,传统的数据处理方式已经无法处理大数据时代带来的挑战。Hadoop是开源的分布式计算框架,它通过分布式存储和处理大量的数据,解决了单节点服务器在大数据处理中带来的性能瓶颈问题。PHP是一种脚本语言,广泛应用于Web开发,而且具有快速开发、易于维护等优点。本文将介绍如何使用PHP和Hadoop进行大数据处理。什么是HadoopHadoop是