HBase实战系列1—压缩与编码技术

1、hbase压缩与编码的配置 安装LZO 解决方案: 1)apt-get install liblzo2-dev 2)hadoop-gpl-compression-0.2.0-dev.jar 放入classpath 把libgpl下的共享库文件放入/opt/hbase/hbase/lib/native/Linux-amd64-64/ libgplcompression.a libgplcompression.la

1、hbase压缩与编码的配置

安装LZO

解决方案:

1)apt-get install liblzo2-dev

2)hadoop-gpl-compression-0.2.0-dev.jar 放入classpath

把libgpl下的共享库文件放入/opt/hbase/hbase/lib/native/Linux-amd64-64/

libgplcompression.a libgplcompression.la libgplcompression.so libgplcompression.so.0 libgplcompression.so.0.0.0

3)配置:

4)测试:

hbase org.apache.hadoop.hbase.util.CompressionTest hdfs:///user.dat lzo

创建表格时,针对ColumnFamily设置压缩和编码方式。

HColumnDescriptor.setCompressionType(Compression.Algorithm.NONE);

HColumnDescriptor.setDataBlockEncoding(DataBlockEncoding.NONE);

使用FAST_DIFF 与 LZO之后的压缩情况:

hbase@GS-WDE-SEV0151:/opt/hbase/hbase$ hadoop fs -dus /hbase-weibo/weibo_test

hdfs://hbase-hdfs.goso.cn:9000/hbase-weibo/weibo_test???? 1021877013

hbase@GS-WDE-SEV0151:/opt/hbase/hbase$ hadoop fs -dus /hbase-weibo/weibo_lzo

hdfs://hbase-hdfs.goso.cn:9000/hbase-weibo/weibo_lzo???? 1179175365

hbase@GS-WDE-SEV0151:/opt/hbase/ops$ hadoop fs -dus /hbase-weibo/weibo_diff

hdfs://hbase-hdfs.goso.cn:9000/hbase-weibo/weibo_diff???? 2754679243

hbase@GS-WDE-SEV0151:/opt/hbase/hbase$ hadoop fs -dus /hbase-weibo/weibo-new

hdfs://hbase-hdfs.goso.cn:9000/hbase-weibo/weibo-new???? 5270708315

忽略数据中出现的Delete的数据、多个版本、以及超时的数据,压缩比达到1:5。

单独使用LZO的配置的压缩可接近也接近5:1的压缩比。

单独使用FAST_DIFF编码可以接近5:2的压缩比。

HBase操作过程:

Finish DataBlock–>Encoding DataBlock(FAST_DIFF\PREFIX\PREFIX_TRIE\DIFF)—>Compression DataBlock(LZO\GZ) —>Flush到磁盘。

如果Encoding和Compression的方式都设置NONE,中间的过程即可忽略。

2、相关测试

weibo-new使用的NONE、NONE

weibo_test使用的LZO、FAST_DIFF

weibo_diff使用了FAST_DIFF

weibo_lzo使用了LZO压缩

1、测试 扫描的效率:

| 个数 | 耗时 | |

| weibo_test | 2314054 | ??3m49.661s |

| weibo-new | 2314054 | ??1m55.349s |

| weibo_lzo | 2314054 | ? 3m24.378s |

| weibo_diff | 2314054 | ?4m41.792s |

结果分析:

使用LZO压缩或者FAST_DIFF的编码,扫描时造成大概一倍的开销

这个原因在于:在当前存储容量下,网络IO不是瓶颈,使用基本配置weibo-new吞吐量达到了45.68MB/s,而使用LZO压缩,显然经过一次或者两次解码之后,消耗了一些CPU时间片,从而耗时较长。

2、随机读的效率,采用单条随机的办法

首先scan出所有的Row,然后,使用shuf -n1000000 /tmp/row 随机取出1000000个row,然后按照单线程随机读的方式获取。

ps:每个Record有3个ColumnFamily,共有31个Column。

| 个数 | 耗时 | |

| weibo_test | 100,0000 | 122min12s, 平均7.3ms/Record |

| weibo-new | 100,0000 | 68min40s, 平均3.99ms/Record |

| weibo_lzo | 100,0000 | 83m26.539s, 平均5.00ms/Record |

| weibo_diff | 100,0000 | 58m5.915s, ?平均3.48ms/Record |

结果分析:

1)LZO解压缩的效率低于反解码的效率,在不以存储代价为第一考虑的情况下,优先选择FAST_DIFF编码方式。

2)LZO随机读会引起 hbase内部更多的读开销。下图在读取同样数据过程中,通过对于RegionServer上scanner采集到的读取个数,lzo明显代价较大。

3)在数据量不超过1T,并且HBase集群内存可以完全cover住整个Cache的情况下,可以不做压缩或者编码的设置,一般带有ROWCOL的bloomfilter基本就可以达到系统最佳的状态。如果数据远远大于Cache总量的10倍以上,优先使用编码方案(FAST_DIFF或者0.96引入的PREFIX_TRIE)

3、随机写的效率,采用批量写。批量个数为100

| 个数 | 耗时 | |

| weibo_test | 8640447 | 571670ms, 66μs/Put, 6.61ms/batch |

| weibo-new | 8640447 | 329694ms,38.12μs/Put,? 3.81ms/batch |

| weibo_lzo | 8640447 | 295770ms, 34.23μs/Put, 3.42ms/batch |

| weibo_diff | 8640447 | 250399ms, 28.97μs/Put,2.90ms/batch |

lz vs diff 写操作的集群吞吐图(两者开始执行的时间起点不同, 绿线代表weibo_diff、红线是weibo_lzo)

?

结论分析:

1)批量写操作,使用FAST_DIFF编码的开销最小,性能比不做任何配置(weibo-new)有24%提升。

2)使用diff,lzo双重配置,批量写操作有较大开销,并且压缩没有比单独使用LZO压缩有明显提升,所以不建议同时使用。

3、总体结论分析

1)在column较多、并且value较短的情况下,使用FAST_DIFF可以获得较好的压缩空间以及较优的读写延迟。推荐使用。

2)在对于存储空间比较紧缺的应用,单独使用LZO压缩,可以在牺牲一些随机读的前提下获得较高的空间压缩率(5:1)。

备注:本系列文章属于Binos_ICT在Binospace个人技术博客原创,原文链接为http://www.binospace.com/index.php/hbase-combat-series-1-compression-and-coding-techniques/?,未经允许,不得在网上转载。

From Binospace, post HBase实战系列1—压缩与编码技术

文章的脚注信息由WordPress的wp-posturl插件自动生成

Copyright © 2008

This feed is for personal, non-commercial use only.

The use of this feed on other websites breaches copyright. If this content is not in your news reader, it makes the page you are viewing an infringement of the copyright. (Digital Fingerprint:

)

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

Stable Diffusion 3论文终于发布,架构细节大揭秘,对复现Sora有帮助?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3论文终于发布,架构细节大揭秘,对复现Sora有帮助?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3的论文终于来了!这个模型于两周前发布,采用了与Sora相同的DiT(DiffusionTransformer)架构,一经发布就引起了不小的轰动。与之前版本相比,StableDiffusion3生成的图质量有了显着提升,现在支持多主题提示,并且文字书写效果也得到了改善,不再出现乱码情况。 StabilityAI指出,StableDiffusion3是一个系列模型,其参数量从800M到8B不等。这一参数范围意味着该模型可以在许多便携设备上直接运行,从而显着降低了使用AI

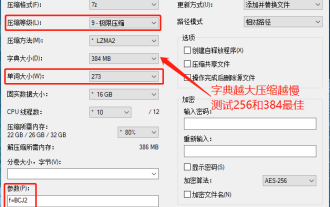

7-zip最大压缩率设置,7zip如何压缩到最小

Jun 18, 2024 pm 06:12 PM

7-zip最大压缩率设置,7zip如何压缩到最小

Jun 18, 2024 pm 06:12 PM

发现某下载网站下载的压缩包,解压后再打包会比原来的压缩包大一些,小的几十Kb的差别,大的几十Mb的差别,如果上传到云盘或付费空间,文件少无所谓,文件多的话,大大的增加储存成本。特意研究了下,有需要的可以借鉴。压缩等级:9-极限压缩字典大小:256或384,字典越压缩越慢,256MB之前压缩率差别较大,384MB后压缩率无差别单词大小:最大273参数:f=BCJ2,测试加参数压缩率会高一些

自动驾驶与轨迹预测看这一篇就够了!

Feb 28, 2024 pm 07:20 PM

自动驾驶与轨迹预测看这一篇就够了!

Feb 28, 2024 pm 07:20 PM

轨迹预测在自动驾驶中承担着重要的角色,自动驾驶轨迹预测是指通过分析车辆行驶过程中的各种数据,预测车辆未来的行驶轨迹。作为自动驾驶的核心模块,轨迹预测的质量对于下游的规划控制至关重要。轨迹预测任务技术栈丰富,需要熟悉自动驾驶动/静态感知、高精地图、车道线、神经网络架构(CNN&GNN&Transformer)技能等,入门难度很大!很多粉丝期望能够尽快上手轨迹预测,少踩坑,今天就为大家盘点下轨迹预测常见的一些问题和入门学习方法!入门相关知识1.预习的论文有没有切入顺序?A:先看survey,p

DualBEV:大幅超越BEVFormer、BEVDet4D,开卷!

Mar 21, 2024 pm 05:21 PM

DualBEV:大幅超越BEVFormer、BEVDet4D,开卷!

Mar 21, 2024 pm 05:21 PM

这篇论文探讨了在自动驾驶中,从不同视角(如透视图和鸟瞰图)准确检测物体的问题,特别是如何有效地从透视图(PV)到鸟瞰图(BEV)空间转换特征,这一转换是通过视觉转换(VT)模块实施的。现有的方法大致分为两种策略:2D到3D和3D到2D转换。2D到3D的方法通过预测深度概率来提升密集的2D特征,但深度预测的固有不确定性,尤其是在远处区域,可能会引入不准确性。而3D到2D的方法通常使用3D查询来采样2D特征,并通过Transformer学习3D和2D特征之间对应关系的注意力权重,这增加了计算和部署的

小米 15 系列全代号曝光:Dada、Haotian、Xuanyuan

Aug 22, 2024 pm 06:47 PM

小米 15 系列全代号曝光:Dada、Haotian、Xuanyuan

Aug 22, 2024 pm 06:47 PM

小米15系列预计将于10月份正式发布,其全系列代号已在外媒MiCode代码库中曝光。其中,旗舰级小米15Ultra代号为"Xuanyuan"(意为"轩辕"),此名源自中国神话中的黄帝,象征着尊贵。小米15的代号为"Dada",而小米15Pro则以"Haotian"(意为"昊天")为名。小米15SPro内部代号为"dijun",暗指《山海经》创世神帝俊。小米15Ultra系列涵盖

PHP实战:快速实现斐波那契数列的代码示例

Mar 20, 2024 pm 02:24 PM

PHP实战:快速实现斐波那契数列的代码示例

Mar 20, 2024 pm 02:24 PM

PHP实战:快速实现斐波那契数列的代码示例斐波那契数列是数学中一个非常有趣且常见的数列,其定义如下:第一个和第二个数为0和1,从第三个数开始,每个数都是前两个数的和。斐波那契数列的前几个数字依次为0,1,1.2,3,5,8,13,21,...依此类推。在PHP中,我们可以通过递归和迭代两种方式来实现斐波那契数列的生成。下面我们分别来展示这两

华为 Mate 60 系列最佳入手时机,新增 AI 消除 + 影像升级,更可享秋日礼遇活动

Aug 29, 2024 pm 03:33 PM

华为 Mate 60 系列最佳入手时机,新增 AI 消除 + 影像升级,更可享秋日礼遇活动

Aug 29, 2024 pm 03:33 PM

自去年华为Mate60系列开售以来,我个人就一直将Mate60Pro作为主力机使用。在将近一年的时间里,华为Mate60Pro经过多次OTA升级,综合体验有了显着提升,给人一种常用常新的感觉。比如近期,华为Mate60系列就再度迎来了影像功能的重磅升级。首先是新增AI消除功能,可以智能消除路人、杂物并对空白部分进行自动补充;其次是主摄色准、长焦清晰度均有明显升级。考虑到现在是开学季,华为Mate60系列还推出了秋日礼遇活动:购机可享至高800元优惠,入手价低至4999元。常用常新的产品力加上超值

综述!深度模型融合(LLM/基础模型/联邦学习/微调等)

Apr 18, 2024 pm 09:43 PM

综述!深度模型融合(LLM/基础模型/联邦学习/微调等)

Apr 18, 2024 pm 09:43 PM

23年9月国防科大、京东和北理工的论文“DeepModelFusion:ASurvey”。深度模型融合/合并是一种新兴技术,它将多个深度学习模型的参数或预测合并为一个模型。它结合了不同模型的能力来弥补单个模型的偏差和错误,以获得更好的性能。而大规模深度学习模型(例如LLM和基础模型)上的深度模型融合面临着一些挑战,包括高计算成本、高维参数空间、不同异构模型之间的干扰等。本文将现有的深度模型融合方法分为四类:(1)“模式连接”,通过一条损失减少的路径将权重空间中的解连接起来,以获得更好的模型融合初