搭建yarn(hadoop-2.2.0)环境详细过程

磨刀不误砍柴工,在这里我们先了解一个问题: MapReduce和YARN是什么关系? 答:YARN并不是下一代MapReduce(MRv2),下一代MapReduce与第一代MapReduce(MRv1)在编程接口、数据处理 引擎(MapTask和ReduceTask)是完全一样的, 可认为MRv2重用了MRv1的这些

磨刀不误砍柴工,在这里我们先了解一个问题:

MapReduce和YARN是什么关系?

答:YARN并不是下一代MapReduce(MRv2),下一代MapReduce与第一代MapReduce(MRv1)在编程接口、数据处理 引擎(MapTask和ReduceTask)是完全一样的, 可认为MRv2重用了MRv1的这些模块,不同的是资源管理和作业管理系统,MRv1中资源管理和作业管理均是由JobTracker实现的,集两个功能 于一身,而在MRv2中,将这两部分分开了,其中,作业管理由ApplicationMaster实现,而资源管理由新增系统YARN完成,由于YARN具有通用性,因此YARN也可以作为其他计算 框架的资源管理系统,不仅限于MapReduce,也是其他计算框架,比如Spark、Storm等, 通常而言,我们一般将运行在YARN上的计算框架称为“X on YARN”,比如“MapReduce On YARN”, "Spark On YARN",“Storm On YARN”等。

Hadoop 2.0由三个子系统组成,分别是HDFS、YARN和MapReduce,其中,YARN是一个崭新的资源管理系统,而MapReduce则只是运行在 YARN上的一个应用,如果把YARN看成一个云操作系统,那么MapReduce可认为是运行在这个操作系统上的App。

2014/7/22 23:41:22

(接)上次写到MapReduce和YARN是什么关系?今天就要正式搭建环境。

搭建环境准备:具体参照《搭建Hadoop-0.20.2环境》一文中的第一步到第六步

系统:Ubuntu-12.04(其他版本也可以)

模式:伪分布式

搭建用户:hadoop

Hadoop-2.2.0下载地址:http://mirrors.hust.edu.cn/apache/hadoop/common/hadoop-2.2.0/

选择你需要的安装包,在这里我们选择hadoop-2.2.0.tar.gz

附Hadoop镜像链接地址:http://www.apache.org/dyn/closer.cgi/hadoop/common/

声明1:我配置hadoop-2.2.0的目录是/home/hadoop

声明2:在/home/hadoop下创建了yarn目录hadoop-2.2.0目录和hadoop数据目录都是在yarn目录下。

声明3:在下面的搭建过程中可将/home/hadoop换成你自己的目录。

步骤一:上传hadoop-2.2.0.tar.gz 并解压到/home/hadoop/yarn目录,此时在yarn目录中解压出hadoop-2.2.0目录

<code>sudo chown -R hadoop:hadoop hadoop-2.2.0 </code>

创建Hadoop数据目录:

<code>mkdir -p /home/hadoop/yarn/yarn_data/hdfs/namenode mkdir -p /home/hadoop/yarn/yarn_data/hdfs/datanode </code>

配置文件之前先大体介绍一下hadoop-2.2.0目录中的各个文件夹,注意区分与Hadoop1中的改变。

外层的启动脚本在sbin目录

内层的被调用脚本在bin目录

Native的so文件都在lib/native目录

配置程序文件都放置在libexec

配置文件都在etc目录,对应以前版本的conf目录

所有的jar包都在share/hadoop目录下面

步骤二:配置环境变量

在这里我自己没有将环境全局化所以在hadoop-2.2.0中没有配置系统环境/etc/profile

如果配置,执行执行source /etc/profile,使之生效。

步骤三:core-site.xml hdfs-site.xml mapred-site.xml yarn-site.xml配置

接下来我们的具体配置就是/home/hadoop/yarn/hadoop-2.2.0/etc/hadoop目录中进行。

core-site.xml配置

<code><configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

<description>指定NameNode的IP地址和端口号</description>

</property>

</configuration>

</code>hdfs-site.xml

<code><configuration>

<property>

<name>dfs.replication</name>

<value>2</value>

<description>备份数</description>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/hadoop/yarn/yarn_data/hdfs/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/hadoop/yarn/yarn_data/hdfs/datanode</value>

</property>

</configuration>

</code>mapred-site.xml

<code><configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>localhost:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>localhost:19888</value>

</property>

</configuration>

</code>yarn-site.xml

<code><configuration> <!-- Site specific YARN configuration properties --> <property> <name>yarn.resourcemanager.address</name> <value>localhost:8032</value> </property> <property> <name>yarn.resourcemanager.scheduler.address</name> <value>localhost:8030</value> </property> <property> <name>yarn.resourcemanager.resource-tracker.address</name> <value>localhost:8031</value> </property> <property> <name>yarn.resourcemanager.admin.address</name> <value>localhost:8033</value> </property> <property> <name>yarn.resourcemanager.webapp.address</name> <value>localhost:8088</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name> <value>org.apache.hadoop.mapred.ShuffleHandler</value> </property> </configuration> </code>

步骤四:slaves配置

因为是伪分布式,所以我们只有localhost

步骤五:将配置好的hadoop-2.2.0分发同步到各个数据节点

因为是伪分布式,这步跳过。

步骤六:格式化NameNode

执行命令:

<code>bin/hdfs namenode –format </code>

或者

<code>bin/hadoop namenode –format </code>

步骤七:启动hdfs和yarn

启动hdfs:

<code>sbin/start-dfs.sh </code>

启动yarn:

<code>sbin/start-yarn.sh </code>

或者可以执行

<code>sbin/start-all.sh </code>

一起启动hdfs和yarn。

另外还要启动history服务,不然在面板中不能打开history链接。

<code>sbin/mr-jobhistory-daemon.sh start historyserver </code>

下面使用jps命令查看启动进程:

<code>4504 ResourceManager 4066 DataNode 4761 NodeManager 5068 JobHistoryServer 4357 SecondaryNameNode 3833 NameNode 5127 Jps </code>

步骤八:测试

hdfs测试:

<code>在hdfs中创建文件:bin/hadoop fs -mkdir /wordcount 向hdfs中上传文件:bin/hadoop fs /home/hadoop/file2.txt /wordcount 查看hdfs文件目录:hdfs dfs –ls / </code>

Yarn测试: 运行WordCount测试程序,

<code>bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.2.0.jar wordcount /wordcount /output2 </code>

具体查看结果:

<code>bin/hadoop fs -cat /output2/* </code>

结果显示:

<code>hadoop 1 hello 2 java 4 jsp 1 </code>

到这里,hadoop-2.2.0环境搭建结束,配置文件根据具体需求,具体配置。可能有配置不当的地方,若有看到还望指正。

原文地址:搭建yarn(hadoop-2.2.0)环境详细过程, 感谢原作者分享。

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

无法引导到Windows恢复环境

Feb 19, 2024 pm 11:12 PM

无法引导到Windows恢复环境

Feb 19, 2024 pm 11:12 PM

Windows恢复环境(WinRE)是用于修复Windows操作系统错误的环境。进入WinRE后,您可以执行系统还原、出厂重置、卸载更新等操作。如果无法引导到WinRE,本文将指导您使用修复程序解决此问题。无法引导到Windows恢复环境如果无法引导至Windows恢复环境,请使用下面提供的修复程序:检查Windows恢复环境的状态使用其他方法进入Windows恢复环境您是否意外删除了Windows恢复分区?执行Windows的就地升级或全新安装下面,我们已经详细解释了所有这些修复。1]检查Wi

Python和Anaconda之间有什么区别?

Sep 06, 2023 pm 08:37 PM

Python和Anaconda之间有什么区别?

Sep 06, 2023 pm 08:37 PM

在本文中,我们将了解Python和Anaconda之间的差异。Python是什么?Python是一种开源语言,非常重视使代码易于阅读并通过缩进行和提供空白来理解。Python的灵活性和易于使用使其非常适用于各种应用,包括但不限于对于科学计算、人工智能和数据科学,以及创造和发展的在线应用程序。当Python经过测试时,它会立即被翻译转化为机器语言,因为它是一种解释性语言。有些语言,比如C++,需要编译才能被理解。精通Python是一个重要的优势,因为它非常易于理解、开发,执行并读取。这使得Pyth

JavaScript包管理器比较:Npm vs Yarn vs Pnpm

Aug 09, 2022 pm 04:22 PM

JavaScript包管理器比较:Npm vs Yarn vs Pnpm

Aug 09, 2022 pm 04:22 PM

本篇文章带大家了解一下三种JavaScript包管理器(npm、yarn、pnpm),并将这三种包管理器进行对比,聊聊npm、yarn、pnpm三者的区别和关联,希望对大家有所帮助,如有问题欢迎指出!

一文浅析JS包管理工具:yarn

Aug 09, 2022 pm 03:49 PM

一文浅析JS包管理工具:yarn

Aug 09, 2022 pm 03:49 PM

yarn 和 npm 一样也是 JavaScript 包管理工具,下面本篇文章就来带大家了解一下yarn包管理工具,希望对大家有所帮助!

Vue框架下,如何快速搭建统计图表系统

Aug 21, 2023 pm 05:48 PM

Vue框架下,如何快速搭建统计图表系统

Aug 21, 2023 pm 05:48 PM

Vue框架下,如何快速搭建统计图表系统在现代网页应用中,统计图表是必不可少的组成部分。Vue.js作为一款流行的前端框架,提供了很多便捷的工具和组件,能够帮助我们快速搭建统计图表系统。本文将介绍如何利用Vue框架以及一些插件来搭建一个简单的统计图表系统。首先,我们需要准备一个Vue.js的开发环境,包括安装Vue脚手架以及一些相关的插件。在命令行中执行以下命

雾锁王国能野地搭建筑吗

Mar 07, 2024 pm 08:28 PM

雾锁王国能野地搭建筑吗

Mar 07, 2024 pm 08:28 PM

玩家在雾锁王国中进行游戏时可以收集不同的材料用来建造建筑,有很多玩家想知道野地搭建筑吗,雾锁王国能野地是不能搭建筑的,必须要在祭坛的范围内才可以搭建。雾锁王国能野地搭建筑吗答:不能。1、雾锁王国能野地是不能搭建筑的。2、建筑必须要在祭坛的范围内才可以搭建。3、玩家可以自行放置灵火祭坛,但一旦离开了范围,将无法进行建筑搭建。4、我们也可以直接在山上挖个洞当做我们的家,这样不用耗建筑材料。5、玩家自己搭建的建筑中,存在舒适度机制,也就是说,内饰越好,舒适度越高。6、高舒适度将为玩家带来属性加成,例如

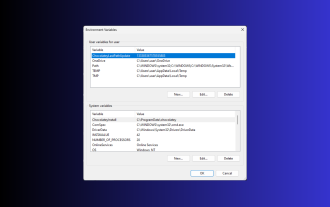

在 Windows 3 上设置环境变量的 11 种方法

Sep 15, 2023 pm 12:21 PM

在 Windows 3 上设置环境变量的 11 种方法

Sep 15, 2023 pm 12:21 PM

在Windows11上设置环境变量可以帮助您自定义系统、运行脚本和配置应用程序。在本指南中,我们将讨论三种方法以及分步说明,以便您可以根据自己的喜好配置系统。有三种类型的环境变量系统环境变量–全局变量处于最低优先级,可由Windows上的所有用户和应用访问,通常用于定义系统范围的设置。用户环境变量–优先级越高,这些变量仅适用于在该帐户下运行的当前用户和进程,并由在该帐户下运行的用户或应用程序设置。进程环境变量–具有最高优先级,它们是临时的,适用于当前进程及其子进程,为程序提供

php集成环境包有哪些

Jul 24, 2023 am 09:36 AM

php集成环境包有哪些

Jul 24, 2023 am 09:36 AM

php集成环境包有:1、PhpStorm,功能强大的PHP集成环境;2、Eclipse,开放源代码的集成开发环境;3、Visual Studio Code,轻量级的开源代码编辑器;4、Sublime Text,受欢迎的文本编辑器,广泛用于各种编程语言;5、NetBeans,由Apache软件基金会开发的集成开发环境;6、Zend Studio,为PHP开发者设计的集成开发环境。