Hadoop集群间的hbase数据迁移

在日常的使用过程中,可能经常需要将一个集群中hbase的数据迁移到或者拷贝到另外一个集群中,这时候,可能会出很多问题 以下是我在处理的过程中的一些做法和处理方式。 前提,两个hbase的版本一直,否则可能出现不可预知的问题,造成数据迁移失败 当两个集群

在日常的使用过程中,可能经常需要将一个集群中hbase的数据迁移到或者拷贝到另外一个集群中,这时候,可能会出很多问题以下是我在处理的过程中的一些做法和处理方式。

前提,两个hbase的版本一直,否则可能出现不可预知的问题,造成数据迁移失败

当两个集群不能通讯的时候,可以先将数据所在集群中hbase的数据文件拷贝到本地

具体做法如下:

在Hadoop目录下执行如下命令,拷贝到本地文件。

bin/Hadoop fs -copyToLocal /hbase/tab_keywordflow /home/test/xiaochenbak

然后你懂得,将文件拷贝到你需要的你需要迁移到的那个集群中,目录是你的表的目录,

如果这个集群中也有对应的表文件,那么删除掉,然后拷贝。

/bin/Hadoop fs -rmr /hbase/tab_keywordflow

/bin/Hadoop fs -copyFromLocal /home/other/xiaochenbak /hbase/tab_keywordflow

此时的/home/other/xiaochenbak为你要迁移到数据的集群。

重置该表在.META.表中的分区信息

bin/hbase org.jruby.Main /home/other/hbase/bin/add_table.rb /hbase/tab_keywordflow

/home/other/hbase/bin/add_table.rb为ruby脚本,可以执行,脚本内容如下:另存为add_table.rb即可

#

# Copyright 2009 The Apache Software Foundation

#

# Licensed to the Apache Software Foundation (ASF) under one

# or more contributor license agreements. See the NOTICE file

# distributed with this work for additional information

# regarding copyright ownership. The ASF licenses this file

# to you under the Apache License, Version 2.0 (the

# "License"); you may not use this file except in compliance

# with the License. You may obtain a copy of the License at

#

# http://www.apache.org/licenses/LICENSE-2.0

#

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

#

# Script adds a table back to a running hbase.

# Currently only works on if table data is in place.

#

# To see usage for this script, run:

#

# ${HBASE_HOME}/bin/hbase org.jruby.Main addtable.rb

#

include Java

import org.apache.Hadoop.hbase.util.Bytes

import org.apache.Hadoop.hbase.HConstants

import org.apache.Hadoop.hbase.regionserver.HRegion

import org.apache.Hadoop.hbase.HRegionInfo

import org.apache.Hadoop.hbase.client.HTable

import org.apache.Hadoop.hbase.client.Delete

import org.apache.Hadoop.hbase.client.Put

import org.apache.Hadoop.hbase.client.Scan

import org.apache.Hadoop.hbase.HTableDescriptor

import org.apache.Hadoop.hbase.HBaseConfiguration

import org.apache.Hadoop.hbase.util.FSUtils

import org.apache.Hadoop.hbase.util.Writables

import org.apache.Hadoop.fs.Path

import org.apache.Hadoop.fs.FileSystem

import org.apache.commons.logging.LogFactory

# Name of this script

NAME = "add_table"

# Print usage for this script

def usage

puts 'Usage: %s.rb TABLE_DIR [alternate_tablename]' % NAME

exit!

end

# Get configuration to use.

c = HBaseConfiguration.new()

# Set Hadoop filesystem configuration using the hbase.rootdir.

# Otherwise, we'll always use localhost though the hbase.rootdir

# might be pointing at hdfs location.

c.set("fs.default.name", c.get(HConstants::HBASE_DIR))

fs = FileSystem.get(c)

# Get a logger and a metautils instance.

LOG = LogFactory.getLog(NAME)

# Check arguments

if ARGV.size < 1 || ARGV.size > 2

usage

end

# Get cmdline args.

srcdir = fs.makeQualified(Path.new(java.lang.String.new(ARGV[0])))

if not fs.exists(srcdir)

raise IOError.new("src dir " srcdir.toString() " doesn't exist!")

end

# 获取表名称

表名 = nil

如果 ARGV.size > 1

表名 = ARGV[1]

raise IOError.new("尚不支持")

埃尔西夫

# 如果没有提供,则使用目录名

表名 = srcdir.getName()

结束

HTableDescriptor.isLegalTableName(tableName.to_java_bytes)

# 计算 hbase.rootdir 下的位置

# 将目录移动到位;小心不要覆盖。

rootdir = FSUtils.getRootDir(c)

tableDir = fs.makeQualified(Path.new(rootdir, tableName))

# 如果目录当前存在,请将其移到一边。

if srcdir.equals(tableDir)

LOG.info("源目录位于 hbase.rootdir 下:" srcdir.toString());

elsif fs.exists(tableDir)

移动表名=表名“.” java.lang.System.currentTimeMillis().to_s

movingTableDir = Path.new(rootdir, java.lang.String.new(movedTableName))

LOG.warn("将 " tableDir.toString() " 移至一边为 " movingTableDir.toString());

raise IOError.new(“移动失败” tableDir.toString()) 除非 fs.rename(tableDir, movingTableDir)

LOG.info("将" srcdir.toString() "移动到" tableDir.toString());

raise IOError.new("移动失败" srcdir.toString()) 除非 fs.rename(srcdir, tableDir)

结束

# 明确提及 .META 中的表。

# 扫描.META。并删除所有以表名

开头的行 LOG.info(“从 .META 中删除提及“ tableName ”。”)

metaTable = HTable.new(c, HConstants::META_TABLE_NAME)

tableNameMetaPrefix = tableName HConstants::META_ROW_DELIMITER.chr

scan = Scan.new((tableNameMetaPrefix HConstants::META_ROW_DELIMITER.chr).to_java_bytes)

扫描仪 = metaTable.getScanner(scan)

# 使用 java.lang.String 进行比较。 Ruby String 有点奇怪。

tableNameStr = java.lang.String.new(tableName)

while (结果=scanner.next())

rowid = Bytes.toString(result.getRow())

rowidStr = java.lang.String.new(rowid)

如果不是 rowidStr.startsWith(tableNameMetaPrefix)

# 太过分了,打破

休息

结束

LOG.info("从目录中删除行:" rowid);

d = Delete.new(result.getRow())

metaTable.delete(d)

结束

Scanner.close()

# 现在,遍历表格并为每个区域添加一个条目

LOG.info("Walking " srcdir.toString() " 将区域添加到目录表中")

statuses = fs.listStatus(srcdir)

对于状态中的状态

下一步,除非 status.isDir()

接下来如果 status.getPath().getName() == "compaction.dir"

Regioninfofile = Path.new(status.getPath(), HRegion::REGIONINFO_FILE)

除非 fs.exists(regioninfofile)

LOG.warn("缺少 .regioninfo: "regioninfofile.toString())

下一个

结束

is = fs.open(regioninfofile)

hri = HRegionInfo.new()

hri.readFields(is)

is.close()

# TODO:需要使用传递的表名称重做表描述符,然后重新计算区域编码名称。

p = Put.new(hri.getRegionName())

p.add(HConstants::CATALOG_FAMILY, HConstants::REGIONINFO_QUALIFIER, Writables.getBytes(hri))

metaTable.put(p)

LOG.info("已添加到目录:" hri.toString())

结束

好了,以上就是我的做法,如何集群键可以通信,那就更好办了,相信你懂,scp

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

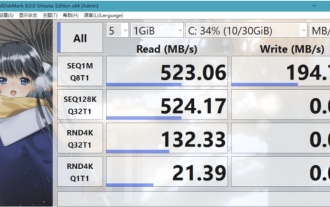

crystaldiskmark是什么软件?-crystaldiskmark如何使用?

Mar 18, 2024 pm 02:58 PM

crystaldiskmark是什么软件?-crystaldiskmark如何使用?

Mar 18, 2024 pm 02:58 PM

CrystalDiskMark是一款适用于硬盘的小型HDD基准测试工具,可以快速测量顺序和随机读/写速度。接下来就让小编为大家介绍一下CrystalDiskMark,以及crystaldiskmark如何使用吧~一、CrystalDiskMark介绍CrystalDiskMark是一款广泛使用的磁盘性能测试工具,用于评估机械硬盘和固态硬盘(SSD)的读写速度和随机I/O性能。它是一款免费的Windows应用程序,并提供用户友好的界面和各种测试模式来评估硬盘驱动器性能的不同方面,并被广泛用于硬件评

使用ddrescue在Linux上恢复数据

Mar 20, 2024 pm 01:37 PM

使用ddrescue在Linux上恢复数据

Mar 20, 2024 pm 01:37 PM

DDREASE是一种用于从文件或块设备(如硬盘、SSD、RAM磁盘、CD、DVD和USB存储设备)恢复数据的工具。它将数据从一个块设备复制到另一个块设备,留下损坏的数据块,只移动好的数据块。ddreasue是一种强大的恢复工具,完全自动化,因为它在恢复操作期间不需要任何干扰。此外,由于有了ddasue地图文件,它可以随时停止和恢复。DDREASE的其他主要功能如下:它不会覆盖恢复的数据,但会在迭代恢复的情况下填补空白。但是,如果指示工具显式执行此操作,则可以将其截断。将数据从多个文件或块恢复到单

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

开源!超越ZoeDepth! DepthFM:快速且精确的单目深度估计!

Apr 03, 2024 pm 12:04 PM

0.这篇文章干了啥?提出了DepthFM:一个多功能且快速的最先进的生成式单目深度估计模型。除了传统的深度估计任务外,DepthFM还展示了在深度修复等下游任务中的最先进能力。DepthFM效率高,可以在少数推理步骤内合成深度图。下面一起来阅读一下这项工作~1.论文信息标题:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

微信聊天记录怎么迁移到新手机

Mar 26, 2024 pm 04:48 PM

微信聊天记录怎么迁移到新手机

Mar 26, 2024 pm 04:48 PM

1、在旧设备上打开微信app,点击右下角的【我】,选择【设置】功能,点击【聊天】。2、选择【聊天记录迁移与备份】,点击【迁移】,选择要迁移设备的平台。3、点击【择需要迁移的聊天】,点击左下角的【全选】或自主选择聊天记录。4、选择完毕后,点击右下角的【开始】,使用新设备登录此微信账号。5、然后扫描该二维码即可开始迁移聊天记录,用户只需等待迁移完成即可。

foobar2000怎么下载?-foobar2000怎么使用

Mar 18, 2024 am 10:58 AM

foobar2000怎么下载?-foobar2000怎么使用

Mar 18, 2024 am 10:58 AM

foobar2000是一款能随时收听音乐资源的软件,各种音乐无损音质带给你,增强版本的音乐播放器,让你得到更全更舒适的音乐体验,它的设计理念是将电脑端的高级音频播放器移植到手机上,提供更加便捷高效的音乐播放体验,界面设计简洁明了易于使用它采用了极简的设计风格,没有过多的装饰和繁琐的操作能够快速上手,同时还支持多种皮肤和主题,根据自己的喜好进行个性化设置,打造专属的音乐播放器支持多种音频格式的播放,它还支持音频增益功能根据自己的听力情况调整音量大小,避免过大的音量对听力造成损害。接下来就让小编为大

谷歌狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理训练最快选择

Apr 01, 2024 pm 07:46 PM

谷歌狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理训练最快选择

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基准测试中性能已经超过Pytorch和TensorFlow,7项指标排名第一。而且测试并不是在JAX性能表现最好的TPU上完成的。虽然现在在开发者中,Pytorch依然比Tensorflow更受欢迎。但未来,也许有更多的大模型会基于JAX平台进行训练和运行。模型最近,Keras团队为三个后端(TensorFlow、JAX、PyTorch)与原生PyTorch实现以及搭配TensorFlow的Keras2进行了基准测试。首先,他们为生成式和非生成式人工智能任务选择了一组主流

超级智能体生命力觉醒!可自我更新的AI来了,妈妈再也不用担心数据瓶颈难题

Apr 29, 2024 pm 06:55 PM

超级智能体生命力觉醒!可自我更新的AI来了,妈妈再也不用担心数据瓶颈难题

Apr 29, 2024 pm 06:55 PM

哭死啊,全球狂炼大模型,一互联网的数据不够用,根本不够用。训练模型搞得跟《饥饿游戏》似的,全球AI研究者,都在苦恼怎么才能喂饱这群数据大胃王。尤其在多模态任务中,这一问题尤为突出。一筹莫展之际,来自人大系的初创团队,用自家的新模型,率先在国内把“模型生成数据自己喂自己”变成了现实。而且还是理解侧和生成侧双管齐下,两侧都能生成高质量、多模态的新数据,对模型本身进行数据反哺。模型是啥?中关村论坛上刚刚露面的多模态大模型Awaker1.0。团队是谁?智子引擎。由人大高瓴人工智能学院博士生高一钊创立,高

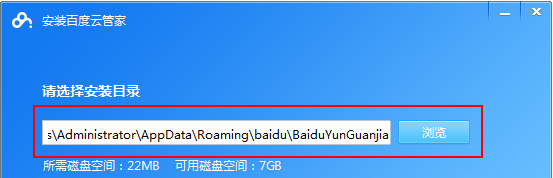

百度网盘app怎么用

Mar 27, 2024 pm 06:46 PM

百度网盘app怎么用

Mar 27, 2024 pm 06:46 PM

在如今云存储已经成为我们日常生活和工作中不可或缺的一部分。百度网盘作为国内领先的云存储服务之一,凭借其强大的存储功能、高效的传输速度以及便捷的操作体验,赢得了广大用户的青睐。而且无论你是想要备份重要文件、分享资料,还是在线观看视频、听取音乐,百度网盘都能满足你的需求。但是很多用户们可能对百度网盘app的具体使用方法还不了解,那么这篇教程就将为大家详细介绍百度网盘app如何使用,还有疑惑的用户们就快来跟着本文详细了解一下吧!百度云网盘怎么用:一、安装首先,下载并安装百度云软件时,请选择自定义安装选