Nvidia 推出了 Chat with RXT,这是一款可在您的 PC 上运行的 AI 聊天机器人,并提供与 ChatGPT 类似的功能等等!您只需要一个 Nvidia RTX GPU,就可以开始使用 Nvidia 的新 AI 聊天机器人了。

Nvidia Chat with RTX 是一款 AI 软件,可让您在计算机上本地运行大型语言模型 (LLM)。因此,您可以随时离线使用 Chat with RTX,而不是在线使用 ChatGPT 等 AI 聊天机器人。

Chat with RTX 使用 TensorRT-LLM、RTX 加速和量化的 Mistral 7-B LLM 来提供与其他在线 AI 聊天机器人相同的快速性能和质量响应。它还提供检索增强生成 (RAG),允许聊天机器人读取您的文件并根据您提供的数据启用自定义答案。这允许您自定义聊天机器人以提供更个性化的体验。

如果您想尝试使用 RTX 进行 Nvidia Chat,请按照以下步骤在您的计算机上下载、安装和配置它。

Nvidia 使在计算机上本地运行 LLM 变得更加容易。要使用 RTX 运行 Chat,您只需下载并安装该应用程序,就像使用任何其他软件一样。但是,Chat with RTX 确实有一些正确安装和使用的最低规格要求。

RTX 30 系列或 40 系列 GPU 16GB RAM 100GB 可用内存空间 Windows 11如果您的电脑确实满足最低系统要求,您可以继续安装该应用程序。

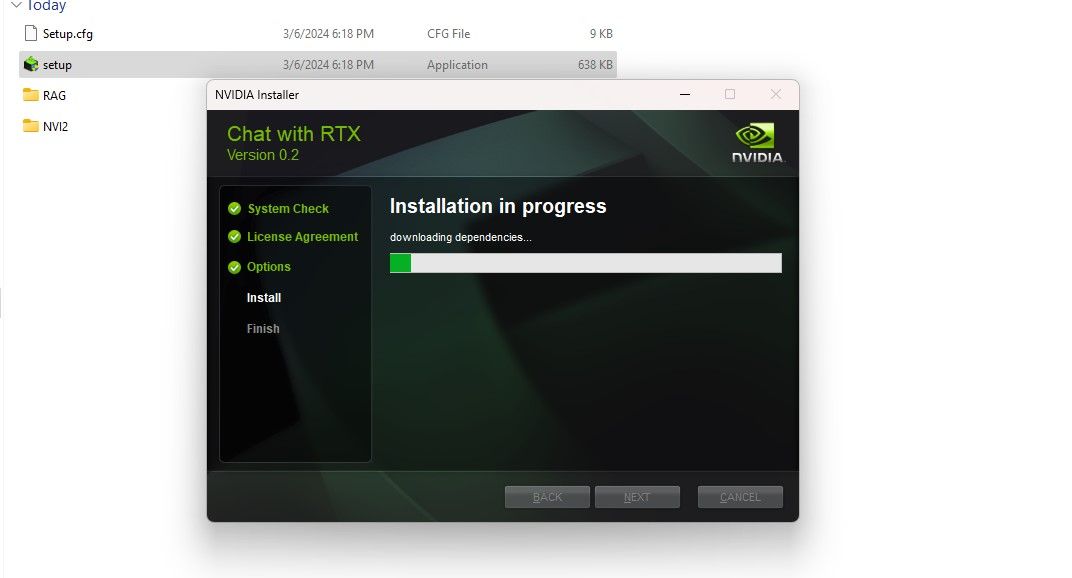

第 1 步:下载 Chat with RTX ZIP 文件。下载:Chat with RTX(免费 — 35GB 下载)第 2 步:右键单击并选择文件存档工具(如 7Zip)来解压缩 ZIP 文件或双击该文件并选择全部提取。步骤3:打开解压的文件夹并双击setup.exe。按照屏幕上的说明进行操作,并在自定义安装过程中选中所有复选框。点击“下一步”后,安装程序将下载并安装 LLM 和所有依赖项。

Chat with RTX 安装将需要一些时间才能完成,因为它会下载并安装大量数据。安装过程完成后,点击关闭,就完成了。现在,您可以试用该应用程序了。

虽然您可以像常规在线 AI 聊天机器人一样使用 Chat with RTX,但我强烈建议您检查其 RAG 功能,该功能使您能够根据需要自定义其输出在您授予访问权限的文件上。

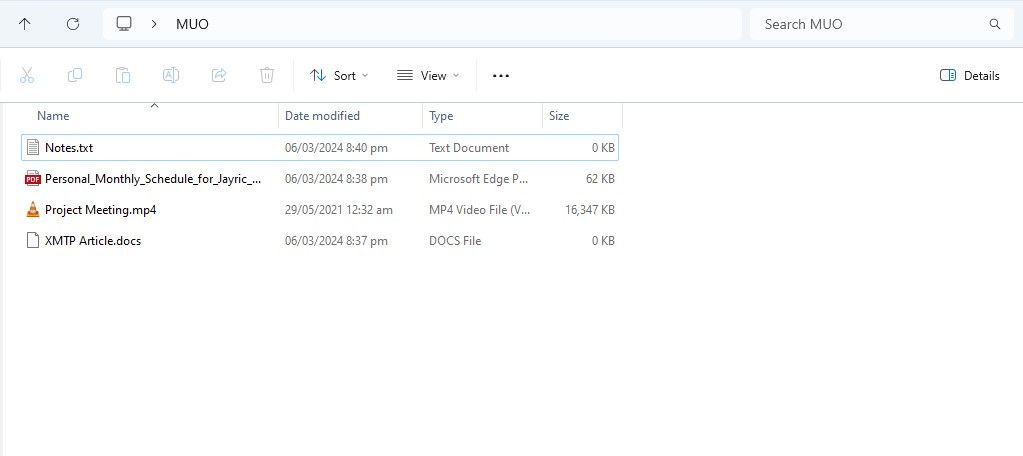

要开始在 Chat with RTX 上使用 RAG,请创建一个新文件夹来存储您希望 AI 分析的文件。

创建后,将数据文件放入该文件夹中。您存储的数据可以涵盖许多主题和文件类型,例如文档、PDF、文本和视频。但是,您可能希望限制放置在此文件夹中的文件数量,以免影响性能。要搜索的数据越多,意味着使用 RTX 聊天将需要更长的时间才能返回特定查询的响应(但这也取决于硬件)。

现在您的数据库已准备就绪,您可以设置 Chat with RTX 并开始使用它来回答您的问题和疑问。

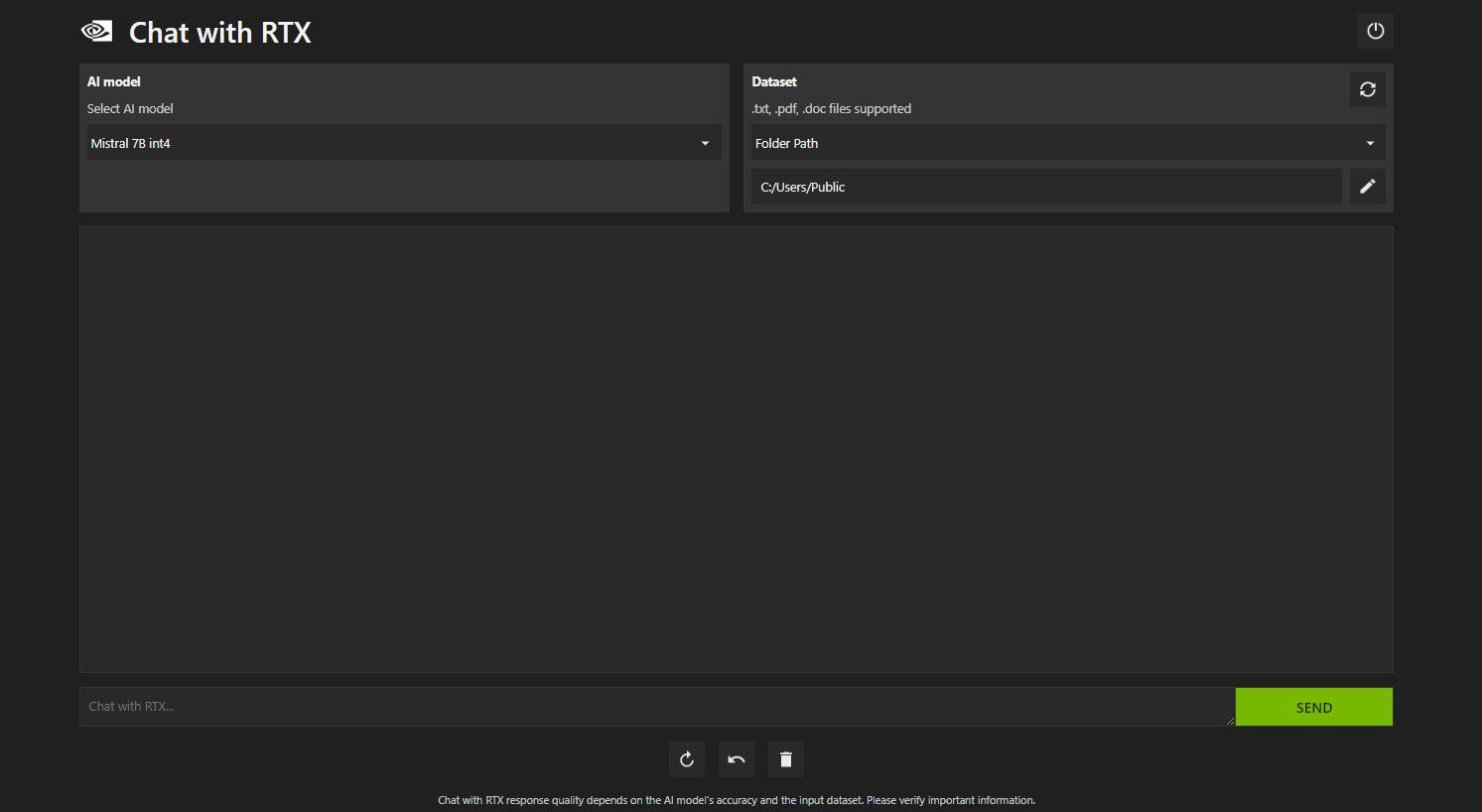

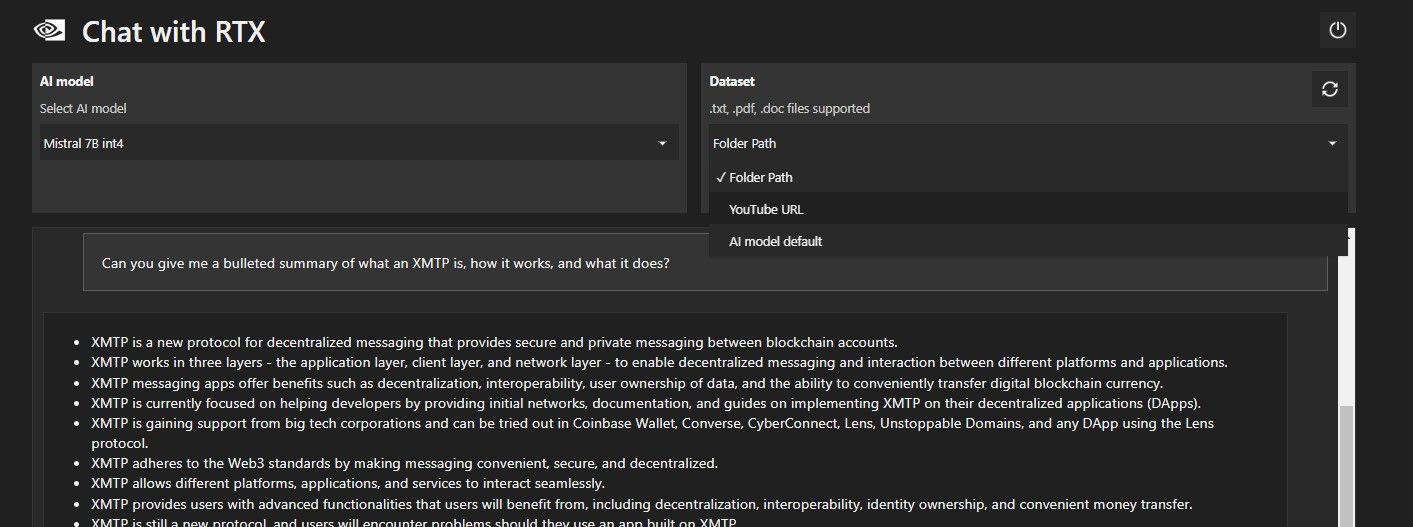

使用 RTX 打开聊天。它应该如下图所示。

在“数据集”下,确保选择“文件夹路径”选项。现在,单击下面的编辑图标(钢笔图标),然后选择包含您希望 Chat with RTX 读取的所有文件的文件夹。如果有其他选项可用,您还可以更改 AI 模型(在撰写本文时,仅 Mistral 7B 可用)。

您现在已准备好使用 Chat with RTX。

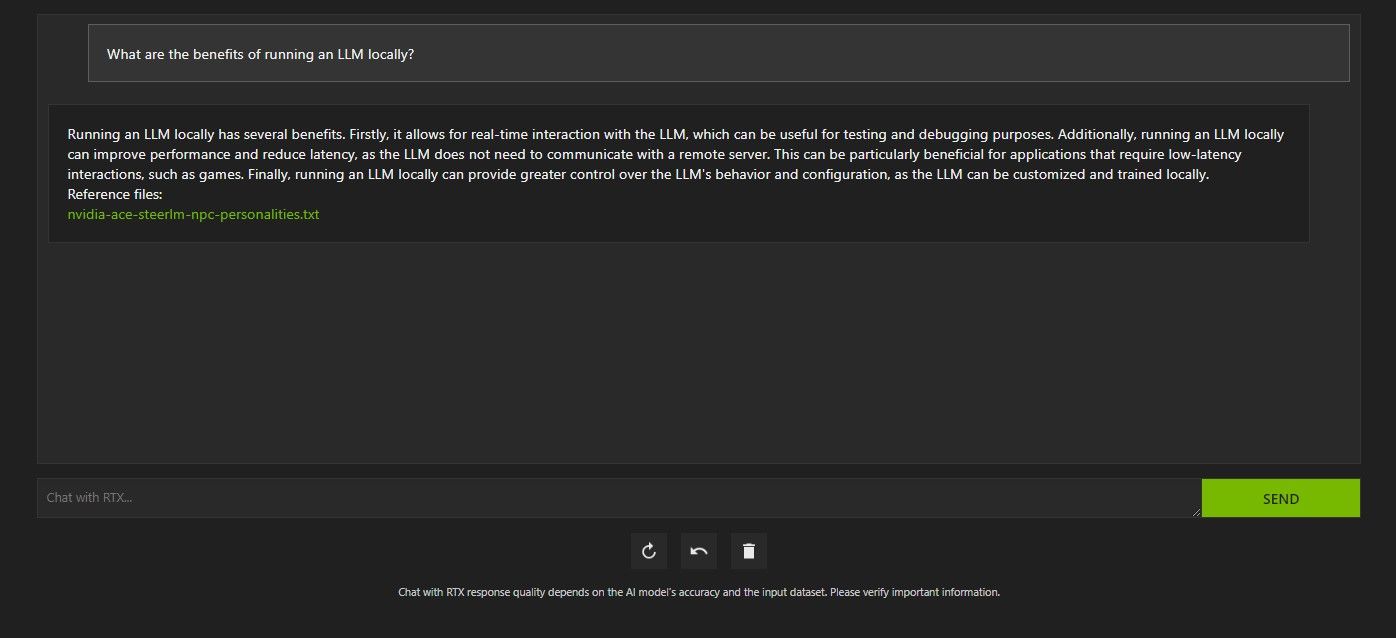

使用 RTX 查询 Chat 的方法有多种。第一个是像常规人工智能聊天机器人一样使用它。我向 Chat with RTX 询问使用本地法学硕士的好处,并对它的回答感到满意。虽然不是很深入,但是足够准确。

但由于 Chat with RTX 具有 RAG 功能,因此您也可以将其用作个人 AI 助理。

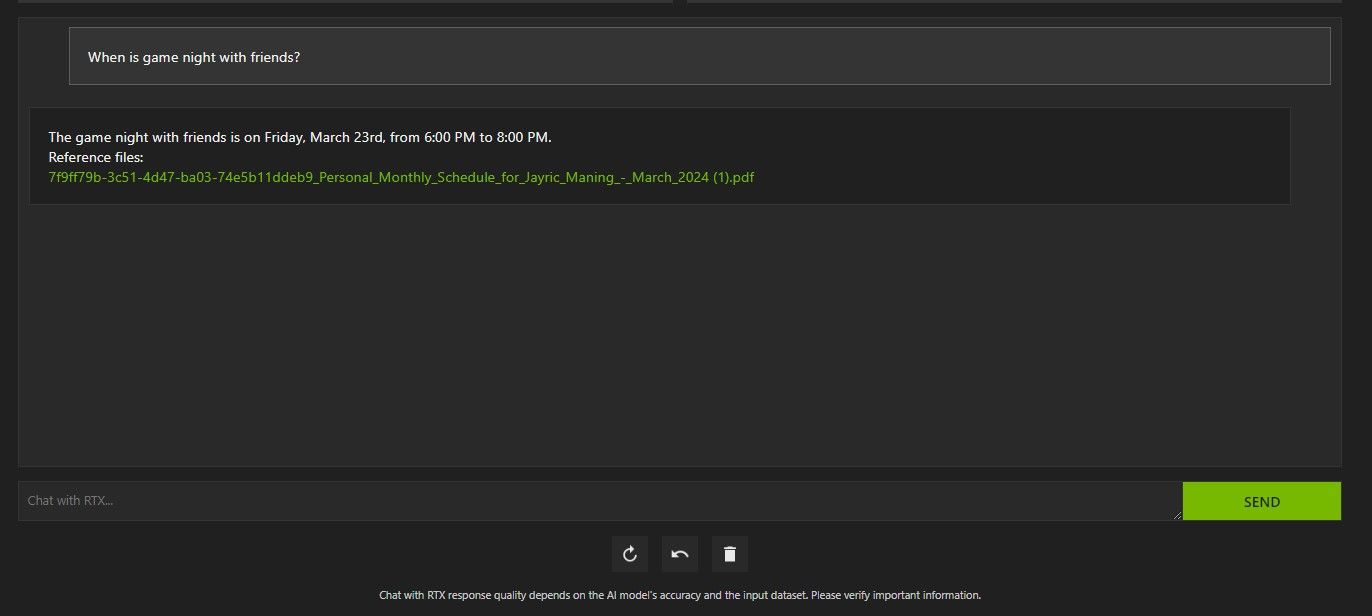

上面,我使用 RTX 聊天来询问我的日程安排。数据来自一个 PDF 文件,其中包含我的日程安排、日历、事件、工作等。在本例中,Chat with RTX 已从数据中提取了正确的日历数据;您必须保持数据文件和日历日期更新,这样的功能才能正常工作,直到与其他应用程序集成为止。

您可以通过多种方式使用 Chat with RTX 的 RAG 来发挥自己的优势。例如,您可以使用它来阅读法律文件并给出摘要,生成与您正在开发的程序相关的代码,获取有关您太忙而无法观看的视频的要点,等等!

除了本地数据文件夹之外,您还可以使用 Chat with RTX 来分析 YouTube 视频。为此,请在数据集下将文件夹路径更改为 YouTube URL。

复制您要分析的 YouTube URL 并将其粘贴到下拉菜单下方。那就问走吧!

Chat with RTX 的 YouTube 视频分析非常好,提供了准确的信息,因此可以方便地进行研究、快速分析等。

ChatGPT 提供 RAG 功能。一些本地人工智能聊天机器人的系统要求明显较低。那么,Nvidia Chat with RTX 值得使用吗?

答案是肯定的!尽管存在竞争,但与 RTX 聊天还是值得使用的。

使用 Nvidia Chat 与 RTX 的最大卖点之一是它能够使用 RAG,而无需将文件发送到第三方服务器。通过在线服务自定义 GPT 可能会暴露您的数据。但由于 Chat with RTX 在本地运行且无需互联网连接,因此在 Chat with RTX 上使用 RAG 可确保您的敏感数据安全且只能在您的 PC 上访问。

对于其他运行 Mistral 7B 的本地运行的 AI 聊天机器人,Chat with RTX 的性能更好更快。尽管性能提升的很大一部分来自于使用更高端的 GPU,但与运行聊天优化的 LLM 的其他方式相比,Nvidia TensorRT-LLM 和 RTX 加速的使用使得在 Chat with RTX 上运行 Mistral 7B 的速度更快。

值得注意的是,我们目前使用的 Chat with RTX 版本是一个演示版。 Chat with RTX 的后续版本可能会变得更加优化并带来性能提升。

Chat with RTX 是一种在本地运行 LLM 的简单、快速且安全的方式,无需互联网连接。如果您也有兴趣运行 LLM 或本地课程,但没有 RTX 30 或 40 系列 GPU,则可以尝试其他本地运行 LLM 的方法。其中最流行的两个是 GPT4ALL 和 Text Gen WebUI。如果您想在本地运行 LLM 获得即插即用的体验,请尝试 GPT4ALL。但如果您更倾向于技术,通过 Text Gen WebUI 运行法学硕士将提供更好的微调和灵活性。

以上是如何在计算机上使用 Nvidia 的 RTX AI 聊天机器人聊天的详细内容。更多信息请关注PHP中文网其他相关文章!