AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

论文第一作者为中山大学计算机学院研二硕士生陈家豪,研究方向为神经渲染和三维重建,导师为李冠彬教授。该论文是他的第一个工作。论文通讯作者为中山大学计算机学院、人机物智能融合实验室李冠彬教授,博士生导师,国家优秀青年基金获得者。团队主要研究领域为视觉感知、场景建模、理解与生成。迄今为止累计发表 CCF A 类 / 中科院一区论文 150 余篇,Google Scholar 引用超过 12000 次,曾获得吴文俊人工智能优秀青年奖等荣誉。自被提出以来,神经辐射场(Neural Radiance Fields, NeRF)因其在新视角合成及三维重建中的出色表现而受到极大关注。虽然大量工作都在尝试改进 NeRF 的渲染质量或运行速度,但一个现实的问题很少被人提及:如果待建模场景中出现了意想不到的瞬态干扰物,我们应该如何消除它们对 NeRF 造成的影响?本文中,来自中山大学、卡迪夫大学、宾夕法尼亚大学和思谋科技的研究人员对此展开了深入研究,并提出了一种解决该问题的新颖范式。通过总结现有方法的优势缺陷、拓宽已有技术的应用思路,该方法不仅可以在各类场景中准确区分静瞬态元素、提高 NeRF 的渲染质量,还入围了 CVPR 2024 最佳论文候选。

- 论文链接:https://arxiv.org/abs/2403.17537

-

项目链接:https://www.sysu-hcp.net/projects/cv/132.html

新视角合成是计算机视觉和图形学的一个重要任务,算法模型需要利用给定的多视角图像及相机位姿来生成目标位姿对应的图像。NeRF 在该任务上取得了重要突破,但其有效性与静态场景的假设有关。具体来说,NeRF 要求待建模场景在拍摄过程中保持静止、多视角图像内容必须一致。在现实中,我们很难满足这种要求,例如在户外拍摄时场景以外的车辆或路人可能会在镜头中随机出现移动,在室内拍摄时某个物体或阴影会不经意间遮挡镜头。我们把这类场景以外的表现出运动或不一致的元素称为瞬态干扰物(Transient Distractors)。如果我们不能消除它们,它们会给 NeRF 的渲染结果带来伪影。

(一時的な干渉(黄色のボックス)の存在により、多数の疑似反射鏡が発生する可能性があります。

現在の一時的な干渉源の問題を解決する方法は、大きく分けて 2 種類あります。

最初の方法は、セマンティック セグメンテーションなどの既存のセグメンテーション モデルを使用して、ディストラクターに関連するマスクを明示的に取得し、NeRF のトレーニング時に対応するピクセルをマスクします。このような方法では正確なセグメンテーション結果を生成できますが、万能ではありません。これは、ディストラクタに関する事前知識 (オブジェクト カテゴリ、初期マスクなど) を事前に知る必要があり、モデルはこれらのディストラクタを識別できるためです。 最初の方法とは異なり、

2 番目の方法は、ヒューリスティック アルゴリズムを使用して、NeRF をトレーニングするときに一時的なディストラクターを暗黙的に処理し、事前知識を必要としません

。このような方法はより一般的ですが、設計の複雑さと高度な姿勢不良のため、一時的な気が散る要素と静的なシーン要素を正確に分離することができません。たとえば、一時的なピクセルに対応するカラー テクスチャは異なる視野角で一貫性がないため、NeRF をトレーニングする場合、このピクセルの予測値と真の値の間の色の残差は、多くの場合、静的なピクセルの残差よりも大きくなります。ただし、シーン内の高周波の静的ディテールにも、フィッティングの難しさにより過剰な残差が生じるため、残留しきい値を設定して一時的な干渉を除去する一部の方法では、高周波の静的ディテールが簡単に失われる可能性があります。  既存の手法とこの論文で提案するヒューリスティックガイドセグメンテーション(HuGS)との比較。静的なシーンが一時的な妨害物によって妨害される場合、(a) セグメンテーション ベースの方法は事前の知識に依存し、予期しない一時的なオブジェクト (ピザなど) を識別できないため、関連するアーティファクトが発生します。(b) ヒューリスティック ベースの方法。この方法はより一般的ですが、精度が十分ではありません(たとえば、高周波の静的なテーブルクロスのテクスチャが失われます)、(c)HuGS はそれらの利点を組み合わせて、一時的なディストラクタと静的なシーン要素を正確に分離できるため、NeRF の結果が大幅に向上します。

既存の手法とこの論文で提案するヒューリスティックガイドセグメンテーション(HuGS)との比較。静的なシーンが一時的な妨害物によって妨害される場合、(a) セグメンテーション ベースの方法は事前の知識に依存し、予期しない一時的なオブジェクト (ピザなど) を識別できないため、関連するアーティファクトが発生します。(b) ヒューリスティック ベースの方法。この方法はより一般的ですが、精度が十分ではありません(たとえば、高周波の静的なテーブルクロスのテクスチャが失われます)、(c)HuGS はそれらの利点を組み合わせて、一時的なディストラクタと静的なシーン要素を正確に分離できるため、NeRF の結果が大幅に向上します。

セグメンテーションモデルに基づく方法は正確ですが普遍的ではなく、ヒューリスティックアルゴリズムに基づく方法は普遍的ですが不正確です。お互いの強みを補い合って、それは正確かつ普遍的ですか?

そこで、論文の著者は、「コースの馬」を動機として、ヒューリスティックガイド付きセグメンテーション (HuGS) と呼ばれる新しいパラダイム

を提案しました。 HuGS は、手作業で設計されたヒューリスティックとキュー駆動のセグメンテーション モデルを巧みに組み合わせることで、追加の事前知識がなくても、シーン内の一時的な注意散漫要素と静的要素を正確に区別できます。

具体的には、HuGS はまずヒューリスティック アルゴリズムを使用して、マルチビュー画像内の静的な一時的な要素を大まかに区別し、大まかな手がかりを出力します。次に、その大まかな手がかりを使用してセグメンテーション モデルをガイドし、より正確なセグメンテーション マスクを生成します。 NeRF をトレーニングする場合、これらのマスクは一時的なピクセルをシールドし、NeRF に対する一時的なディストラクターの影響を排除するために使用されます。 HuGSのデザインアイデア。 具体的な実装に関して、論文の著者は HuGS のセグメンテーション モデル

HuGS のセグメンテーション モデル

として Segment Anything Model (SAM) を選択しました。 SAM は現在、最も高度なプロンプト駆動のセグメンテーション モデルであり、ポイント、ボックス、マスクなどのさまざまな種類のプロンプト入力を受け入れ、対応するインスタンス セグメンテーション マスクを出力できます。

ヒューリスティックアルゴリズムに関しては、著者は詳細な分析の後、結合ヒューリスティック

を提案しました。Structure-from-Motion(SfM)に基づくヒューリスティックは、シーンの高周波静的詳細をキャプチャするために使用されます。一方、カラー残差ヒューリスティックに基づくヒューリスティックは、低周波の静的な詳細をキャプチャするために使用されます。 2 つのヒューリスティックによって出力される大まかな静的マスクは互いに異なり、それらの和集合は SAM をより正確な静的マスクに導くために使用されます。これら 2 つのヒューリスティックをシームレスに組み合わせることで、HuGS は、さまざまなテクスチャの詳細に直面したときに、さまざまなタイプの静的要素を確実に識別できます。

HuGS 流程图。(a) 给定带有瞬态干扰物的静态场景下的无序多视角图像,HuGS 首先获得两种启发式信息。(b) 基于 SfM 的启发式算法通过 SfM 来获取区分静态特征点和瞬态特征点,然后使用稀疏的静态特征点作为提示引导 SAM 生成稠密的静态掩膜。(c) 基于颜色残差的启发式算法依赖于部分训练(即只经过数千次迭代训练)的 NeRF。其预测图像和真实图像之间的颜色残差可以用于生成另一组静态掩膜。(d) 两种不同掩膜的结合最终引导 SAM 生成 (e) 每个图像的准确静态掩膜。SfM 是一种从二维图像重建三维结构的技术。在提取图像的二维特征后,SfM 会对特征进行匹配和几何验证、重建稀疏三维点云。SfM 在 NeRF 中常被用于估计图像相机位姿,而论文作者发现 SfM 还可以被用来区分场景的静瞬态元素。设某个二维特征点的匹配数量为与其对应相同三维点云点的其他二维特征点数量,那么来自静态区域的二维特征点的匹配数量要大于来自瞬态区域的特征点匹配数量。基于该发现,我们可以在匹配数量上设置阈值来过滤得到静态特征点,再通过 SAM 将静态特征点转换为静态掩膜。为了验证该发现的正确性,论文作者在 Kubric 数据集上进行了统计。正如下图所示,不同图像区域的特征点匹配数量有显著的差异。另一个可视化结果表明合理的阈值设置可以在去除瞬态特征点的同时保留静态特征点。

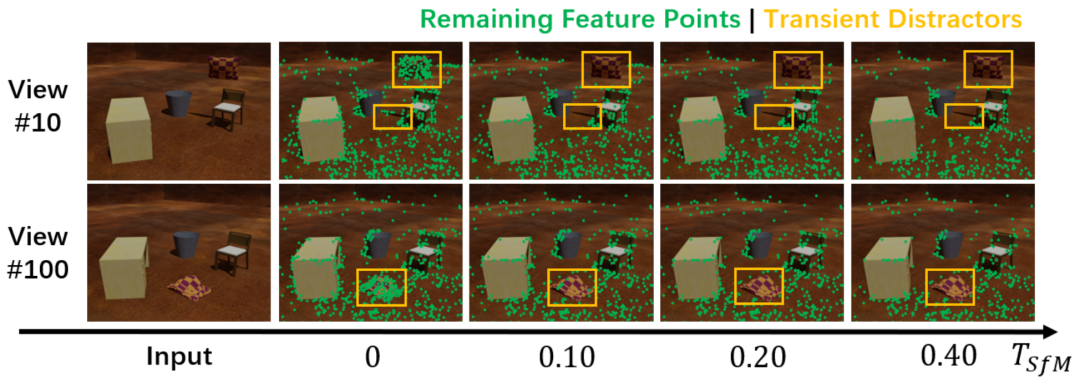

左图为来自不同图像区域的特征点在匹配数量上的数量分布直方图,其中静态区域特征点的匹配数量均匀分布在 [0,200] 区间内,而瞬态区域特征点的匹配数量趋近于 0、集中分布在 [0,10] 区间内。右图为经过过滤后不同图像区域的剩余特征点密度随阈值变化的曲线图,其中整张图像与静态区域的剩余特征点密度随着阈值上升呈线性下降,而瞬态区域的剩余特征点密度呈指数下降、并在阈值大于 0.2 后几乎为 0。 两个不同视角图像的剩余特征点随阈值上升而变化的可视化分布情况。位于瞬态区域内的剩余特征点被逐渐去除,而静态区域的大部分特征点仍被保留。虽然基于 SfM 的启发式在大部分场景中表现良好,但它无法很好地捕获静态平滑纹理,这是因为平滑纹理缺乏显著特征、难以被 SfM 的特征提取算法识别。为了能够识别低频纹理,论文作者引入了基于颜色残差的启发式算法:首先在原始多视角图像上部分训练 NeRF(即只迭代数千次)、得到欠拟合模型,然后获取渲染图像和目标图像之间的颜色残差。正如背景介绍所述,低频静态纹理区域的颜色残差要小于其他类型区域的残差,因此可以在颜色残差上设置阈值获取与低频静态纹理相关的粗糙掩膜。通过颜色残差得到的掩膜可以和通过 SfM 得到的掩膜互补,形成完整结果。

两个不同视角图像的剩余特征点随阈值上升而变化的可视化分布情况。位于瞬态区域内的剩余特征点被逐渐去除,而静态区域的大部分特征点仍被保留。虽然基于 SfM 的启发式在大部分场景中表现良好,但它无法很好地捕获静态平滑纹理,这是因为平滑纹理缺乏显著特征、难以被 SfM 的特征提取算法识别。为了能够识别低频纹理,论文作者引入了基于颜色残差的启发式算法:首先在原始多视角图像上部分训练 NeRF(即只迭代数千次)、得到欠拟合模型,然后获取渲染图像和目标图像之间的颜色残差。正如背景介绍所述,低频静态纹理区域的颜色残差要小于其他类型区域的残差,因此可以在颜色残差上设置阈值获取与低频静态纹理相关的粗糙掩膜。通过颜色残差得到的掩膜可以和通过 SfM 得到的掩膜互补,形成完整结果。

两种启发式算法的组合,其中(a)为输入的目标图像,(d)为只迭代五千次的 NeRF 渲染结果。基于 SfM 的启发式得到的静态掩膜 (b) 在捕获高频静态细节(如盒子纹理)的同时遗漏了静态平滑部分(如白色椅背)。基于颜色残差的启发式得到的静态掩膜(e)及其单独引导 SAM 得到的分割掩膜(f)取得了相反效果。它们的并集(c)在覆盖所有静态元素的同时区分了瞬态干扰物(即粉色气球)。

这里展示了 HuGS 在两个不同真实场景下的可视化分割过程,以及基线模型 Mip-NeRF 360 在应用静态掩膜前后的渲染结果比较。在组合启发式算法和 SAM 的帮助下,HuGS 可以生成准确的静态掩膜,而 Mip-NeRF 360 在应用静态掩膜后消除了大量伪影,RGB 图和深度图的渲染质量有明显提升。

这里展示了论文方法在三个数据集和两个基线模型上的实验结果,以及与现有方法的比较。现有方法要么无法消除瞬态干扰物带来的伪影,要么抹除掉过多的静态纹理细节。相比之下,论文方法可以在有效消除伪影的同时更好地保留静态细节。

论文作者同样在 Kubric 数据集上与现有分割算法进行了比较。实验结果表明,即使提供了先验知识,语义分割、视频分割等现有分割模型依然表现不佳,这是因为现有分割模型都没有针对该任务进行设计。现有基于启发式的方法虽然可以大致定位瞬态干扰物的位置,但无法得到更加精确的分割结果。与之相比,HuGS 通过结合启发式算法和分割模型,在没有额外先验知识的情况下准确分离瞬态干扰物和静态场景元素。

论文作者还通过去除不同组件的方式来验证各组件对 HuGS 造成的影响。结果表明,缺少基于 SfM 的启发式的模型 (b) 无法很好地重建蓝色方框中的低频静态纹理,而缺少基于颜色残差的启发式的模型 (c) 和 (d) 丢失了黄色方框中的高频静态细节。相比之下,完整方法 (f) 的数值指标和可视化结果最佳。

论文提出了一种新颖的启发式引导分割范式,有效解决了 NeRF 现实训练中常见的瞬时干扰问题。通过战略性地结合手工设计的启发式和最先进的分割模型的互补优势,该方法在没有任何先验知识的情况下实现了对不同场景中瞬时干扰物的高度准确分割。通过精心设计的启发式,论文方法能够稳健地捕捉到高频和低频的静态场景元素。大量实验证明了该方法的先进性。以上是CVPR最佳论文候选 | NeRF新突破,用启发式引导分割去除瞬态干扰物,无需额外先验知识的详细内容。更多信息请关注PHP中文网其他相关文章!

既存の手法とこの論文で提案するヒューリスティックガイドセグメンテーション(HuGS)との比較。静的なシーンが一時的な妨害物によって妨害される場合、(a) セグメンテーション ベースの方法は事前の知識に依存し、予期しない一時的なオブジェクト (ピザなど) を識別できないため、関連するアーティファクトが発生します。(b) ヒューリスティック ベースの方法。この方法はより一般的ですが、精度が十分ではありません(たとえば、高周波の静的なテーブルクロスのテクスチャが失われます)、(c)HuGS はそれらの利点を組み合わせて、一時的なディストラクタと静的なシーン要素を正確に分離できるため、NeRF の結果が大幅に向上します。

既存の手法とこの論文で提案するヒューリスティックガイドセグメンテーション(HuGS)との比較。静的なシーンが一時的な妨害物によって妨害される場合、(a) セグメンテーション ベースの方法は事前の知識に依存し、予期しない一時的なオブジェクト (ピザなど) を識別できないため、関連するアーティファクトが発生します。(b) ヒューリスティック ベースの方法。この方法はより一般的ですが、精度が十分ではありません(たとえば、高周波の静的なテーブルクロスのテクスチャが失われます)、(c)HuGS はそれらの利点を組み合わせて、一時的なディストラクタと静的なシーン要素を正確に分離できるため、NeRF の結果が大幅に向上します。  HuGS のセグメンテーション モデル

HuGS のセグメンテーション モデル