为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Herausgeber |. ScienceAI

Frage- und Antwortdatensätze (QA) spielen eine wichtige Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen.

Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf.

Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells, wissenschaftliche Fragen zu beantworten, nicht vollständig testen. Im Gegensatz dazu kann die offene Fragebeantwortung (openQA) die Fähigkeiten des Modells umfassender bewerten, es fehlen jedoch geeignete Bewertungsmetriken.

Zweitens stammen viele Inhalte bestehender Datensätze aus Lehrbüchern auf Universitätsniveau und darunter, was es schwierig macht, die hochgradigen Wissensspeicherfähigkeiten von LLM in tatsächlichen akademischen Forschungs- oder Produktionsumgebungen zu bewerten.

Drittens basiert die Erstellung dieser Benchmark-Datensätze auf menschlichen Expertenkommentaren.

Die Bewältigung dieser Herausforderungen ist für den Aufbau eines umfassenderen QA-Datensatzes von entscheidender Bedeutung und trägt auch zu einer genaueren Bewertung des wissenschaftlichen LLM bei.

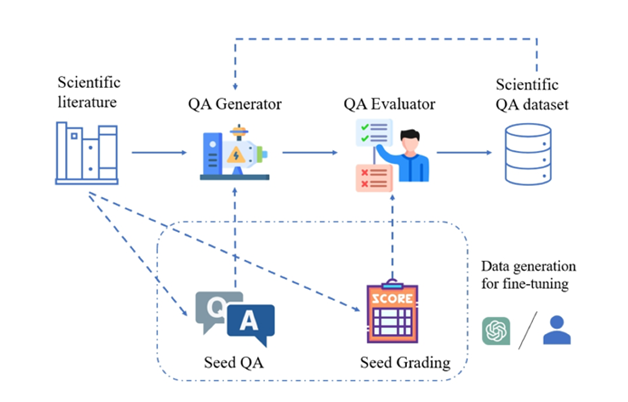

Abbildung: SciQAG-Framework zur Generierung hochwertiger wissenschaftlicher Frage- und Antwortpaare aus wissenschaftlicher Literatur.

Zu diesem Zweck haben das Argonne National Laboratory in den Vereinigten Staaten, das Team von Professor Ian Foster von der University of Chicago (Gordon-Bell-Preisträger 2002), das UNSW AI4Science-Team von Professor Bram Hoex von der University of New South Wales, Australien, das AI4Science-Unternehmen GreenDynamics und das Team von Professor Jie Chunyu von der City University of Hong Kong schlugen gemeinsam SciQAG vor, das erste neuartige Framework, das automatisch hochwertige wissenschaftliche offene Frage- und Antwortpaare aus großen wissenschaftlichen Literaturkorpora auf der Grundlage großer Sprachmodelle generiert (LLM).

Papierlink:https://arxiv.org/abs/2405.09939

Github-Link:https://github.com/MasterAI-EAM/SciQAG

Basierend auf SciQAG haben die Forscher erstellt SciQAG-24D, ein umfangreicher, hochwertiger, offener wissenschaftlicher QA-Datensatz, enthält 188.042 QA-Paare, die aus 22.743 wissenschaftlichen Arbeiten in 24 wissenschaftlichen Bereichen extrahiert wurden, und soll der Feinabstimmung von LLM und der Bewertung wissenschaftlicher Probleme dienen. Lösungsfähigkeiten.

Experimente zeigen, dass die Feinabstimmung von LLMs am SciQAG-24D-Datensatz ihre Leistung bei der Beantwortung offener Fragen und bei wissenschaftlichen Aufgaben erheblich verbessern kann.

Der Datensatz, das Modell und der Evaluierungscode wurden als Open Source bereitgestellt (https://github.com/MasterAI-EAM/SciQAG), um die gemeinsame Entwicklung offener wissenschaftlicher Fragen und Antworten durch die AI for Science-Community zu fördern.

SciQAG-Framework mit SciQAG-24D-Benchmark-Datensatz

SciQAG besteht aus einem QA-Generator und einem QA-Evaluator mit dem Ziel, schnell verschiedene offene Frage- und Antwortpaare auf der Grundlage wissenschaftlicher Literatur in großem Maßstab zu generieren. Zunächst wandelt der Generator wissenschaftliche Arbeiten in Frage-Antwort-Paare um, anschließend filtert der Bewerter die Frage-Antwort-Paare heraus, die nicht den Qualitätsstandards entsprechen, und erhält so einen qualitativ hochwertigen wissenschaftlichen Frage-Antwort-Datensatz.

QA-Generator

Die Forscher entwarfen durch vergleichende Experimente eine zweistufige Eingabeaufforderung (Prompt), die es LLM ermöglichte, zunächst Schlüsselwörter zu extrahieren und dann Frage- und Antwortpaare basierend auf den Schlüsselwörtern zu generieren.

Da der generierte Frage- und Antwortdatensatz den „geschlossenen Buch“-Modus annimmt, wird das Originalpapier nicht bereitgestellt und konzentriert sich nur auf das extrahierte wissenschaftliche Wissen selbst. Die Eingabeaufforderung erfordert, dass die generierten Frage- und Antwortpaare nicht darauf angewiesen sind auf oder verweisen Sie auf die eindeutigen Informationen in der Originalarbeit (z. B. ist keine moderne Nomenklatur zulässig, wie „diese/diese Arbeit“, „diese/diese Forschung“ usw.) oder stellen Sie Fragen zu den Tabellen/Bildern in der Artikel).

Um Leistung und Kosten in Einklang zu bringen, entschieden sich die Forscher für die Feinabstimmung eines Open-Source-LLM als Generator. SciQAG-Benutzer können je nach ihren eigenen Umständen ein beliebiges Open-Source- oder Closed-Source-LLM als Generator wählen, indem sie entweder Feinabstimmung oder Prompt-Word-Engineering nutzen.

QA-Evaluator

Der Evaluator wird verwendet, um zwei Zwecke zu erfüllen: (1) Bewerten der Qualität generierter Frage- und Antwortpaare; (2) Verwerfen von Frage- und Antwortpaaren geringer Qualität basierend auf festgelegten Kriterien.

Forscher haben einen umfassenden Bewertungsindex RACAR entwickelt, der aus fünf Dimensionen besteht: Relevanz, Agnostizismus, Vollständigkeit, Genauigkeit und Angemessenheit.

In dieser Studie verwendeten die Forscher GPT-4 direkt als QA-Evaluator, um die generierten QA-Paare gemäß RACAR mit einer Bewertungsstufe von 1–5 zu bewerten (1 bedeutet inakzeptabel, 5 bedeutet völlig akzeptabel).

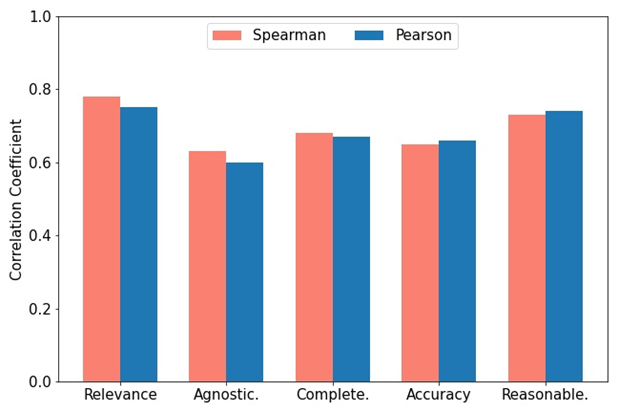

Wie in der Abbildung gezeigt, verwendeten zwei Domänenexperten zur Messung der Konsistenz zwischen GPT-4 und manueller Bewertung die RACAR-Metrik, um eine manuelle Bewertung für 10 Artikel (insgesamt 100 Frage- und Antwortpaare) durchzuführen. Benutzer können je nach Bedarf jedes Open-Source- oder Closed-Source-LLM als Evaluator wählen.

图示:GPT-4 分配分数与专家标注分数之间的 Spearman 和 Pearson 相关性。

SciQAG 框架的运用

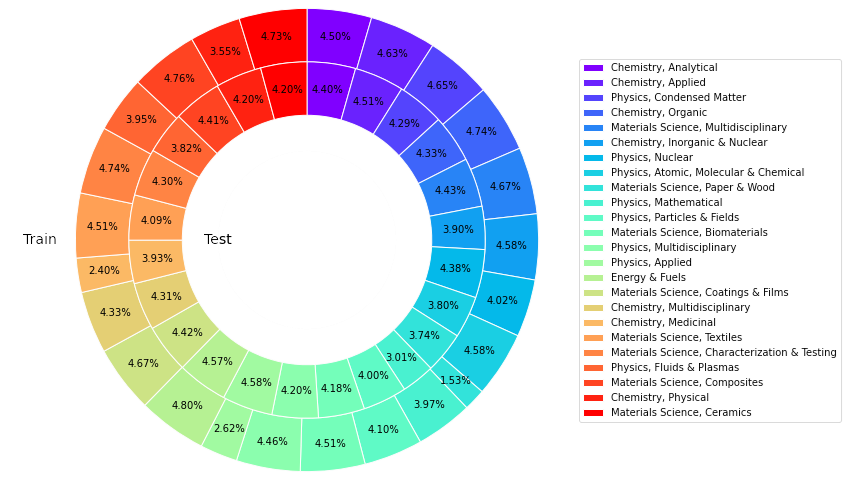

该研究从Web of Science (WoS)核心合集数据库中获取了24类高引用论文共计22,743篇,来自材料科学、化学、物理、能源等领域,旨在构建一个可靠、丰富、平衡且具有代表性的科学知识来源。

为了微调开源LLM以形成QA生成器,研究人员从论文集合中随机选择426篇论文作为输入,通过提示GPT-4生成4260个种子QA对。

使用经过训练的QA生成器在剩余论文上进行推理,共生成227,430个QA对(包括种子QA对)。从每个类别中抽取50篇论文(共1,200篇),使用GPT-4计算每个生成的QA对的RACAR分数,过滤掉任一维分数低于3的QA对作为测试集。

对于余下的QA对,则使用基于规则的方法过滤掉所有包含论文特有信息的问答对以形成训练集。

SciQAG-24D 基准数据集

基于以上,研究人员建立了开放式科学 QA 基准数据集 SciQAG-24D,筛选后的训练集包括 21,529 篇论文和 179,511 个 QA 对,而筛选后的测试集包含 1,199 篇论文和 8,531 个 QA 对。

统计显示,99.15%回答中的数据来自原论文,87.29%的问题相似度在0.3以下,且回答对原文内容的覆盖度达到78.26%。

该数据集应用广泛:训练集可用于微调 LLM,为其注入科学知识;测试集可⽤于评估LLM在某特定或整体科学领域中的开放式QA任务表现。由于测试集较大,因此它也可以作为高质量数据用于微调。

图示:SciQAG-24D数据集训练和测试中不同类别的文章比例。

实验结果

研究人员进行了全面的实验以对比不同语言模型之间的科学问答性能差异及探索微调的影响。

零样本设定(zero-shot setting)

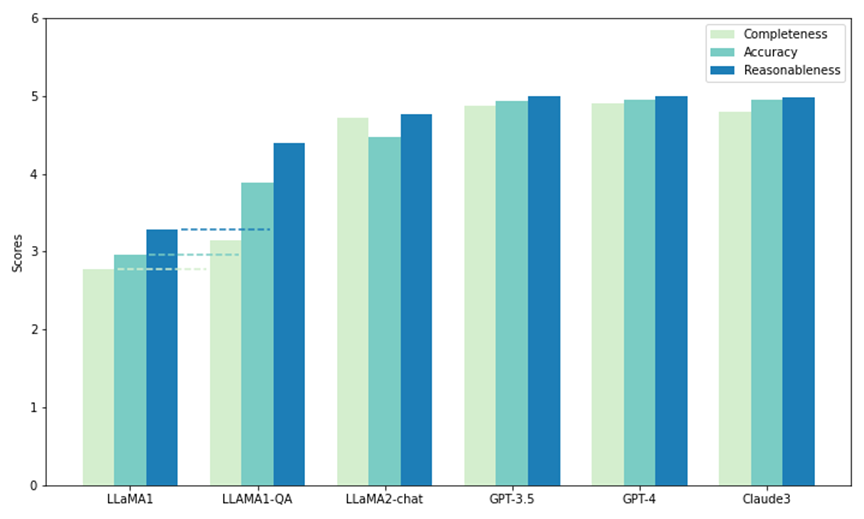

研究人员使用 SciQAG-24D 中的部分测试集对五个模型进行了零样本性能对比。其中两个是开源的 LLM:LLaMA1 (7B) 和 LLaMA2-chat (7B),其余的是闭源 LLM 。

通过API调用:GPT3.5 (gpt-3.5-turbo)、GPT-4 (gpt-4-1106-preview) 和 Claude 3 (claude-3-opus-20240229)。每个模型在测试中被提示了 1000 个问题,并通过 CAR 指标(由RACAR指标调整而来,只关注回答评估)评估其输出,以衡量其在回答科学研究问题方面的零样本能力。

如图所示,在所有模型中,GPT-4 在完备性(4.90)和合理性(4.99)方面得分最高,而 Claude 3 的准确性得分最高(4.95)。GPT-3.5 的表现也非常出色,在所有指标上的得分都紧随 GPT-4 和 Claude 3 之后。

值得注意的是,LLaMA1 在所有三个维度上的得分都最低。相比之下,LLaMA2-chat 模型虽然得分不如 GPT 模型高,但在所有指标上都比原来的 LLaMA1 有了大幅提高。结果表明了商用LLM在回答科学问题方面的卓越性能,同时开源模型(如 LLaMA2-chat)也在这个方面取得了显著进步。

图示:SciQAG-24D上的零样本测试和微调测试(LLAMA1-QA)

微调设定(fine-tuning setting)

研究人员选择了零样本性能最差的 LLaMA1 在SciQAG-24D的训练集上进行微调,以获得 LLaMA1-QA。通过三个实验,研究人员证明 SciQAG-24D 可以作为有效的微调数据,提高下游科学任务的性能:

(a)LLaMA-QA与原始 LLaMA1的在未见过的SciQAG-24D测试集上的表现比较。

如上图所示,与原始 LLaMA1相比,LLaMA1-QA的性能有了显著提高(完整性提高了13%,准确性和合理性提高了 超过30%)。这表明LLaMA1已经从SciQAG-24D的训练数据中学习了回答科学问题的逻辑,并内化了一些科学知识。

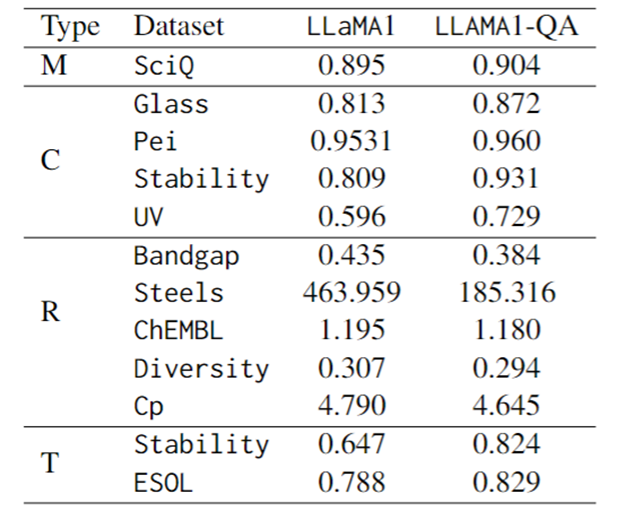

(b)在 SciQ(一个科学 MCQ 基准)上的微调表现比较。

下表的第一行显示LLaMA1-QA比LLaMA1稍有进步(+1%)。根据观察,微调也增强了模型的指令跟随能力:无法解析输出的概率从LLaMA1的 4.1%降至LLaMA1-QA的 1.7%。

(c)在多种科学任务上的微调表现比较。

评估指标上,分类任务使用F1-score,回归任务使用MAE,转换任务使用KL散度。如下表所示,科学任务中LLaMA1-QA与LLaMA1模型相比有明显改善。

最明显的改进体现在回归任务中,MAE从463.96降至185.32。这些发现表明,在训练过程中加入QA对可以增强模型学习和应用科学知识的能力,从而提高其在下游预测任务中的表现。

令人惊讶的是,与专门设计的具有特征的机器学习模型相比,LLM 可以在某些任务中取得相当甚至超越它们的结果。例如,在带隙任务中,虽然LLaMA1-QA 的表现不如 MODNet 等模型(0.3327),但它已经超过了AMMExpress v2020(0.4161)。

在多样性任务中,LLaMA1-QA 的表现优于深度学习基线(0.3198)。这些研究结果表明,LLM在特定科学任务中具有巨大潜力。

图示:LLaMA1和LLaMA1-QA在SciQ和科学任务上的微调表现(M代表多项选择,C代表分类,R代表回归,T代表转换)

总结与展望

(1)SciQAG是一个从科学文献中生成QA对的框架,结合用于评估和筛选QA对的RACAR指标,可高效地为资源匮乏的科学领域生成大量基于知识的QA数据。

(2)团队生成了一个包含188,042个QA对的综合开源科学QA数据集,称为SciQAG-24D。训练集用于微调LLM,测试集评估LLM在开放式闭卷科学QA任务上的表现。

对SciQAG-24D测试集上几个LLM的零样本性能进行了比较,并在SciQAG-24D训练集上微调了LLaMA1,得到了LLaMA1-QA。这种微调显著提高了其在多个科学任务上的表现。

(3)研究表明,LLM在科学任务中具有潜⼒,LLaMA1-QA的结果可以达到甚⾄超过机器学习基线的⽔平。这证明了SciQAG-24D的多方面效用,表明将科学QA数据纳入训练过程可以增强LLM的学习和应用科学知识的能力。

以上是为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

突破传统缺陷检测的界限,\'Defect Spectrum\'首次实现超高精度丰富语义的工业缺陷检测。

Jul 26, 2024 pm 05:38 PM

突破传统缺陷检测的界限,\'Defect Spectrum\'首次实现超高精度丰富语义的工业缺陷检测。

Jul 26, 2024 pm 05:38 PM

在现代制造业中,精准的缺陷检测不仅是保证产品质量的关键,更是提升生产效率的核心。然而,现有的缺陷检测数据集常常缺乏实际应用所需的精确度和语义丰富性,导致模型无法识别具体的缺陷类别或位置。为了解决这一难题,由香港科技大学广州和思谋科技组成的顶尖研究团队,创新性地开发出了“DefectSpectrum”数据集,为工业缺陷提供了详尽、语义丰富的大规模标注。如表一所示,相比其他工业数据集,“DefectSpectrum”数据集提供了最多的缺陷标注(5438张缺陷样本),最细致的缺陷分类(125种缺陷类别

英伟达对话模型ChatQA进化到2.0版本,上下文长度提到128K

Jul 26, 2024 am 08:40 AM

英伟达对话模型ChatQA进化到2.0版本,上下文长度提到128K

Jul 26, 2024 am 08:40 AM

开放LLM社区正是百花齐放、竞相争鸣的时代,你能看到Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1等许多表现优良的模型。但是,相比于以GPT-4-Turbo为代表的专有大模型,开放模型在很多领域依然还有明显差距。在通用模型之外,也有一些专精关键领域的开放模型已被开发出来,比如用于编程和数学的DeepSeek-Coder-V2、用于视觉-语言任务的InternVL

数百万晶体数据训练,解决晶体学相位问题,深度学习方法PhAI登Science

Aug 08, 2024 pm 09:22 PM

数百万晶体数据训练,解决晶体学相位问题,深度学习方法PhAI登Science

Aug 08, 2024 pm 09:22 PM

编辑|KX时至今日,晶体学所测定的结构细节和精度,从简单的金属到大型膜蛋白,是任何其他方法都无法比拟的。然而,最大的挑战——所谓的相位问题,仍然是从实验确定的振幅中检索相位信息。丹麦哥本哈根大学研究人员,开发了一种解决晶体相问题的深度学习方法PhAI,利用数百万人工晶体结构及其相应的合成衍射数据训练的深度学习神经网络,可以生成准确的电子密度图。研究表明,这种基于深度学习的从头算结构解决方案方法,可以以仅2埃的分辨率解决相位问题,该分辨率仅相当于原子分辨率可用数据的10%到20%,而传统的从头算方

谷歌AI拿下IMO奥数银牌,数学推理模型AlphaProof面世,强化学习 is so back

Jul 26, 2024 pm 02:40 PM

谷歌AI拿下IMO奥数银牌,数学推理模型AlphaProof面世,强化学习 is so back

Jul 26, 2024 pm 02:40 PM

对于AI来说,奥数不再是问题了。本周四,谷歌DeepMind的人工智能完成了一项壮举:用AI做出了今年国际数学奥林匹克竞赛IMO的真题,并且距拿金牌仅一步之遥。上周刚刚结束的IMO竞赛共有六道赛题,涉及代数、组合学、几何和数论。谷歌提出的混合AI系统做对了四道,获得28分,达到了银牌水平。本月初,UCLA终身教授陶哲轩刚刚宣传了百万美元奖金的AI数学奥林匹克竞赛(AIMO进步奖),没想到7月还没过,AI的做题水平就进步到了这种水平。IMO上同步做题,做对了最难题IMO是历史最悠久、规模最大、最负

PRO | 为什么基于 MoE 的大模型更值得关注?

Aug 07, 2024 pm 07:08 PM

PRO | 为什么基于 MoE 的大模型更值得关注?

Aug 07, 2024 pm 07:08 PM

2023年,几乎AI的每个领域都在以前所未有的速度进化,同时,AI也在不断地推动着具身智能、自动驾驶等关键赛道的技术边界。多模态趋势下,Transformer作为AI大模型主流架构的局面是否会撼动?为何探索基于MoE(专家混合)架构的大模型成为业内新趋势?大型视觉模型(LVM)能否成为通用视觉的新突破?...我们从过去的半年发布的2023年本站PRO会员通讯中,挑选了10份针对以上领域技术趋势、产业变革进行深入剖析的专题解读,助您在新的一年里为大展宏图做好准备。本篇解读来自2023年Week50

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

编辑|ScienceAI问答(QA)数据集在推动自然语言处理(NLP)研究发挥着至关重要的作用。高质量QA数据集不仅可以用于微调模型,也可以有效评估大语言模型(LLM)的能力,尤其是针对科学知识的理解和推理能力。尽管当前已有许多科学QA数据集,涵盖了医学、化学、生物等领域,但这些数据集仍存在一些不足。其一,数据形式较为单一,大多数为多项选择题(multiple-choicequestions),它们易于进行评估,但限制了模型的答案选择范围,无法充分测试模型的科学问题解答能力。相比之下,开放式问答

准确率达60.8%,浙大基于Transformer的化学逆合成预测模型,登Nature子刊

Aug 06, 2024 pm 07:34 PM

准确率达60.8%,浙大基于Transformer的化学逆合成预测模型,登Nature子刊

Aug 06, 2024 pm 07:34 PM

编辑|KX逆合成是药物发现和有机合成中的一项关键任务,AI越来越多地用于加快这一过程。现有AI方法性能不尽人意,多样性有限。在实践中,化学反应通常会引起局部分子变化,反应物和产物之间存在很大重叠。受此启发,浙江大学侯廷军团队提出将单步逆合成预测重新定义为分子串编辑任务,迭代细化目标分子串以生成前体化合物。并提出了基于编辑的逆合成模型EditRetro,该模型可以实现高质量和多样化的预测。大量实验表明,模型在标准基准数据集USPTO-50 K上取得了出色的性能,top-1准确率达到60.8%。

Nature观点,人工智能在医学中的测试一片混乱,应该怎么做?

Aug 22, 2024 pm 04:37 PM

Nature观点,人工智能在医学中的测试一片混乱,应该怎么做?

Aug 22, 2024 pm 04:37 PM

编辑|ScienceAI基于有限的临床数据,数百种医疗算法已被批准。科学家们正在讨论由谁来测试这些工具,以及如何最好地进行测试。DevinSingh在急诊室目睹了一名儿科患者因长时间等待救治而心脏骤停,这促使他探索AI在缩短等待时间中的应用。Singh利用了SickKids急诊室的分诊数据,与同事们建立了一系列AI模型,用于提供潜在诊断和推荐测试。一项研究表明,这些模型可以加快22.3%的就诊速度,将每位需要进行医学检查的患者的结果处理速度加快近3小时。然而,人工智能算法在研究中的成功只是验证此