摩尔线程'夸娥智算集群 KUAE” 1.2 版本发布:支持 64K 长文本、新增 LLaMA2 全系列大模型等

本站 8 月 19 日消息,摩尔线程“夸娥智算集群 KUAE” 1.2 版本正式发布。该版本对软硬件层面的综合性进行优化,支持 64K 长文本、新增 LLaMA2 全系列大模型、百川、雅意、Qwen2、Mixtral(MoE 8x7B)等模型。

-

MFU 提升

- 使用千卡集群训练千亿模型,MFU 提升 10%。

- 稠密模型集群训练 MFU 最高达到 55%。

-

Flash Attention2 优化

- 集成 MUSA SDK 平台优化后的 Flash Attention2 技术,提升大模型训练效率与资源利用率。

-

64K 长文本支持

- 增强对长文本大模型训练的支持,优化处理长文本理解和生成任务的能力。

-

支持混合专家模型 MoE

- All2All 优化,针对 muDNN 算子优化不同形状下的矩阵运算,支持 MoE 大模型训练。

-

断点续训

- 提升 Checkpoint 读写性能,提高训练效率。

-

优化 DeepSpeed

- 适配摩尔线程 GPU 集群的 DeepSpeed 与 Ulysses,强化长文本训练支持。

- 适配国内外多款大模型。

-

稳定性提升

- 软硬件成熟,实现连续无故障训练 15 天。

- 引入 KUAE Aegis 可靠性功能,加强监控、自动诊断与故障恢复能力。

-

可视化 / 可观测

- 引入 PerfSight 性能监控系统,实时显示训练过程中的资源消耗与性能数据。

-

内置模型库新增大模型

- 新增 LLaMA2 全系列、百川、雅意、Qwen2、Mixtral(MoE 8x7B)等模型。

以上是摩尔线程'夸娥智算集群 KUAE” 1.2 版本发布:支持 64K 长文本、新增 LLaMA2 全系列大模型等的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

摩尔线程与百度地图签订战略合作,共创全新一代数字孪生地图

Jul 25, 2024 am 12:31 AM

摩尔线程与百度地图签订战略合作,共创全新一代数字孪生地图

Jul 25, 2024 am 12:31 AM

本站7月24日消息,近日,摩尔线程与百度地图签署战略合作协议,双方将发挥各自技术、产品方面的优势,共同推动数字孪生地图的技术创新。根据合作协议,双方将围绕数字孪生地图项目建设,利用百度地图的地图引擎优势、数字孪生技术优势、地图大数据应用优势,以及摩尔线程全功能GPU的3D图形渲染和AI计算技术优势,积极开展深入广泛的持续性合作,共同推动数字孪生地图解决方案的应用和规模化落地。据摩尔线程官方介绍,地图数据作为国家的关键资产,数字孪生地图尤其凸显了其在高负载渲染场景中的重要性,这对GPU的渲染效能及

真正的国产显卡之光!摩尔线程国产GPU、AI与元宇宙多项进展深入解读

Jun 05, 2023 am 11:10 AM

真正的国产显卡之光!摩尔线程国产GPU、AI与元宇宙多项进展深入解读

Jun 05, 2023 am 11:10 AM

一、摩尔线程简史:光速创业全线出击如今,我们已经有了较为成熟的自主CPU处理器、NAND闪存、DRAM内存、OS操作系统,而作为计算平台中非常关键的一环,GPU显卡,却一直存在严重的缺失,主要是它不但在硬件设计上难度极大,生态培育更是难上加难,非一朝一夕之功。国内做GPU的企业其实并不少,但很多都是仅限特定行业领域,或者面向高性能计算,真正敢于全面布局,敢于进军消费者市场的,就不能不提到摩尔线程(MooreThread)。5月31日,摩尔线向快科技发出2023年夏季发布会的邀请,原本以为这次的核

AI主战场,万卡是标配:国产GPU万卡万P集群来了!

Jul 10, 2024 pm 03:07 PM

AI主战场,万卡是标配:国产GPU万卡万P集群来了!

Jul 10, 2024 pm 03:07 PM

ScalingLaw持续见效,让算力就快跟不上大模型的膨胀速度了。「规模越大、算力越高、效果越好」成为行业圭皋。主流大模型从百亿跨越到1.8万亿参数只用了1年,META、Google、微软这些巨头也从2022年起就在搭建15000卡以上的超大集群。「万卡已然成为AI主战场的标配。」然而在国内,全国产化的GPU万卡集群,则是屈指可数。有超大规模,同时还具备超强通用性的万卡集群,更是行业空白。当国产GPU万卡万P集群首次亮相时,自然就引发了行业广泛关注。7月3日,摩尔线程在上海重磅宣布其AI旗舰产品

支持游戏《绝区零》,摩尔线程发布显卡驱动 v260.70.2 版本更新

Jul 22, 2024 pm 08:44 PM

支持游戏《绝区零》,摩尔线程发布显卡驱动 v260.70.2 版本更新

Jul 22, 2024 pm 08:44 PM

本站7月22日消息,摩尔线程今日发布版本号为v260.70.2的图形显卡驱动程序。此次更新支持游戏《绝区零》,并修复了在游戏启动大厅和游戏内场景概率性渲染缺失及其他的一些问题。与此同时,新驱动着重提升了包括《乐高积木传说》《求生岛:不老泉传说》以及《巴别塔圣歌》在内的多款热门游戏的性能表现。此外,新驱动还特别对部分DirectX11游戏性能进行了优化,例如《远征:泥泞奔驰游戏》平均帧率提升超过150%,《清零计划2:天启派对》平均帧率提升约150%。显卡用户可通过访问摩尔线程官网下载最新版本v2

摩尔线程'智娱摩方”台式电脑主机配置上新:i5-14400F + MTT S80 国产显卡售 7099 元

Jul 28, 2024 pm 05:14 PM

摩尔线程'智娱摩方”台式电脑主机配置上新:i5-14400F + MTT S80 国产显卡售 7099 元

Jul 28, 2024 pm 05:14 PM

本站7月28日消息,摩尔线程在去年6月30日推出了一款名为“智娱摩方”的台式电脑主机,宣称“注重游戏领域”,今天官方为该机推出“i5-14400F+32GBRAM+1TB+MTTS80显卡”配置,商品页显示到手价为7099元。据悉,该游戏电脑采用了10核心16线程酷睿i5-14400F处理器、使用B760I登陆舰主板、运行内存为32GBDDR43200Mhz、自带PCIe4.01TBSSD,具体规格参考京东参数如下:GPU方面,“智娱摩方”游戏电脑采用了摩尔线程自家的MTTS80显卡,该显卡搭载

摩尔线程 MTT S30 国产显卡发售:4GB 显存、功耗 40W,售 399 元

Feb 22, 2024 am 08:00 AM

摩尔线程 MTT S30 国产显卡发售:4GB 显存、功耗 40W,售 399 元

Feb 22, 2024 am 08:00 AM

本站2月21日消息,摩尔线程MTTS30国产显卡目前已经上架京东,首发价399元,需支付50元定金。本站注意到,摩尔线程MTTS30显卡基于MUSA统一系统架构打造,兼容x86、Arm、龙芯LoongArch等多种CPU架构,支持OpenGL、OpenGLES及Vulkan等多种图形API,支持4K画面输出、AV1编解码,可容纳于紧凑型机箱中,无需额外供电。参数方面,这款显卡拥有1024MUSA核心,核心频率1.3Ghz,显卡4GB,功耗40W,卡长144mm,卡宽67mm,配备1个HDMI2.

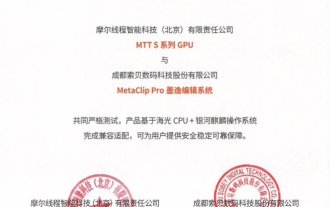

摩尔线程与索贝实现 CPU、GPU、软件、系统全链条国产化全域超清解决方案

Sep 03, 2024 am 12:00 AM

摩尔线程与索贝实现 CPU、GPU、软件、系统全链条国产化全域超清解决方案

Sep 03, 2024 am 12:00 AM

本站9月2日消息,摩尔线程与索贝合作,在第三十一届北京国际广播电影电视展览会上展示了“国产化全域超清解决方案”。基于摩尔线程全功能GPU,索贝的MetaClipPro(墨逸)非线性编辑系统及图文包装系统能够在国产环境中流程稳定运行。▲图源摩尔线程公众号,下同本站获悉,双方通过联合开发,已成功实现了从软件、CPU、操作系统到GPU的全链条国产化。索贝还推出了多款搭载海光3330系列和海光7000系列CPU、银河麒麟操作系统以及摩尔线程全功能GPU的国产解决方案。

摩尔线程发布显卡驱动 v270.80:支持 OpenGL 4.1 与 AV1 编码,解决 DX11 下《黑神话:悟空》Benchmark 闪退

Aug 20, 2024 pm 07:52 PM

摩尔线程发布显卡驱动 v270.80:支持 OpenGL 4.1 与 AV1 编码,解决 DX11 下《黑神话:悟空》Benchmark 闪退

Aug 20, 2024 pm 07:52 PM

本站8月20日消息,摩尔线程今日发布版本号为v270.80的图形显卡驱动程序。新版驱动程序可以在Windows10和Windows11操作系统环境下实现对OpenGL4.1的全面支持,并且支持AV1格式编码和VC1格式解码。与此同时,新驱动解决了DirectX11模式下运行《黑神话・悟空》Benchmark的闪退问题,目前摩尔线程团队正在针对该游戏进行优化。新驱动对更多DirectX11游戏性能进行了优化,如《链在一起》平均帧率提升超150%,《收获日3》平均帧率提升超100%,DOTA2平均帧