构建负责任的人工智能代理:平衡创新与道德

人工智能 (AI) 正在改变行业,Salesforce 的 AgentForce 等自主 AI 代理和 AutoGPT 等开源工具引领潮流。这些代理自动执行复杂的任务,与其他系统协作并提高生产力。然而,随着它们变得更加自主,负责任的人工智能开发对于解决偏见、透明度和问责制等问题至关重要。

人工智能代理的快速采用引发了关于其伦理影响的争论。虽然它们具有彻底改变医疗保健、教育和销售等行业的巨大潜力,但如果设计不负责任,它们也会带来风险。开发者、组织和政府必须共同努力,确保这些系统既创新又符合道德。

构建负责任的人工智能代理意味着什么?

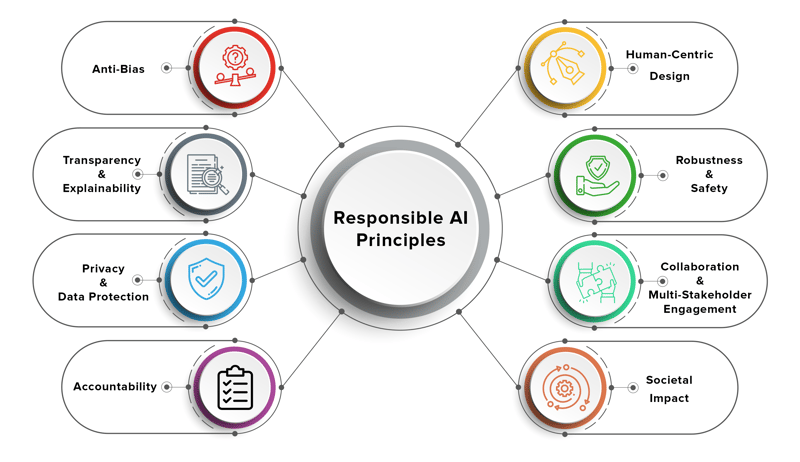

负责任的人工智能代理被设计为道德、透明和负责的,确保它们符合人类价值观并最大限度地减少伤害。这些代理人必须公平运作,尊重隐私,并为其决定提供明确的解释。

负责任的人工智能的关键原则包括:

- 公平:避免决策偏见,确保所有用户得到公平的结果。

- 透明度:让用户和利益相关者能够理解人工智能决策。

- 问责制:建立人工智能结果的责任并确保系统可以接受审核。

- 隐私:保护用户数据并确保安全操作。

- 可持续发展:设计节能且环保的人工智能系统。

构建负责任的人工智能不仅仅是一项技术挑战,它是一项多学科的努力,需要开发人员、伦理学家、政策制定者和最终用户之间的合作。

人工智能系统中的道德困境示例

随着人工智能代理变得更加自主,他们面临着道德困境,这对他们的设计和部署提出了挑战。以下是一些现实世界的例子:

1.决策偏差

在有偏见的数据集上训练的人工智能代理可能会做出歧视性的决定。例如:

- 由于招聘数据的历史偏差,招聘代理可能会偏爱某些人口统计数据。

- 金融人工智能代理可能会根据有偏见的信用评分模型拒绝向特定群体提供贷款。

2。缺乏透明度

许多人工智能代理以“黑匣子”的方式运作,做出难以解释或解释的决策。例如:

- 客户服务 AI 代理可能会在没有提供明确推理的情况下升级或解决问题,从而导致用户感到沮丧和不信任。

3。责任差距

当人工智能代理犯错时,谁负责?例如:

- 如果人工智能代理控制的自动驾驶汽车发生事故,责任应该归咎于开发商、制造商还是用户?

4。侵犯隐私

人工智能代理通常需要访问敏感的用户数据才能有效运行。然而:

- 销售人工智能代理可能会无意中共享机密客户信息,从而违反 GDPR 等隐私法。

5。在销售和营销中道德地使用人工智能

Salesforce 的 AgentForce 等工具正在通过自动化潜在客户开发和客户参与来改变销售和营销。然而:

- 如果人工智能代理使用操纵策略来追加销售产品,就会引发有关道德营销实践的问题。

这些困境凸显了将道德考虑纳入人工智能代理的设计和部署的重要性。

负责任的人工智能开发的框架和最佳实践

为了应对这些挑战,开发人员和组织可以采用以下框架和最佳实践:

1。道德人工智能框架

多个组织已经制定了负责任的人工智能指南,包括:

- Google 的人工智能原则:注重公平、隐私和问责制。

- OECD 人工智能原则:强调以人为本的价值观和透明度。

- Salesforce 的 AI 道德准则:旨在建立信任并确保 AI 系统的公平性。

2。偏差缓解

- 使用多样化且具有代表性的数据集来训练人工智能代理。

- 定期审核 AI 模型是否存在偏差,并根据需要重新训练它们。

- 实施公平性指标来评估人工智能决策对不同群体的影响。

3。可解释性和透明度

- 使用 S*HAP(SHapley Additive exPlanations)* 或 LIME(本地可解释模型不可知解释) 等技术来使 AI 决策可解释。

- 为用户提供关于人工智能代理如何做出决策的清晰解释。

4。问责机制

- 为人工智能项目建立清晰的治理结构。

- 将人工智能成果的责任分配给特定团队或个人。

- 维护 AI 代理操作的详细日志以进行审计。

5。隐私和安全

- 使用加密和安全协议来保护用户数据。

- 实施差分隐私技术来匿名化敏感信息。

- 遵守 GDPR 和 CCPA 等数据保护法规。

6。持续监控和反馈

- 实时监控 AI 代理以检测和解决问题。

- 收集用户反馈以提高人工智能代理的性能和道德一致性。

- 定期更新人工智能模型,以反映不断变化的社会规范和价值观。

利益相关者的角色

构建负责任的人工智能代理是一项共同的责任,需要多个利益相关者之间的协作:

政府

- 制定法规以确保人工智能系统公平、透明和负责任。

- 促进道德人工智能的研究和开发。

- 建立监督机构来监控人工智能代理的部署。

组织

- 制定负责任的人工智能的内部政策和指南。

- 投资培训计划,对员工进行道德人工智能实践教育。

- 与学术机构和非营利组织合作,推进符合道德的人工智能研究。

开发者

- 在人工智能代理的设计和开发过程中优先考虑道德因素。

- 倡导组织内负责任的人工智能实践。

- 随时了解道德人工智能框架和工具的最新进展。

Salesforce 和 AgentForce:案例研究

Salesforce 是客户关系管理 (CRM) 领域的领导者,一直处于负责任的 AI 开发的前沿。他们的 AgentForce 平台利用人工智能代理来自动化销售流程、提高客户参与度并推动业务增长。

Salesforce 的与众不同之处在于其对道德人工智能的承诺。该公司实施了强有力的指导方针,以确保其人工智能系统公平、透明和负责任。例如:

- 偏差检测:Salesforce 使用工具来识别和减轻其 AI 模型中的偏差。

- 可解释性:AgentForce 为用户提供关于如何提出人工智能驱动的推荐的清晰见解。

- 隐私:Salesforce 确保安全处理客户数据并符合全球法规。

通过优先考虑负责任的人工智能,Salesforce 为其他组织树立了可以效仿的基准。

结论

随着人工智能代理变得更加自主,平衡创新与道德至关重要。通过解决偏见、透明度和问责制等问题,我们可以确保人工智能代理不仅具有创新性,而且符合道德规范。

构建负责任的人工智能代理需要开发人员、组织和政府之间的协作努力。通过采用道德框架、减少偏见和确保透明度,我们可以创建造福社会、同时最大限度减少伤害的人工智能系统。 Salesforce 的 AgentForce 等工具展示了负责任的人工智能如何在保持信任和公平的同时推动创新。

人工智能的未来是光明的,但我们要确保它也是负责任的。

以上是构建负责任的人工智能代理:平衡创新与道德的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

神秘的JavaScript:它的作用以及为什么重要

Apr 09, 2025 am 12:07 AM

神秘的JavaScript:它的作用以及为什么重要

Apr 09, 2025 am 12:07 AM

JavaScript是现代Web开发的基石,它的主要功能包括事件驱动编程、动态内容生成和异步编程。1)事件驱动编程允许网页根据用户操作动态变化。2)动态内容生成使得页面内容可以根据条件调整。3)异步编程确保用户界面不被阻塞。JavaScript广泛应用于网页交互、单页面应用和服务器端开发,极大地提升了用户体验和跨平台开发的灵活性。

谁得到更多的Python或JavaScript?

Apr 04, 2025 am 12:09 AM

谁得到更多的Python或JavaScript?

Apr 04, 2025 am 12:09 AM

Python和JavaScript开发者的薪资没有绝对的高低,具体取决于技能和行业需求。1.Python在数据科学和机器学习领域可能薪资更高。2.JavaScript在前端和全栈开发中需求大,薪资也可观。3.影响因素包括经验、地理位置、公司规模和特定技能。

JavaScript难以学习吗?

Apr 03, 2025 am 12:20 AM

JavaScript难以学习吗?

Apr 03, 2025 am 12:20 AM

学习JavaScript不难,但有挑战。1)理解基础概念如变量、数据类型、函数等。2)掌握异步编程,通过事件循环实现。3)使用DOM操作和Promise处理异步请求。4)避免常见错误,使用调试技巧。5)优化性能,遵循最佳实践。

JavaScript的演变:当前的趋势和未来前景

Apr 10, 2025 am 09:33 AM

JavaScript的演变:当前的趋势和未来前景

Apr 10, 2025 am 09:33 AM

JavaScript的最新趋势包括TypeScript的崛起、现代框架和库的流行以及WebAssembly的应用。未来前景涵盖更强大的类型系统、服务器端JavaScript的发展、人工智能和机器学习的扩展以及物联网和边缘计算的潜力。

如何使用JavaScript将具有相同ID的数组元素合并到一个对象中?

Apr 04, 2025 pm 05:09 PM

如何使用JavaScript将具有相同ID的数组元素合并到一个对象中?

Apr 04, 2025 pm 05:09 PM

如何在JavaScript中将具有相同ID的数组元素合并到一个对象中?在处理数据时,我们常常会遇到需要将具有相同ID�...

如何实现视差滚动和元素动画效果,像资生堂官网那样?

或者:

怎样才能像资生堂官网一样,实现页面滚动伴随的动画效果?

Apr 04, 2025 pm 05:36 PM

如何实现视差滚动和元素动画效果,像资生堂官网那样?

或者:

怎样才能像资生堂官网一样,实现页面滚动伴随的动画效果?

Apr 04, 2025 pm 05:36 PM

实现视差滚动和元素动画效果的探讨本文将探讨如何实现类似资生堂官网(https://www.shiseido.co.jp/sb/wonderland/)中�...

console.log输出结果差异:两次调用为何不同?

Apr 04, 2025 pm 05:12 PM

console.log输出结果差异:两次调用为何不同?

Apr 04, 2025 pm 05:12 PM

深入探讨console.log输出差异的根源本文将分析一段代码中console.log函数输出结果的差异,并解释其背后的原因。�...