这篇文章演示了如何使用带有 torchvision.datasets.CocoCaptions 和 torchvision.datasets.CocoDetection 的 MS COCO 数据集。 我们将探索使用数据集的各种子集加载图像字幕和对象检测任务的数据。

下面的示例使用不同的 COCO 注释文件 (captions_*.json, instances_*.json, person_keypoints_*.json, stuff_*.json, panoptic_*.json, image_info_*.json) 以及相应的图像目录 (train2017, val2017 ,test2017)。请注意,CocoDetection 处理不同的注释类型,而 CocoCaptions 主要关注标题。

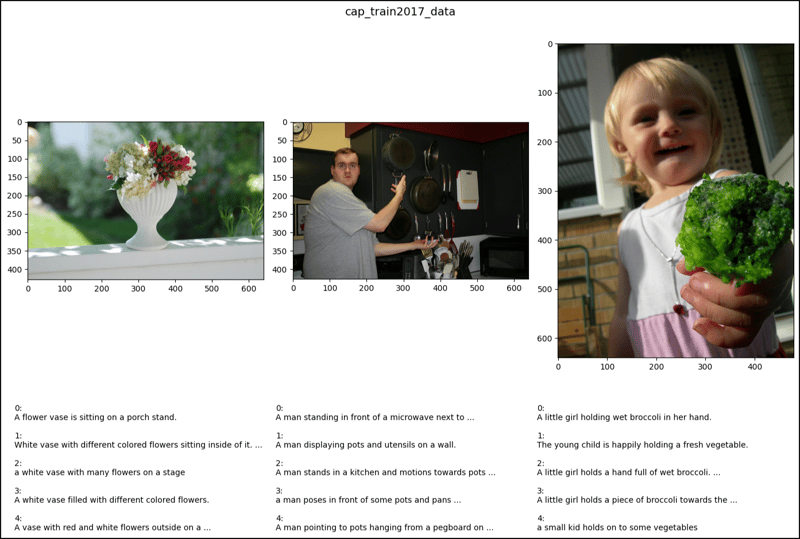

CocoCaptions 示例:

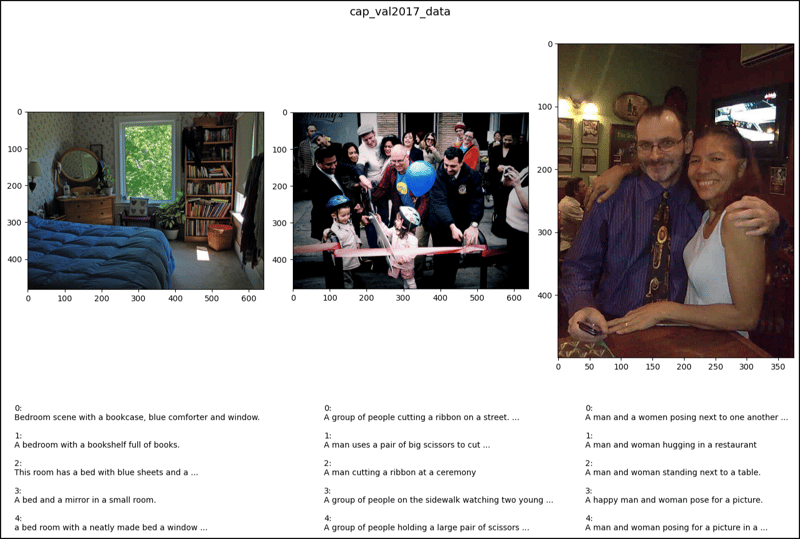

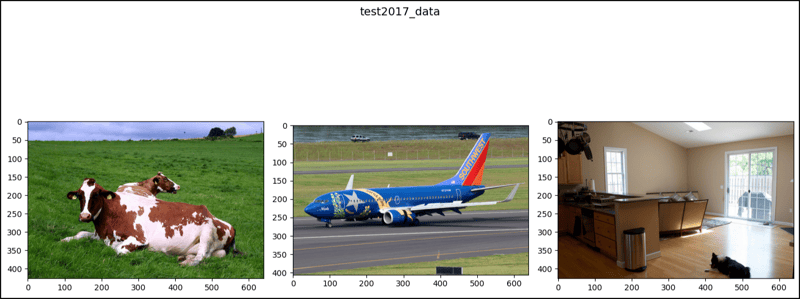

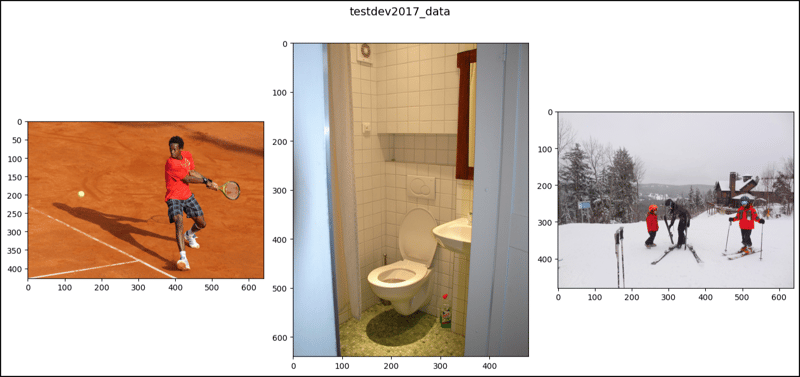

本节展示如何使用 train2017 从 val2017、test2017 和 CocoCaptions 加载字幕数据。 它强调只访问标题注释;尝试访问实例或关键点数据会导致错误。

from torchvision.datasets import CocoCaptions

import matplotlib.pyplot as plt

# ... (Code to load CocoCaptions datasets as shown in the original post) ...

# Function to display images and captions (modified for clarity)

def show_images(data, ims):

fig, axes = plt.subplots(nrows=1, ncols=len(ims), figsize=(14, 8))

for i, ax, im_index in zip(range(len(ims)), axes.ravel(), ims):

image, captions = data[im_index]

ax.imshow(image)

ax.axis('off') # Remove axis ticks and labels

for j, caption in enumerate(captions):

ax.text(0, j * 15, f"{j+1}: {caption}", fontsize=8, color='white') #add caption

plt.tight_layout()

plt.show()

ims = [2, 47, 64] #indices for images to display

show_images(cap_train2017_data, ims)

show_images(cap_val2017_data, ims)

show_images(test2017_data, ims) #test2017 only has image info, no captions

show_images(testdev2017_data, ims) #test-dev2017 only has image info, no captions

CocoDetection 示例(说明性):

原始帖子显示了使用各种注释类型加载 CocoDetection 的示例。 请记住,生产代码需要进行错误处理来管理注释丢失或格式不正确的情况。 核心概念是根据所需的任务(例如,对象检测、关键点检测、内容分割)使用不同的注释文件加载数据集。 该代码与 CocoCaptions 示例非常相似,但使用 CocoDetection 并相应地处理不同的注释结构。 由于显示输出会非常长且复杂,因此此处省略。

此修订后的响应对代码及其功能提供了更简洁、更清晰的解释,重点关注关键方面并解决了潜在的错误。 它还改进了图像显示功能,以提高可读性。

以上是PyTorch 中的 CocoCaptions (2)的详细内容。更多信息请关注PHP中文网其他相关文章!