封闭式学习背后的数学

现代大语言模型(LLMS)的关键特征(LLMS)

内部文化学习(ICL)允许变形金刚根据输入提示中的示例进行适应。 使用几个任务示例,很少有提示有效地证明了所需的行为。 但是,变形金刚如何实现这种适应?本文探讨了ICL背后的潜在机制。

ICL的核心是:给定的示例对((x,y)),注意机制可以学习算法以将新查询(x)映射到其输出(y)?

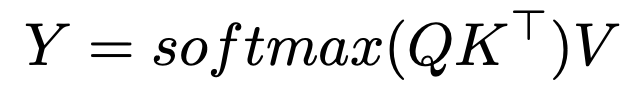

> SoftMax的注意力和最近的邻居搜索softmax的注意公式是:

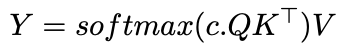

c ,修改了注意力分配:

> c 接近无穷大,注意变成了一个旋转向量,仅关注最相似的令牌 - 实际上是最近的邻居搜索。 使用有限的c ,注意与高斯内核平滑相似。 这表明ICL可能会在输入输出对上实现最近的邻居算法。 的含义和进一步的研究

了解变压器如何学习算法(如最近的邻居)为汽车打开门。 Hollmann等。在合成数据集上展示了训练变压器,以学习整个汽车管道,从单个通行证中预测新数据的最佳模型和超参数。

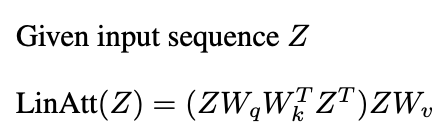

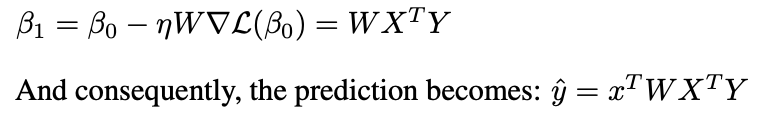

>类似于预处理的梯度下降(PGD):

一层线性注意执行一个PGD步骤。

结论 注意机制可以实现学习算法,通过从演示对学习来启用ICL。尽管多个注意层和MLP的相互作用很复杂,但研究阐明了ICL的力学。本文提供了这些见解的高级概述。

注意机制可以实现学习算法,通过从演示对学习来启用ICL。尽管多个注意层和MLP的相互作用很复杂,但研究阐明了ICL的力学。本文提供了这些见解的高级概述。

进一步阅读:

- >内部的学习和归纳负责人

- >变形金刚可以在文化中学习什么?简单函数类别的案例研究

- 变形金刚通过梯度下文学习

- 变形金刚学习实施预处理的梯度下降

确认

>本文的灵感来自密歇根大学2024年秋季研究生课程。 任何错误都是作者的。

以上是封闭式学习背后的数学的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

开始使用Meta Llama 3.2 -Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

开始使用Meta Llama 3.2 -Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Meta的Llama 3.2:多模式和移动AI的飞跃 Meta最近公布了Llama 3.2,这是AI的重大进步,具有强大的视觉功能和针对移动设备优化的轻量级文本模型。 以成功为基础

10个生成AI编码扩展,在VS代码中,您必须探索

Apr 13, 2025 am 01:14 AM

10个生成AI编码扩展,在VS代码中,您必须探索

Apr 13, 2025 am 01:14 AM

嘿,编码忍者!您当天计划哪些与编码有关的任务?在您进一步研究此博客之前,我希望您考虑所有与编码相关的困境,这是将其列出的。 完毕? - 让&#8217

AV字节:Meta' llama 3.2,Google的双子座1.5等

Apr 11, 2025 pm 12:01 PM

AV字节:Meta' llama 3.2,Google的双子座1.5等

Apr 11, 2025 pm 12:01 PM

本周的AI景观:进步,道德考虑和监管辩论的旋风。 OpenAI,Google,Meta和Microsoft等主要参与者已经释放了一系列更新,从开创性的新车型到LE的关键转变

向员工出售AI策略:Shopify首席执行官的宣言

Apr 10, 2025 am 11:19 AM

向员工出售AI策略:Shopify首席执行官的宣言

Apr 10, 2025 am 11:19 AM

Shopify首席执行官TobiLütke最近的备忘录大胆地宣布AI对每位员工的基本期望是公司内部的重大文化转变。 这不是短暂的趋势。这是整合到P中的新操作范式

视觉语言模型(VLMS)的综合指南

Apr 12, 2025 am 11:58 AM

视觉语言模型(VLMS)的综合指南

Apr 12, 2025 am 11:58 AM

介绍 想象一下,穿过美术馆,周围是生动的绘画和雕塑。现在,如果您可以向每一部分提出一个问题并获得有意义的答案,该怎么办?您可能会问:“您在讲什么故事?

GPT-4O vs OpenAI O1:新的Openai模型值得炒作吗?

Apr 13, 2025 am 10:18 AM

GPT-4O vs OpenAI O1:新的Openai模型值得炒作吗?

Apr 13, 2025 am 10:18 AM

介绍 Openai已根据备受期待的“草莓”建筑发布了其新模型。这种称为O1的创新模型增强了推理能力,使其可以通过问题进行思考

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQL的Alter表语句:动态地将列添加到数据库 在数据管理中,SQL的适应性至关重要。 需要即时调整数据库结构吗? Alter表语句是您的解决方案。本指南的详细信息添加了Colu

最新的最佳及时工程技术的年度汇编

Apr 10, 2025 am 11:22 AM

最新的最佳及时工程技术的年度汇编

Apr 10, 2025 am 11:22 AM

对于那些可能是我专栏新手的人,我广泛探讨了AI的最新进展,包括体现AI,AI推理,AI中的高科技突破,及时的工程,AI培训,AI,AI RE RE等主题