LLAMA 3.2 90B教程:带有shatlit&groq的图像字幕应用程序

META最终通过引入Llama 3.2 11B和90B视觉模型来为Llama生态系统增加了多模式。这两种模型在处理文本和图像方面都表现出色,这使我尝试使用90B版本构建一个项目。

在本文中,我将分享我的作品,并指导您使用简化的前端和Llama 3.2 90B作为生成字幕的引擎。为什么使用Llama 3.2 90B进行图像字幕应用

>它具有解决视觉推理,图像识别和图像字幕等复杂任务的能力。它已经在大量的60亿个图像文本对的大量数据集上进行了培训。

llama 3.2-Vision是我们应用程序的绝佳选择,因为它支持文本任务的多种语言,尽管英语是与图像相关的应用程序的主要重点。它的关键功能使其成为视觉问题回答(VQA),文档VQA和Image-Text检索等任务的绝佳选择,图像字幕是其出色的应用程序之一。>让我们探索这些功能如何转化为像图像字幕之类的真实应用程序。

>图像字幕管道

图像字幕是生成汇总图像内容的描述性文本的自动过程。它结合了计算机视觉和自然语言处理,以在语言中解释和表达视觉细节。传统上,图像字幕需要一条复杂的管道,通常涉及图像处理和语言的单独阶段。标准方法涉及三个主要步骤:图像预处理,特征提取和字幕生成。

图像预处理:图像通常进行调整,标准化和偶尔裁剪,以确保它们符合模型的输入规格。特征提取:提取视觉特征以识别图像中的对象,场景或相关细节。在大多数模型中,这需要一个单独的视觉模型来解释图像,生成语言模型可以理解的结构化数据。

字幕生成:然后,语言模型使用这些提取的特征来制作连贯的描述,结合了视觉数据中确定的对象,上下文和关系。

>使用Llama 3.2 90b,这个传统上复杂的过程变得更加简单。该模型的视觉适配器将视觉特征集成到核心语言模型中,使其能够直接解释图像并通过简单的提示生成字幕。通过将跨注意层嵌入其体系结构中,Llama 3.2 90B允许用户通过仅提示模型来描述图像,即确定需要单独的处理阶段。这种简单性使更易于访问和高效的图像字幕可以产生自然的描述性标题,从而有效地捕获图像的本质。

图像字幕应用程序的概述

>将Llama 3.2 90B的力量栩栩如生,我们将使用简化的前端构建一个简单而有效的图像字幕应用程序,并构建用于生成字幕的GROQ。

>该应用程序将允许用户上传图像并接收模型生成的描述标题,仅需单击两次。此设置非常适合用户友好,需要最少的编码知识才能开始。我们的应用程序将包含以下功能:

标题:一个突出显示的标题,Llama字幕,以建立应用程序的目的。

>上传按钮:一个从用户设备上传图像的接口。

- 生成按钮:一个按钮启动字幕生成过程。

- > >字幕输出:该应用将直接在接口上显示生成的字幕。

- 我们的Llama 3.2 90B应用程序的代码实现

- groq API将充当用户上传图像和Llama 3.2视频模型之间的桥梁。如果您想跟随我并与我进行编码,请确保您首先:

- >

>将您的API密钥保存在A

> recreterentials.json

文件中以简化访问。- 遵循Groq的“安装和配置”的Quickstart指南。

- >下面的此Python代码片段设置了一个简化的应用程序,可以与GROQ API进行交互。它包括: >用于Web App开发(流线),AI Interactions(GROQ),Image处理(BASE64)和文件操作(OS,JSON)的库库。

- >从单独的JSON文件中读取GROQ API键,以获得增强的安全性。

> 定义一个函数,将图像编码为base64格式以进行有效的传输和处理。

- >我们通过编写下面的功能继续前进,该功能旨在使用GROQ API生成上传图像的文本描述。这是其功能的故障:

-

- >图像编码:上传的图像被转换为基本64编码的字符串。这种格式允许在API请求中轻松传输映像数据。 >

- groq API交互:groq客户端的实例化以促进与GROQ服务的通信。制定了聊天完成请求,包括:

- 一个用户提示:“此图像中有什么?” >

- base64编码的图像数据,嵌入了数据URI中。指定了Llama-3.2-90B-Vision-Preiview模型来处理图像并生成文本描述。

- >字幕提取:从GROQ API响应中提取生成的字幕。返回了首选的消息内容,其中包含标题。 >

import streamlit as st from groq import Groq import base64 import os import json # Set up Groq API Key os.environ['GROQ_API_KEY'] = json.load(open('credentials.json', 'r'))['groq_token'] # Function to encode the image def encode_image(image_path): with open(image_path, "rb") as image_file: return base64.b64encode(image_file.read()).decode('utf-8')登录后复制>最后,我们通过简化生成我们的Interactive Web应用程序

最终的简化应用程序:Llama字幕# Function to generate caption def generate_caption(uploaded_image): base64_image = base64.b64encode(uploaded_image.read()).decode('utf-8') client = Groq() chat_completion = client.chat.completions.create( messages=[ { "role": "user", "content": [ {"type": "text", "text": "What's in this image?"}, { "type": "image_url", "image_url": { "url": f"data:image/jpeg;base64,{base64_image}", }, }, ], } ], model="llama-3.2-90b-vision-preview", ) return chat_completion.choices[0].message.content登录后复制

此简化应用程序提供了一个用于图像字幕的用户友好界面。这是其功能的故障:- >标题和文件上传器:

- 该应用显示一个标题:“ Llama Captioner”。

- > 文件上传器组件允许用户选择图像文件(JPG,JPEG或PNG)。

> - 字幕生成:

- 一个按钮,“生成字幕”,触发字幕生成过程。

> - generate_caption函数被调用以处理上传的图像并获得标题。

- 成功的生成后,显示了一条成功消息,其后是生成的字幕。

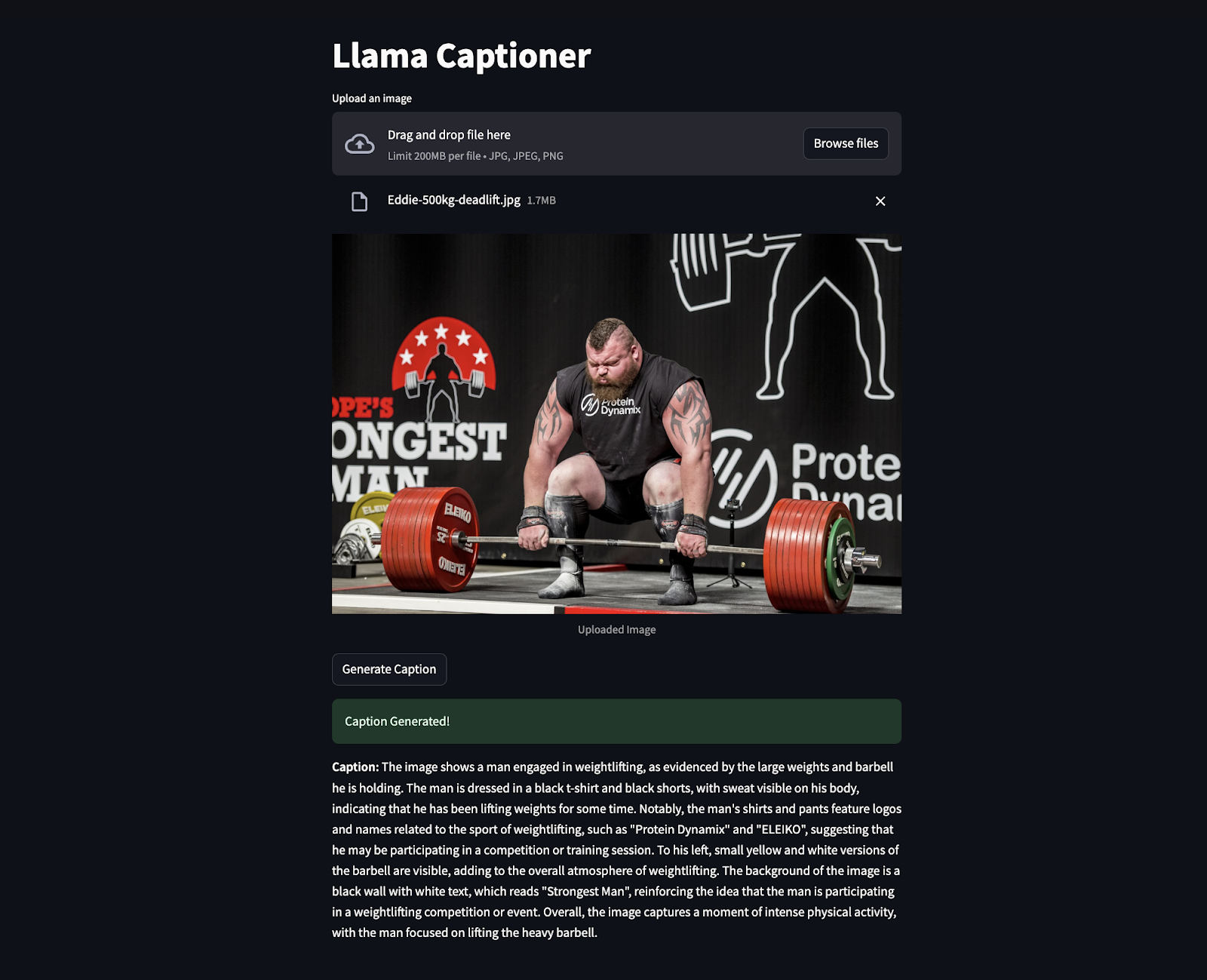

- >以下片段是在行动中的代码,其中埃迪·霍尔(Eddie Hall)的图像上传以生成标题。令人惊讶的是,它甚至提取了像“最坚强的人”等清晰可见的信息等。

- >

使用Llama 3.2 90B构建图像字幕应用程序,并简化了高级AI如何使艰巨的任务更容易。该项目将强大的模型与一个简单的接口相结合,以创建一个既直观又易于使用的工具。>

要继续学习骆驼,我建议以下资源: 作为AI工程师,我看到了此类工具的巨大潜力。它们可以使技术更容易访问,帮助人们更好地参与内容,并以更明智的方式自动化流程。

作为AI工程师,我看到了此类工具的巨大潜力。它们可以使技术更容易访问,帮助人们更好地参与内容,并以更明智的方式自动化流程。

> - >如何在使用Torchchat的Android手机上运行Llama 3.2 1B llama 3.2和Gradio教程:构建一个多模式Web应用

- llama stack:带有实际示例的指南

- >微调美洲拉玛3.2并在本地使用:逐步指南

- llama 3.3:演示项目的分步教程

>

以上是LLAMA 3.2 90B教程:带有shatlit&groq的图像字幕应用程序的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

开始使用Meta Llama 3.2 -Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

开始使用Meta Llama 3.2 -Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Meta的Llama 3.2:多模式和移动AI的飞跃 Meta最近公布了Llama 3.2,这是AI的重大进步,具有强大的视觉功能和针对移动设备优化的轻量级文本模型。 以成功为基础

10个生成AI编码扩展,在VS代码中,您必须探索

Apr 13, 2025 am 01:14 AM

10个生成AI编码扩展,在VS代码中,您必须探索

Apr 13, 2025 am 01:14 AM

嘿,编码忍者!您当天计划哪些与编码有关的任务?在您进一步研究此博客之前,我希望您考虑所有与编码相关的困境,这是将其列出的。 完毕? - 让&#8217

AV字节:Meta' llama 3.2,Google的双子座1.5等

Apr 11, 2025 pm 12:01 PM

AV字节:Meta' llama 3.2,Google的双子座1.5等

Apr 11, 2025 pm 12:01 PM

本周的AI景观:进步,道德考虑和监管辩论的旋风。 OpenAI,Google,Meta和Microsoft等主要参与者已经释放了一系列更新,从开创性的新车型到LE的关键转变

向员工出售AI策略:Shopify首席执行官的宣言

Apr 10, 2025 am 11:19 AM

向员工出售AI策略:Shopify首席执行官的宣言

Apr 10, 2025 am 11:19 AM

Shopify首席执行官TobiLütke最近的备忘录大胆地宣布AI对每位员工的基本期望是公司内部的重大文化转变。 这不是短暂的趋势。这是整合到P中的新操作范式

GPT-4O vs OpenAI O1:新的Openai模型值得炒作吗?

Apr 13, 2025 am 10:18 AM

GPT-4O vs OpenAI O1:新的Openai模型值得炒作吗?

Apr 13, 2025 am 10:18 AM

介绍 Openai已根据备受期待的“草莓”建筑发布了其新模型。这种称为O1的创新模型增强了推理能力,使其可以通过问题进行思考

视觉语言模型(VLMS)的综合指南

Apr 12, 2025 am 11:58 AM

视觉语言模型(VLMS)的综合指南

Apr 12, 2025 am 11:58 AM

介绍 想象一下,穿过美术馆,周围是生动的绘画和雕塑。现在,如果您可以向每一部分提出一个问题并获得有意义的答案,该怎么办?您可能会问:“您在讲什么故事?

最新的最佳及时工程技术的年度汇编

Apr 10, 2025 am 11:22 AM

最新的最佳及时工程技术的年度汇编

Apr 10, 2025 am 11:22 AM

对于那些可能是我专栏新手的人,我广泛探讨了AI的最新进展,包括体现AI,AI推理,AI中的高科技突破,及时的工程,AI培训,AI,AI RE RE等主题

3种运行Llama 3.2的方法-Analytics Vidhya

Apr 11, 2025 am 11:56 AM

3种运行Llama 3.2的方法-Analytics Vidhya

Apr 11, 2025 am 11:56 AM

Meta's Llama 3.2:多式联运AI强力 Meta的最新多模式模型Llama 3.2代表了AI的重大进步,具有增强的语言理解力,提高的准确性和出色的文本生成能力。 它的能力t

作为AI工程师,我看到了此类工具的巨大潜力。它们可以使技术更容易访问,帮助人们更好地参与内容,并以更明智的方式自动化流程。

作为AI工程师,我看到了此类工具的巨大潜力。它们可以使技术更容易访问,帮助人们更好地参与内容,并以更明智的方式自动化流程。