Kimi K1.5与OpenAi O1:哪个更好的推理模型?

OpenAI是第一个引入O1和O1-Mini等推理模型的人,但这是游戏中唯一的玩家吗?不远射! DeepSeek,Qwen和现在的Kimi等中国LLM正在加紧挑战OpenAI,以更实惠的价格提供类似的能力。在DeepSeek令人印象深刻的首次亮相之后,Kimi Ai的新型Kimi K1.5型号轮到了。在本文中,我们将在同一任务上测试Kimi K1.5针对Openai O1,并查看哪个更好!

>

>目录的表- >什么是kimi k1.5? Web搜索

- 任务5:图像分析

- 最终结果:kimi k1.5 vs openai o1

- 结论

- 请注意: 请注意:Kimi K1.5是免费的,同时访问O1和O1-Mini的Chatgpt Plus的费用为20美元。在研究任务之前,让我们比较两种型号。

- > 什么是kimi k1.5?

- Kimi K1.5是Moonshot AI的多模式LLM,接受了增强学习(RL)的训练,旨在在文本,视觉和编码的各种推理任务中表现出色。 Kimi K1.5最近推出,由于其令人印象深刻的性能而迅速引起了人们的关注,与OpenAI的O1型号的功能相匹配而没有预览或迷你后缀。 >

- 键功能

- >无限用法完全免费

>可轻松分析多达50个文件(PDF,DOC,PPTS,图像) 高级COT推理,无需提供

增强的图像理解,超越基本文本提取

也阅读:

- openai o1:OpenAI的新型号系列

- o1-mini:一种改变游戏的词干和推理模型

- >

- kimi k1.5 vs Openai O1和O1-Mini

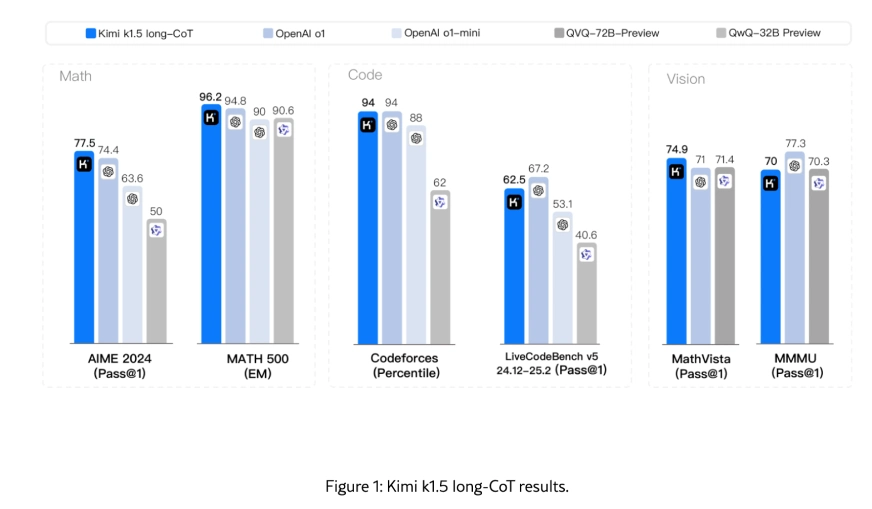

- Kimi K1.5在长期任务中匹配OpenAI的O1和O1-Mini,并且在短件任务中优于GPT-4O和Claude Sonnet 3.5。它的多模式功能,尤其是在视觉推理中,它将其作为OpenAI模型的强大竞争对手。 RL培训技术,多模式数据配方和基础设施优化的使用在实现这些结果方面一直是关键的。

k1.5长期模型:推进多模式推理

>kimi k1.5长距离模型通过长篇小说缩放,改进的策略优化方法和视觉文本增强学习(RL)的结合来实现最新的(SOTA)性能。与传统的语言模型预处理不同,该模型依赖于下一步的预测,并且受到可用培训数据的限制,Kimi K1.5利用RL通过学习奖励来探索探索的培训数据来扩展其培训数据。这种方法建立了一个简单而有效的RL框架,避免了诸如蒙特卡洛树搜索或价值功能之类的复杂技术。  键基准强调了该模型的出色性能:

键基准强调了该模型的出色性能:- >数学推理

- :Math-500上的96.2和Aime 2024上的77.5分数,与OpenAI的O1和O1-Mini型号匹配。 编程

- :代码方面的第94个百分位数,在竞争性编程方面表现出色。 视觉推理

- :74.9在Mathvista上,展示了强大的多模式集成。 >该模型处理长篇小说任务(例如计划,反思和校正)的能力通过培训期间的部分推出,提高效率和性能。

使用有效的long2short方法将长密码模型的成功构建在长密度模型的成功基础上,以将长密度技术提炼成更有效的框架。这种方法结合了微调,增强学习和远程蒸馏,为短篇小说任务提供了快速而准确的推理。值得注意的成就包括:

数学推理

- :在数学500上的94.6和Aime 2024上的60.8得分,表现优于现有的短型型号,例如GPT-4O和Claude Sonnet 3.5,最高可达550%。

- 编程:47.3在LiveCodeBench上,在代码生成和调试任务方面出色。

- 自然语言理解:对诸如聊天机器人和虚拟助手等实时应用程序有效。 >

- >远程蒸馏技术,包括模型合并和最短拒绝采样,确保通过降低的计算成本来确保高性能,从而使短点模型高效。 要知道更多您可以在这里结帐他们的研究论文! >

任务1:斑马拼图

提示:>正确求解了这个斑马拼图。openai O1响应:

收集器详细信息 Collector Position Nationality Lot Amount Spent Shirt Color Collector #1 Portuguese Toy Unknown Blue Collector #2 Japanese Lot 40 0,000 Purple Collector #3 Italian Lot 30 0,000 Pink Collector #4 Canadian Unknown 0,000 Yellow Collector #5 Unknown Unknown 0,000 Unknown

kimi k1.5响应:

收集器详细信息 Collector # Nationality Lot Item Amount Shirt Color 1 Italian 30 Clock 0,000 Blue 2 Japanese 40 Painting 0,000 Purple 3 Canadian 10 Vase 0,000 Pink 4 Portuguese 34 Toy 0,000 Yellow 5 (Unknown)

观察:

Openai O1提供的响应明显不准确。结果表不符合问题中指定的所需格式,从而使回答不可靠。另一方面,Kimi K1.5根据问题提供了正确格式的响应,但答案本身的内容不正确。

>>判决:

>openai o1:❌| Kimi K1.5:❌

>任务2:逻辑推理

> 提示:

>您走进房间看床。在床上有两只狗,四只猫,一只长颈鹿,五头牛和一只鸭子。还有三把椅子和一张桌子。地板上有几条腿? openai O1响应: kimi k1.5响应:

观察:

正确答案:

> 22(2(人)4(表)4(bed)4(bed)12(3张椅子))

openai O1花费了太长时间来产生响应。虽然计算正确并包括一个详细的解释,但它未能说明地板上的人腿,这使得其答案不正确。相比之下,Kimi K1.5在更少的时间内提供了正确的答案。>

>判决:>openai o1:❌| Kimi K1.5:✅ >任务3:创建一个HTML站点

>

提示:>创建一个简单的html页面,其中使用一个按钮将背景颜色更改为粉红色时,用一些五彩纸屑将其更改为粉红色。 openai O1响应:

kimi k1.5响应:

观察:

> >判决:>openai o1:❌| Kimi K1.5:✅ >任务4:Web搜索

提示:>阅读文章 - https://www.analyticsvidhya.com/blog/2024/07/building-agentic-agentic-rag-systems-with-langgraph/,以了解构建wikipedia数据的矢量数据库的过程。以简洁的方式汇总关键步骤。openai O1响应: >构建wikipedia数据的矢量数据库的过程:

- >收集数据:从转储或API中获取Wikipedia文章。 >

- >>预处理文本:清洁文本并将其分成较小的连贯的“块”。

- 选择一个嵌入模型:使用语言模型(例如OpenAI嵌入)将文本块转换为数值向量。 生成嵌入

- :对于每个块,产生其语义向量表示。 设置矢量数据库 :选择一个矢量存储(例如Pinecone,Weaviate,Faiss,Chroma)以存储和索引嵌入。

- > >插入向量 :将所有块向量和关联的元数据(例如,原始文章参考)加载到数据库中。

- 测试检索:与矢量化问题查询数据库,以确保返回相关的wikipedia块。 >

- 优化并集成:将索引和集成与检索效果生成(RAG)管道进行有效,准确的信息检索。

- kimi k1.5响应: >“具有Langgraph的构建代理抹布系统的综合指南”文章概述了为Wikipedia数据构建向量数据库的过程,这是创建代理抹布系统的一部分。这是总结的关键步骤:

- 安装依赖项:安装必要的库,例如Langchain,Langchain-Openai,Langchain-Community,Langgraph和Langchain-Chroma。 >

- 输入API键:使用GetPass函数安全地输入OpenAI和Tavily搜索的API键,以避免在代码中公开它们。 设置环境变量

- :设置OpenAI和Tavily搜索API键的环境变量。 > >加载wikipedia data

- :

>从提供的Google Drive链接下载Wikipedia数据或使用本地存档文件。

> - >提取并将数据加载到文档列表中。

:

-

使用文本分离器将文档分为较小,可管理的块。

>本文使用递归的术语textsplitter将文档分为大约2000个字符的块,重叠为300个字符。

- >

- 创建矢量数据库

- >初始化一个色度矢量数据库客户端。

>使用OpenAI的嵌入模型(Text-Embedding-3-Small)将文档块转换为嵌入。

- >

- >将文档块及其嵌入在矢量数据库索引中,将余弦相似性指定为距离函数。

- 设置向量数据库回收

- >配置猎犬以基于余弦相似性获取前3个最相似的文档。

设置一个相似性阈值(例如,0.3),以过滤与查询不够相似的文档。

- >

- 测试猎犬

- >用示例查询测试猎犬,以确保其返回相关文档。>

对于vector数据库中没有相关文档的查询,检索器应返回一个空列表。

- 观察:

- 为了估算太空中数据中心所需的散热器表面积的下限,我首先应用Stefan-Boltzmann定律,该法描述了表面辐射的功率:

> >判决:

>

openai o1:❌| Kimi K1.5:✅任务5:图像分析

提示:

>图像显示了空间中数据中心的高度简化示意图,其中一些简化的假设需要合理。

>任务:>估计数据中心所需的散热器表面积的下限。

2。仅辐射传热:

地址。

地址如何在热管理的背景下处理太阳和深空。 >输入图像:

openai O1响应:

下面的是一个逐步推理过程,具有明确规定的简化假设,理由和热力学第一定律的应用。最终结果将是在散热器区域的下限,以消散由空间数据中心产生的1 gW的热量。

关键假设和简化1。功率输入和热量产生:

假设数据中心由1 GW太阳能电源提供动力。 GPU消耗的几乎所有电力都将转换为热量(在稳态下电能转换本质上是100%,因为所有未存储的电能最终都必须随热量消散)。因此,要去除的废热约为1 gW = 1×10^9 W.> 在太空中,没有对环境的对流或导电冷却,只有辐射传热。因此,热排斥的主要模式是从散热器表面进入深空的热辐射。

3。发射率和吸收性:

假设散热器是用高发射率构造的,例如ε= 0.9

ε = 0.9。这对于涂有某些高发射率的油漆或材料的表面是合理的。对于所需区域的下限,我们假设理想的条件:散热器主要远离太阳,以最大程度地减少太阳能吸收。

- kimi k1.5响应:

为了处理热管理中的太阳和深空,应使用阳光遮挡数据中心,或放在不暴露于阳光下的位置,例如行星或月球的阴暗面。必须设计散热器以有效地辐射热量进入空间的真空,这是非常冷的。 通过确保数据中心设备产生的热量等于散热器辐射的热量,热力学的第一定律适用于这种情况。该法律确保系统中的总能量保持恒定,并在散热器的设计中充分考虑了热量。>所需散热器表面积的下限大约为

766平方米。数据中心应避免阳光直射,并应优化散热器,以在空间真空中进行散热以维持热平衡。

观察:

Kimi K1.5的响应是出色的,原因有几个。从基本的Stefan-Boltzmann法律方程开始,它通过分步方法来证明明确的数学推理。 Kimi清楚地定义了所有变量及其值,显示了解决散热器区域的数学过程,并提供了766平方米的具体数值结果。该解释包括有关热管理策略的明确理由,例如将散热器定位在地球的阴暗面,以及与现实世界应用的第一定律的直接联系。响应以特定数字和可行的建议结束。

> 相比之下,Openai O1的响应仍然更加理论上,重点是一般假设和设置,而不是完成实际计算。它缺乏具体的数值解决方案,并且没有完全解决热管理方面,与Kimi K1.5的详细和以解决方案为导向的方法相比,它的实用性和行动性不佳。>判决:

openai o1:❌| Kimi K1.5:✅

最终结果:kimi k1.5 vs Openai O1

>任务结果

也请阅读:Kimi K1.5 vs DeepSeek R1:最好的中国LLMS战役Task Winner Zebra Puzzle Neither Logical Reasoning Kimi k1.5 Create an HTML Site Kimi k1.5 Web Search Kimi k1.5 Image Analysis Kimi k1.5 结论

诸如Kimi K1.5和DeepSeek R1之类的免费模型正在挑战Openai O1的主导地位,无需免费提供推理,编码和多模式任务的卓越性能。随着Kimi K1.5在关键基准和DeepSeek R1方面的表现优于OpenAi,在编码挑战方面脱颖而出,为Openai O1支付20美元/月是否仍然是合理的?在下面的评论部分中让我们知道!

>敬请期待分析vidhya博客,以获取更多如此出色的内容!

以上是Kimi K1.5与OpenAi O1:哪个更好的推理模型?的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

我尝试了使用光标AI编码的Vibe编码,这太神奇了!

Mar 20, 2025 pm 03:34 PM

我尝试了使用光标AI编码的Vibe编码,这太神奇了!

Mar 20, 2025 pm 03:34 PM

Vibe编码通过让我们使用自然语言而不是无尽的代码行创建应用程序来重塑软件开发的世界。受Andrej Karpathy等有远见的人的启发,这种创新的方法使Dev

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月,Generative AI又是一个改变游戏规则的月份,为我们带来了一些最令人期待的模型升级和开创性的新功能。从Xai的Grok 3和Anthropic的Claude 3.7十四行诗到Openai的G

如何使用Yolo V12进行对象检测?

Mar 22, 2025 am 11:07 AM

如何使用Yolo V12进行对象检测?

Mar 22, 2025 am 11:07 AM

Yolo(您只看一次)一直是领先的实时对象检测框架,每次迭代都在以前的版本上改善。最新版本Yolo V12引入了进步,可显着提高准确性

最佳AI艺术生成器(免费付款)创意项目

Apr 02, 2025 pm 06:10 PM

最佳AI艺术生成器(免费付款)创意项目

Apr 02, 2025 pm 06:10 PM

本文回顾了AI最高的艺术生成器,讨论了他们的功能,对创意项目的适用性和价值。它重点介绍了Midjourney是专业人士的最佳价值,并建议使用Dall-E 2进行高质量的可定制艺术。

Chatgpt 4 o可用吗?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o可用吗?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4当前可用并广泛使用,与诸如ChatGpt 3.5(例如ChatGpt 3.5)相比,在理解上下文和产生连贯的响应方面取得了重大改进。未来的发展可能包括更多个性化的间

哪个AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

哪个AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

本文讨论了AI模型超过Chatgpt,例如Lamda,Llama和Grok,突出了它们在准确性,理解和行业影响方面的优势。(159个字符)

如何将Mistral OCR用于下一个抹布模型

Mar 21, 2025 am 11:11 AM

如何将Mistral OCR用于下一个抹布模型

Mar 21, 2025 am 11:11 AM

MISTRAL OCR:通过多模式文档理解彻底改变检索效果 检索增强的生成(RAG)系统具有明显高级的AI功能,从而可以访问大量的数据存储,以获得更明智的响应

顶级AI写作助理来增强您的内容创建

Apr 02, 2025 pm 06:11 PM

顶级AI写作助理来增强您的内容创建

Apr 02, 2025 pm 06:11 PM

文章讨论了Grammarly,Jasper,Copy.ai,Writesonic和Rytr等AI最高的写作助手,重点介绍了其独特的内容创建功能。它认为Jasper在SEO优化方面表现出色,而AI工具有助于保持音调的组成

键基准强调了该模型的出色性能:

键基准强调了该模型的出色性能: