利用拥抱面部文本生成推理的力量(TGI):您的本地LLM服务器

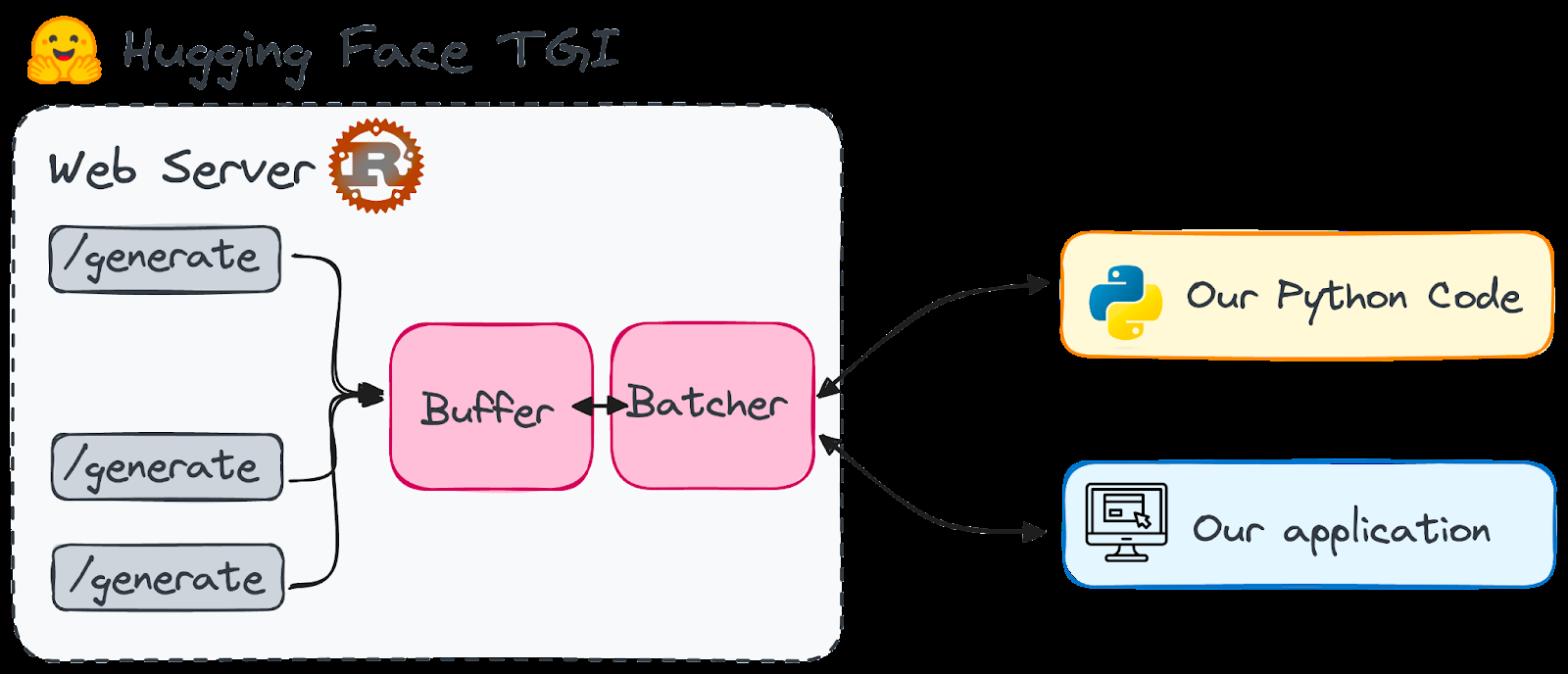

了解拥抱脸TGI

>

拥抱聊天

> openassistant

nat.dev

> 方法1:从头开始(更复杂)

>curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh conda create -n text-generation-inference python=3.9 && conda activate text-generation-inference

sudo)省略了说明,请参阅原始文本。git clone https://github.com/huggingface/text-generation-inference.git>

cd text-generation-inference/ && BUILD_EXTENSIONS=False make install

方法2:使用docker(推荐)>

volume=$PWD/data && sudo docker run --gpus all --shm-size 1g -p 8080:80 -v $volume:/data ghcr.io/huggingface/text-generation-inference:0.9 --model-id tiiuae/falcon-7b-instruct --num-shard 1 --quantize bitsandbytes"all"如果使用单个gpu。

"0"

python库(/generate)简化了交互。/stream>

text-generation实用的技巧和进一步的学习pip install text-generation

以上是拥抱脸部的文本生成推理工具包 - ai中的游戏改变者的详细内容。更多信息请关注PHP中文网其他相关文章!