经常性神经网络:LSTM与GRU - 实用指南

我生动地回想起课程期间遇到了经常性的神经网络(RNN)。虽然序列数据最初吸引了我,但无数的架构很快变得令人困惑。共同的顾问回应“取决于”,只会放大我的不确定性。广泛的实验和众多项目之后,我对何时使用LSTM与GRU的理解有了显着改善。本指南旨在阐明您的下一个项目的决策过程。我们将深入研究LSTM和GRU的细节,以帮助您做出明智的选择。

1997年推出的长期短期记忆(LSTM)网络解决了传统RNN固有的消失梯度问题。它们的核心是一个能够在长时间内保留信息的内存单元,由三个大门管理:

对信息流的这种颗粒状控制使LSTM可以捕获序列中的长距离依赖性。

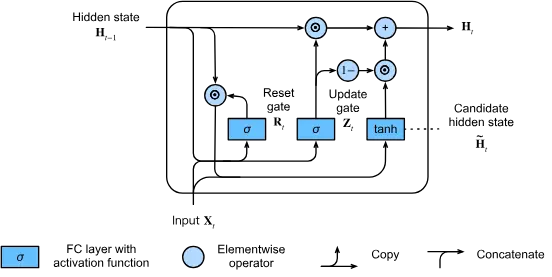

2014年提出的封闭式复发单元(GRU)简化了LSTM架构,同时保留了许多效果。格鲁斯仅利用两个大门:

这种简化的设计导致了提高的计算效率,同时仍可以有效缓解消失的梯度问题。

格鲁斯(Grus)出色:

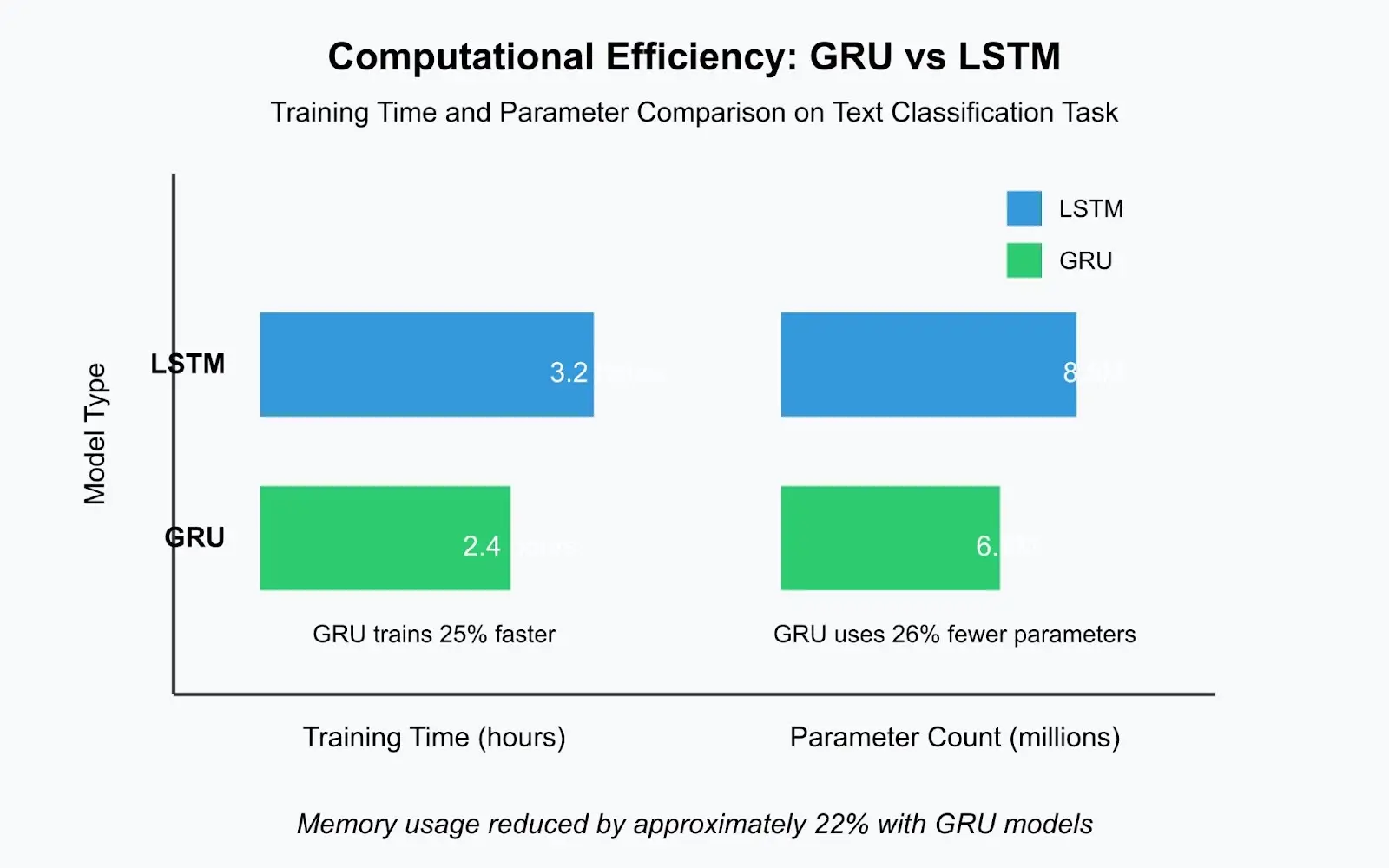

由于其简单的结构和较少的参数,GRU通常比可比LSTMS快20-30%。在最近的文本分类项目中,与LSTM的3.2小时相比,GRU模型在2.4小时内接受了培训,这在迭代开发过程中这是一个实质性的差异。

LSTMS优越:

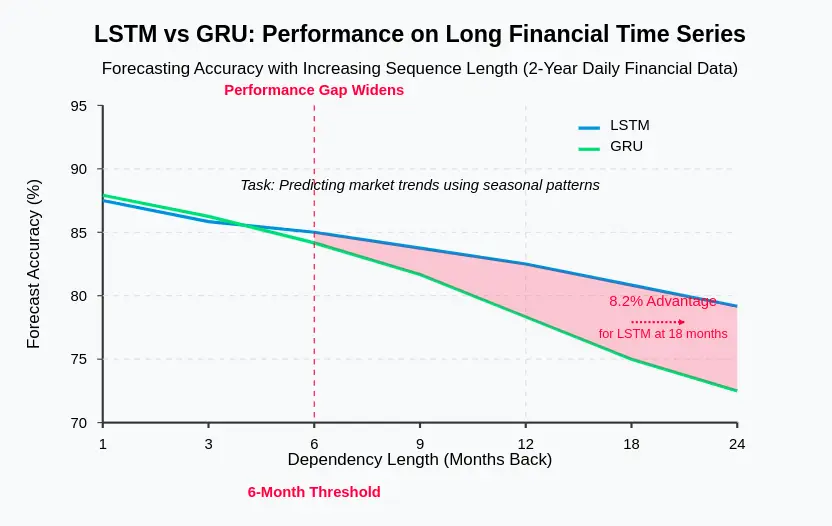

在财务时间序列中,使用多年的日常数据预测,LSTM始终优于GRU,预测依赖于季节性模式的趋势。 LSTMS中专用的记忆单元为长期信息保留提供了必要的能力。

格鲁斯经常证明:

Grus经常收敛的速度更快,有时比LSTMS少25%的时代达到令人满意的性能。这加速了实验并提高生产率。

Grus是有利的:

客户服务应用程序的生产LSTM语言模型需要42MB的存储空间,而GRU等效物仅需要31MB,减少26%的减少将部署到边缘设备。

对于大多数具有中等序列长度(20-100个令牌)的NLP任务,GRU通常在训练速度更快时的性能比LSTM相当或更好。但是,对于涉及非常长文档或复杂语言理解的任务,LSTM可能会提供优势。

对于具有多种季节性模式或非常长期依赖性的预测,LSTM通常表现出色。它们的明确记忆单元有效地捕获了复杂的时间模式。

在具有中等序列长度的语音识别中,GRU在计算效率方面通常比LSTM的表现均优于LSTM,同时保持了可比的精度。

在LSTM和GRU之间进行选择时,请考虑以下因素:

考虑混合方法:使用GRU进行编码和LSTMS进行解码,堆叠不同的层类型或集合方法。基于变压器的体系结构在许多NLP任务中已在很大程度上取代了LSTM和GRU,但是对于时间序列分析和注意力机制在计算上昂贵的情况,经常性模型仍然很有价值。

了解LSTM和GRU的优势和劣势是选择适当的体系结构的关键。通常,格鲁斯由于其简单性和效率而成为一个很好的起点。仅当有证据表明您的特定应用程序的性能提高时,才切换到LSTMS。请记住,与LSTMS和GRUS之间的选择相比,有效的功能工程,数据预处理和正则化通常对模型性能产生更大的影响。记录您的决策过程和实验结果以供将来参考。

以上是何时在LSTMS上使用GRU?的详细内容。更多信息请关注PHP中文网其他相关文章!