抓取一个网站上的全部链接

一 算法简介

程序在思路上采用了广度优先算法,对未遍历过的链接逐次发起GET请求,然后对返回来的页面用正则表达式进行解析,取出其中未被发现的新链接,加入集合中,待下一次循环时遍历。

具体实现上使用了Map

二 程序实现

上面相关思路已经说得很清楚了,并且代码中关键地方有注释,因此这里就不多说了,代码如下:

package action;

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.MalformedURLException;

import java.net.URL;

import java.util.LinkedHashMap;

import java.util.Map;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class WebCrawlerDemo {

public static void main(String[] args) {

WebCrawlerDemo webCrawlerDemo = new WebCrawlerDemo();

webCrawlerDemo.myPrint("http://www.zifangsky.cn");

}

public void myPrint(String baseUrl) {

Map oldMap = new LinkedHashMap(); // 存储链接-是否被遍历

// 键值对

String oldLinkHost = ""; //host

Pattern p = Pattern.compile("(https?://)?[^/\\s]*"); //比如:http://www.zifangsky.cn

Matcher m = p.matcher(baseUrl);

if (m.find()) {

oldLinkHost = m.group();

}

oldMap.put(baseUrl, false);

oldMap = crawlLinks(oldLinkHost, oldMap);

for (Map.Entry mapping : oldMap.entrySet()) {

System.out.println("链接:" + mapping.getKey());

}

}

/**

* 抓取一个网站所有可以抓取的网页链接,在思路上使用了广度优先算法

* 对未遍历过的新链接不断发起GET请求,一直到遍历完整个集合都没能发现新的链接

* 则表示不能发现新的链接了,任务结束

*

* @param oldLinkHost 域名,如:http://www.zifangsky.cn

* @param oldMap 待遍历的链接集合

*

* @return 返回所有抓取到的链接集合

* */

private Map crawlLinks(String oldLinkHost,

Map oldMap) {

Map newMap = new LinkedHashMap();

String oldLink = "";

for (Map.Entry mapping : oldMap.entrySet()) {

System.out.println("link:" + mapping.getKey() + "--------check:"

+ mapping.getValue());

// 如果没有被遍历过

if (!mapping.getValue()) {

oldLink = mapping.getKey();

// 发起GET请求

try {

URL url = new URL(oldLink);

HttpURLConnection connection = (HttpURLConnection) url

.openConnection();

connection.setRequestMethod("GET");

connection.setConnectTimeout(2000);

connection.setReadTimeout(2000);

if (connection.getResponseCode() == 200) {

InputStream inputStream = connection.getInputStream();

BufferedReader reader = new BufferedReader(

new InputStreamReader(inputStream, "UTF-8"));

String line = "";

Pattern pattern = Pattern

.compile("(.+)");

Matcher matcher = null;

while ((line = reader.readLine()) != null) {

matcher = pattern.matcher(line);

if (matcher.find()) {

String newLink = matcher.group(1).trim(); // 链接

// String title = matcher.group(3).trim(); //标题

// 判断获取到的链接是否以http开头

if (!newLink.startsWith("http")) {

if (newLink.startsWith("/"))

newLink = oldLinkHost + newLink;

else

newLink = oldLinkHost + "/" + newLink;

}

//去除链接末尾的 /

if(newLink.endsWith("/"))

newLink = newLink.substring(0, newLink.length() - 1);

//去重,并且丢弃其他网站的链接

if (!oldMap.containsKey(newLink)

&& !newMap.containsKey(newLink)

&& newLink.startsWith(oldLinkHost)) {

// System.out.println("temp2: " + newLink);

newMap.put(newLink, false);

}

}

}

}

} catch (MalformedURLException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

}

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

oldMap.replace(oldLink, false, true);

}

}

//有新链接,继续遍历

if (!newMap.isEmpty()) {

oldMap.putAll(newMap);

oldMap.putAll(crawlLinks(oldLinkHost, oldMap)); //由于Map的特性,不会导致出现重复的键值对

}

return oldMap;

}

}登录后复制

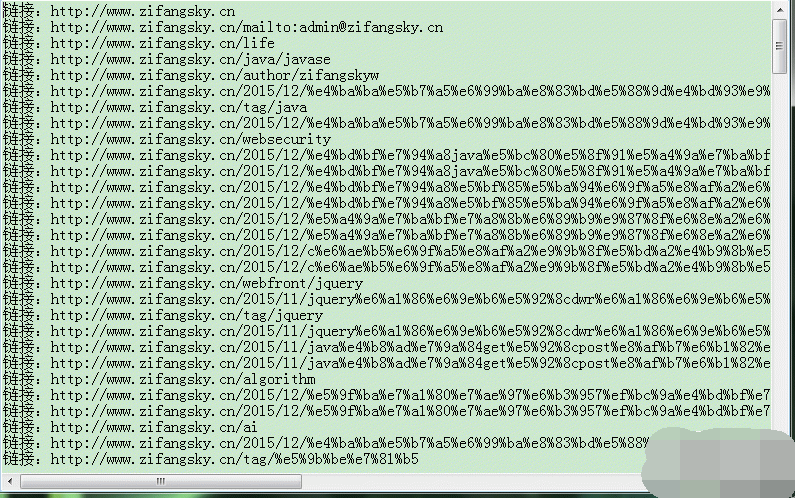

三 最后的测试效果

本站声明

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系admin@php.cn

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

刺客信条阴影:贝壳谜语解决方案

3 周前

By DDD

Windows 11 KB5054979中的新功能以及如何解决更新问题

2 周前

By DDD

在哪里可以找到原子中的起重机控制钥匙卡

3 周前

By DDD

节省R.E.P.O.解释(并保存文件)

1 个月前

By 尊渡假赌尊渡假赌尊渡假赌

刺客信条阴影 - 如何找到铁匠,解锁武器和装甲定制

4 周前

By DDD

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)