使用python Selenium爬取内容并存储MySQL数据库的实例图解

这篇文章主要介绍了python Selenium爬取内容并存储至MySQL数据库的实现代码,需要的朋友可以参考下

前面我通过一篇文章讲述了如何爬取CSDN的博客摘要等信息。通常,在使用Selenium爬虫爬取数据后,需要存储在TXT文本中,但是这是很难进行数据处理和数据分析的。这篇文章主要讲述通过Selenium爬取我的个人博客信息,然后存储在数据库MySQL中,以便对数据进行分析,比如分析哪个时间段发表的博客多、结合WordCloud分析文章的主题、文章阅读量排名等。

这是一篇基础性的文章,希望对您有所帮助,如果文章中出现错误或不足之处,还请海涵。下一篇文章会简单讲解数据分析的过程。

一. 爬取的结果

爬取的地址为:http://blog.csdn.net/Eastmount

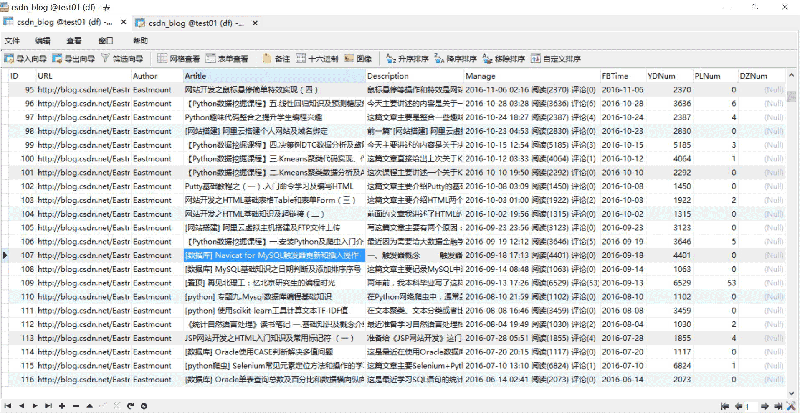

爬取并存储至MySQL数据库的结果如下所示:

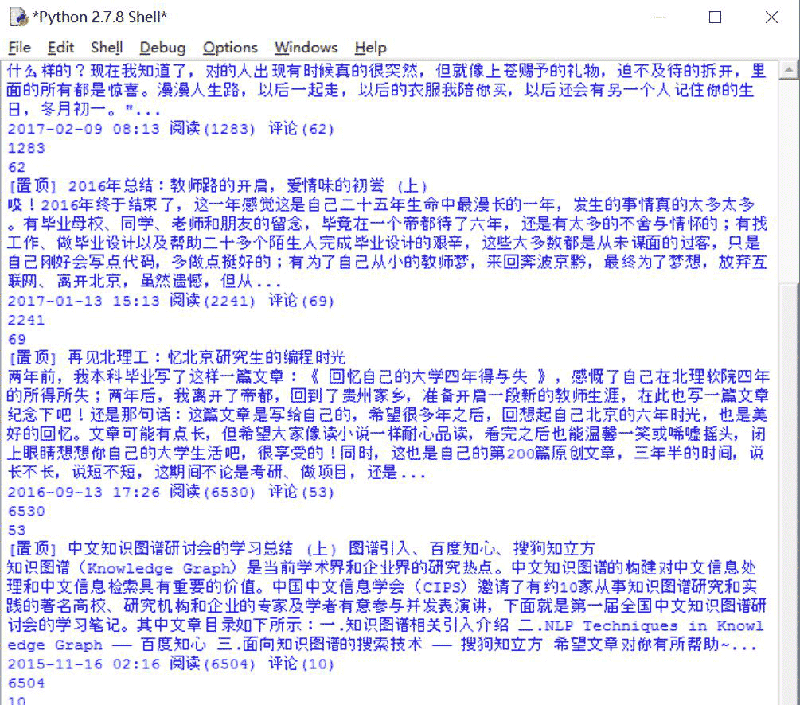

运行过程如下图所示:

二. 完整代码分析

完整代码如下所示:

# coding=utf-8

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import selenium.webdriver.support.ui as ui

import re

import time

import os

import codecs

import MySQLdb

#打开Firefox浏览器 设定等待加载时间

driver = webdriver.Firefox()

wait = ui.WebDriverWait(driver,10)

#获取每个博主的博客页面低端总页码

def getPage():

print 'getPage'

number = 0

texts = driver.find_element_by_xpath("//p[@id='papelist']").text

print '页码', texts

m = re.findall(r'(\w*[0-9]+)\w*',texts) #正则表达式寻找数字

print '页数:' + str(m[1])

return int(m[1])

#主函数

def main():

#获取txt文件总行数

count = len(open("Blog_URL.txt",'rU').readlines())

print count

n = 0

urlfile = open("Blog_URL.txt",'r')

#循环获取每个博主的文章摘信息

while n < count: #这里爬取2个人博客信息,正常情况count个博主信息

url = urlfile.readline()

url = url.strip("\n")

print url

driver.get(url)

#获取总页码

allPage = getPage()

print u'页码总数为:', allPage

time.sleep(2)

#数据库操作结合

try:

conn=MySQLdb.connect(host='localhost',user='root',

passwd='123456',port=3306, db='test01')

cur=conn.cursor() #数据库游标

#报错:UnicodeEncodeError: 'latin-1' codec can't encode character

conn.set_character_set('utf8')

cur.execute('SET NAMES utf8;')

cur.execute('SET CHARACTER SET utf8;')

cur.execute('SET character_set_connection=utf8;')

#具体内容处理

m = 1 #第1页

while m <= allPage:

ur = url + "/article/list/" + str(m)

print ur

driver.get(ur)

#标题

article_title = driver.find_elements_by_xpath("//p[@class='article_title']")

for title in article_title:

#print url

con = title.text

con = con.strip("\n")

#print con + '\n'

#摘要

article_description = driver.find_elements_by_xpath("//p[@class='article_description']")

for description in article_description:

con = description.text

con = con.strip("\n")

#print con + '\n'

#信息

article_manage = driver.find_elements_by_xpath("//p[@class='article_manage']")

for manage in article_manage:

con = manage.text

con = con.strip("\n")

#print con + '\n'

num = 0

print u'长度', len(article_title)

while num < len(article_title):

#插入数据 8个值

sql = '''insert into csdn_blog

(URL,Author,Artitle,Description,Manage,FBTime,YDNum,PLNum)

values(%s, %s, %s, %s, %s, %s, %s, %s)'''

Artitle = article_title[num].text

Description = article_description[num].text

Manage = article_manage[num].text

print Artitle

print Description

print Manage

#获取作者

Author = url.split('/')[-1]

#获取阅读数和评论数

mode = re.compile(r'\d+\.?\d*')

YDNum = mode.findall(Manage)[-2]

PLNum = mode.findall(Manage)[-1]

print YDNum

print PLNum

#获取发布时间

end = Manage.find(u' 阅读')

FBTime = Manage[:end]

cur.execute(sql, (url, Author, Artitle, Description, Manage,FBTime,YDNum,PLNum))

num = num + 1

else:

print u'数据库插入成功'

m = m + 1

#异常处理

except MySQLdb.Error,e:

print "Mysql Error %d: %s" % (e.args[0], e.args[1])

finally:

cur.close()

conn.commit()

conn.close()

n = n + 1

else:

urlfile.close()

print 'Load Over'

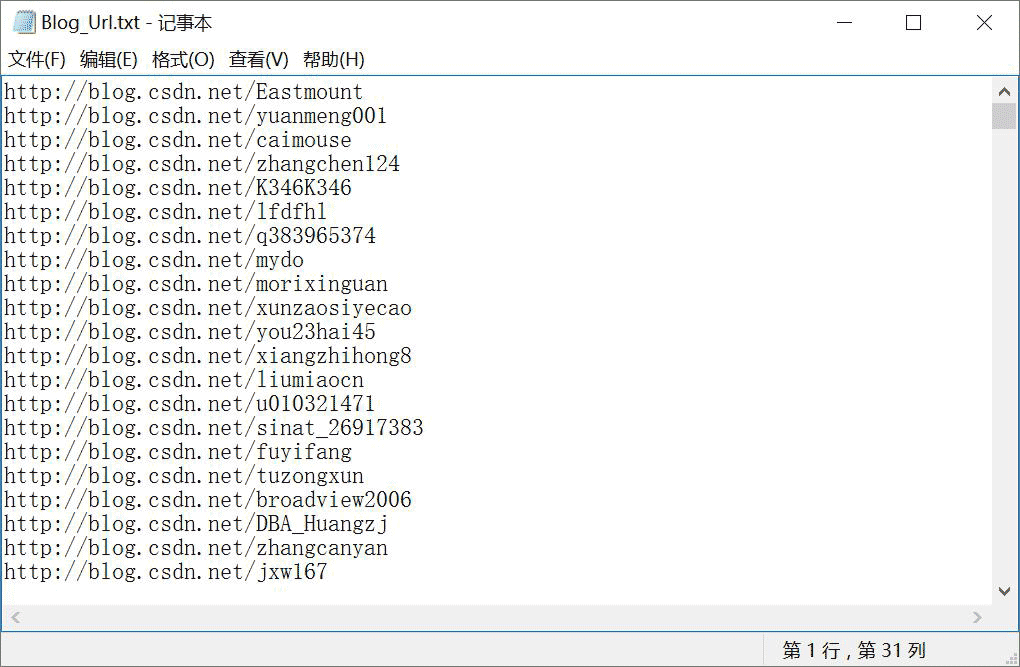

main()在Blog_Url.txt文件中放置需要爬取用户的博客地址URL,如下图所示。注意在此处,作者预先写了个爬取CSDN所有专家的URL代码,这里为访问其他人用于提升阅读量已省略。

分析过程如下所示。

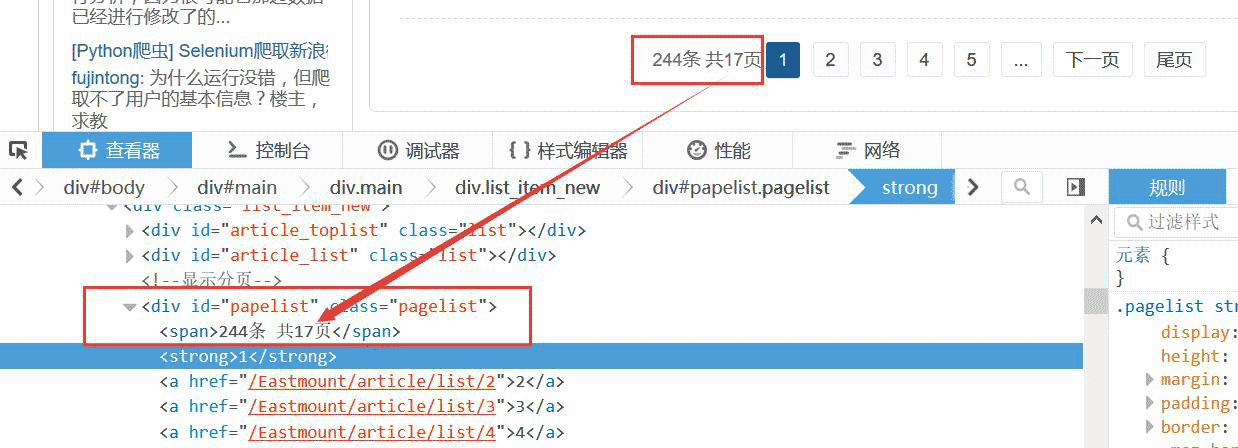

1.获取博主总页码

首先从Blog_Url.txt读取博主地址,然后访问并获取页码总数。代码如下:

#获取每个博主的博客页面低端总页码

def getPage():

print 'getPage'

number = 0

texts = driver.find_element_by_xpath("//p[@id='papelist']").text

print '页码', texts

m = re.findall(r'(\w*[0-9]+)\w*',texts) #正则表达式寻找数字

print '页数:' + str(m[1])

return int(m[1])比如获取总页码位17页,如下图所示:

2.翻页DOM树分析

这里的博客翻页采用的是URL连接,比较方便。

如:http://blog.csdn.net/Eastmount/article/list/2

故只需要 :1.获取总页码;2.爬取每页信息;3.URL设置进行循环翻页;4.再爬取。

也可以采用点击"下页"跳转,没有"下页"停止跳转,爬虫结束,接着爬取下一个博主。

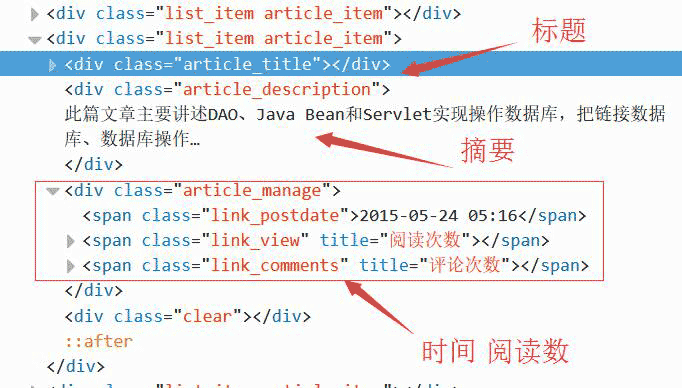

3.获取详细信息:标题、摘要、时间

然后审查元素分析每个博客页面,如果采用BeautifulSoup爬取会报错"Forbidden"。

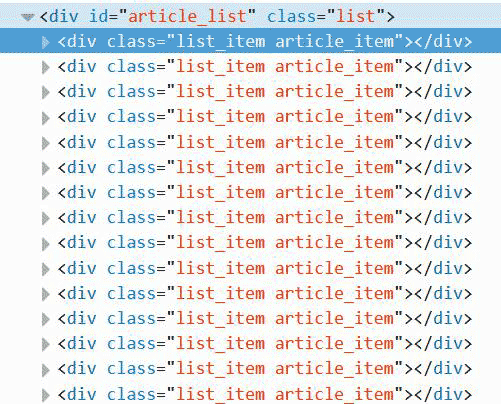

发现每篇文章都是由一个

这里定位到该位置即可爬取,这里需要分别定位标题、摘要、时间。

代码如下所示。注意,在while中同时获取三个值,它们是对应的。

#标题

article_title = driver.find_elements_by_xpath("//p[@class='article_title']")

for title in article_title:

con = title.text

con = con.strip("\n")

print con + '\n'

#摘要

article_description = driver.find_elements_by_xpath("//p[@class='article_description']")

for description in article_description:

con = description.text

con = con.strip("\n")

print con + '\n'

#信息

article_manage = driver.find_elements_by_xpath("//p[@class='article_manage']")

for manage in article_manage:

con = manage.text

con = con.strip("\n")

print con + '\n'

num = 0

print u'长度', len(article_title)

while num < len(article_title):

Artitle = article_title[num].text

Description = article_description[num].text

Manage = article_manage[num].text

print Artitle, Description, Manage 4.特殊字符串处理

获取URL最后一个/后的博主名称、获取字符串时间、阅读数代码如下:

#获取博主姓名 url = "http://blog.csdn.net/Eastmount" print url.split('/')[-1] #输出: Eastmount #获取数字 name = "2015-09-08 18:06 阅读(909) 评论(0)" print name import re mode = re.compile(r'\d+\.?\d*') print mode.findall(name) #输出: ['2015', '09', '08', '18', '06', '909', '0'] print mode.findall(name)[-2] #输出: 909 #获取时间 end = name.find(r' 阅读') print name[:end] #输出: 2015-09-08 18:06 import time, datetime a = time.strptime(name[:end],'%Y-%m-%d %H:%M') print a #输出: time.struct_time(tm_year=2015, tm_mon=9, tm_mday=8, tm_hour=18, tm_min=6, # tm_sec=0, tm_wday=1, tm_yday=251, tm_isdst=-1)

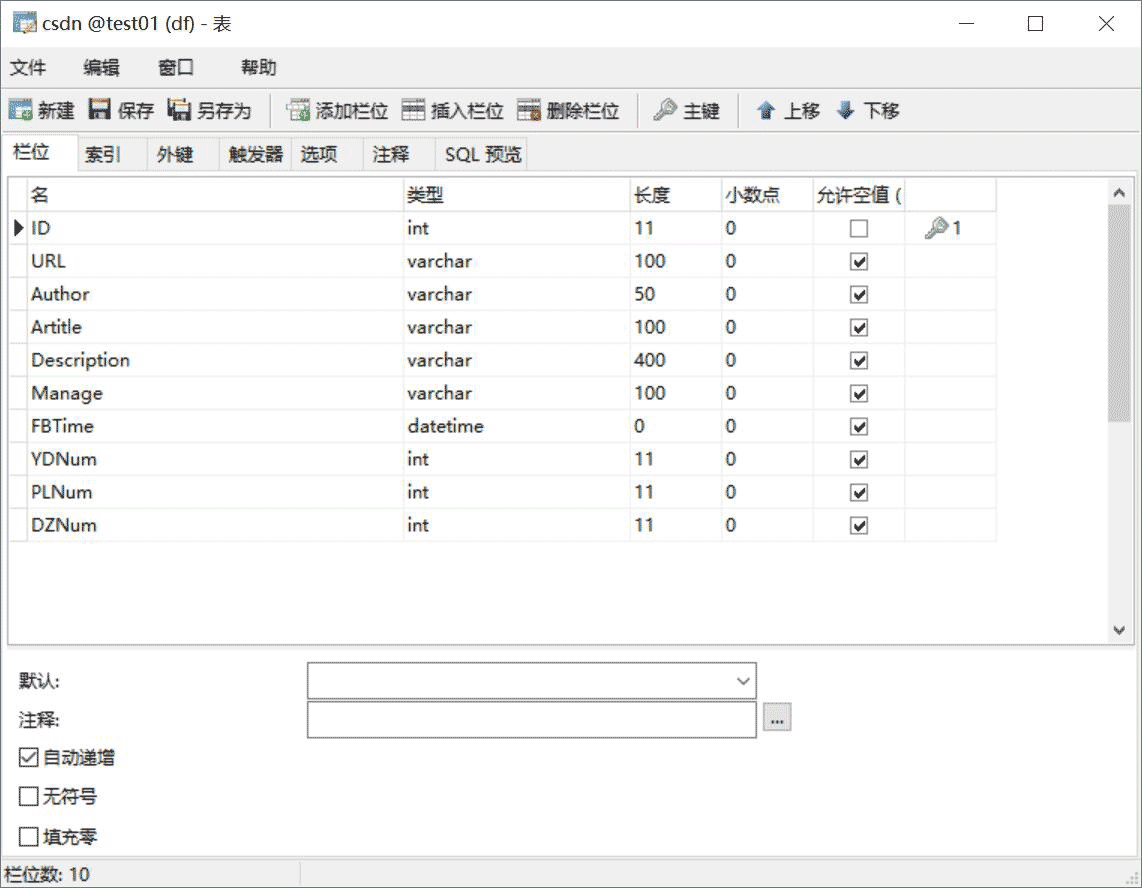

三. 数据库相关操作

SQL语句创建表代码如下:

CREATE TABLE `csdn` ( `ID` int(11) NOT NULL AUTO_INCREMENT, `URL` varchar(100) COLLATE utf8_bin DEFAULT NULL, `Author` varchar(50) COLLATE utf8_bin DEFAULT NULL COMMENT '作者', `Artitle` varchar(100) COLLATE utf8_bin DEFAULT NULL COMMENT '标题', `Description` varchar(400) COLLATE utf8_bin DEFAULT NULL COMMENT '摘要', `Manage` varchar(100) COLLATE utf8_bin DEFAULT NULL COMMENT '信息', `FBTime` datetime DEFAULT NULL COMMENT '发布日期', `YDNum` int(11) DEFAULT NULL COMMENT '阅读数', `PLNum` int(11) DEFAULT NULL COMMENT '评论数', `DZNum` int(11) DEFAULT NULL COMMENT '点赞数', PRIMARY KEY (`ID`) ) ENGINE=InnoDB AUTO_INCREMENT=9371 DEFAULT CHARSET=utf8 COLLATE=utf8_bin;

显示如下图所示:

其中,Python调用MySQL推荐下面这篇文字。

python专题九.Mysql数据库编程基础知识

核心代码如下所示:

# coding:utf-8 import MySQLdb try: conn=MySQLdb.connect(host='localhost',user='root',passwd='123456',port=3306, db='test01') cur=conn.cursor() #插入数据 sql = '''insert into student values(%s, %s, %s)''' cur.execute(sql, ('yxz','111111', '10')) #查看数据 print u'\n插入数据:' cur.execute('select * from student') for data in cur.fetchall(): print '%s %s %s' % data cur.close() conn.commit() conn.close() except MySQLdb.Error,e: print "Mysql Error %d: %s" % (e.args[0], e.args[1])

注意,在下载过程中,有的网站是新版本的,无法获取页码。

比如:http://blog.csdn.net/michaelzhou224

这时需要简单设置,跳过这些链接,并保存到文件中,核心代码如下所示:

#获取每个博主的博客页面低端总页码

def getPage():

print 'getPage'

number = 0

#texts = driver.find_element_by_xpath("//p[@id='papelist']").text

texts = driver.find_element_by_xpath("//p[@class='pagelist']").text

print 'testsss'

print u'页码', texts

if texts=="":

print u'页码为0 网站错误'

return 0

m = re.findall(r'(\w*[0-9]+)\w*',texts) #正则表达式寻找数字

print u'页数:' + str(m[1])

return int(m[1])主函数修改:

error = codecs.open("Blog_Error.txt", 'a', 'utf-8')

#循环获取每个博主的文章摘信息

while n < count: #这里爬取2个人博客信息,正常情况count个博主信息

url = urlfile.readline()

url = url.strip("\n")

print url

driver.get(url+"/article/list/1")

#print driver.page_source

#获取总页码

allPage = getPage()

print u'页码总数为:', allPage

#返回错误,否则程序总截住

if allPage==0:

error.write(url + "\r\n")

print u'错误URL'

continue; #跳过进入下一个博主

time.sleep(2)

#数据库操作结合

try:

.....以上是使用python Selenium爬取内容并存储MySQL数据库的实例图解的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

Python:自动化,脚本和任务管理

Apr 16, 2025 am 12:14 AM

Python:自动化,脚本和任务管理

Apr 16, 2025 am 12:14 AM

Python在自动化、脚本编写和任务管理中表现出色。1)自动化:通过标准库如os、shutil实现文件备份。2)脚本编写:使用psutil库监控系统资源。3)任务管理:利用schedule库调度任务。Python的易用性和丰富库支持使其在这些领域中成为首选工具。

vscode怎么在终端运行程序

Apr 15, 2025 pm 06:42 PM

vscode怎么在终端运行程序

Apr 15, 2025 pm 06:42 PM

在 VS Code 中,可以通过以下步骤在终端运行程序:准备代码和打开集成终端确保代码目录与终端工作目录一致根据编程语言选择运行命令(如 Python 的 python your_file_name.py)检查是否成功运行并解决错误利用调试器提升调试效率

vscode 扩展是否是恶意的

Apr 15, 2025 pm 07:57 PM

vscode 扩展是否是恶意的

Apr 15, 2025 pm 07:57 PM

VS Code 扩展存在恶意风险,例如隐藏恶意代码、利用漏洞、伪装成合法扩展。识别恶意扩展的方法包括:检查发布者、阅读评论、检查代码、谨慎安装。安全措施还包括:安全意识、良好习惯、定期更新和杀毒软件。

Python vs. JavaScript:学习曲线和易用性

Apr 16, 2025 am 12:12 AM

Python vs. JavaScript:学习曲线和易用性

Apr 16, 2025 am 12:12 AM

Python更适合初学者,学习曲线平缓,语法简洁;JavaScript适合前端开发,学习曲线较陡,语法灵活。1.Python语法直观,适用于数据科学和后端开发。2.JavaScript灵活,广泛用于前端和服务器端编程。

vscode是什么 vscode是干什么用的

Apr 15, 2025 pm 06:45 PM

vscode是什么 vscode是干什么用的

Apr 15, 2025 pm 06:45 PM

VS Code 全称 Visual Studio Code,是一个由微软开发的免费开源跨平台代码编辑器和开发环境。它支持广泛的编程语言,提供语法高亮、代码自动补全、代码片段和智能提示等功能以提高开发效率。通过丰富的扩展生态系统,用户可以针对特定需求和语言添加扩展程序,例如调试器、代码格式化工具和 Git 集成。VS Code 还包含直观的调试器,有助于快速查找和解决代码中的 bug。

vscode 无法运行 python怎么回事

Apr 15, 2025 pm 06:00 PM

vscode 无法运行 python怎么回事

Apr 15, 2025 pm 06:00 PM

最常见的“无法运行 Python”问题源于 Python 解释器路径的错误配置,解决方法包括:确认 Python 安装、配置 VS Code、使用虚拟环境。除此之外,还有断点调试、变量监视、日志输出、代码格式化等高效的调试技巧和最佳实践,如使用虚拟环境隔离依赖,使用断点追踪代码执行,使用监视表达式实时跟踪变量变化等,这些能大幅提高开发效率。

vscode 可以在 mac 上吗

Apr 15, 2025 pm 07:45 PM

vscode 可以在 mac 上吗

Apr 15, 2025 pm 07:45 PM

VS Code 在 macOS 上表现良好,可提升开发效率。安装和配置步骤包括:安装 VS Code 并进行配置。安装特定语言的扩展(如 JavaScript 的 ESLint)。谨慎安装扩展,避免过多导致启动变慢。学习基本功能,如 Git 集成、终端和调试器。设置合适的主题和代码字体。注意潜在问题:扩展兼容性、文件权限等。

vs code 可以运行 python 吗

Apr 15, 2025 pm 08:21 PM

vs code 可以运行 python 吗

Apr 15, 2025 pm 08:21 PM

是的,VS Code 可以运行 Python 代码。为在 VS Code 中高效运行 Python,请完成以下步骤:安装 Python 解释器并配置环境变量。安装 VS Code 中的 Python 扩展。通过命令行在 VS Code 的终端中运行 Python 代码。利用 VS Code 的调试功能和代码格式化来提高开发效率。采用良好的编程习惯并使用性能分析工具优化代码性能。