序列标注、手写小写字母OCR数据集、双向RNN

序列标注(sequence labelling),输入序列每一帧预测一个类别。OCR(Optical Character Recognition 光学字符识别)。

MIT口语系统研究组Rob Kassel收集,斯坦福大学人工智能实验室Ben Taskar预处理OCR数据集(http://ai.stanford.edu/~btaskar/ocr/ ),包含大量单独手写小写字母,每个样本对应16X8像素二值图像。字线组合序列,序列对应单词。6800个,长度不超过14字母的单词。gzip压缩,内容用Tab分隔文本文件。Python csv模块直接读取。文件每行一个归一化字母属性,ID号、标签、像素值、下一字母ID号等。

下一字母ID值排序,按照正确顺序读取每个单词字母。收集字母,直到下一个ID对应字段未被设置为止。读取新序列。读取完目标字母及数据像素,用零图像填充序列对象,能纳入两个较大目标字母所有像素数据NumPy数组。

时间步之间共享softmax层。数据和目标数组包含序列,每个目标字母对应一个图像帧。RNN扩展,每个字母输出添加softmax分类器。分类器对每帧数据而非整个序列评估预测结果。计算序列长度。一个softmax层添加到所有帧:或者为所有帧添加几个不同分类器,或者令所有帧共享同一个分类器。共享分类器,权值在训练中被调整次数更多,训练单词每个字母。一个全连接层权值矩阵维数batch_size*in_size*out_size。现需要在两个输入维度batch_size、sequence_steps更新权值矩阵。令输入(RNN输出活性值)扁平为形状batch_size*sequence_steps*in_size。权值矩阵变成较大的批数据。结果反扁平化(unflatten)。

代价函数,序列每一帧有预测目标对,在相应维度平均。依据张量长度(序列最大长度)归一化的tf.reduce_mean无法使用。需要按照实际序列长度归一化,手工调用tf.reduce_sum和除法运算均值。

损失函数,tf.argmax针对轴2非轴1,各帧填充,依据序列实际长度计算均值。tf.reduce_mean对批数据所有单词取均值。

TensorFlow自动导数计算,可使用序列分类相同优化运算,只需要代入新代价函数。对所有RNN梯度裁剪,防止训练发散,避免负面影响。

训练模型,get_sataset下载手写体图像,预处理,小写字母独热编码向量。随机打乱数据顺序,分偏划分训练集、测试集。

单词相邻字母存在依赖关系(或互信息),RNN保存同一单词全部输入信息到隐含活性值。前几个字母分类,网络无大量输入推断额外信息,双向RNN(bidirectional RNN)克服缺陷。

两个RNN观测输入序列,一个按照通常顺序从左端读取单词,另一个按照相反顺序从右端读取单词。每个时间步得到两个输出活性值。送入共享softmax层前,拼接。分类器从每个字母获取完整单词信息。tf.modle.rnn.bidirectional_rnn已实现。

实现双向RNN。划分预测属性到两个函数,只关注较少内容。_shared_softmax函数,传入函数张量data推断输入尺寸。复用其他架构函数,相同扁平化技巧在所有时间步共享同一个softmax层。rnn.dynamic_rnn创建两个RNN。

序列反转,比实现新反向传递RNN运算容易。tf.reverse_sequence函数反转帧数据中sequence_lengths帧。数据流图节点有名称。scope参数是rnn_dynamic_cell变量scope名称,默认值RNN。两个参数不同RNN,需要不同域。

反转序列送入后向RNN,网络输出反转,和前向输出对齐。沿RNN神经元输出维度拼接两个张量,返回。双向RNN模型性能更优。

import gzipimport csvimport numpy as npfrom helpers import downloadclass OcrDataset:

URL = 'http://ai.stanford.edu/~btaskar/ocr/letter.data.gz'def __init__(self, cache_dir):

path = download(type(self).URL, cache_dir)

lines = self._read(path)

data, target = self._parse(lines)

self.data, self.target = self._pad(data, target)

@staticmethoddef _read(filepath):

with gzip.open(filepath, 'rt') as file_:

reader = csv.reader(file_, delimiter='\t')

lines = list(reader)return lines

@staticmethoddef _parse(lines):

lines = sorted(lines, key=lambda x: int(x[0]))

data, target = [], []

next_ = Nonefor line in lines:if not next_:

data.append([])

target.append([])else:assert next_ == int(line[0])

next_ = int(line[2]) if int(line[2]) > -1 else None

pixels = np.array([int(x) for x in line[6:134]])

pixels = pixels.reshape((16, 8))

data[-1].append(pixels)

target[-1].append(line[1])return data, target

@staticmethoddef _pad(data, target):

max_length = max(len(x) for x in target)

padding = np.zeros((16, 8))

data = [x + ([padding] * (max_length - len(x))) for x in data]

target = [x + ([''] * (max_length - len(x))) for x in target]return np.array(data), np.array(target)import tensorflow as tffrom helpers import lazy_propertyclass SequenceLabellingModel:def __init__(self, data, target, params):

self.data = data

self.target = target

self.params = params

self.prediction

self.cost

self.error

self.optimize

@lazy_propertydef length(self):

used = tf.sign(tf.reduce_max(tf.abs(self.data), reduction_indices=2))

length = tf.reduce_sum(used, reduction_indices=1)

length = tf.cast(length, tf.int32)return length

@lazy_propertydef prediction(self):

output, _ = tf.nn.dynamic_rnn(

tf.nn.rnn_cell.GRUCell(self.params.rnn_hidden),

self.data,

dtype=tf.float32,

sequence_length=self.length,

)# Softmax layer.max_length = int(self.target.get_shape()[1])

num_classes = int(self.target.get_shape()[2])

weight = tf.Variable(tf.truncated_normal(

[self.params.rnn_hidden, num_classes], stddev=0.01))

bias = tf.Variable(tf.constant(0.1, shape=[num_classes]))# Flatten to apply same weights to all time steps.output = tf.reshape(output, [-1, self.params.rnn_hidden])

prediction = tf.nn.softmax(tf.matmul(output, weight) + bias)

prediction = tf.reshape(prediction, [-1, max_length, num_classes])return prediction

@lazy_propertydef cost(self):# Compute cross entropy for each frame.cross_entropy = self.target * tf.log(self.prediction)

cross_entropy = -tf.reduce_sum(cross_entropy, reduction_indices=2)

mask = tf.sign(tf.reduce_max(tf.abs(self.target), reduction_indices=2))

cross_entropy *= mask# Average over actual sequence lengths.cross_entropy = tf.reduce_sum(cross_entropy, reduction_indices=1)

cross_entropy /= tf.cast(self.length, tf.float32)return tf.reduce_mean(cross_entropy)

@lazy_propertydef error(self):

mistakes = tf.not_equal(

tf.argmax(self.target, 2), tf.argmax(self.prediction, 2))

mistakes = tf.cast(mistakes, tf.float32)

mask = tf.sign(tf.reduce_max(tf.abs(self.target), reduction_indices=2))

mistakes *= mask# Average over actual sequence lengths.mistakes = tf.reduce_sum(mistakes, reduction_indices=1)

mistakes /= tf.cast(self.length, tf.float32)return tf.reduce_mean(mistakes)

@lazy_propertydef optimize(self):

gradient = self.params.optimizer.compute_gradients(self.cost)try:

limit = self.params.gradient_clipping

gradient = [

(tf.clip_by_value(g, -limit, limit), v)if g is not None else (None, v)for g, v in gradient]except AttributeError:print('No gradient clipping parameter specified.')

optimize = self.params.optimizer.apply_gradients(gradient)return optimizeimport randomimport tensorflow as tfimport numpy as npfrom helpers import AttrDictfrom OcrDataset import OcrDatasetfrom SequenceLabellingModel import SequenceLabellingModelfrom batched import batched

params = AttrDict(

rnn_cell=tf.nn.rnn_cell.GRUCell,

rnn_hidden=300,

optimizer=tf.train.RMSPropOptimizer(0.002),

gradient_clipping=5,

batch_size=10,

epochs=5,

epoch_size=50)def get_dataset():

dataset = OcrDataset('./ocr')# Flatten images into vectors.dataset.data = dataset.data.reshape(dataset.data.shape[:2] + (-1,))# One-hot encode targets.target = np.zeros(dataset.target.shape + (26,))for index, letter in np.ndenumerate(dataset.target):if letter:

target[index][ord(letter) - ord('a')] = 1dataset.target = target# Shuffle order of examples.order = np.random.permutation(len(dataset.data))

dataset.data = dataset.data[order]

dataset.target = dataset.target[order]return dataset# Split into training and test data.dataset = get_dataset()

split = int(0.66 * len(dataset.data))

train_data, test_data = dataset.data[:split], dataset.data[split:]

train_target, test_target = dataset.target[:split], dataset.target[split:]# Compute graph._, length, image_size = train_data.shape

num_classes = train_target.shape[2]

data = tf.placeholder(tf.float32, [None, length, image_size])

target = tf.placeholder(tf.float32, [None, length, num_classes])

model = SequenceLabellingModel(data, target, params)

batches = batched(train_data, train_target, params.batch_size)

sess = tf.Session()

sess.run(tf.initialize_all_variables())for index, batch in enumerate(batches):

batch_data = batch[0]

batch_target = batch[1]

epoch = batch[2]if epoch >= params.epochs:breakfeed = {data: batch_data, target: batch_target}

error, _ = sess.run([model.error, model.optimize], feed)print('{}: {:3.6f}%'.format(index + 1, 100 * error))

test_feed = {data: test_data, target: test_target}

test_error, _ = sess.run([model.error, model.optimize], test_feed)print('Test error: {:3.6f}%'.format(100 * error))import tensorflow as tffrom helpers import lazy_propertyclass BidirectionalSequenceLabellingModel:def __init__(self, data, target, params):

self.data = data

self.target = target

self.params = params

self.prediction

self.cost

self.error

self.optimize

@lazy_propertydef length(self):

used = tf.sign(tf.reduce_max(tf.abs(self.data), reduction_indices=2))

length = tf.reduce_sum(used, reduction_indices=1)

length = tf.cast(length, tf.int32)return length

@lazy_propertydef prediction(self):

output = self._bidirectional_rnn(self.data, self.length)

num_classes = int(self.target.get_shape()[2])

prediction = self._shared_softmax(output, num_classes)return predictiondef _bidirectional_rnn(self, data, length):

length_64 = tf.cast(length, tf.int64)

forward, _ = tf.nn.dynamic_rnn(

cell=self.params.rnn_cell(self.params.rnn_hidden),

inputs=data,

dtype=tf.float32,

sequence_length=length,

scope='rnn-forward')

backward, _ = tf.nn.dynamic_rnn(

cell=self.params.rnn_cell(self.params.rnn_hidden),

inputs=tf.reverse_sequence(data, length_64, seq_dim=1),

dtype=tf.float32,

sequence_length=self.length,

scope='rnn-backward')

backward = tf.reverse_sequence(backward, length_64, seq_dim=1)

output = tf.concat(2, [forward, backward])return outputdef _shared_softmax(self, data, out_size):

max_length = int(data.get_shape()[1])

in_size = int(data.get_shape()[2])

weight = tf.Variable(tf.truncated_normal(

[in_size, out_size], stddev=0.01))

bias = tf.Variable(tf.constant(0.1, shape=[out_size]))# Flatten to apply same weights to all time steps.flat = tf.reshape(data, [-1, in_size])

output = tf.nn.softmax(tf.matmul(flat, weight) + bias)

output = tf.reshape(output, [-1, max_length, out_size])return output

@lazy_propertydef cost(self):# Compute cross entropy for each frame.cross_entropy = self.target * tf.log(self.prediction)

cross_entropy = -tf.reduce_sum(cross_entropy, reduction_indices=2)

mask = tf.sign(tf.reduce_max(tf.abs(self.target), reduction_indices=2))

cross_entropy *= mask# Average over actual sequence lengths.cross_entropy = tf.reduce_sum(cross_entropy, reduction_indices=1)

cross_entropy /= tf.cast(self.length, tf.float32)return tf.reduce_mean(cross_entropy)

@lazy_propertydef error(self):

mistakes = tf.not_equal(

tf.argmax(self.target, 2), tf.argmax(self.prediction, 2))

mistakes = tf.cast(mistakes, tf.float32)

mask = tf.sign(tf.reduce_max(tf.abs(self.target), reduction_indices=2))

mistakes *= mask# Average over actual sequence lengths.mistakes = tf.reduce_sum(mistakes, reduction_indices=1)

mistakes /= tf.cast(self.length, tf.float32)return tf.reduce_mean(mistakes)

@lazy_propertydef optimize(self):

gradient = self.params.optimizer.compute_gradients(self.cost)try:

limit = self.params.gradient_clipping

gradient = [

(tf.clip_by_value(g, -limit, limit), v)if g is not None else (None, v)for g, v in gradient]except AttributeError:print('No gradient clipping parameter specified.')

optimize = self.params.optimizer.apply_gradients(gradient)return optimize

参考资料:

《面向机器智能的TensorFlow实践》

欢迎加我微信交流:qingxingfengzi

我的微信公众号:qingxingfengzigz

我老婆张幸清的微信公众号:qingqingfeifangz

以上是序列标注、手写小写字母OCR数据集、双向RNN的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

小红书笔记怎么删除

Mar 21, 2024 pm 08:12 PM

小红书笔记怎么删除

Mar 21, 2024 pm 08:12 PM

小红书笔记怎么删除?在小红书APP中是可以编辑笔记的,多数的用户不知道小红书笔记如何的删除,接下来就是小编为用户带来的小红书笔记删除方法图文教程,感兴趣的用户快来一起看看吧!小红书使用教程小红书笔记怎么删除1、首先打开小红书APP进入到主页面,选择右下角【我】进入到专区;2、之后在我的专区,点击下图所示的笔记页面,选择要删除的笔记;3、进入到笔记页面,右上角【三个点】;4、最后下方会展开功能栏,点击【删除】即可完成。

学会彻底卸载pip,使用Python更加高效

Jan 16, 2024 am 09:01 AM

学会彻底卸载pip,使用Python更加高效

Jan 16, 2024 am 09:01 AM

不再需要pip?快来学习如何有效卸载pip!引言:pip是Python的包管理工具之一,它可以方便地安装、升级和卸载Python包。然而,有时候我们可能需要卸载pip,可能是因为我们希望使用其他的包管理工具,或者因为我们需要完全清除Python环境。本文将介绍如何有效地卸载pip,并提供具体的代码示例。一、卸载pip的方法下面将介绍两种常见的卸载pip的方法

小红书发布过的笔记不见了怎么办?它刚发的笔记搜不到的原因是什么?

Mar 21, 2024 pm 09:30 PM

小红书发布过的笔记不见了怎么办?它刚发的笔记搜不到的原因是什么?

Mar 21, 2024 pm 09:30 PM

作为一名小红书的用户,我们都曾遇到过发布过的笔记突然不见了的情况,这无疑让人感到困惑和担忧。在这种情况下,我们该怎么办呢?本文将围绕“小红书发布过的笔记不见了怎么办”这一主题,为你详细解答。一、小红书发布过的笔记不见了怎么办?首先,不要惊慌。如果你发现笔记不见了,保持冷静是关键,不要慌张。这可能是由于平台系统故障或操作失误引起的。检查发布记录很简单。只需打开小红书App,点击“我”→“发布”→“所有发布”,就可以查看自己的发布记录。在这里,你可以轻松找到之前发布的笔记。3.重新发布。如果找到了之

小红书怎么在笔记中添加商品链接 小红书在笔记中添加商品链接教程

Mar 12, 2024 am 10:40 AM

小红书怎么在笔记中添加商品链接 小红书在笔记中添加商品链接教程

Mar 12, 2024 am 10:40 AM

小红书怎么在笔记中添加商品链接?在小红书这款app中用户不仅可以浏览各种内容还可以进行购物,所以这款app中关于购物推荐、好物分享的内容是非常多的,如果小伙伴在这款app也是一个达人的话,也可以分享一些购物经验,找到商家进行合作,在笔记中添加连接之类的,很多人都愿意使用这款app购物,因为不仅方便,而且有很多达人会进行一些推荐,可以一边浏览有趣内容,一边看看有没有适合自己的衣服商品。一起看看如何在笔记中添加商品链接吧!小红书笔记添加商品链接方法 在手机桌面上打开app。 在app首页点击

深入研究matplotlib的色彩映射表

Jan 09, 2024 pm 03:51 PM

深入研究matplotlib的色彩映射表

Jan 09, 2024 pm 03:51 PM

深入学习matplotlib颜色表,需要具体代码示例一、引言matplotlib是一个功能强大的Python绘图库,它提供了丰富的绘图函数和工具,可以用于创建各种类型的图表。而颜色表(colormap)是matplotlib中一个重要的概念,它决定了图表的配色方案。深入学习matplotlib颜色表,将帮助我们更好地掌握matplotlib的绘图功能,使绘

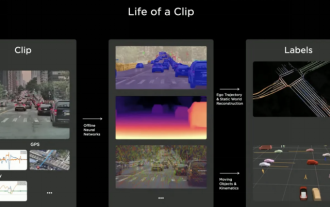

2024年自动驾驶标注行业是否会被世界模型所颠覆?

Mar 01, 2024 pm 10:37 PM

2024年自动驾驶标注行业是否会被世界模型所颠覆?

Mar 01, 2024 pm 10:37 PM

1.数据标注面临的问题(特别是基于BEV任务)随着基于BEVtransformer任务的兴起,随之带来的是对数据的依赖变的越来越重,基于BEV任务的标注也变得越来越重要。目前来看无论是2D-3D的联合障碍物标注,还是基于重建点云的clip的车道线或者Occpuancy任务标注都还是太贵了(和2D标注任务相比,贵了很多)。当然业界里面也有很多基于大模型等的半自动化,或者自动化标注的研究。还有一方面是自动驾驶的数据采集,周期太过于漫长,还涉及到数据合规能一系列问题。比如,你想采集一个平板车跨相机的场

揭秘C语言的吸引力: 发掘程序员的潜质

Feb 24, 2024 pm 11:21 PM

揭秘C语言的吸引力: 发掘程序员的潜质

Feb 24, 2024 pm 11:21 PM

学习C语言的魅力:解锁程序员的潜力随着科技的不断发展,计算机编程已经成为了一个备受关注的领域。在众多编程语言中,C语言一直以来都备受程序员的喜爱。它的简单、高效以及广泛应用的特点,使得学习C语言成为了许多人进入编程领域的第一步。本文将讨论学习C语言的魅力,以及如何通过学习C语言来解锁程序员的潜力。首先,学习C语言的魅力在于其简洁性。相比其他编程语言而言,C语

一起学习word根号输入办法

Mar 19, 2024 pm 08:52 PM

一起学习word根号输入办法

Mar 19, 2024 pm 08:52 PM

在word中编辑文字内容时,有时会需要输入公式符号。有的小伙们不知道在word根号输入的方法,小面就让小编跟小伙伴们一起分享下word根号输入的方法教程。希望对小伙伴们有所帮助。首先,打开电脑上的Word软件,然后打开要编辑的文件,并将光标移动到需要插入根号的位置,参考下方的图片示例。2.选择【插入】,再选择符号里的【公式】。如下方的图片红色圈中部分内容所示:3.接着选择下方的【插入新公式】。如下方的图片红色圈中部分内容所示:4.选择【根式】,再选择合适的根号。如下方的图片红色圈中部分内容所示: