服务器编程中对于文件的操作详解

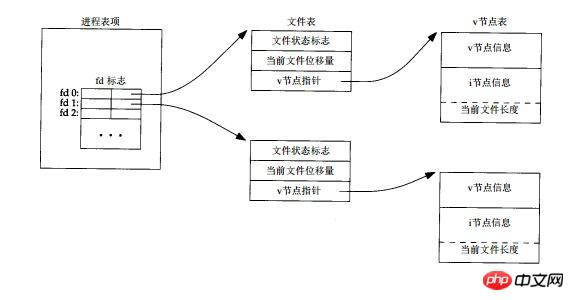

linux系统下一切皆文件,通过虚拟文件系统(VFS)的机制将所有底层屏蔽掉,用户可以通过统一的接口来实现对不同驱动的操作,对于每一个文件需要一个引用来指示,此时文件描述符应用而生,文件描述符类似于widows下的handle,对于文件的大部分操作都是通过这个描述符来操作的,例如read,write。对于每一个文件描述符,内核使用三种数据结构来管理。

(1) 每个进程在进程表中都有一个记录项,每个记录项中有一张打开文件描述符表,可将其视为一个矢量,每个描述符占用一项。与每个文件描述符相关联的是:

(a) 文件描述符标志。 (当前只定义了一个文件描述符标志FD_CLOEXEC)

(b) 指向一个文件表项的指针。

(2) 内核为所有打开文件维持一张文件表。每个文件表项包含:

(a) 文件状态标志(读、写、增写、同步、非阻塞等 )。

(b) 当前文件位移量。(即为lseek函数所操作的值)

(c) 指向该文件v节点表项的指针。

(3) 每个打开文件(或设备)都有一个 v 节点结构。 v节点包含了文件类型和对此文件进行各种操作的函数的指针信息。对于大多数文件, v 节点还包含了该文件的 i 节点(索引节点)。这些信息是在打开文件时从盘上读入内存的,所以所有关于文件的信息都是快速可供使用的。例如, i 节点包含了文件的所有者、文件长度、文件所在的设备、指向文件在盘上所使用的实际数据块的指针等等点。

经过上述文件系统的三层封装,每层负责不同的职责,从上到下第一层用于标识文件,第二层用于管理进程独立数据,第三层管理文件系统元数据,直接关联一个文件。这种分层思想的一个优点就是上层可以复用下层的结构。可能有多个文件描述符项指向同一个文件表项,也可以有多个文件表项指向同一个V节点。

如果两个独立的进程打开了同一个文件,打开此文件的每个进程都得到一个文件表项,但是两个文件表项的V节点指针指向相同的V节点,这样的安排使得每个进程都有他自己的对该文件的当前位移量,且支持不同的打开方式(O_RDONLY, O_WRONLY, ORDWR)。

当一个进程通过fork创建出子进程后,此时父,子进程内的文件描述符共享同一个文件表项,也就是说父子进程的文件描述符的指向相同。一般我们会在fork后关闭掉各自不需要的fd,例如父子进程通过pipe或socketpair进行通信,往往会close掉自己不需要读(或写)的一端。只有在没有文件描述符引用当前文件表项的时候,close操作才真正销毁当前文件表项数据结构,有点类似于引用计数的思想。这也是网络编程中close和shutdown函数的区别,前者只有在最后一个使用该socket的句柄的进程关闭的时候才真正断开连接,而后者毫不商量直接断开一侧连接。但是在多线程的环境中,由于父子线程共享地址空间,此时文件描述符共同拥有,只有一份,所以也就不能在线程内close掉自己不需要的fd,否则会导致其它需要该fd的线程也受影响。因为父,子进程内打开的文件描述符共享同一个文件表项,所以在某些系统的服务器编程中,如果采用preforking模型(服务器预先派生多个子进程,在每个子进程监听listenfd来accept连接)就会导致惊群现象的发生,服务器派生的多个子进程各自调用accept并因而均被投入睡眠,当第一个客户连接到达时,尽管只有一个进程获得连接,但是所有进程都被唤醒,这样导致性能受损。参见UNP P657。

同时如果fork之后调用exec,所有的文件描述符继续保持打开状态。这可以用来给exec后的程序传递某些文件描述符。同时文件描述符标志FD_CLOEXEC 就是用来关闭exec时继续保持开放的文件描述符的选项。

也可以通过dup或fcntl显式复制一个文件描述符,他们指向相同的文件表项。通过dup2将文件描述符复制到制定数值。

每个进程都有一个文件描述符表,进程间独立,两个进程之间的文件描述符并无直接关系,所以在进程内可以直接传递文件描述符,但是如果跨越进程传递就失去了意义,unix可以通过sendmsg/recvmsg进行专门的文件描述符的传递(参见书UNP 15.7节)。每个进程的前三个文件描述符分别对应标准输入,标准输出,标准错误。但是一个进程可打开的文件描述符数量是有限制的,如果打开的文件描述符太多会出现”Too many open files”的问题。在网络服务器中,通过listenfd调用调用accept时,体现为产生EMFILE错误,这主要是因为文件描述符是系统的一个重要资源,系统资源是有尽的,系统对单一进程文件描述符限制默认值一般是1024,使用ulimit -n命令可以查看。当然也可以调高进程文件描述符数目,但这是治标不治本的方法,因为处理高并发服务时,服务器资源有限,难免资源枯竭。

当结合epoll的水平触发方式来监听lisenfd的连接时,大量socket连接涌来如果不处理会塞满TCP的连接队列,listenfd会一直产生可读事件,将服务器陷入忙等待,用C++开源网络库muduo作者陈硕的做法是事先准备一个空闲的文件描述符,当产生EMFILE错误时就先关闭这个空闲文件,获得一个文件描述符名额,再accept拿到一个socket连接的文件描述符,随后立刻close,这样就优雅的断开了与客户端的连接,最后重新打开空闲文件,把”坑”填上,以备再次出现这种情况时使用。

1 //在程序开头先”占用”一个文件描述符 2 3 int idlefd = open("/dev/null", O_RDONLY | O_CLOEXEC); 4 ………… 5 6 //然后当出现EMFILE错误的时候处理这个错误 7 8 peerlen = sizeof(peeraddr); 9 connfd = accept4(listenfd, (struct sockaddr*)&peeraddr, &peerlen, SOCK_NONBLOCK | SOCK_CLOEXEC);10 11 if (connfd == -1)12 {13 if (errno == EMFILE)14 {15 close(idlefd);16 idlefd = accept(listenfd, NULL, NULL);17 close(idlefd);18 idlefd = open("/dev/null", O_RDONLY | O_CLOEXEC);19 continue;20 }21 else22 ERR_EXIT("accept4");23 }以上是服务器编程中对于文件的操作详解的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

使用正则表达式去除 PHP 数组中的重复值

Apr 26, 2024 pm 04:33 PM

使用正则表达式去除 PHP 数组中的重复值

Apr 26, 2024 pm 04:33 PM

使用正则表达式从PHP数组中去除重复值的方法:使用正则表达式/(.*)(.+)/i匹配并替换重复项。遍历数组元素,使用preg_match检查匹配情况。如果匹配,跳过值;否则,将其添加到无重复值的新数组中。

搭载 AMD EPYC 霄龙 4004 系列处理器,华硕推出多款服务器与工作站产品

Jul 23, 2024 pm 09:34 PM

搭载 AMD EPYC 霄龙 4004 系列处理器,华硕推出多款服务器与工作站产品

Jul 23, 2024 pm 09:34 PM

本站7月23日消息,华硕推出多款由AMDEPYC霄龙4004系列处理器驱动的服务器与工作站级产品。本站注:AMD于5月推出AM5平台、Zen4架构的EPYC霄龙4004系列处理器,最高提供16核3DV-Cache规格。ASUSProER100AB6服务器ASUSProER100AB6是一款搭载EPYC霄龙4004系列处理器的1U机架式服务器产品,适用于IDC及中小型企业需求。ASUSExpertCenterProET500AB6工作站ASUSExpertCenterProET500AB6是一款A

编程是干啥的,学了有什么用

Apr 28, 2024 pm 01:34 PM

编程是干啥的,学了有什么用

Apr 28, 2024 pm 01:34 PM

1、编程可以用于开发各种软件和应用程序,包括网站、手机应用、游戏和数据分析工具等。它的应用领域非常广泛,覆盖了几乎所有行业,包括科学研究、医疗保健、金融、教育、娱乐等。2、学习编程可以帮助我们提高问题解决能力和逻辑思维能力。编程过程中,我们需要分析和理解问题,找出解决方案,并将其转化为代码。这种思维方式能够培养我们的分析和抽象能力,提高我们解决实际问题的能力。

释放你内心的程序员:C 绝对初学者

Oct 11, 2024 pm 03:50 PM

释放你内心的程序员:C 绝对初学者

Oct 11, 2024 pm 03:50 PM

C语言是初学者学习编程的理想选择,其优势包括效率、多功能性和可移植性。学习C语言需要:安装C编译器(如MinGW或Cygwin)了解变量、数据类型、条件语句和循环语句编写包含主函数和printf()函数的第一个程序通过实战案例(如计算平均数)练习C语言知识

使用 Python 解决问题:作为初学者,解锁强大的解决方案

Oct 11, 2024 pm 08:58 PM

使用 Python 解决问题:作为初学者,解锁强大的解决方案

Oct 11, 2024 pm 08:58 PM

Python 使初学者能够解决问题。其用户友好的语法、广泛的库以及变量、条件语句和循环等功能可实现高效的代码开发。从管理数据到控制程序流程和执行重复任务,Python 提供了

C++ 编程谜题集锦:激发思维,提升编程水平

Jun 01, 2024 pm 10:26 PM

C++ 编程谜题集锦:激发思维,提升编程水平

Jun 01, 2024 pm 10:26 PM

C++编程谜题涵盖斐波那契数列、阶乘、汉明距离、数组最大值和最小值等算法和数据结构概念,通过解决这些谜题,可以巩固C++知识,提升算法理解和编程技巧。

编码的关键:为初学者释放 Python 的力量

Oct 11, 2024 pm 12:17 PM

编码的关键:为初学者释放 Python 的力量

Oct 11, 2024 pm 12:17 PM

Python通过其易学性和强大功能,是初学者的理想编程入门语言。其基础包括:变量:用于存储数据(数字、字符串、列表等)。数据类型:定义变量中数据的类型(整数、浮点数等)。运算符:用于数学运算和比较。控制流:控制代码执行流(条件语句、循环)。

Python 的力量,简单:一种适合初学者的编程方法

Oct 11, 2024 pm 04:53 PM

Python 的力量,简单:一种适合初学者的编程方法

Oct 11, 2024 pm 04:53 PM

Python编程入门安装Python:从官方网站下载并安装。HelloWorld!:使用print("HelloWorld!")打印第一行代码。实战案例:计算圆面积:使用π(3.14159)和半径计算圆面积。变量和数据类型:使用变量存储数据,Python中的数据类型包括整数、浮点数、字符串和布尔值。表达式和赋值:使用操作符将变量、常量和函数连接起来,并使用赋值运算符(=)将值赋给变量。控制流:if-else语句:根据条件执行不同的代码块,确定奇