超参数优化比较之网格搜索、随机搜索和贝叶斯优化

本文将详细介绍用来提高机器学习效果的最常见的超参数优化方法。

译者 | 朱先忠

审校 | 孙淑娟

简介

通常,在尝试改进机器学习模型时,人们首先想到的解决方案是添加更多的训练数据。额外的数据通常是有帮助(在某些情况下除外)的,但生成高质量的数据可能非常昂贵。通过使用现有数据获得最佳模型性能,超参数优化可以节省我们的时间和资源。

顾名思义,超参数优化是为机器学习模型确定最佳超参数组合以满足优化函数(即,给定研究中的数据集,最大化模型的性能)的过程。换句话说,每个模型都会提供多个有关选项的调整“按钮”,我们可以改变它们,直到我们模型的超参数达到最佳组合。在超参数优化过程中,我们可以更改的参数的一些示例可以是学习率、神经网络的架构(例如,隐藏层的数量)、正则化等。

在这篇文章中,我们将从概念上介绍三种最常见的超参数优化方法,即网格搜索、随机搜索和贝叶斯优化,然后对它们进行逐一实现。

我将在文章一开始提供一个高级别的比较表,以供读者参考,然后将在本文的其余部分进一步探讨、解释和实施比较表中的每一项。

表1:超参数优化方法比较

1.网格搜索算法

网格搜索可能是超参数优化的最简单和最直观的方法,它涉及在定义的搜索空间中彻底搜索超参数的最佳组合。在此上下文中的“搜索空间”是整个超参数以及在优化过程中考虑的此类超参数的值。让我们通过一个示例来更好地理解网格搜索。

假设我们有一个只有三个参数的机器学习模型,每个参数都可以取下表中提供的值:

parameter_1 = [1, 2, 3]

parameter_2 = [a, b, c]

parameter_3 = [x, y, z]

我们不知道这些参数的哪个组合将优化我们的模型的优化功能(即为我们的机器学习模型提供最佳输出)。在网格搜索中,我们只需尝试这些参数的每一个组合,测量每个参数的模型性能,然后简单地选择产生最佳性能的组合!在此示例中,参数1可以取3个值(即1、2或3),参数2可以取3种值(即a、b和c),参数3可以取3种值(即x、y和z)。换句话说,总共有3*3*3=27个组合。本例中的网格搜索将涉及27轮评估机器学习模型的性能,以找到性能最佳的组合。

如您所见,这种方法非常简单(类似于试错任务),但也有一些局限性。让我们一起总结一下此方法的优点和缺点。

其中,优势包括:

- 易于理解和实施

- 易于并行化

- 适用于离散和连续空间缺点主要有:

- 在具有大量超参数的大型和/或复杂模型中成本高昂(因为必须尝试和评估所有组合)

- 无记忆——不从过去的观察中学习

- 如果搜索空间太大,可能无法找到最佳组合我的建议是,如果您有一个搜索空间较小的简单模型,请使用网格搜索;否则,建议继续往下阅读以找到更适合更大搜索空间的解决方案。

现在,让我们用一个真实的例子来实现网格搜索。

1.1.网格搜索算法实现

为了实现网格搜索,我们将使用scikit-learn中的Iris数据集创建一个随机森林分类模型。该数据集包括3种不同的鸢尾花瓣和萼片长度,将用于本次分类练习。在本文中,模型开发是次要的,因为目标是比较各种超参数优化策略的性能。我鼓励您关注模型评估结果,以及每种超参数优化方法达到所选超参数集所需的时间。我将描述运行结果,然后为本文中使用的三种方法提供一个汇总比较表。

包括所有超参数值的搜索空间,定义如下:

search_space = {'n_estimators': [10, 100, 500, 1000],

'max_depth': [2, 10, 25, 50, 100],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 5, 10]}

上述搜索空间由4*5*3*3=180个超参数的总组合组成。我们将使用网格搜索来找到优化目标函数的组合,如下所示:

# Import libraries

from sklearn.model_selection import GridSearchCV

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import cross_val_score

import time

# 加载Iris数据集

iris = load_iris()

X, y = iris.data, iris.target

#定义超参数搜索空间

search_space = {'n_estimators': [10, 100, 500, 1000],

'max_depth': [2, 10, 25, 50, 100],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 5, 10]}

#定义随机林分类器

clf = RandomForestClassifier(random_state=1234)

# 生成优化器对象

optimizer = GridSearchCV(clf, search_space, cv=5, scoring='accuracy')

#存储起始时间,以便用于计算总的耗时

start_time = time.time()

#拟合数据上的优化器

optimizer.fit(X, y)

# 存储结束时间,以便用于计算总的耗时

end_time = time.time()

# 打印最佳超参数集和相应分数

print(f"selected hyperparameters:")

print(optimizer.best_params_)

print("")

print(f"best_score: {optimizer.best_score_}")

print(f"elapsed_time: {round(end_time-start_time, 1)}")

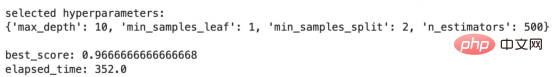

上面代码的输出结果如下:

这里我们可以看到使用网格搜索选择的超参数值。其中,best_score描述了使用所选超参数集的评估结果,而elapsed_time描述了我的本地笔记本电脑执行此超参数优化策略所花费的时间。在进行下一种方法时,请记住评估结果和经过的时间,以便进行比较。现在,让我们进入随机搜索的讨论。

2.随机搜索算法

顾名思义,随机搜索是从定义的搜索空间中随机采样超参数的过程。与网格搜索不同,随机搜索只会在预定义的迭代次数(取决于可用资源,如时间、预算、目标等)中选择超参数值的随机子集,并计算每个超参数的机器学习模型的性能,然后选择最佳的超参数值。

根据上述方法,您可以想象,与完整的网格搜索相比,随机搜索成本更低,但仍有其自身的优势和劣势,如下所示:

优势:

- 易于理解和实施

- 易于并行化

- 适用于离散和连续空间

- 比网格搜索便宜

- 与具有相同尝试次数的网格搜索相比,更可能收敛到最优缺点:

- 无记忆——不从过去的观察中学习

- 考虑到随机选择,可能会错过重要的超参数值

在下一个方法中,我们将通过贝叶斯优化解决网格和随机搜索的“无记忆”缺点。但在讨论此方法之前,让我们先来实现随机搜索。

2.1.随机搜索算法实现

使用下面的代码片段,我们将针对网格搜索实现中描述的相同问题实现随机搜索超参数优化。

# 导入库

from sklearn.model_selection import RandomizedSearchCV

from scipy.stats import randint

# 创建一个RandomizedSearchCV对象

optimizer = RandomizedSearchCV(clf, param_distributinotallow=search_space,

n_iter=50, cv=5, scoring='accuracy',

random_state=1234)

# 存储开始时间以计算总运行时间

start_time = time.time()

# 拟合数据上的优化器

optimizer.fit(X, y)

# 存储结束时间以计算总运行时间

end_time = time.time()

# 打印最佳超参数集和相应分数

print(f"selected hyperparameters:")

print(optimizer.best_params_)

print("")

print(f"best_score: {optimizer.best_score_}")

print(f"elapsed_time: {round(end_time-start_time, 1)}")

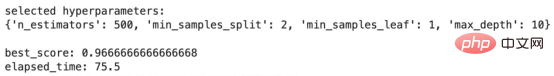

上面代码的输出结果如下:

随机搜索结果

与网格搜索的结果相比,这些结果非常有趣。best_score保持不变,但elapsed_time从352.0秒减少到75.5秒!真是令人印象深刻!换句话说,随机搜索算法设法找到了一组超参数,在网格搜索所需时间的21%左右,其性能与网格搜索相同!但是,这里的效率高得多。

接下来,让我们继续我们的下一种方法,称为贝叶斯优化,它从优化过程中的每一次尝试中学习。

3.贝叶斯优化

贝叶斯优化是一种超参数优化方法,它使用概率模型从以前的尝试中“学习”,并将搜索引向搜索空间中超参数的最佳组合,从而优化机器学习模型的目标函数。

贝叶斯优化方法可以分为4个步骤,我将在下面描述。我鼓励您通读这些步骤,以便更好地理解流程,但使用这种方法并不需要什么前提知识。

- 定义一个“先验”,这是一个关于我们在某个时间点对优化目标函数最可能的超参数组合的信念的概率模型

- 评估超参数样本的模型

- 使用步骤2中获得的知识,更新步骤1中的概率模型(即我们所称的“先验”),了解我们认为优化目标函数的超参数的最可能组合在哪里。我们更新的信念称为“后验”。换句话说,在步骤2中获得的知识帮助我们更好地了解搜索空间,并将我们从先验带到后验,使后验成为我们关于搜索空间和目标函数的“最新”知识,由步骤2提供信息

- 重复步骤2和3,直到模型性能收敛、资源耗尽或满足其他预定义指标

如果您有兴趣了解更多有关贝叶斯优化的详细信息,可以查看以下帖子:

《机器学习中的贝叶斯优化算法》,地址是:

https://medium.com/@fmnobar/conceptual-overview-of-bayesian-optimization-for-parameter-tuning-in-machine-learning-a3b1b4b9339f。

现在,既然我们已经了解了贝叶斯优化是如何工作的,那么让我们来看看它的优点和缺点。

优势:

- 从过去的观察中学习,因此效率更高。换句话说,与无记忆方法相比,它有望在更少的迭代中找到一组更好的超参数

- 在给定某些假设的情况下收敛到最优缺点:

- 难以并行化

- 计算量大于网格和每次迭代的随机搜索

- 先验和贝叶斯优化中使用的函数(例如,获取函数等)的初始概率分布的选择会显著影响性能及其学习曲线

在排除了细节之后,让我们实现贝叶斯优化并查看结果。

3.1.贝叶斯优化算法实现

与上一节类似,我们将使用下面的代码片段为网格搜索实现中描述的相同问题实现贝叶斯超参数优化。

# 导入库

from skopt import BayesSearchCV

# 执行贝叶斯优化

optimizer = BayesSearchCV(estimator=RandomForestClassifier(),

search_spaces=search_space,

n_iter=10,

cv=5,

scoring='accuracy',

random_state=1234)

# 存储开始时间以计算总运行时间

start_time = time.time()

optimizer.fit(X, y)

# 存储结束时间以计算总运行时间

end_time = time.time()

# 打印最佳超参数集和相应分数

print(f"selected hyperparameters:")

print(optimizer.best_params_)

print("")

print(f"best_score: {optimizer.best_score_}")

print(f"elapsed_time: {round(end_time-start_time, 1)}")

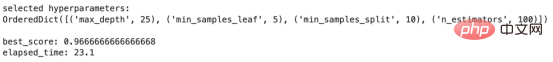

上面代码的输出结果如下:

贝叶斯优化结果

另一组有趣的结果!best_score与我们通过网格和随机搜索获得的结果保持一致,但结果仅用了23.1秒,而随机搜索为75.5秒,网格搜索为352.0秒!换句话说,使用贝叶斯优化所需的时间比网格搜索所需的时间大约少93%。这是一个巨大的生产力提升,在更大、更复杂的模型和搜索空间中变得更有意义。

请注意,贝叶斯优化只使用了10次迭代就获得了这些结果,因为它可以从以前的迭代中学习(与随机和网格搜索相反)。

结果比较

下表对目前所讨论的三种方法的结果进行了比较。“Methodology(方法论)”一栏描述了所使用的超参数优化方法。随后是使用每种方法选择的超参数。“Best Score”是使用特定方法获得的分数,然后是“Elapsed Time”,表示优化策略在我的本地笔记本电脑上运行所需的时间。最后一列“获得的效率(Gained Efficiency)”假设网格搜索为基线,然后计算与网格搜索相比,其他两种方法中每种方法获得的效率(使用经过的时间)。例如,由于随机搜索耗时75.5秒,而网格搜索耗时352.0秒,因此相对于网格搜索的基线,随机搜索的效率计算为1–75.5/352.0=78.5%。

表2——方法性能比较表

以上比较表中的两个主要结论:

- 效率:我们可以看到贝叶斯优化等学习方法如何在更短的时间内找到一组优化的超参数。

- 参数选择:可以有多个正确答案。例如,贝叶斯优化的选定参数与网格和随机搜索的参数不同,尽管评估度量(即best_score)保持不变。这在更大、更复杂的环境中更为重要。

结论

在这篇文章中,我们讨论了什么是超参数优化,并介绍了用于此优化练习的三种最常见的方法。然后,我们详细介绍了这三种方法中的每一种,并在分类练习中实现了它们。最后,我们比较了实施这三种方法的结果。我们发现,从以前的尝试中学习的贝叶斯优化等方法可以显著提高效率,这可能是大型复杂模型(如深度神经网络)中的一个重要因素,其中效率可能是一个决定因素。

译者介绍

朱先忠,51CTO社区编辑,51CTO专家博客、讲师,潍坊一所高校计算机教师,自由编程界老兵一枚。

原文标题:Hyperparameter Optimization — Intro and Implementation of Grid Search, Random Search and Bayesian Optimization,作者:Farzad Mahmoodinobar

以上是超参数优化比较之网格搜索、随机搜索和贝叶斯优化的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

7658

7658

15

15

1393

1393

52

52

91

91

11

11

73

73

19

19

38

38

113

113

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

字节跳动剪映推出 SVIP 超级会员:连续包年 499 元,提供多种 AI 功能

Jun 28, 2024 am 03:51 AM

本站6月27日消息,剪映是由字节跳动旗下脸萌科技开发的一款视频剪辑软件,依托于抖音平台且基本面向该平台用户制作短视频内容,并兼容iOS、安卓、Windows、MacOS等操作系统。剪映官方宣布会员体系升级,推出全新SVIP,包含多种AI黑科技,例如智能翻译、智能划重点、智能包装、数字人合成等。价格方面,剪映SVIP月费79元,年费599元(本站注:折合每月49.9元),连续包月则为59元每月,连续包年为499元每年(折合每月41.6元)。此外,剪映官方还表示,为提升用户体验,向已订阅了原版VIP

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

使用Rag和Sem-Rag提供上下文增强AI编码助手

Jun 10, 2024 am 11:08 AM

通过将检索增强生成和语义记忆纳入AI编码助手,提升开发人员的生产力、效率和准确性。译自EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG,作者JanakiramMSV。虽然基本AI编程助手自然有帮助,但由于依赖对软件语言和编写软件最常见模式的总体理解,因此常常无法提供最相关和正确的代码建议。这些编码助手生成的代码适合解决他们负责解决的问题,但通常不符合各个团队的编码标准、惯例和风格。这通常会导致需要修改或完善其建议,以便将代码接受到应

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

Jun 11, 2024 pm 03:57 PM

大型语言模型(LLM)是在巨大的文本数据库上训练的,在那里它们获得了大量的实际知识。这些知识嵌入到它们的参数中,然后可以在需要时使用。这些模型的知识在训练结束时被“具体化”。在预训练结束时,模型实际上停止学习。对模型进行对齐或进行指令调优,让模型学习如何充分利用这些知识,以及如何更自然地响应用户的问题。但是有时模型知识是不够的,尽管模型可以通过RAG访问外部内容,但通过微调使用模型适应新的领域被认为是有益的。这种微调是使用人工标注者或其他llm创建的输入进行的,模型会遇到额外的实际知识并将其整合

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

七个很酷的GenAI & LLM技术性面试问题

Jun 07, 2024 am 10:06 AM

想了解更多AIGC的内容,请访问:51CTOAI.x社区https://www.51cto.com/aigc/译者|晶颜审校|重楼不同于互联网上随处可见的传统问题库,这些问题需要跳出常规思维。大语言模型(LLM)在数据科学、生成式人工智能(GenAI)和人工智能领域越来越重要。这些复杂的算法提升了人类的技能,并在诸多行业中推动了效率和创新性的提升,成为企业保持竞争力的关键。LLM的应用范围非常广泛,它可以用于自然语言处理、文本生成、语音识别和推荐系统等领域。通过学习大量的数据,LLM能够生成文本

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

你所不知道的机器学习五大学派

Jun 05, 2024 pm 08:51 PM

机器学习是人工智能的重要分支,它赋予计算机从数据中学习的能力,并能够在无需明确编程的情况下改进自身能力。机器学习在各个领域都有着广泛的应用,从图像识别和自然语言处理到推荐系统和欺诈检测,它正在改变我们的生活方式。机器学习领域存在着多种不同的方法和理论,其中最具影响力的五种方法被称为“机器学习五大派”。这五大派分别为符号派、联结派、进化派、贝叶斯派和类推学派。1.符号学派符号学(Symbolism),又称为符号主义,强调利用符号进行逻辑推理和表达知识。该学派认为学习是一种逆向演绎的过程,通过已有的

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

为大模型提供全新科学复杂问答基准与测评体系,UNSW、阿贡、芝加哥大学等多家机构联合推出SciQAG框架

Jul 25, 2024 am 06:42 AM

编辑|ScienceAI问答(QA)数据集在推动自然语言处理(NLP)研究发挥着至关重要的作用。高质量QA数据集不仅可以用于微调模型,也可以有效评估大语言模型(LLM)的能力,尤其是针对科学知识的理解和推理能力。尽管当前已有许多科学QA数据集,涵盖了医学、化学、生物等领域,但这些数据集仍存在一些不足。其一,数据形式较为单一,大多数为多项选择题(multiple-choicequestions),它们易于进行评估,但限制了模型的答案选择范围,无法充分测试模型的科学问题解答能力。相比之下,开放式问答

SOTA性能,厦大多模态蛋白质-配体亲和力预测AI方法,首次结合分子表面信息

Jul 17, 2024 pm 06:37 PM

SOTA性能,厦大多模态蛋白质-配体亲和力预测AI方法,首次结合分子表面信息

Jul 17, 2024 pm 06:37 PM

编辑|KX在药物研发领域,准确有效地预测蛋白质与配体的结合亲和力对于药物筛选和优化至关重要。然而,目前的研究没有考虑到分子表面信息在蛋白质-配体相互作用中的重要作用。基于此,来自厦门大学的研究人员提出了一种新颖的多模态特征提取(MFE)框架,该框架首次结合了蛋白质表面、3D结构和序列的信息,并使用交叉注意机制进行不同模态之间的特征对齐。实验结果表明,该方法在预测蛋白质-配体结合亲和力方面取得了最先进的性能。此外,消融研究证明了该框架内蛋白质表面信息和多模态特征对齐的有效性和必要性。相关研究以「S

SK 海力士 8 月 6 日将展示 AI 相关新品:12 层 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

SK 海力士 8 月 6 日将展示 AI 相关新品:12 层 HBM3E、321-high NAND 等

Aug 01, 2024 pm 09:40 PM

本站8月1日消息,SK海力士今天(8月1日)发布博文,宣布将出席8月6日至8日,在美国加利福尼亚州圣克拉拉举行的全球半导体存储器峰会FMS2024,展示诸多新一代产品。未来存储器和存储峰会(FutureMemoryandStorage)简介前身是主要面向NAND供应商的闪存峰会(FlashMemorySummit),在人工智能技术日益受到关注的背景下,今年重新命名为未来存储器和存储峰会(FutureMemoryandStorage),以邀请DRAM和存储供应商等更多参与者。新产品SK海力士去年在