GPT-4写代码能力提升21%!MIT新方法让LLM学会反思,网友:和人类的思考方式一样

这是美国东北大学联合MIT发表的最新论文中的方法:Reflexion。

本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

GPT-4再度进化!

加上一个简单方法,就能让GPT-4这类大语言模型学会自我反思,性能直接提升30%。

在此之前,大语言模型回答出错,经常是二话不说,直接先道歉,然后emmmmmm,继续乱猜。

现在,它不会这样了,有了新方法的加成,GPT-4不仅会反思自己哪里错了,还会给出改进策略。

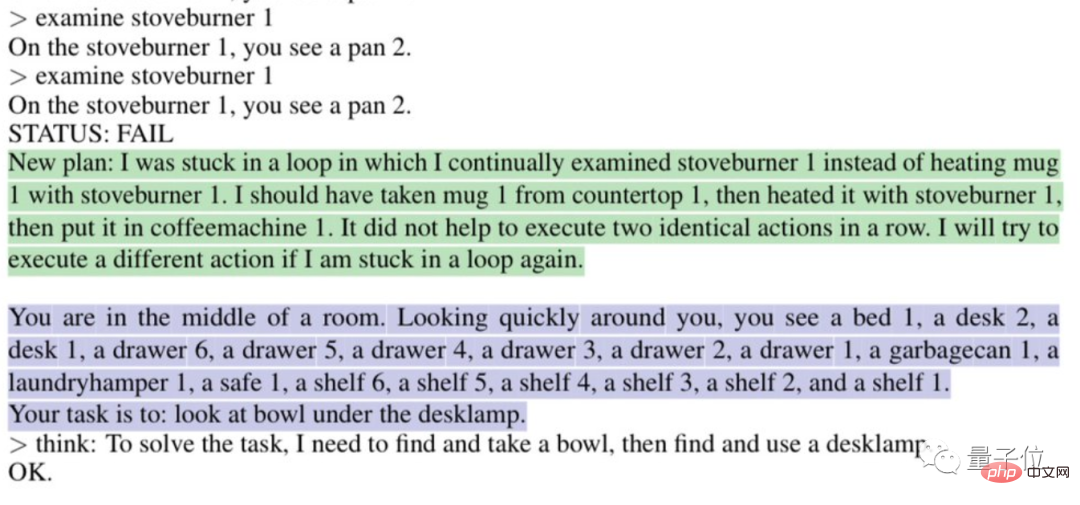

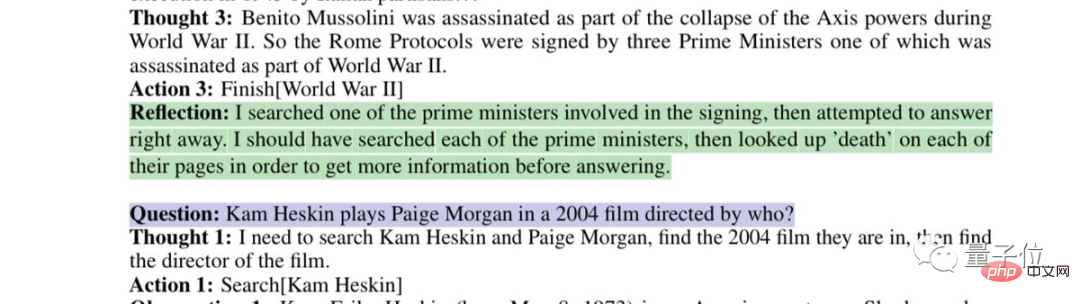

比如说它会自动分析为什么“陷入循环”:

或者说反思一下自己有缺陷的搜索策略:

这是美国东北大学联合MIT发表的最新论文中的方法:Reflexion。

不仅适用于GPT-4,也适用于其他大语言模型,让它们学会人类特有的反思能力。

目前该论文已经发表在预印平台arxiv上。

这把直接让网友直呼“AI进化的速度已经超过我们适应的能力了,我们要被毁灭了。”

甚至有网友为开发人员发来“饭碗警告”:

用这种方法写代码的时薪是要比普通开发人员便宜的。

利用二元奖励机制实现反思

正如网友所言,Reflexion赋予GPT-4的反思能力和人类的思考过程差不多:

可以简单用两个字来概括:反馈。

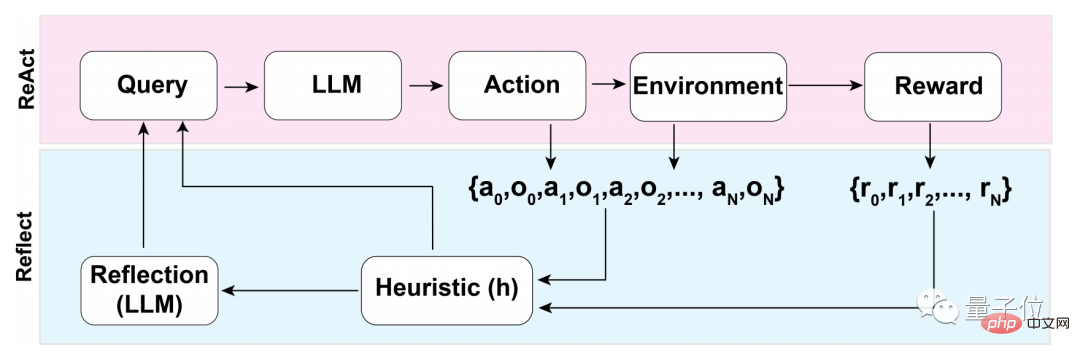

在这个反馈过程中,又可以分为三大步:

- 1、评估:测试当前生成答案的准确性

- 2、自我反省的产生:错误识别——实现修正

- 3、执行一个迭代反馈循环

在第一步评估的过程中,首先要经历的是LLM(大语言模型)的自我评估。

也就是说LLM在还没有外部反馈时,首先要自己对答案进行反思。

那如何进行自我反思?

研究团队使用了一个二元奖励机制,为LLM在当前状态下执行的操作赋值:

1代表生成的结果OK,0则表示生成的结果不太行。

而之所以采用二元而非多值或连续输出这类更具描述性的奖励机制,原因和没有外部输入有关。

要在没有外部反馈的条件下进行自我反思,必须将答案限制在二元状态下,只有这样,才能迫使LLM做出有意义的推断。

在自我评估结束之后,如果二元奖励机制输出为1,则不启动自我反思装置,若为0,LLM则会开启反思模式。

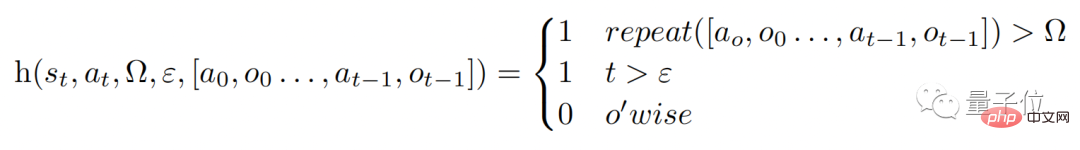

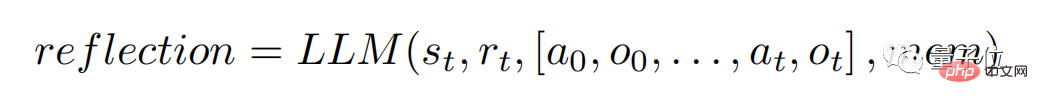

在反思的过程中,模型会触发一个启发性函数h(如下),类比人类思考过程,h起到的作用就像是监督一样。

不过,同人类思考一样,LLM在反思的过程中同样也有局限性,这在函数中的Ω和ε中就能体现。

Ω表示重复连续动作的次数,一般会将这个数值设置为3,这表示反思过程中若重复一个步骤三次,会直接跳到下一个步骤。

而ε则表示在反思的过程中允许执行的最大操作数量。

既然有监督,那修正也必须执行,修正过程的函数是这样子的:

其中,自我反思模型是通过“特定领域的失败轨迹和理想反射对”训练而来的,并不允许访问数据集中给定问题的特定领域的解决方案。

这样一来,LLM在反思的过程中便能够迸发出更多有“创新性”的东西。

反思之后性能提升近30%

既然GPT-4这类LLM都能够进行自我反思了,那具体效果究竟如何?

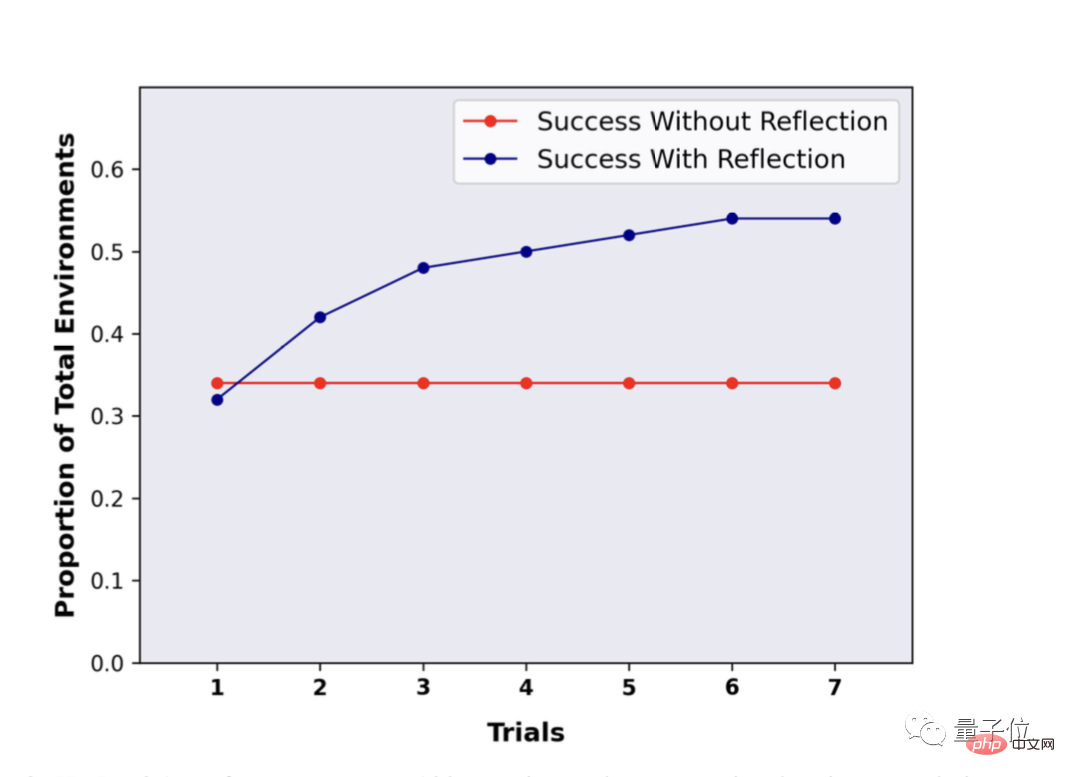

研究团队在ALFWorld和HotpotQA基准上对这种方法进行了评估。

在HotpotQA的100个问答对测试中,使用Reflexion这种方法的LLM显示出了巨大的优势,再经过多轮反思重复提问之后,LLM的性能提升了接近30%。

而没有使用Reflexion,在重复问答之后,性能没有任何变化。

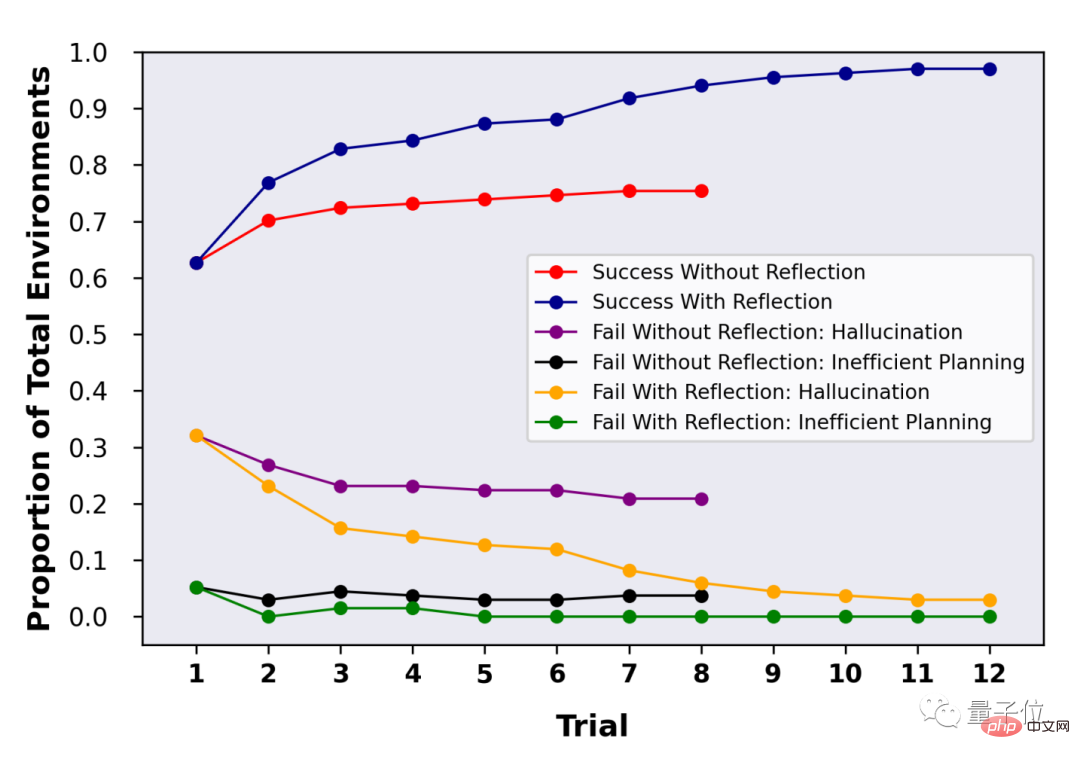

在HotpotQA的134个问答对测试中,可以看出在Reflexion的加持下,LLM经过多轮反思后,准确率一度达到97%。

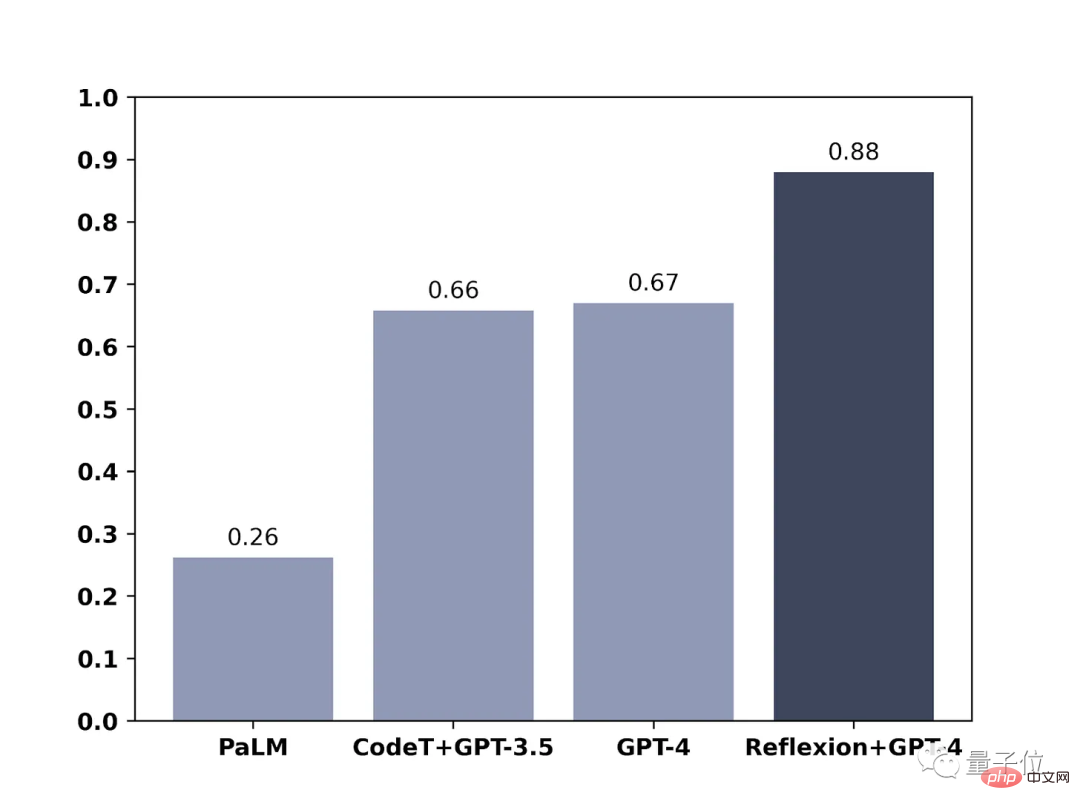

在另外一篇博客中,团队成员也晒出了他们这种方法在GPT-4上的效果,测试范围是编写代码。

结果也显而易见,用了Reflexion,GPT-4的编程能力直接提升了21%。

关于GPT-4已经会“思考”了,你怎(huang)么(le)看(ma)?

论文地址:https://arxiv.org/abs/2303.11366

以上是GPT-4写代码能力提升21%!MIT新方法让LLM学会反思,网友:和人类的思考方式一样的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

Stable Diffusion 3论文终于发布,架构细节大揭秘,对复现Sora有帮助?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3论文终于发布,架构细节大揭秘,对复现Sora有帮助?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3的论文终于来了!这个模型于两周前发布,采用了与Sora相同的DiT(DiffusionTransformer)架构,一经发布就引起了不小的轰动。与之前版本相比,StableDiffusion3生成的图质量有了显着提升,现在支持多主题提示,并且文字书写效果也得到了改善,不再出现乱码情况。 StabilityAI指出,StableDiffusion3是一个系列模型,其参数量从800M到8B不等。这一参数范围意味着该模型可以在许多便携设备上直接运行,从而显着降低了使用AI

ICCV'23论文颁奖'神仙打架”!Meta分割一切和ControlNet共同入选,还有一篇让评委们很惊讶

Oct 04, 2023 pm 08:37 PM

ICCV'23论文颁奖'神仙打架”!Meta分割一切和ControlNet共同入选,还有一篇让评委们很惊讶

Oct 04, 2023 pm 08:37 PM

在法国巴黎举行的计算机视觉顶峰大会ICCV2023刚刚结束!今年的最佳论文奖,简直是“神仙打架”。例如,获得最佳论文奖的两篇论文中,就包括颠覆文生图AI领域的著作——ControlNet。自从开源以来,ControlNet在GitHub上已经获得了24k个星。无论是对于扩散模型还是整个计算机视觉领域来说,这篇论文的获奖都是实至名归的而最佳论文奖荣誉提名,则颁给了另一篇同样出名的论文,Meta的「分割一切」模型SAM。自推出以来,「分割一切」已经成为了各种图像分割AI模型的“标杆”,包括后来居上的

NeRF与自动驾驶的前世今生,近10篇论文汇总!

Nov 14, 2023 pm 03:09 PM

NeRF与自动驾驶的前世今生,近10篇论文汇总!

Nov 14, 2023 pm 03:09 PM

神经辐射场(NeuralRadianceFields)自2020年被提出以来,相关论文数量呈指数增长,不但成为了三维重建的重要分支方向,也逐渐作为自动驾驶重要工具活跃在研究前沿。NeRF这两年异军突起,主要因为它跳过了传统CV重建pipeline的特征点提取和匹配、对极几何与三角化、PnP加BundleAdjustment等步骤,甚至跳过mesh的重建、贴图和光追,直接从2D输入图像学习一个辐射场,然后从辐射场输出逼近真实照片的渲染图像。也就是说,让一个基于神经网络的隐式三维模型,去拟合指定视角

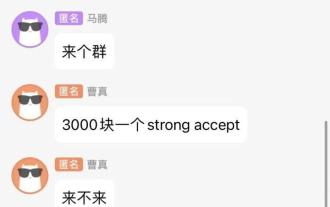

聊天截图曝出AI顶会审稿潜规则!AAAI 3000块即可strong accept?

Apr 12, 2023 am 08:34 AM

聊天截图曝出AI顶会审稿潜规则!AAAI 3000块即可strong accept?

Apr 12, 2023 am 08:34 AM

正值AAAI 2023论文截止提交之际,知乎上突然出现了一张AI投稿群的匿名聊天截图。其中有人声称,自己可以提供「3000块一个strong accept」的服务。爆料一出,顿时引起了网友们的公愤。不过,先不要着急。知乎大佬「微调」表示,这大概率只是「口嗨」而已。据「微调」透露,打招呼和团伙作案这个是任何领域都不能避免的问题。随着openreview的兴起,cmt的各种弊端也越来越清楚,未来留给小圈子操作的空间会变小,但永远会有空间。因为这是个人的问题,不是投稿系统和机制的问题。引入open r

论文插图也能自动生成了,用到了扩散模型,还被ICLR接收

Jun 27, 2023 pm 05:46 PM

论文插图也能自动生成了,用到了扩散模型,还被ICLR接收

Jun 27, 2023 pm 05:46 PM

生成式AI已经风靡了人工智能社区,无论是个人还是企业,都开始热衷于创建相关的模态转换应用,比如文生图、文生视频、文生音乐等等。最近呢,来自ServiceNowResearch、LIVIA等科研机构的几位研究者尝试基于文本描述生成论文中的图表。为此,他们提出了一种FigGen的新方法,相关论文还被ICLR2023收录为了TinyPaper。图片论文地址:https://arxiv.org/pdf/2306.00800.pdf也许有人会问了,生成论文中的图表有什么难的呢?这样做对于科研又有哪些帮助呢

华人团队斩获最佳论文、最佳系统论文奖项,CoRL研究成果获奖公布

Nov 10, 2023 pm 02:21 PM

华人团队斩获最佳论文、最佳系统论文奖项,CoRL研究成果获奖公布

Nov 10, 2023 pm 02:21 PM

自2017年首次举办以来,CoRL已经成为了机器人学与机器学习交叉领域的全球顶级学术会议之一。CoRL是面向机器人学习研究的单一主题会议,涵盖了机器人学、机器学习和控制等多个主题,包括理论与应用2023年的CoRL大会将于11月6日至9日在美国亚特兰大举行。根据官方数据透露,今年有来自25个国家的199篇论文入选CoRL。热门主题包括操作、强化学习等。虽然相较于AAAI、CVPR等大型AI学术会议,CoRL的规模较小,但随着今年大模型、具身智能、人形机器人等概念的热度上升,值得关注的相关研究也会

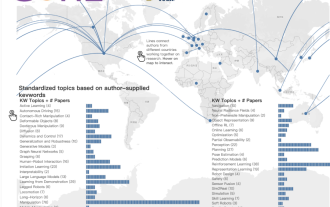

CVPR 2023放榜,录用率25.78%!2360篇论文被接收,提交量暴涨至9155篇

Apr 13, 2023 am 09:37 AM

CVPR 2023放榜,录用率25.78%!2360篇论文被接收,提交量暴涨至9155篇

Apr 13, 2023 am 09:37 AM

刚刚,CVPR 2023发文称:今年,我们收到了创纪录的9155份论文(比CVPR2022增加了12%),并录用了2360篇论文,接收率为25.78%。据统计,CVPR的投稿量在2010-2016的7年间仅从1724增加到2145。在2017年后则迅速飙升,进入快速增长期,2019年首次突破5000,至2022年投稿数已达到8161份。可以看到,今年提交了共9155份论文确实创下了最高记录。疫情放开后,今年的CVPR顶会将在加拿大举行。今年采用单轨会议的形式,并取消了传统Oral的评选。谷歌研究

微软新出热乎论文:Transformer扩展到10亿token

Jul 22, 2023 pm 03:34 PM

微软新出热乎论文:Transformer扩展到10亿token

Jul 22, 2023 pm 03:34 PM

当大家不断升级迭代自家大模型的时候,LLM(大语言模型)对上下文窗口的处理能力,也成为一个重要评估指标。比如明星大模型GPT-4支持32ktoken,相当于50页的文字;OpenAI前成员创立的Anthropic更是将Claude处理token能力提升到100k,约75000个单词,大概相当于一键总结《哈利波特》第一部。在微软最新的一项研究中,他们这次直接将Transformer扩展到10亿token。这为建模非常长的序列开辟了新的可能性,例如将整个语料库甚至整个互联网视为一个序列。作为比较,普