ChatGPT技术国产化尝试

本次分享题目为 ChatGPT 技术、国产化尝试和开源模型。分享包含三大部分的内容,第一部分总体介绍 ChatGPT 相关的技术:ChatGPT 技术的演进、目前存在什么样的问题、ChatGPT 技术学习的三个阶段、数据组织和效果评估;第二部分分享我们在 ChatGPT 技术国产化方面进行的尝试,包含实验过程中我们遇到的问题、进行的思考以及模型的效果和应用;第三部分介绍我们已经发布的中文开源大模型,使用自有数据训练出本地模型如何进行操作,在实验过程中可能遇到的问题,和开源的先进模型相比存在的差距以及如何进一步提升模型的效果。

一、ChatGPT 相关技术

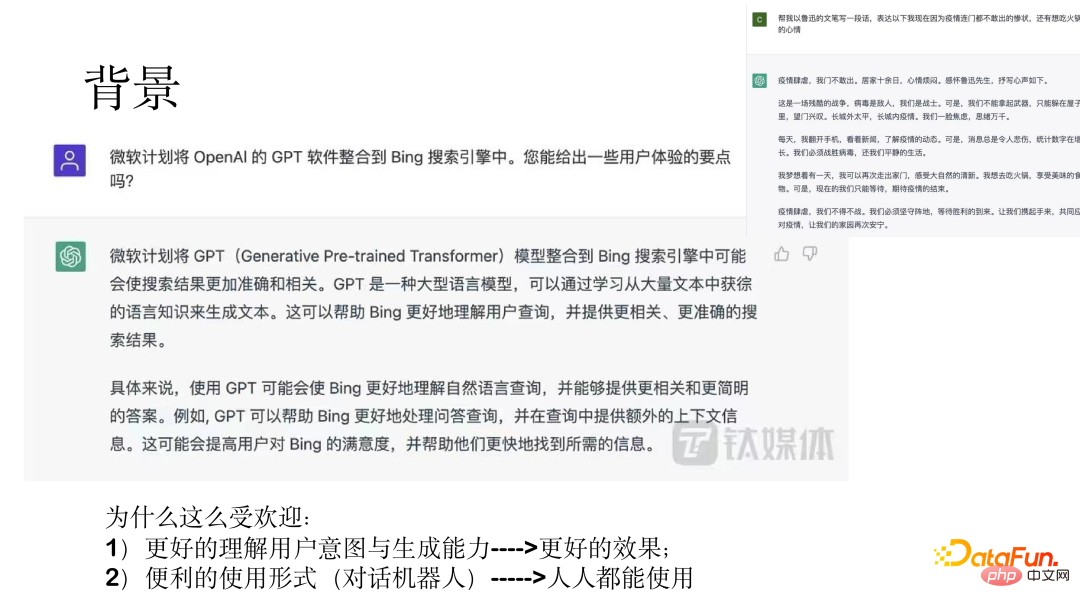

ChatGPT 是一个通用功能型助手。2022 年 12 月 5 日,OpenAI 首席执行官 Sam Altman 在社交媒体上发文称,ChatGPT 推出五天,已突破 100 万用户。AI 聊天机器人 ChatGPT 爆火出圈,已成为一个标志性事件。微软正洽谈 100 亿美元增持股份,并很快将其整合到微软云中。

上图中展示了两个例子,展现出了惊人的效果。

ChatGPT 之所以这么受欢迎,一方面是由于其理解用户意图的能力和生成的效果比较好;另一方面,通过对话机器人的形式,使得人人都能使用。

下面将从模型演进、最初模型存在的问题、ChatGPT 模型学习的三个阶段、训练 ChatGPT 模型的数据组织和效果几个方面进行介绍。

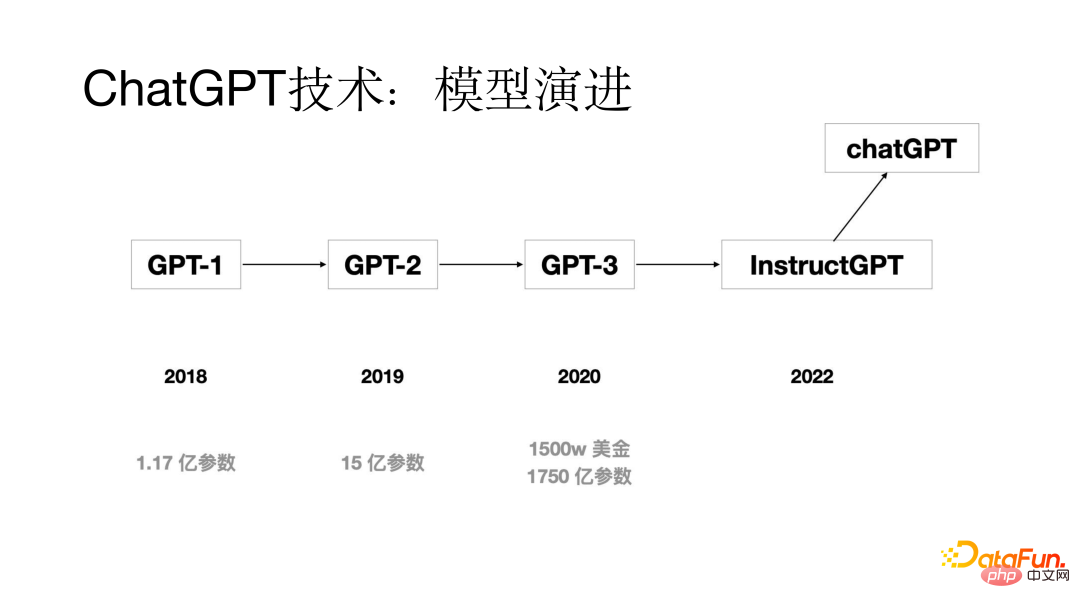

1、模型演进

ChatGPT 技术也经过了几代模型的演进,最初的 GPT 模型是在 2018 年提出的,模型参数只有 1.17 亿;2019 年的时候 GPT-2 模型参数是 15 亿;到了 2020 年 GPT-3 模型参数达到了 1750 亿;通过几代的模型更新迭代,到 2022 年出现了 ChatGPT 模型。

2、之前的模型存在什么样的问题

在 ChatGPT 模型出来之前的模型存在什么样的问题呢?通过分析发现存在的一个比较显著的问题是对齐问题,虽然大模型的生成能力比较强,但是生成的答案有时候不符合用户意图。通过研究发现造成对齐问题出现的主要原因是语言模型训练的训练目标是预测下一个词,而不是按照用户意图来生成。为了解决对齐问题,在训练 ChatGPT 模型过程中加入了基于人类反馈的强化学习(Reinforcement Learning from Human Feedback,RLHF)过程。

3、学习三阶段

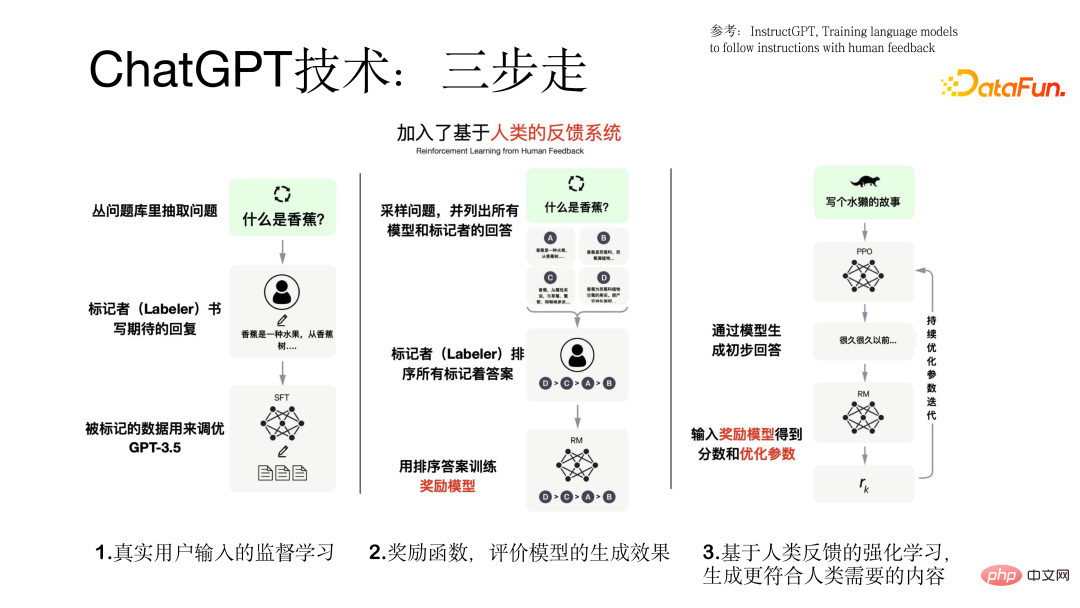

ChatGPT 模型的训练过程是按照三步骤走的形式进行的。

第一步是在 GPT 模型基础上使用真实用户的输入进行监督学习,在这个过程中数据来自真实用户,数据质量比较高也比较宝贵。

第二步是训练一个奖励模型,对于一个 query 通过不同模型会产生不同的输出结果,标记者对所有模型的输出结果进行一个排序,用这些排序后的数据训练奖励模型。

第三步是把模型生成的初步答案输入到奖励模型当中,奖励模型会对这个答案进行一个评价,如果生成的答案符合用户的意图就给一个正向的反馈,否则就给一个负向的反馈,从而把模型调教的越来越好,这就是引入强化学习的目的,使得生成的结果更符合人类的需要。训练 ChatGPT 模型过程中三步走的过程如下图所示。

4、数据组织和效果评估

在训练模型之前我们需要准备好所用的数据集,在这个过程中就会遇到数据冷启动的问题,可以通过以下三个方面来解决:

(1)搜集旧系统用户使用的数据集

(2)让标注人员根据之前真实用户输入的问题标注一些相似的 prompt 和输出

(3)数据标注人员从问答、写故事、生成等自己想的一些 prompt。

训练 ChatGPT 模型的数据包含三部分数据集(77k 真实数据):

(1)基于真实用户 prompt 的监督学习数据,用户 prompt,模型 response,数据量有 13k。

(2)用于训练奖励模型的数据集,这部分数据对于一个 prompt 对应多个response 的排序,数据量有 33k。

(3)基于奖励模型使用强化学习技术进行模型训练的数据集,只需要用户prompt,数据量有 31k,对质量要求较高。

完成 ChatGPT 模型训练后,对于模型的评价也是比较充分的,主要从以下几个方面来评价:

(1)模型生成的结果是否符合用户的意图

(2)生成的结果能不能满足用户提到的约束

(3)模型在客服领域能否有好的效果

通过和 GPT 基础模型进行对比的详细实验结果如下图所示。

二、ChatGPT 技术国产化

下面将从背景与问题、解决思路、效果与实践三个方面介绍我们进行 ChatGPT 技术国产化的内容。

1、背景与问题

为什么要进行国产化,主要考虑了以下几个方面:

(1)ChatGPT 技术本身是比较先进的,在许多任务上效果比较好,但是不对中国大陆提供服务。

(2)可能不能满足国内企业级客户的需求,无法提供本地化技术支持和服务。

(3)价格是以欧美为主要市场的美元进行计价的,价格比较昂贵,国内多数用户可能承受不起。通过测试发现对于每条数据约需要花费 0.5 元人民币,对于拥有大量数据的客户无法进行商业化。

由于以上三个问题,我们尝试了 ChatGPT 技术国产化。

2、解决思路

我们在进行 ChatGPT 技术国产化过程中,采用了分布走的策略。

首先训练了一个具有百亿参数的中文预训练模型;其次在亿级别任务数据上使用 Prompt 的形式进行任务监督学习;然后把模型对话化,即以对话或人机交互的形式和人进行交互;最后我们再引入奖励模型和用户反馈的强化学习 RLHF 技术。

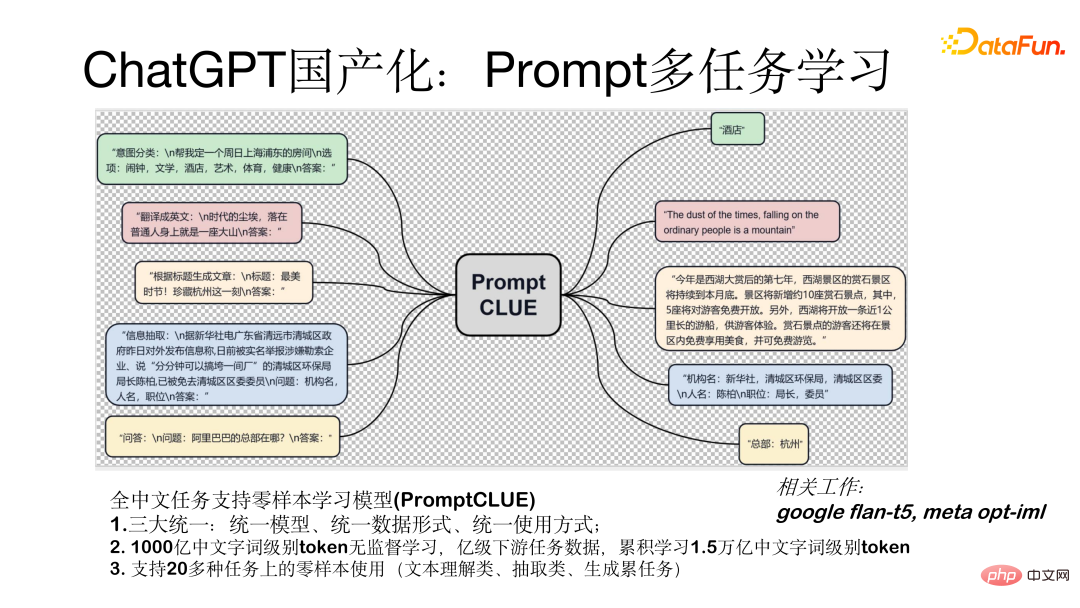

Prompt 多任务学习模型(PromptCLUE)是一个支持全中文任务零样本学习的模型。该模型实现了三大统一:统一模型、统一数据形式(所有任务都转化为 prompt 形式)、统一使用方式(零样本的形式进行使用)。该模型是基于 1000 亿中文字词级别 token 进行无监督学习,在亿级下游任务数据上进行训练,累积学习了 1.5 万亿中文字词级别 token。支持 20 多种任务上的零样本使用(文本理解类、抽取类、生成类任务)。

如何把模型进行对话化,即转化为人机交互形式的模型,我们主要做了如下几方面的工作:

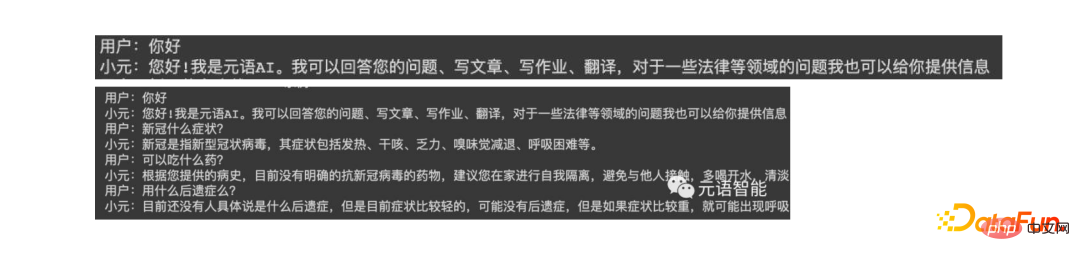

首先为了使模型具有比较好的生成效果,我们移除了文本理解类和抽取类的任务,这样就加强了问答、对话和生成类任务的学习;其次,转变成对话模型后,生成结果会受到上下文的干扰,针对这个问题,我们加入了抗干扰数据,使得模型可以在必要时忽略无关的上下文;最后,我们基于真实用户的反馈数据加入了学习过程,使得模型能够更好地理解用户的意图。下图是和模型进行单轮和多轮测试的形式。

3、效果与实践

下面是针对模型进行测试的效果,通过比较当前与 ChatGPT 模型相比还有1~2 年的差距,不过这种差距是可以逐步弥补的,目前我们进行了一些有益的尝试,也有了一定的效果,目前可以进行一些对话、问答、写作等交互。下图展示了测试结果。

三、国产开源大模型

1、中文开源模型

我们最近刚发布的元语功能型对话大模型(ChatYuan)参数量有 7.7 亿,线上的版本是具有 100 亿参数量的模型,已经上线了多个平台,包括 Huggingface、ModelScope、Github、paddlepaddle 都可以使用。模型可以下载到本地,根据自己的用户数据集进行微调。它是基于 PromptCLUE-large 结合数亿条功能对话多轮对话数据进一步训练得到。

上面以 Huggingface 平台为例,展示了模型本地使用方法。在平台搜索ChatYuan,加载模型,进行简单的包装。使用中有一些比较重要的参数,比如是否采样 sample,如果需要生成的比较多样就需要采样。

2、基于自有数据训练本地模型

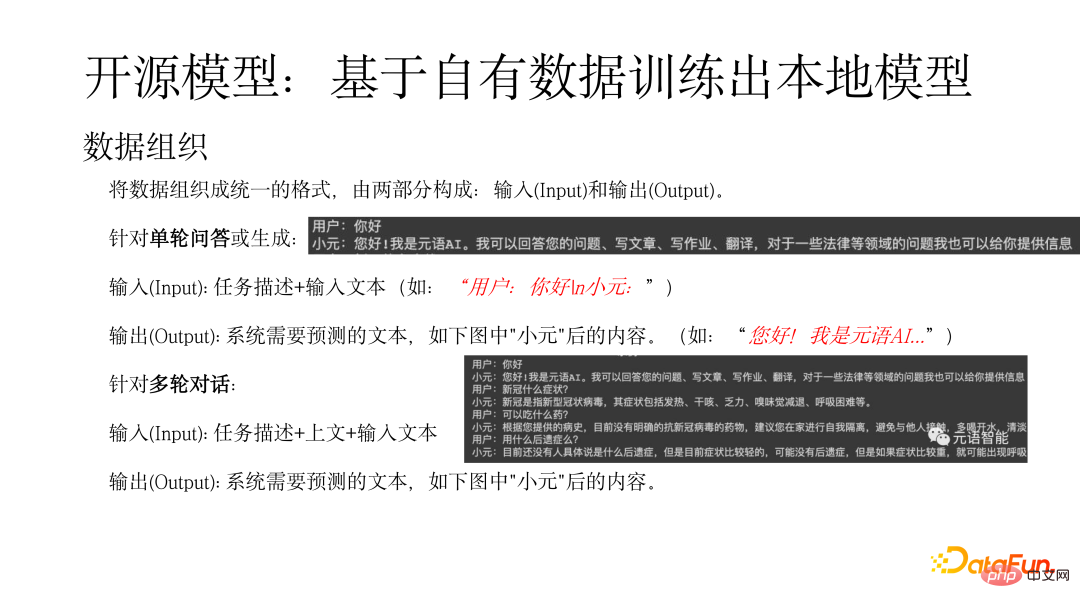

首先需要将数据组织成统一的形式,由两部分构成:输入(Input)和输出(Output)。对于单轮问答或生成输入(Input):任务描述+输入文本(如:“用户:你好n小元:”),输出(Output)是指系统需要预测的文本(如:“您好!我是元语AI...”)。对于多轮对话输入(Input):任务描述+上文+输入文本,输出是指系统需要预测的文本,如下图中"小元"后的内容。

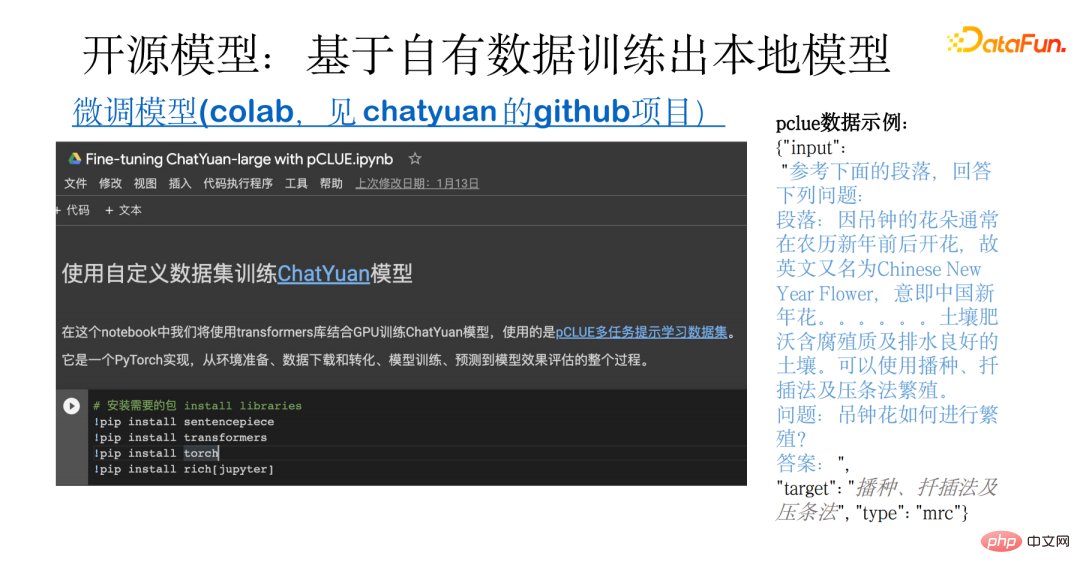

下图展示了基于自有数据进行训练本地模型的一个示例。这一示例涵盖了整个过程,从数据的准备,到开源数据的下载、转化,还包括模型的训练、预测和评估。其基础使用的是 pCLUE 多任务数据集。用户可以使用自己的数据进行训练,也可以使用 pCLUE 进行初步的训练,来测试效果。

3、可能的问题、差距和如何进一步提升效果

ChatYuan 和 ChatGPT 都是通用型功能型对话大模型,都能够在闲聊或法律、医疗等专业领域进行问答、交互和生成。通过和 ChatGPT 模型相比较,目前还有一定的差距,主要体现在是以下几个方面:

- 模型大小方面,ChatGPT 参数量是千亿级别的,ChatYuan 是百亿级别的;

- 学习到的数据量方面也存在很大差距,ChatYuan 模型还在学习过程中;

- 在强化学习方面,ChatGPT 模型已经引入了基于用户反馈的强化学习,我们的模型还在引入过程中。

在使用模型过程中可能遇到生成效果和文本长度方面的问题,取决于数据格式是否正确,在生成过程中是否采样 sample,输出结果的长度控制 max_length 等。

要进一步提升模型效果,可以从如下几个方面入手:

(1)结合行业数据进行进一步训练,包括无监督预训,以及使用大量高质量的数据进行有监督学习。

(2)使用真实用户反馈数据的学习可以弥补分布差异。

(3)引入强化学习,对齐用户意图。

(4)选用更大的模型,一般来说模型越大,模型能力越强。

ChatGPT 带来的新技术和使用场景,让人们看到了 AI 的巨大潜力。更多应用都将得到升级,也为一些新应用创造了可能。

元语智能,作为大模型 Model-as-a-Service 服务商,在这一领域也在不断探索中。欢迎感兴趣的伙伴关注我们的网站和公众号。

今天的分享就到这里,谢谢大家。

以上是ChatGPT技术国产化尝试的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

热门话题

ChatGPT 现在允许免费用户使用 DALL-E 3 生成每日限制的图像

Aug 09, 2024 pm 09:37 PM

ChatGPT 现在允许免费用户使用 DALL-E 3 生成每日限制的图像

Aug 09, 2024 pm 09:37 PM

DALL-E 3 于 2023 年 9 月正式推出,是比其前身大幅改进的型号。它被认为是迄今为止最好的人工智能图像生成器之一,能够创建具有复杂细节的图像。然而,在推出时,它不包括

选择最适合数据的嵌入模型:OpenAI 和开源多语言嵌入的对比测试

Feb 26, 2024 pm 06:10 PM

选择最适合数据的嵌入模型:OpenAI 和开源多语言嵌入的对比测试

Feb 26, 2024 pm 06:10 PM

OpenAI最近宣布推出他们的最新一代嵌入模型embeddingv3,他们声称这是性能最出色的嵌入模型,具备更高的多语言性能。这一批模型被划分为两种类型:规模较小的text-embeddings-3-small和更为强大、体积较大的text-embeddings-3-large。这些模型的设计和训练方式的信息披露得很少,模型只能通过付费API访问。所以就出现了很多开源的嵌入模型但是这些开源的模型与OpenAI闭源模型相比如何呢?本文将对这些新模型与开源模型的性能进行实证比较。我们计划建立一个数据

编程新范式,当Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

编程新范式,当Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

2023年,AI技术已经成为热点话题,对各行业产生了巨大影响,编程领域尤其如此。人们越来越认识到AI技术的重要性,Spring社区也不例外。随着GenAI(GeneralArtificialIntelligence)技术的不断进步,简化具备AI功能的应用程序的创建变得至关重要和迫切。在这个背景下,"SpringAI"应运而生,旨在简化开发AI功能应用程序的过程,使其变得简单直观,避免不必要的复杂性。通过"SpringAI",开发者可以更轻松地构建具备AI功能的应用程序,将其变得更加易于使用和操作

手机怎么安装chatgpt

Mar 05, 2024 pm 02:31 PM

手机怎么安装chatgpt

Mar 05, 2024 pm 02:31 PM

安装步骤:1、在ChatGTP官网或手机商店上下载ChatGTP软件;2、打开后在设置界面中,选择语言为中文;3、在对局界面中,选择人机对局并设置中文相谱;4、开始后在聊天窗口中输入指令,即可与软件进行交互。

OpenAI超级对齐团队遗作:两个大模型博弈一番,输出更好懂了

Jul 19, 2024 am 01:29 AM

OpenAI超级对齐团队遗作:两个大模型博弈一番,输出更好懂了

Jul 19, 2024 am 01:29 AM

如果AI模型给的答案一点也看不懂,你敢用吗?随着机器学习系统在更重要的领域得到应用,证明为什么我们可以信任它们的输出,并明确何时不应信任它们,变得越来越重要。获得对复杂系统输出结果信任的一个可行方法是,要求系统对其输出产生一种解释,这种解释对人类或另一个受信任的系统来说是可读的,即可以完全理解以至于任何可能的错误都可以被发现。例如,为了建立对司法系统的信任,我们要求法院提供清晰易读的书面意见,解释并支持其决策。对于大型语言模型来说,我们也可以采用类似的方法。不过,在采用这种方法时,确保语言模型生

基于Rust的Zed编辑器已开源,内置对OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

基于Rust的Zed编辑器已开源,内置对OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

作者丨TimAnderson编译丨诺亚出品|51CTO技术栈(微信号:blog51cto)Zed编辑器项目目前仍处于预发布阶段,已在AGPL、GPL和Apache许可下开源。该编辑器以高性能和多种AI辅助选择为特色,但目前仅适用于Mac平台使用。内森·索博(NathanSobo)在一篇帖子中解释道,Zed项目在GitHub上的代码库中,编辑器部分采用了GPL许可,服务器端组件则使用了AGPL许可证,而GPUI(GPU加速用户界面)部分则采用了Apache2.0许可。GPUI是Zed团队开发的一款

没等来OpenAI,等来了Open-Sora全面开源

Mar 18, 2024 pm 08:40 PM

没等来OpenAI,等来了Open-Sora全面开源

Mar 18, 2024 pm 08:40 PM

不久前OpenAISora以其惊人的视频生成效果迅速走红,在一众文生视频模型中突出重围,成为全球瞩目的焦点。继2周前推出成本直降46%的Sora训练推理复现流程后,Colossal-AI团队全面开源全球首个类Sora架构视频生成模型「Open-Sora1.0」,涵盖了整个训练流程,包括数据处理、所有训练细节和模型权重,携手全球AI热爱者共同推进视频创作的新纪元。先睹为快,我们先看一段由Colossal-AI团队发布的「Open-Sora1.0」模型生成的都市繁华掠影视频。Open-Sora1.0

本地运行性能超越 OpenAI Text-Embedding-Ada-002 的 Embedding 服务,太方便了!

Apr 15, 2024 am 09:01 AM

本地运行性能超越 OpenAI Text-Embedding-Ada-002 的 Embedding 服务,太方便了!

Apr 15, 2024 am 09:01 AM

Ollama是一款超级实用的工具,让你能够在本地轻松运行Llama2、Mistral、Gemma等开源模型。本文我将介绍如何使用Ollama实现对文本的向量化处理。如果你本地还没有安装Ollama,可以阅读这篇文章。本文我们将使用nomic-embed-text[2]模型。它是一种文本编码器,在短的上下文和长的上下文任务上,性能超越了OpenAItext-embedding-ada-002和text-embedding-3-small。启动nomic-embed-text服务当你已经成功安装好o